MIDI-3D: 1枚の画像からマルチオブジェクトの3Dシーンを高速生成するオープンソースツール

はじめに

MIDI-3Dは、VAST-AI-Researchチームによって開発されたオープンソースプロジェクトで、開発者、研究者、クリエイターのために、1つの画像から複数のオブジェクトを含む3Dシーンを素早く生成します。このツールはマルチインスタンス拡散モデリング技術に基づいており、人工知能と3Dモデリングを組み合わせることで、複数の高品質な3Dオブジェクトを同時に生成し、それらの空間的関係を維持します。MIDI-3DはCVPR 2025で公開され、コード、モデルの重み、オンラインデモのすべてがオープンになっています。MIDI-3DはCVPR 2025で発表され、コードとモデルの重み、オンライン・デモはすべて公開されている。リアルな画像とカートゥーン風の画像の両方の入力をサポートし、生成時間は40秒と短く、出力ファイルは .glb 形式で、他のソフトウェアで編集することができる。このプロジェクトは、3Dシーンの作成を簡素化し、より多くの人が簡単にデジタルアセットを作れるようにすることを目的としている。

機能一覧

- 1枚の画像から複数のオブジェクトを含む3Dシーンを生成し、リアルなスタイルとカートゥーンスタイルの両方をサポートします。

- 画像中のオブジェクトを自動的に識別し、ラベルを付けるための画像分割機能を提供する。

- 完全なシーンに自動的に結合される、分離可能な複数の3Dインスタンスを同時に生成します。

- コマンドライン操作とインタラクティブなウェブプレゼンテーションの両方をサポート。

- 事前にトレーニングされたモデルの重みを自動的にローカルにダウンロードし、素早く起動。

- 輸出

.glbその後の編集や他のソフトウェアへのインポートに使用できる形式の3Dモデルファイル。 - 生成プロセスは効率的で、オブジェクトごとのモデリングや長時間の最適化を必要としない。

ヘルプの使用

MIDI-3Dの使い方は、インストールと操作の2つに分かれます。以下は、ゼロから始めるための詳しい手順です。

設置プロセス

- ハードウェアおよびソフトウェア環境の準備

MIDI-3DはGPUアクセラレーションに依存しているため、CUDA対応のコンピュータが必要です。少なくとも6GBのビデオメモリを持つNVIDIA GPUを推奨します。Python 3.10以上がインストールされていることを確認してください。 - 仮想環境の作成(オプション)

コンフリクトを避けるために、新しいConda環境を作ることができる:

conda create -n midi python=3.10

conda activate midi

- PyTorchのインストール

GPUのCUDAバージョンに従ってPyTorchをインストールする:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu118

バージョンが異なる場合は、https://pytorch.org/get-started/locally/、対応するコマンドを選択する。

- プロジェクトコードのダウンロード

ターミナルで以下のコマンドを実行して、MIDI-3Dリポジトリをクローンします:

git clone https://github.com/VAST-AI-Research/MIDI-3D.git

cd MIDI-3D

- 依存関係のインストール

プロジェクト・オファーrequirements.txtファイルを開き、以下のコマンドを実行してすべての依存関係をインストールする:

pip install -r requirements.txt

- モデルの重みの取得

スクリプトを実行すると、MIDI-3Dは自動的にhttps://huggingface.co/VAST-AI/MIDI-3D から事前にトレーニングされたモデルをダウンロードし、それをpretrained_weights/MIDI-3Dフォルダに解凍してください。ネットワークが不安定な場合は、手動でダウンロードしてそのパスに解凍することもできます。

ワークフロー

MIDI-3Dはコマンドラインとインタラクティブデモの2つの使用方法をサポートしています。以下に具体的な手順を示します。

コマンドライン操作

- スプリット・チャートの作成

MIDI-3Dは画像とそれに対応するセグメンテーションマップ(オブジェクト領域のラベリング)を必要とします。セグメンテーションマップは付属のGrounded SAMスクリプトで作成できます。例えば04_rgb.png走れ:

python -m scripts.grounding_sam --image assets/example_data/Cartoon-Style/04_rgb.png --labels "lamp sofa table dog" --output ./segmentation.png

--image入力画像のパスを指定する。--labels写真に写っているオブジェクトの名前をスペースで区切って入力します。--outputセグメンテーション図を保存するパスを指定します。

実行するとsegmentation.pngドキュメンテーション

- 3Dシーンの生成

画像とスプリットマップを含む3Dシーンを生成するには、以下のコマンドを実行する:

python -m scripts.inference_midi --rgb assets/example_data/Cartoon-Style/00_rgb.png --seg assets/example_data/Cartoon-Style/00_seg.png --output-dir "./output"

--rgbはオリジナルのマップパスである。--segは分割グラフパスである。--output-dirは出力フォルダーのパスである。

生成された3Dシーンはoutput.glbファイルは、通常40秒から1分かかります。オブジェクトが画像の端に近い場合は、パラメータ--do-image-padding例えば

python -m scripts.inference_midi --rgb 00_rgb.png --seg 00_seg.png --output-dir "./output" --do-image-padding

インタラクティブ・プレゼンテーション

- スタートアップ・デモ

以下のコマンドを実行し、Gradioインターフェイスを起動する:

python gradio_demo.py

システムが自動的にブラウザを開き、操作ページを表示します。また、https://huggingface.co/spaces/VAST-AI/MIDI-3D、オンラインデモをご覧いただけます。

- 画像をアップロードして分割する

インターフェースの "Input Image "をクリックして画像をアップロードします。その後、マウスを使って対象領域を選択すると、システムが自動的にセグメンテーションマップを生成し、「セグメンテーション結果」に表示されます。 - 3Dシーンの生成

Run Segmentation」をクリックしてセグメンテーションマップを確認し、パラメータ(ランダムシードなど)を調整し、「Generate」ボタンをクリックします。数秒後、インターフェースに3Dモデルが表示されますので、クリックしてダウンロードします。.glbドキュメンテーション

機能

- 画像分割

Grounded SAMはMIDI-3D用の前処理ツールで、画像内のオブジェクトを自動的に認識し、セグメンテーションマップを生成します。オブジェクト名(例:"lamp sofa")を入力するか、インタラクティブなインターフェースで手動で選択することができます。高いセグメンテーション精度でマルチオブジェクトシーンをサポートします。 - マルチオブジェクト3D生成

MIDI-3Dは、マルチインスタンス拡散モデリングを使用して、複数の3Dオブジェクトを同時に生成し、それらの空間的関係を維持します。例えば、リビングルームの写真から、ソファ、テーブル、ランプの3Dモデルを生成し、完全なシーンを直接構成することができます。従来のオブジェクトごとの生成方法よりも高速です。 - モデル出力

生成された.glbファイルはBlender、Unity、その他のソフトウェアと互換性があります。様々なニーズに合わせて、ファイルをインポートしたり、マテリアルやライトを調整したり、アニメーションを追加したりすることができます。

補足資料

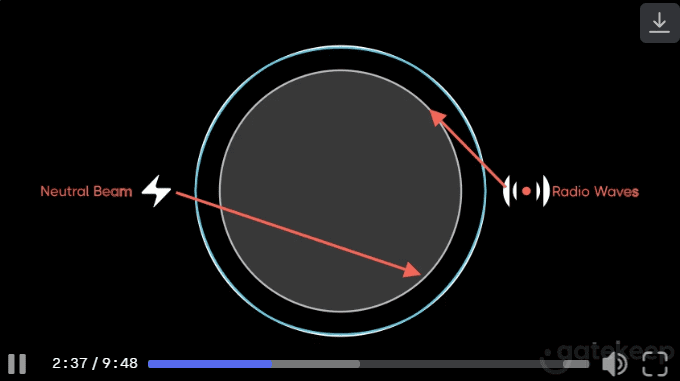

- インストラクション・ビデオ

画像のアップロードから3Dシーンの生成までを詳しく紹介する公式ハウツービデオ(https://github.com/VAST-AI-Research/MIDI-3D)が用意されている。 - 書誌

技術的な詳細については、https://arxiv.org/abs/2412.03558。

よくある質問

- 生成に失敗した場合は、GPUがサポートしているかどうか、またはセグメンテーション・マップが正しいかどうかを確認してください。

- オブジェクトの詳細が欠けている場合は、より解像度の高い画像を使用してみてください。

アプリケーションシナリオ

- ゲーム開発

開発者はMIDI-3Dを使ってスケッチから3Dシーンを生成することができます。例えば、森の写真を素早く木々や地形の3Dモデルに変換し、Unityにインポートすることができます。 - 学術研究

研究者は、マルチインスタンス拡散モデルの有効性をテストするために使用することができる。このモデルは合成データでのみ学習されるが、実画像や漫画画像にも十分適応できる。 - デジタルアート

アーティストは、漫画の写真から3Dアニメーションのシーンを生成して、創造的な作品をすばやく制作し、モデリングの時間を節約することができます。

品質保証

- MIDI-3Dはどのような画像をサポートしていますか?

アジュバント.png歌で応える.jpgフォーマットより良い結果を得るためには、鮮明な画像をお勧めします。 - どのようなハードウェア構成が必要ですか?

CUDA環境で実行するには、少なくとも6GBのビデオメモリを搭載したNVIDIA GPUが必要。 - 生成されたモデルは市販されているか?

はい、プロジェクトはMITライセンスを使用しています。.glb文書は、ライセンス要件に従って、商業目的で自由に使用することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません