メタ、ラマ3.3をリリース、70Bのパラメータはラマ3.1より強い 405B - より小さく、より速く、より強く

Metaは、700億パラメータを持つ大規模言語モデル、Llama 3.3を発表した。Llama 3.3は、405Bパラメータを持つLlama 3.1に匹敵する性能を持ち、Llama 3.1 405Bよりも10倍低い入力コストを持っている!命令順守率はGPT-4o、クロード3.5ソネットを上回る。

破壊的なコンピューティング効率

従来、高性能なAIモデルは、多くの場合、大きな計算量と高いハードウェアコストを意味していました。パラメータ・サイズが前作のLlama 3.1の半分であるにもかかわらず、主要なベンチマークにおける性能は素晴らしいの一言に尽きる。

主要業績評価指標

- 70Bパラメータ、128Kコンテキスト

- 対応言語:英語、ドイツ語、フランス語、イタリア語、ポルトガル語、ヒンディー語、スペイン語、タイ語を含む8言語

- IFEvalテストスコア:92.1%、ラマ3.1(405B)より良い

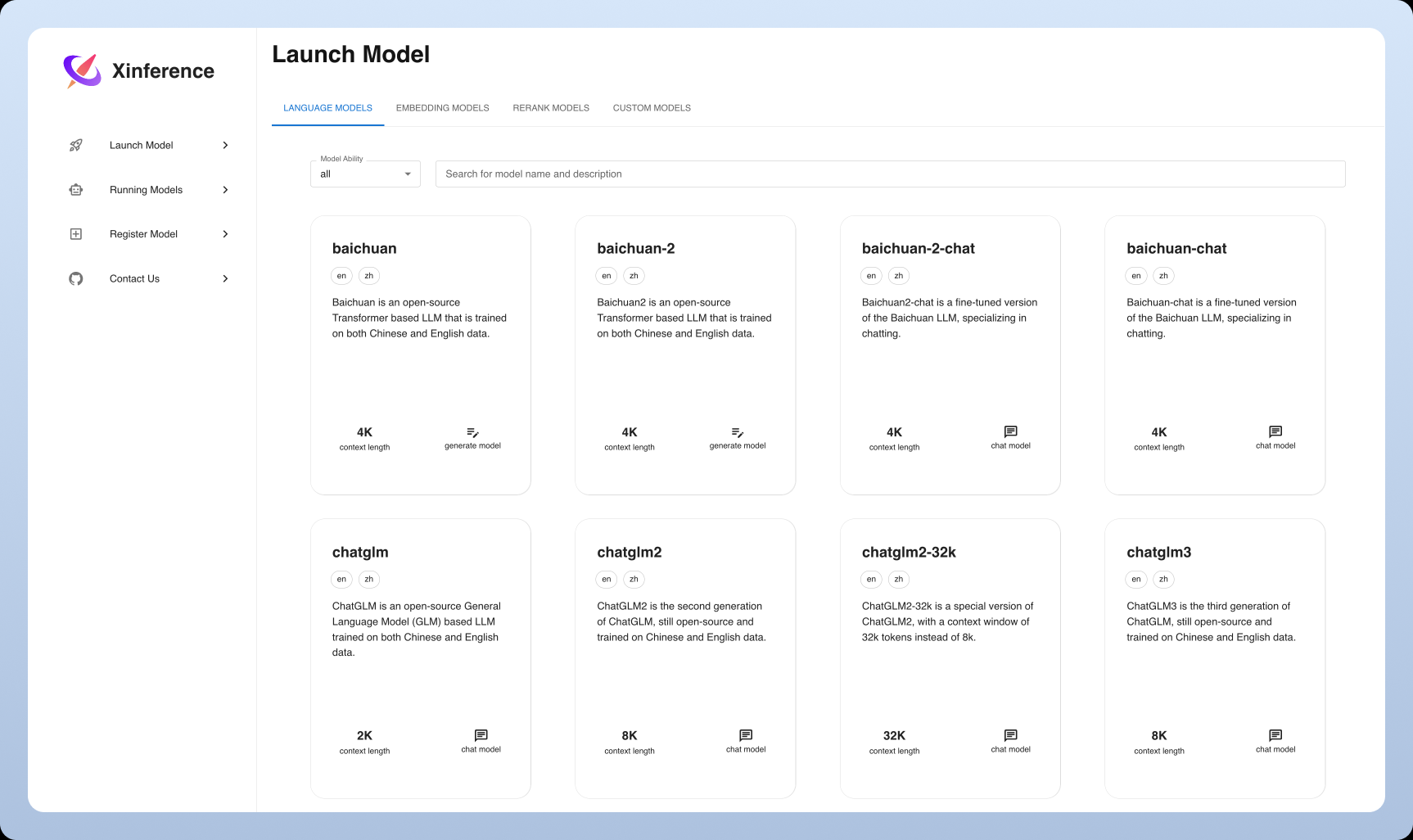

- 現地での展開のしやすさ:大幅な改善

Llama 3.3の最大の魅力は、その驚くべき手頃さだ。もはや中小規模の開発チームや新興企業は、高価なコンピューティング・リソースを敬遠する必要はない。標準的なワークステーションで、最先端のAIテクノロジーを動かすことができるのです。

複数のアプリケーション・シナリオ

このモデルの応用範囲の広さには目を見張るものがある:

- 対話AI

- 合成データ生成

- 多言語処理

- 研究と革新的な応用

安全性

MetaはLlama 3.3でより強力なセキュリティ・メカニズムを搭載した:

- 微調整された拒絶メカニズムの統合

- ラマガード3 リスク管理ツール

- 微調整された倫理的調整メカニズム

これらの取り組みにより、モデルがオープンにアクセス可能でありながら、責任を持って管理されたインテリジェントなモデルであり続けることが保証される。

産業への影響

これは単なる数字ではなく、オープンソースAIが止められないという証拠です。これは単なる数字ではなく、オープンソースのAIが止められないという証拠であり、Llama 3.3はハイエンドのAI技術を「エリートクラブ」から「大衆のためのパーティー」へと変えている。

マーク・ザッカーバーグの戦略的青写真

メタ社は、米国ルイジアナ州に2ギガワットのデータセンターを建設するなど、インフラへの投資を積極的に行っており、AIの長期的な成長への強いコミットメントを示している。

ダウンロード

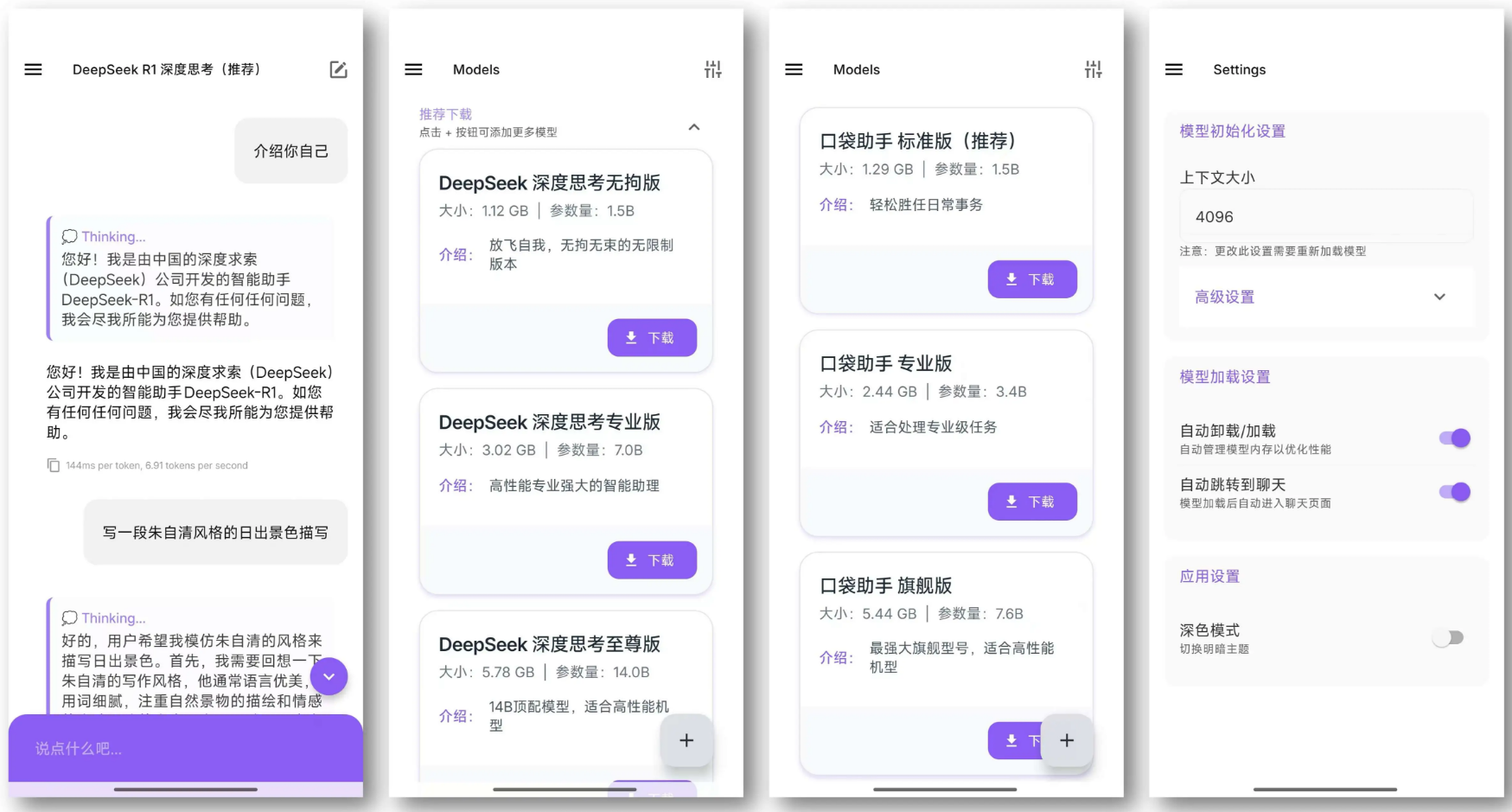

Llama 3.3がOllamモデルライブラリに追加され、モデルサイズが42Gになりました。

Llama 3.3を導入していない開発者は、MetaのGitHubリポジトリにアクセスするか、Hugging Faceからモデルファイルをダウンロードできる。

モデルカード:

github.com/meta-llama/llama-models/blob/main/models/llama3_3/MODEL_CARD.md

モデルファイル:

huggingface.co/meta-llama/Llama-3.3-70B-Instruct

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません