Magic 1-For-1:1分で1分の動画を生成すると謳う、効率的な動画生成オープンソースプロジェクト

はじめに

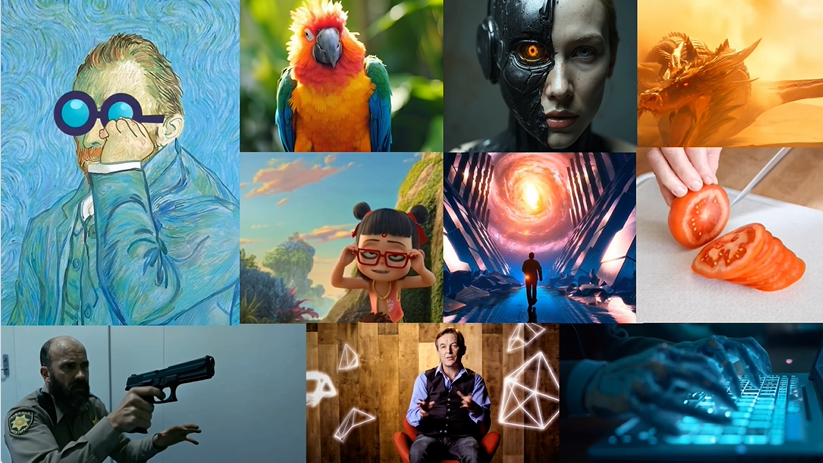

Magic 1-For-1は、メモリ使用量を最適化し、推論レイテンシを削減するように設計された効率的なビデオ生成モデルである。このモデルは、テキストからビデオへの生成タスクを、より効率的な学習と蒸留のために、テキストから画像への生成と画像からビデオへの生成という2つのサブタスクに分解する。Magic 1-For-1は、短いビデオを迅速に生成する必要があるシナリオのために、高品質の1分ビデオクリップを1分未満で生成することができる。このプロジェクトは北京大学、Hedra Inc.、Nvidiaの研究者によって開発され、コードとモデルの重みはGitHubで公開されている。

機能一覧

- テキストから画像への変換:入力されたテキスト説明を画像に変換します。

- 画像からビデオへの変換:生成された画像をビデオクリップに変換します。

- 効率的なメモリ使用:シングルGPU環境でのメモリ使用を最適化します。

- 高速推論:高速ビデオ生成のための推論待ち時間の短縮。

- モデル重みのダウンロード: 訓練済みモデル重みをダウンロードするためのリンクを提供します。

- 環境セットアップ: 詳細な環境セットアップと依存関係のインストールガイドを提供します。

ヘルプの使用

環境設定

- git-lfsをインストールします:

sudo apt-get install git-lfs

- Conda環境が作成され、アクティベートされる:

conda create -n video_infer python=3.9

conda activate video_infer

- プロジェクトの依存関係をインストールします:

pip install -r requirements.txt

モデルウェイトのダウンロード

- 事前に訓練された重みを格納するディレクトリを作成する:

mkdir pretrained_weights

- 魔法の1-For-1ウェイトをダウンロードする:

wget -O pretrained_weights/magic_1_for_1_weights.pth <model_weights_url>

- Hugging Faceコンポーネントをダウンロードする:

huggingface-cli download tencent/HunyuanVideo --local_dir pretrained_weights --local_dir_use_symlinks False

huggingface-cli download xtuner/llava-llama-3-8b-v1_1-transformers --local_dir pretrained_weights/text_encoder --local_dir_use_symlinks False

huggingface-cli download openai/clip-vit-large-patch14 --local_dir pretrained_weights/text_encoder_2 --local_dir_use_symlinks False

ビデオの作成

- 以下のコマンドを実行して、テキストと画像をビデオに変換する:

python test_ti2v.py --config configs/test/text_to_video/4_step_ti2v.yaml --quantization False

- または、提供されたスクリプトを使用する:

bash scripts/generate_video.sh

詳細な機能操作の流れ

- テキストから画像への変換テキストによる説明を入力すると、モデルが対応する画像を生成します。

- 画像からビデオへの変換生成された画像をビデオ生成モジュールに入力し、短いビデオクリップを生成します。

- 効率的なメモリ使用メモリ使用量を最適化することで、シングルGPU環境でも効率的な動作を保証します。

- 高速推論短い動画を高速に生成する必要があるシナリオにおいて、推論遅延を低減し、高速な動画生成を実現する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません