llamafile: 単一ファイルを使ってLLMを配布・実行、LLMデプロイの簡素化、LLMのクロスプラットフォーム対応

はじめに

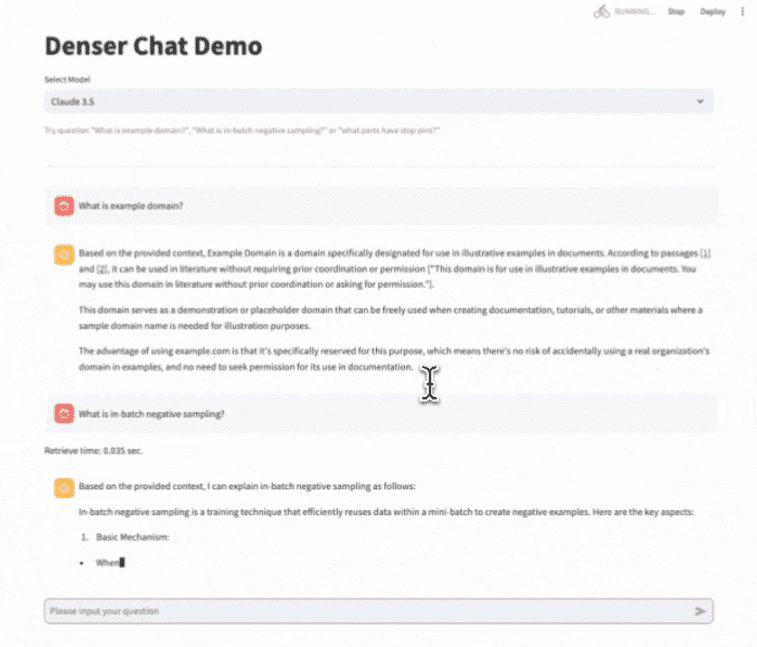

llamafileはMozilla Buildersプロジェクトのツールで、Large Language Model (LLM)の導入と運用を簡単にするために設計されています。LLMを組み合わせることで ラマ.cpp Cosmopolitan Libcとの連携により、llamafileは複雑なLLMの展開プロセスを単一の実行ファイルに簡素化し、インストール不要で幅広いオペレーティングシステム上でローカルに実行することをサポートします。このツールはテキストダイアログをサポートするだけでなく、データのプライバシーを確保するために画像入力も扱います。

機能一覧

- 単一ファイル操作LLMモデルと実行環境を1つの実行ファイルにパッケージ化します。

- クロスプラットフォームの互換性Windows、macOS、Linux、FreeBSD、OpenBSD、NetBSDに対応しています。

- ローカルオペレーションインターネット接続は不要で、すべてのデータ処理はローカルで行われるため、プライバシーと安全性が確保されています。

- マルチモーダルサポートテキスト入力と画像入力をサポートし、豊富なインタラクティブ機能を提供します。

- OpenAI API対応OpenAI APIと互換性のあるインターフェースを提供し、既存のアプリケーションとの統合を容易にします。

- ハイパフォーマンス行列乗算カーネルが最適化され、CPUとGPU上でより高速に動作するようになりました。

- オープンソースプロジェクトオープンソースコード、活発なコミュニティへの貢献、継続的なアップデートと最適化。

ヘルプの使用

インストールと操作

- llamafileのダウンロードアクセス GitHubページ 最新版のllamafileをダウンロードしてください。

- 執行権限の委譲(macOS、Linux、BSDユーザー向け):

chmod +x path/to/llamafile - llamafileを実行する::

- macOS、Linux、BSDユーザー向け:

./path/to/llamafile - Windowsユーザーの場合:ファイル名を

.exeサフィックスを付けて実行する:.\path\to\llamafile.exe

- macOS、Linux、BSDユーザー向け:

機能操作

- ウェブインターフェースの起動: llamafileを実行すると、ブラウザが自動的にチャット画面を開きます(開かない場合は手動でアクセスしてください)。

http://127.0.0.1:8080/). - OpenAI APIインターフェースの使用: llamafileはOpenAI APIと互換性のあるインターフェイスを提供し、一般的なAPIのユースケースをサポートします。以下のコマンドで呼び出すことができます:

curl http://localhost:8080/v1/chat/completions -H "Content-Type: application/json" -d '{ "model": "LLaMA_CPP", "messages": [{"role": "user", "content": "Hello, world!"}] }' - 画像入力例えば、画像をアップロードして、それについて質問することができます:

curl -X POST http://localhost:8080/v1/images -F "image=@path/to/image.jpg" -F "prompt=Describe this image" - コマンドラインモードllamafileはスクリプト操作のためのコマンドラインモードもサポートしています:

./path/to/llamafile --cli -p "Your prompt here"

一般的な問題

- 能力の問題パーミッションの問題が発生した場合は、ファイルに実行パーミッションがあることを確認してください。

chmod +xコマンド)。 - ファイルサイズ制限Windowsユーザーは、1つの実行ファイルのサイズが4GBを超えないことに注意してください。

- 従属問題macOSユーザーはXcodeをインストールする必要があります。 コマンド ラインツール、Linuxユーザーは、GPUアクセラレーションをサポートするためにCUDA SDKまたはROCm SDKをインストールする必要があるかもしれません。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません