LiveTalking: オープンソースのリアルタイム・インタラクティブ・デジタル・ヒューマン・ライブ・システム。

はじめに

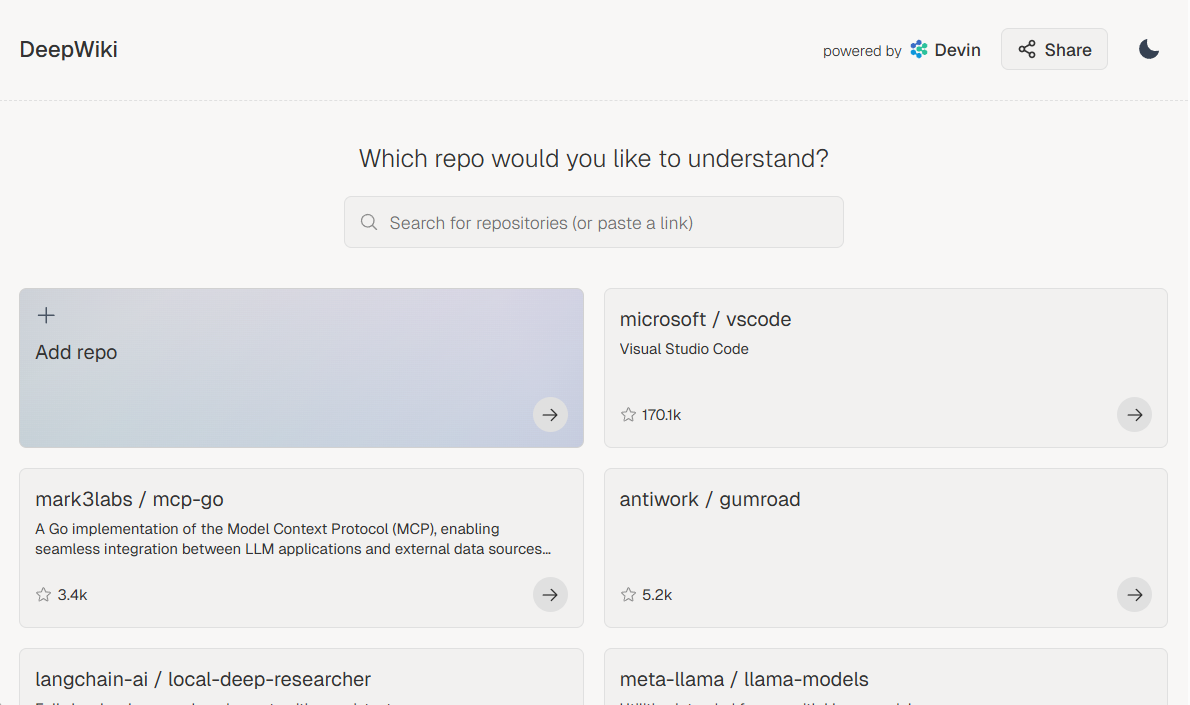

LiveTalkingはオープンソースのリアルタイムインタラクティブデジタルヒューマンシステムで、高品質のデジタルヒューマンライブソリューションの構築に専念しています。このプロジェクトは、Apache 2.0オープンソースプロトコルを使用し、ER-NeRFレンダリング、リアルタイムオーディオ・ビデオストリーム処理、リップシンクロナイゼーションなどの最先端技術を統合しています。このシステムは、リアルタイムのデジタル・ヒューマン・レンダリングとインタラクションをサポートし、ライブ放送、オンライン教育、顧客サービス、その他多くのシナリオに使用できる。LiveTalkingは、リアルタイムのパフォーマンスとインタラクティブな体験に特別な注意を払っており、AIGC技術を統合することで、ユーザーに完全なデジタルヒューマン開発フレームワークを提供しています。このプロジェクトは継続的に更新・保守されており、包括的なドキュメントによってサポートされているため、デジタルパーソン・アプリケーションの構築に理想的な選択肢となっています。

機能一覧

- 複数のデジタル人体モデルをサポート:エルナーフそしてミュージックトークそしてwav2lipそしてウルトラライト・デジタル・ヒューマン

- オーディオとビデオの同時対話を実現

- サウンドクローニングのサポート

- デジタル推進派の発言と妨害

- フルボディビデオスプライシングに対応

- RTMPおよびWebRTCプッシュストリームをサポート

- ビデオスケジューリングのサポート:話していないときにカスタムビデオを再生する

- 複数同時実行をサポート

ヘルプの使用

1.インストールプロセス

- 環境要件 Ubuntu 20.04、Python 3.10、Pytorch 1.12、CUDA 11.3

- 依存関係のインストール ::

conda create -n nerfstream python=3.10

conda activate nerfstream

conda install pytorch==1.12.1 torchvision==0.13.1 cudatoolkit=11.3 -c pytorch

pip install -r requirements.txt

もしトレーニングしなければ。 エルナーフ モデルの場合、以下のライブラリをインストールする必要はありません:

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

pip install tensorflow-gpu==2.8.0

pip install --upgrade "protobuf<=3.20.1"

2.クイックスタート

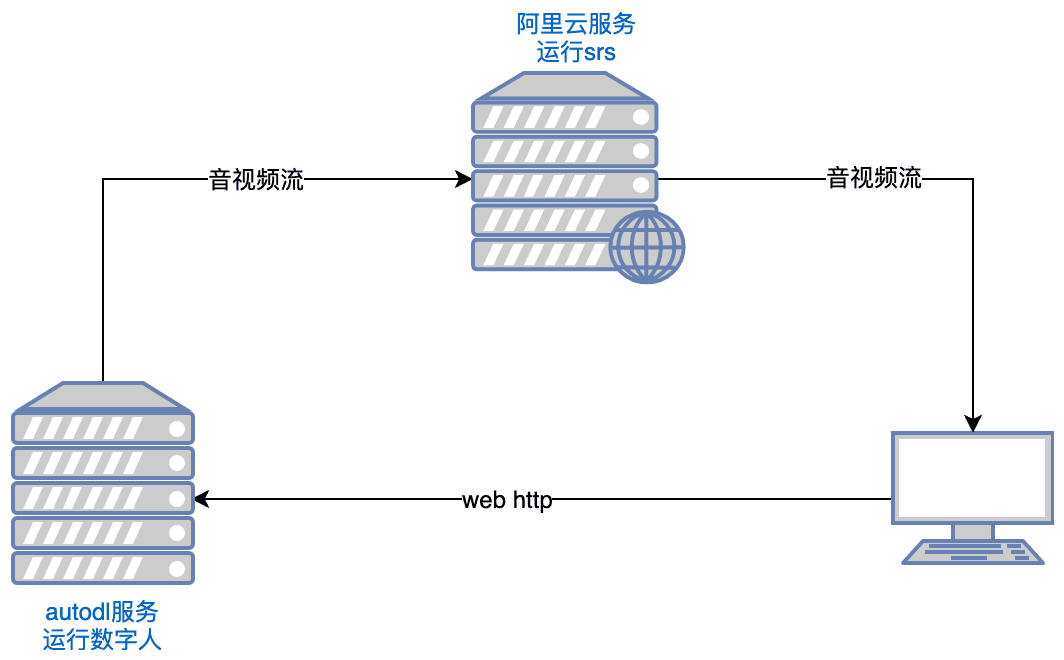

- ランニングSRS ::

export CANDIDATE='<服务器外网ip>'

docker run --rm --env CANDIDATE=$CANDIDATE -p 1935:1935 -p 8080:8080 -p 1985:1985 -p 8000:8000/udp registry.cn-hangzhou.aliyuncs.com/ossrs/srs:5 objs/srs -c conf/rtc.conf

備考: サーバーはポート tcp:8000,8010,1985; udp:8000 を開く必要があります。

- デジタル・パーソンの立ち上げ ::

python app.py

Huggingfaceにアクセスできない場合は、実行前に実行してください:

export HF_ENDPOINT=https://hf-mirror.com

ブラウザで開く http://serverip:8010/rtcpushapi.htmlテキストボックスにテキストを入力して送信すると、デジタル担当者がその文章を放送する。

その他の使用方法

- Dockerの実行 以前のインストールは必要ありません:

docker run --gpus all -it --network=host --rm registry.cn-beijing.aliyuncs.com/codewithgpu2/lipku-metahuman-stream:vjo1Y6NJ3N

コードは /root/metahuman-stream事前 git pull 最新のコードを引っ張り出し、ステップ2と3と同様にコマンドを実行する。

- ミラーリング ::

- autodlイメージ:チュートリアル

- ucloudのミラー:ucloudチュートリアル

- 一般的な問題 Linux CUDA環境のセットアップについては、こちらの記事を参照してください:参考記事

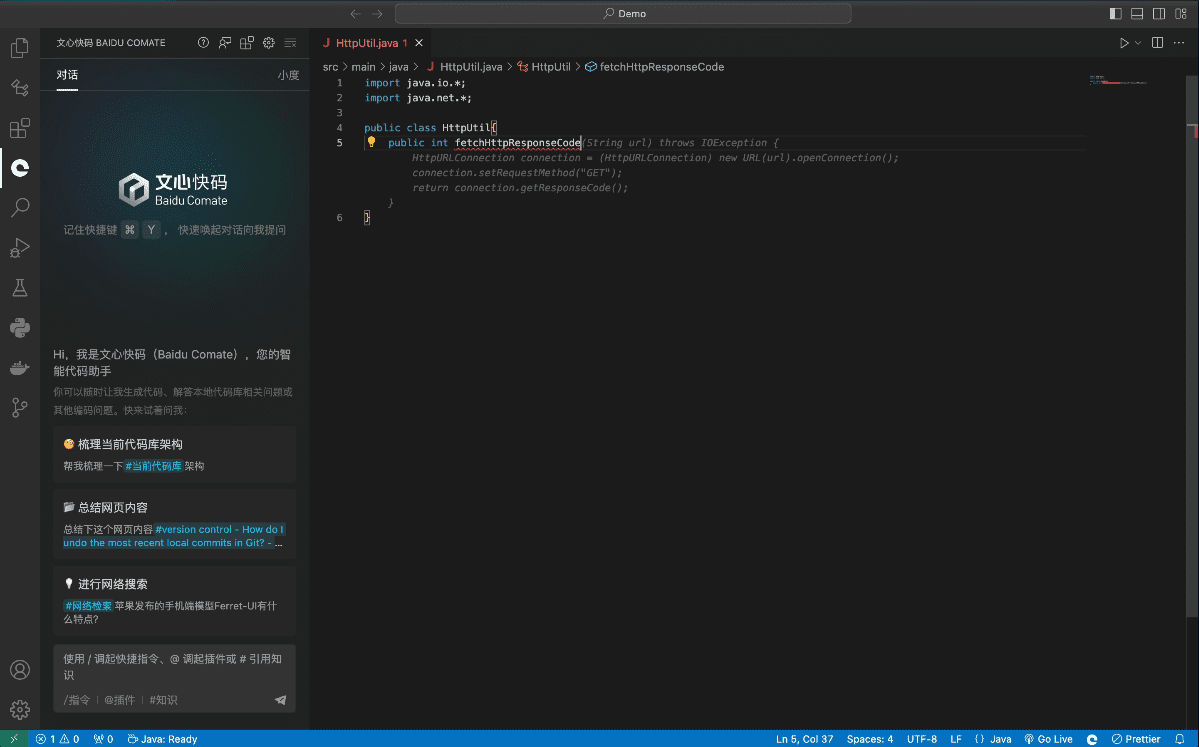

3.設定方法

- システム構成

- config.yamlファイルを編集して基本パラメーターを設定する。

- カメラとオーディオデバイスの設定

- AIモデルのパラメータとパスの設定

- ライブ・プッシュ・ストリーミング・パラメーターの設定

- デジタル人体モデルの準備

- カスタム3Dモデルのインポートをサポート

- 事前に構築されたサンプルモデルを使用することができます。

- MetaHumanモデルのインポートをサポート

主な機能

- リアルタイムのオーディオとビデオの同期対話::

- デジタイザーモデルの選択:設定ページで適切なデジタイザーモデル(ernerf、musetalkなど)を選択します。

- 音声・映像伝送方式の選択:要件に応じて適切な音声・映像伝送方式(WebRTC、RTMPなど)を選択する。

- ダイアログの開始:オーディオ/ビデオ伝送を開始し、リアルタイムのオーディオ/ビデオ同期ダイアログを実現します。

- デジタル人体モデル切り替え::

- Setup ページに入る: Project Run ページで、Setup ボタンをクリックして Setup ページに入る。

- 新しいモデルを選択:設定ページで新しいデジモンモデルを選択し、設定を保存します。

- プロジェクトを再起動: 新しいモデル構成を適用するためにプロジェクトを再起動します。

- オーディオとビデオのパラメーター調整::

- パラメータ設定ページに入る: プロジェクトの実行ページで、パラメータ設定ボタンをクリックしてパラメータ設定ページに入る。

- 調整パラメーター:必要に応じてオーディオとビデオのパラメーター(解像度、フレームレートなど)を調整します。

- Save and apply(保存して適用):設定を保存し、新しいパラメータ構成を適用します。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません