LiteLLM: 複数のビッグモデルAPIを統合的に呼び出すPython SDK、マルチプラットフォームLLM呼び出し・管理ツール

はじめに

LiteLLMは、BerriAIによって開発されたPython SDKとプロキシサーバーで、複数の大規模言語モデル(LLM)APIの呼び出しと管理を簡素化し、統一します。OpenAI、HuggingFace、Azureなどを含む100以上のラージモデルAPIをサポートし、OpenAIフォーマットに統一しているため、開発者は異なるAIサービス間の切り替えや管理を簡単に行うことができます。また、安定したDockerイメージと詳細な移行ガイドも提供します。LiteLLMは、プロキシサーバーとPython SDKを通じて、100以上のLLM APIをOpenAI形式で呼び出すことができ、開発効率と柔軟性を大幅に向上させます。

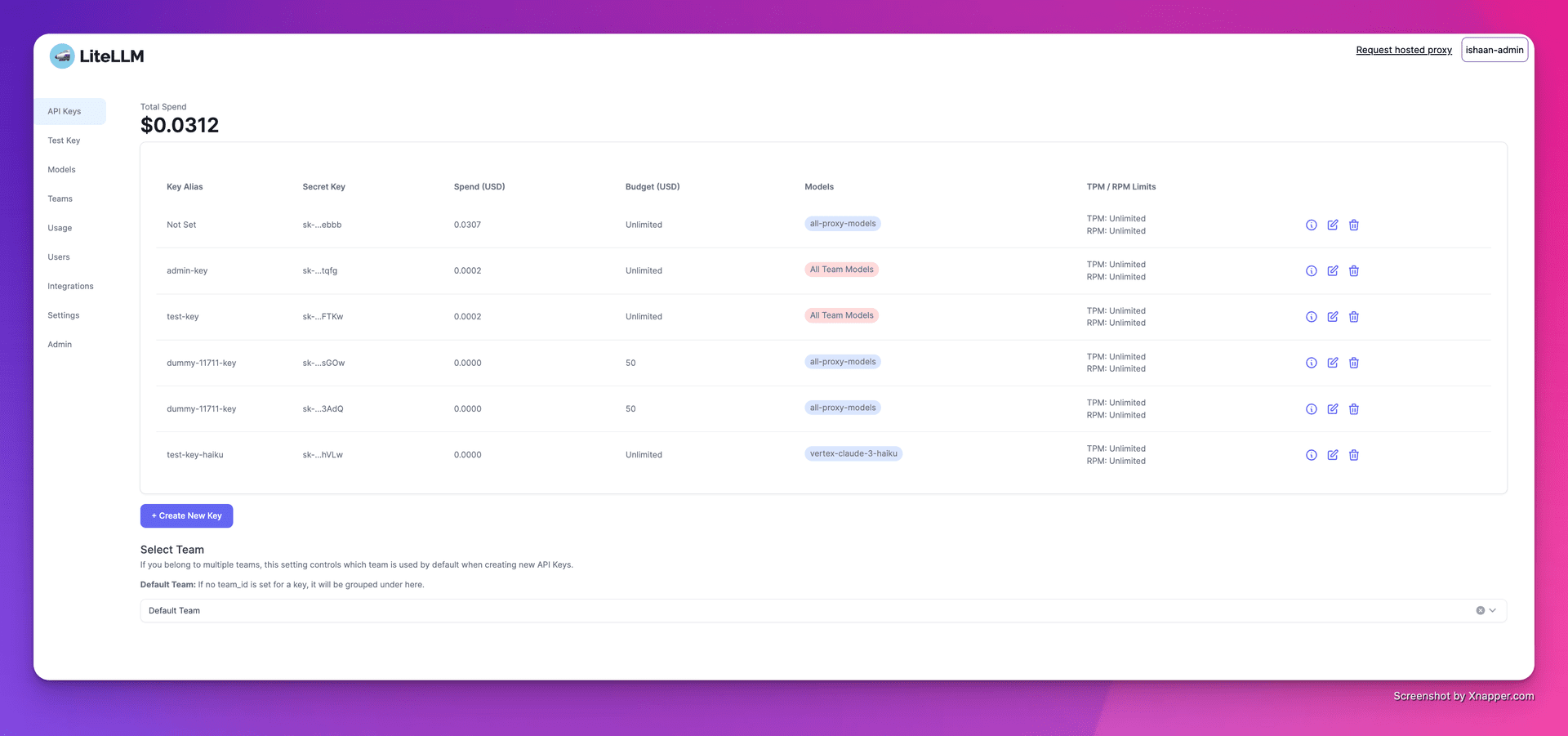

1.キーの作成

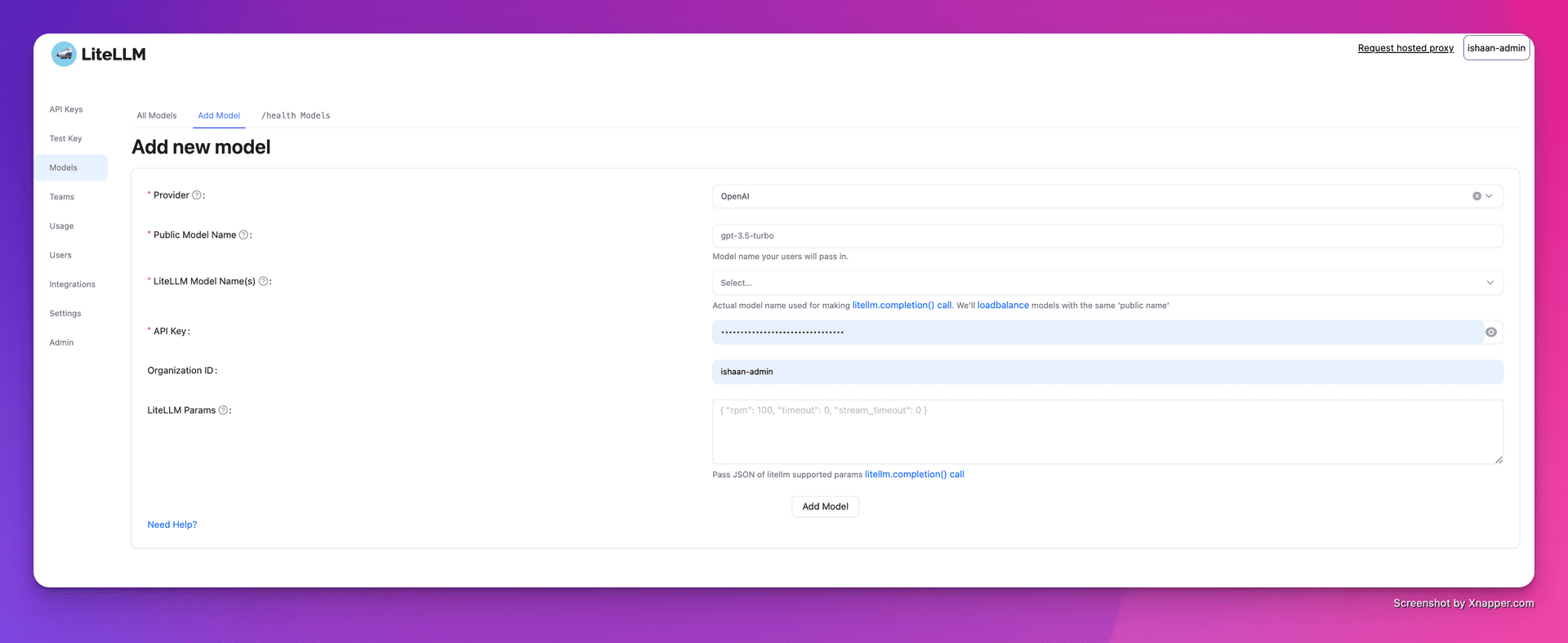

2.モデルの追加

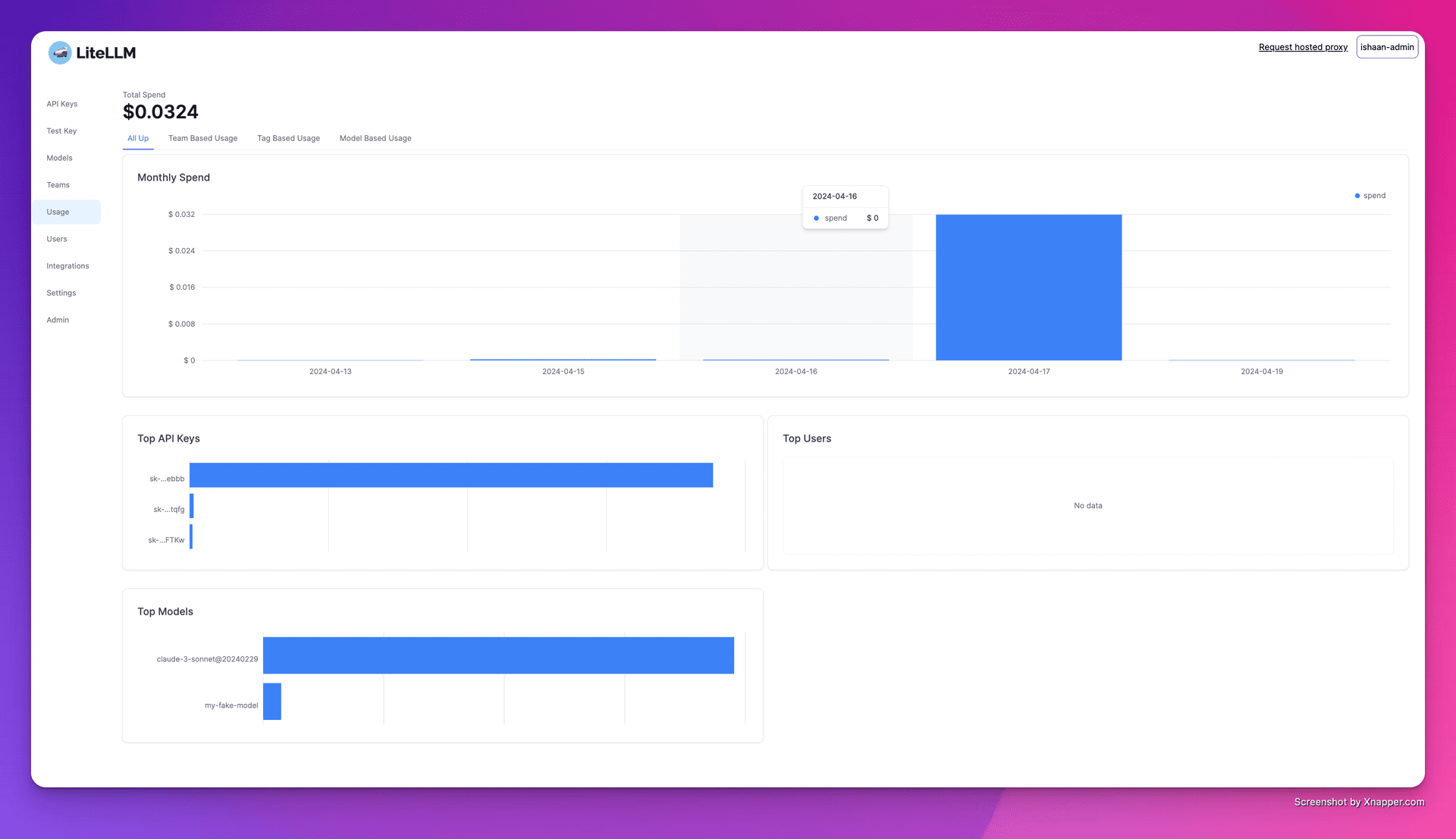

3.支出の追跡

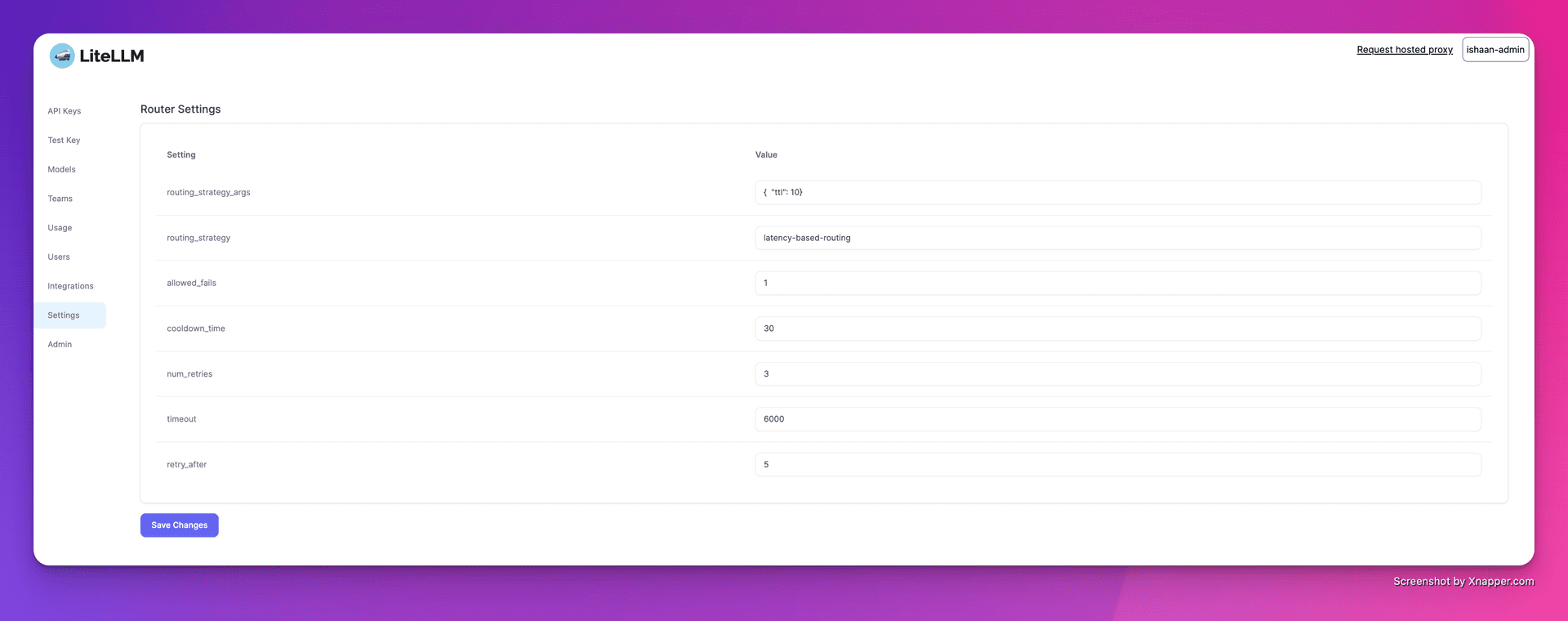

4.ロードバランシングの設定

機能一覧

- マルチプラットフォーム対応OpenAI、Cohere、Anthropicなど、複数のLLMプロバイダーをサポート。100以上のビッグモデルAPIコールをサポート。

- 安定版12時間の負荷テストを実施した安定したDockerイメージを提供します。予算とリクエスト頻度の制限設定に対応。

- プロキシサーバー複数のLLM APIをプロキシサーバ経由で統一的に呼び出し、APIフォーマットをOpenAIフォーマットに統一的に変換。

- Python SDK開発プロセスを簡素化するためにPython SDKが提供されています。

- ストリーミング対応ユーザー・エクスペリエンスを向上させるために、ストリーミング・リターン・モデル・レスポンスをサポート。

- コールバック関数複数のコールバックをサポートし、ロギングやモニタリングを容易にします。

ヘルプの使用

インストールとセットアップ

- DockerのインストールDockerがシステムにインストールされていることを確認してください。

- プルミラー使用

docker pullコマンドはLiteLLMの安定したイメージを取り出します。 - プロキシサーバーの起動::

cd litellm echo 'LITELLM_MASTER_KEY="sk-1234"' > .env echo 'LITELLM_SALT_KEY="sk-1234"' > .env source .env poetry run pytest . - クライアントの設定プロキシサーバーのアドレスとAPIキーをコードに設定します。

import openai client = openai.OpenAI(api_key="your_api_key", base_url="http://0.0.0.0:4000") response = client.chat.completions.create(model="gpt-3.5-turbo", messages=[{"role": "user", "content": "Hello, how are you?"}]) print(response)

使用機能

- 呼び出しモデルスルー

model=<provider_name>/<model_name>異なるプロバイダーのモデルを呼び出す。 - ストリーミング対応設定

stream=Trueストリーミング応答を取得する。response = await acompletion(model="gpt-3.5-turbo", messages=messages, stream=True) for part in response: print(part.choices.delta.content or "") - コールバックの設定入出力を記録するコールバック関数を設定します。

litellm.success_callback = ["lunary", "langfuse", "athina", "helicone"]

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません