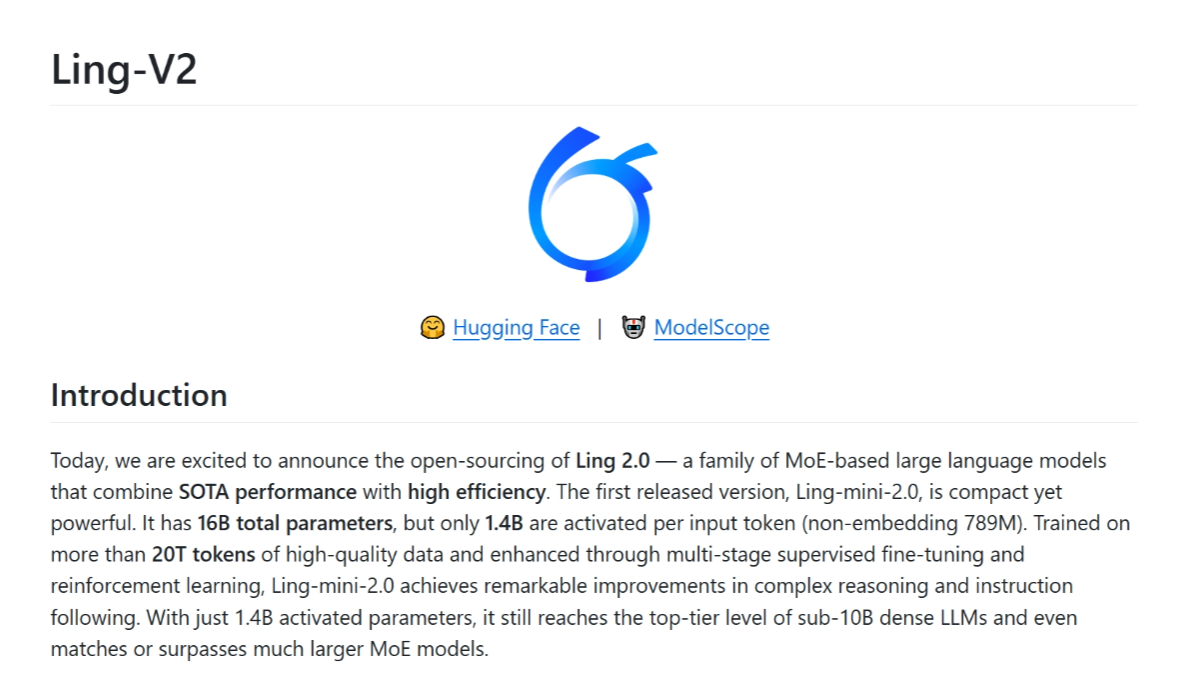

Ling-V2 - Ant-BellingオープンソースのMoEアーキテクチャ言語モデルシリーズ

Ling-V2とは?

Ling-V2は、Ant-Bellingチームによって導入されたMoEアーキテクチャに基づく大規模言語モデルファミリーである。 最初のバージョンLing-mini-2.0は、総パラメータが160億であり、入力トークンあたり14億パラメータしか活性化されない。このモデルは20兆個の高品質データトークンで学習され、多段教師付き微調整と強化学習によって強化され、強力な複雑推論と命令順守を備えています。MoEアーキテクチャの1/32活性化比に基づき、7倍相当の高密度性能の活用、高速生成、効率的な学習と推論を達成し、FP8効率的学習ソリューションでオープンソース化されており、様々な事前学習チェックポイントを提供し、継続的な学習をサポートします。MoEはMoE研究の理想的な出発点であり、自然言語処理、インテリジェントなカスタマーサービス、コンテンツ作成、教育、ヘルスケアなどの分野で広く利用されています。

Ling-V2の機能的特徴

- 高い推理力コーディング、数学、領域横断的な知識を必要とするタスクを含む複雑な推論タスクに優れており、部分的に密なモデルや大規模なMoEモデルを超える正確なソリューションを提供します。

- 優れたパフォーマンス効率1/32の活性化比を持つMoEアーキテクチャに基づき、7~8億の高密度モデルの性能を達成するために14億のパラメータを活性化するだけで、生成速度は最大300+トークン/秒となり、長文を扱う際の効率が大幅に改善されます。

- 高度なトレーニング技術オープンソースのFP8学習スキームにより、メモリ使用量がさらに最適化され、学習スループットが大幅に向上しました。

- オープンソース戦略また、研究者による継続的なトレーニングや綿密な研究を容易にするため、5つの事前トレーニング・チェックポイントがオープンソース化されている。

Ling-V2の主な利点

- 高性能と効率のバランス1/32活性化比MoEアーキテクチャにより、Ling-V2は高性能を維持しながら計算効率を大幅に向上させた。

- 効率的なトレーニングソリューションオープンソースのFP8学習スキームにより、メモリ使用量がさらに最適化され、学習スループットが大幅に向上し、計算リソースの消費量が削減されるため、モデル学習がより効率的かつ経済的になります。

- オープンソース戦略トレーニング済みモデルの利用可能性と、5つのトレーニング前チェックポイントのオープンソース化は、研究者に柔軟性と利便性を提供し、継続的なトレーニングや詳細な研究をサポートし、インクルーシブテクノロジーの開発を促進します。

- 幅広いアプリケーション・シナリオLing-V2は、自然言語処理、インテリジェントな顧客サービス、コンテンツ作成、教育、ヘルスケアなどの分野を含むさまざまなアプリケーションシナリオに適しており、高い実用性と適応性でさまざまな業界やユーザーのニーズに応えることができます。

Ling-V2の公式ウェブサイトは?

- GitHubリポジトリ:: https://github.com/inclusionAI/Ling-V2

- HuggingFaceモデルライブラリ:: https://huggingface.co/collections/inclusionAI/ling-v2-68bf1dd2fc34c306c1fa6f86

Ling-V2が適応となる人

- 自然言語処理(NLP)研究者Ling-V2は、自然言語処理研究に携わるプロフェッショナルに強力な推論機能と効率的な学習ソリューションを提供し、テキスト分類、感情分析、機械翻訳の分野で飛躍的な進歩を遂げるユーザーを支援します。

- コーポレート・テクニカル・チームテキストデータを効率的に処理する必要がある企業の技術チームにとって、このモデルはインテリジェントなカスタマーサービス、コンテンツ作成、ナレッジ管理システムに統合され、企業の業務効率とユーザー体験を向上させます。

- 教育者と学生教育分野では、教育者と生徒のためのパーソナライズされた教育支援。

- 医療関係者症例分析、医学文献検索などで医師を支援し、医療分野における意思決定の正確性と効率性を向上させる。

- コンテンツクリエーターLing-V2はコンテンツ制作を支援し、クリエイターの作業効率とクオリティを向上させ、創造性を刺激します。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません