LHM:1枚の画像から動き対応の3D人体モデルを生成する

はじめに

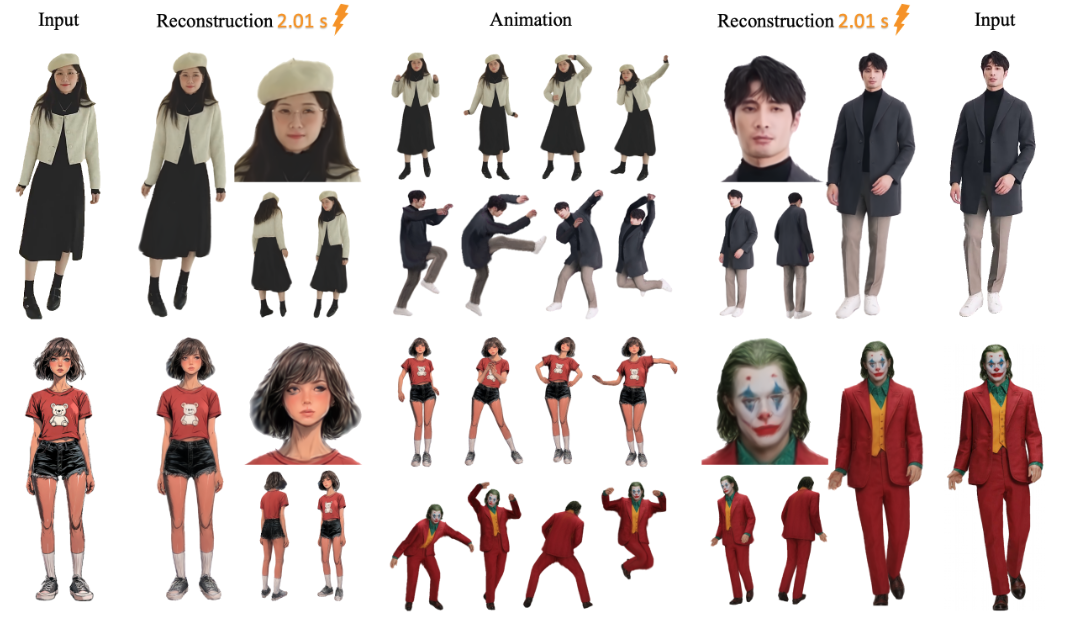

LHM(Large Animatable Human Reconstruction Model)は、aigc3dチームによって開発されたオープンソースプロジェクトで、1枚の画像からアクションをサポートする3D人体モデルを素早く生成することができます。LHMは、人体を表現するために3Dガウススプラット技術を使用し、衣服の質感や幾何学的なディテールを保持するマルチモーダル変換アーキテクチャと組み合わせています。2025年3月13日に初めてリリースされたこのプロジェクトは、3Dデジタルヒューマン関連アプリケーションの研究や開発に適した、事前学習済みのモデルとコードを提供する。

機能一覧

- 1枚の画像から数秒で3Dマネキンを生成。

- リアルタイムレンダリングをサポートしており、生成されたモデルを直接見ることができる。

- ダイナミックな映像を生成するために、人体の姿勢を調整するアクション機能を提供する。

- 後の編集用に3Dメッシュファイル(OBJ形式など)を出力。

- 事前に訓練されたモデル(LHM-0.5BやLHM-1Bなど)が含まれており、それ自体を訓練する必要はない。

- ローカル・ビジュアライゼーションをサポートするGradioインターフェイスを統合。

- ビデオからアクションを抽出してモデルに適用するビデオ処理パイプラインを提供します。

ヘルプの使用

LHMの使い方は、インストールと操作の2つに分かれます。以下は、すぐに使い始めるための詳しい手順です。

設置プロセス

- 環境を整える

システムには、Python 3.10とCUDA(バージョン11.8または12.1をサポート)が必要です。少なくとも16GBのビデオメモリを搭載したA100や4090などのNVIDIAグラフィックカードを推奨。- Pythonのバージョンを確認してください:

python --version - CUDAのバージョンを確認してください:

nvcc --version

- Pythonのバージョンを確認してください:

- クローン倉庫

ターミナルで以下のコマンドを入力し、LHMコードをダウンロードする:git clone https://github.com/aigc3d/LHM.git cd LHM

- 依存関係のインストール

CUDAのバージョンに応じて対応するスクリプトを実行します:- CUDA 11.8:

sh ./install_cu118.sh - CUDA 12.1:

sh ./install_cu121.sh

スクリプトが失敗した場合は、依存関係を手動でインストールしてください:

pip install -r requirements.txt - CUDA 11.8:

- ダウンロードモデル

モデルは自動的にダウンロードされます。手動でダウンロードしたい場合は、以下のコマンドを使用する:- LHM-0.5Bモデル:

wget https://virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/LHM-0.5B.tar tar -xvf LHM-0.5B.tar - LHM-1Bモデル:

wget https://virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/LHM-1B.tar tar -xvf LHM-1B.tar

これをダウンロードし、プロジェクトのルート・ディレクトリに解凍する。

- LHM-0.5Bモデル:

- インストールの確認

テストコマンドを実行し、環境に問題がないことを確認する:python app.py成功すれば、Gradioインターフェースが起動する。

ワークフロー

3Dモデルの生成

- 写真を準備する

人体全体を含む鮮明な画像を用意し、ローカルに保存する。<path_to_image>/person.jpg. - 推論スクリプトの実行

それをターミナルに入力する:bash ./inference.sh ./configs/inference/human-lrm-1B.yaml LHM-1B <path_to_image>/ ./output/<path_to_image>は画像のパスです。./output/は、生成された結果が保存される出力フォルダです。

- 結果を見る

生成後<output>フォルダには、3Dモデルファイルとレンダリングされた動画があります。メッシュファイルを3Dソフトウェア(Blenderなど)で開いたり、ビデオを直接再生することができます。

アクションの追加

- 準備運動シーケンス

このプロジェクトでは、サンプル・アクション・ファイルを<LHM根目录>/train_data/motion_video/mimo1/smplx_params.また、独自のSMPL-Xパラメータファイルを使用することもできます。 - アクションスクリプトの実行

以下のコマンドを入力する:bash ./inference.sh ./configs/inference/human-lrm-1B.yaml LHM-1B <path_to_image>/ <path_to_motion>/smplx_params<path_to_motion>はアクションファイルのパスです。

- アクションビデオのプレビュー

出力フォルダはアクションビデオを生成し、直接再生できる。

グラディオ・インターフェースの使用

- 起動インターフェース

ターミナルで実行:python app.pyブラウザが開きます

http://0.0.0.0:7860. - 写真をアップロードする

インターフェイスに体の写真をアップロードし、"Submit "をクリックします。 - 結果を出す

数秒後、インターフェイスにレンダリング画像とアクションビデオが表示され、ダウンロードして見ることができる。

3Dメッシュのエクスポート

- エクスポート・スクリプトの実行

インプット:bash ./inference_mesh.sh ./configs/inference/human-lrm-1B.yaml LHM-1B - ファイルを探す。

出力フォルダには、3Dソフトウェアで編集可能なOBJ形式のメッシュファイルがあります。

ほら

- 写真は鮮明である必要があり、シンプルな背景の方が効果的だ。

- アクションの効果は、入力されたアクションの質に依存する。

- ビデオメモリが足りない場合は、LHM-0.5Bモデルをお試しください。

アプリケーションシナリオ

- ゲーム開発

開発者はLHMを使って、写真から3Dキャラクターモデルを素早く生成し、ポーズを調整してゲームエンジンにインポートすることができ、モデリングの時間を節約できます。 - 映画・テレビ制作

映画やテレビのチームは、LHMを使用してデジタル・スタンドインを作成し、特殊効果シーンで使用するアクション・ビデオを生成することで、手作業によるモデリング・コストを削減することができる。 - バーチャルキャスター (TV)

ホストは自分の写真をアップロードして3D画像を生成し、アクションを追加してパーソナライズされたバーチャル画像を作成できる。 - 教育研究

研究者たちは、LHMを使って3D再構成アルゴリズムをテストしたり、教室で写真からモデルへの変換プロセスを実演したりすることができた。

品質保証

- LHMはどのような画像フォーマットに対応していますか?

JPG、PNG、JPGなどの一般的なフォーマットをサポートし、ファイルサイズは10MB以下を推奨。 - モデルの生成にはどのくらい時間がかかりますか?

A100カードで約0.2秒、4090カードで1~2秒、ハードウェアによって多少異なる。 - モデルを自分でトレーニングできますか?

可能だが、トレーニングスクリプトは公式には提供されていない。データセットの準備とコードのチューニングが必要で、経験者向き。 - 出力された3Dモデルは編集できますか?

できます。OBJファイルをエクスポートしたら、BlenderまたはMayaでジオメトリとテクスチャを編集します。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません