LazyLLM:マルチインテリジェント・ボディ・アプリケーション構築のためのShangtangオープンソース・ローコード開発ツール

はじめに

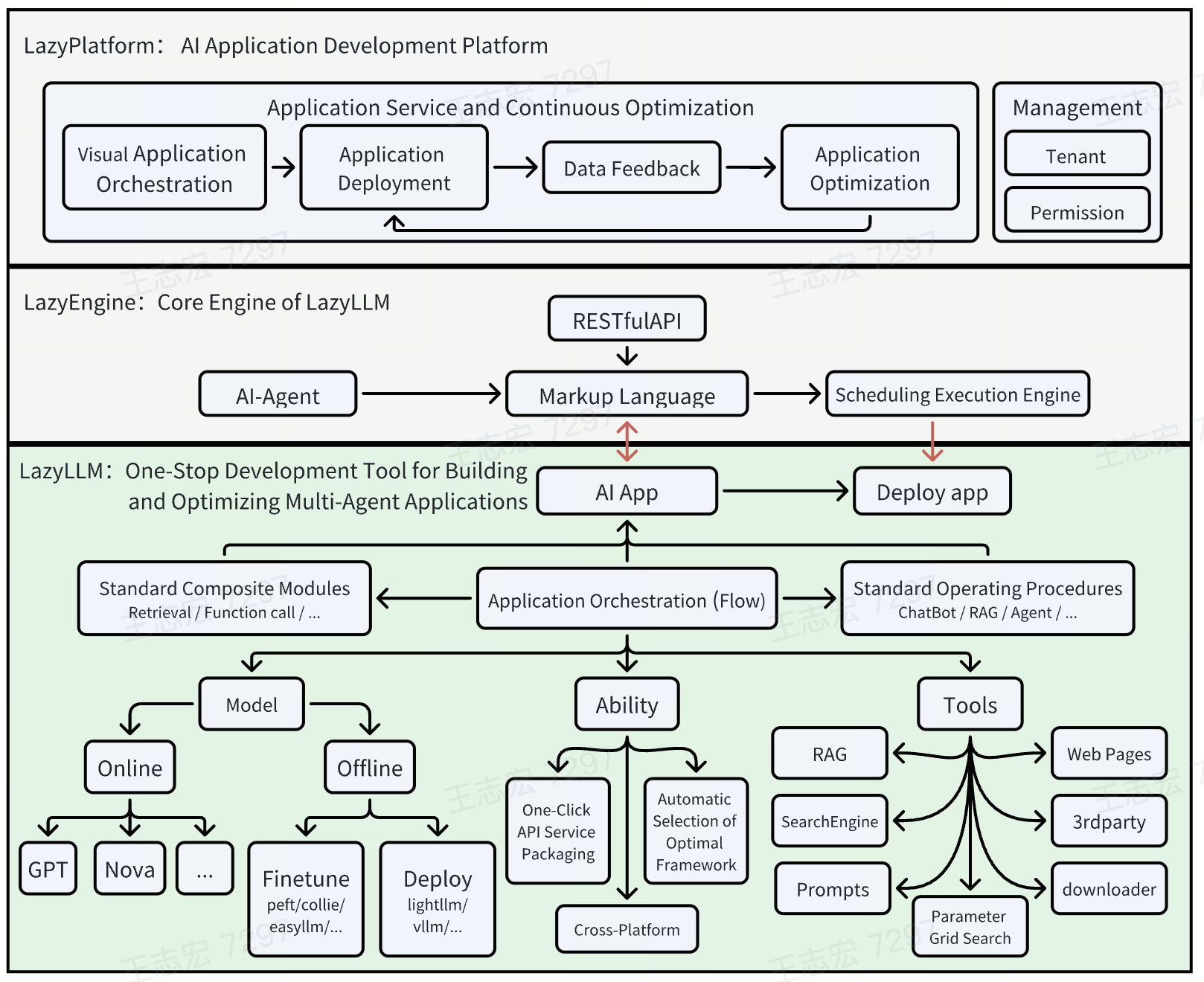

LazyLLMはLazyAGIチームによって開発されたオープンソースツールで、マルチインテリジェンス大規模モデルアプリケーションの開発プロセスの簡素化に焦点を当てています。開発者が複雑なAIアプリケーションを素早く構築し、ワンクリックのデプロイメントと軽量のゲートウェイ機構によって、面倒なエンジニアリングの設定にかかる時間を節約することができます。初心者でも経験豊富な開発者でも、LazyLLMはサポートを提供します。初心者は事前にビルドされたモジュールで簡単に始めることができ、熟練者は柔軟なカスタマイズ機能で高度な開発を実現できます。LazyLLMは効率性と実用性を重視し、可能な限り低いコストで生産可能なアプリケーションを構築できるよう、好ましいコンポーネントを統合しています。GitHubには1100以上のスターがあり、活発なコミュニティがあるため、アップデートは継続的に行われています。

機能一覧

- ワンクリックで複雑なアプリケーションをデプロイプロトタイプの検証から製品リリースまでの全プロセスを、サブモジュール・サービスの自動構成でサポートします。

- クロスプラットフォームの互換性ベアメタルサーバー、開発マシン、Slurmクラスター、パブリッククラウドにコード変更なしで適応します。

- データフロー管理(フロー)複雑なアプリケーション・ロジックを簡単に整理するために、パイプラインやパラレルといった定義済みのプロセスを提供します。

- モジュラーコンポーネントカスタマイズや拡張、ユーザーアルゴリズムやサードパーティツールの統合をサポートします。

- 軽量ゲートウェイ機構サービス起動とURL設定を簡素化し、より効率的な開発を実現。

- マルチインテリジェンス開発をサポート大規模なモデルタスクに適応した複数のAIエージェントを含むアプリケーションを迅速に構築します。

ヘルプの使用

設置プロセス

LazyLLMはPythonベースのオープンソースプロジェクトです。詳しい手順は以下の通りです:

環境準備

- システム要件の確認Python 3.8以上がインストールされていることを確認してください。

- GitのインストールGitがインストールされていない場合は、次のようなコマンドラインツールを使うことができる。

apt-get install gitもしかしたらbrew install git) インストール。 - 仮想環境の作成(オプションだが推奨)::

python -m venv lazyllm_env source lazyllm_env/bin/activate # Linux/Mac lazyllm_env\Scripts\activate # Windows

ダウンロードとインストール

- GitHubリポジトリのクローン::

git clone https://github.com/LazyAGI/LazyLLM.git cd LazyLLM - 依存関係のインストール::

- 以下のコマンドを実行して、必要なライブラリをインストールする:

pip install -r requirements.txt - 依存関係の衝突が発生した場合は、pipをアップグレードしてみてください:

pip install --upgrade pip

- 以下のコマンドを実行して、必要なライブラリをインストールする:

- インストールの確認::

- サンプルコードを実行して、インストールが成功したことを確認します:

python -m lazyllm --version - バージョン番号が返されれば(例えばv0.5)、インストールは完了です。

- サンプルコードを実行して、インストールが成功したことを確認します:

オプション:Dockerデプロイメント

- LazyLLMはDockerのワンクリックイメージパッケージングをサポートしています:

- Dockerをインストールする(公式サイトhttps://docs.docker.com/get-docker/)。

- プロジェクトのルート・ディレクトリで実行する:

docker build -t lazyllm:latest . docker run -it lazyllm:latest

使用方法

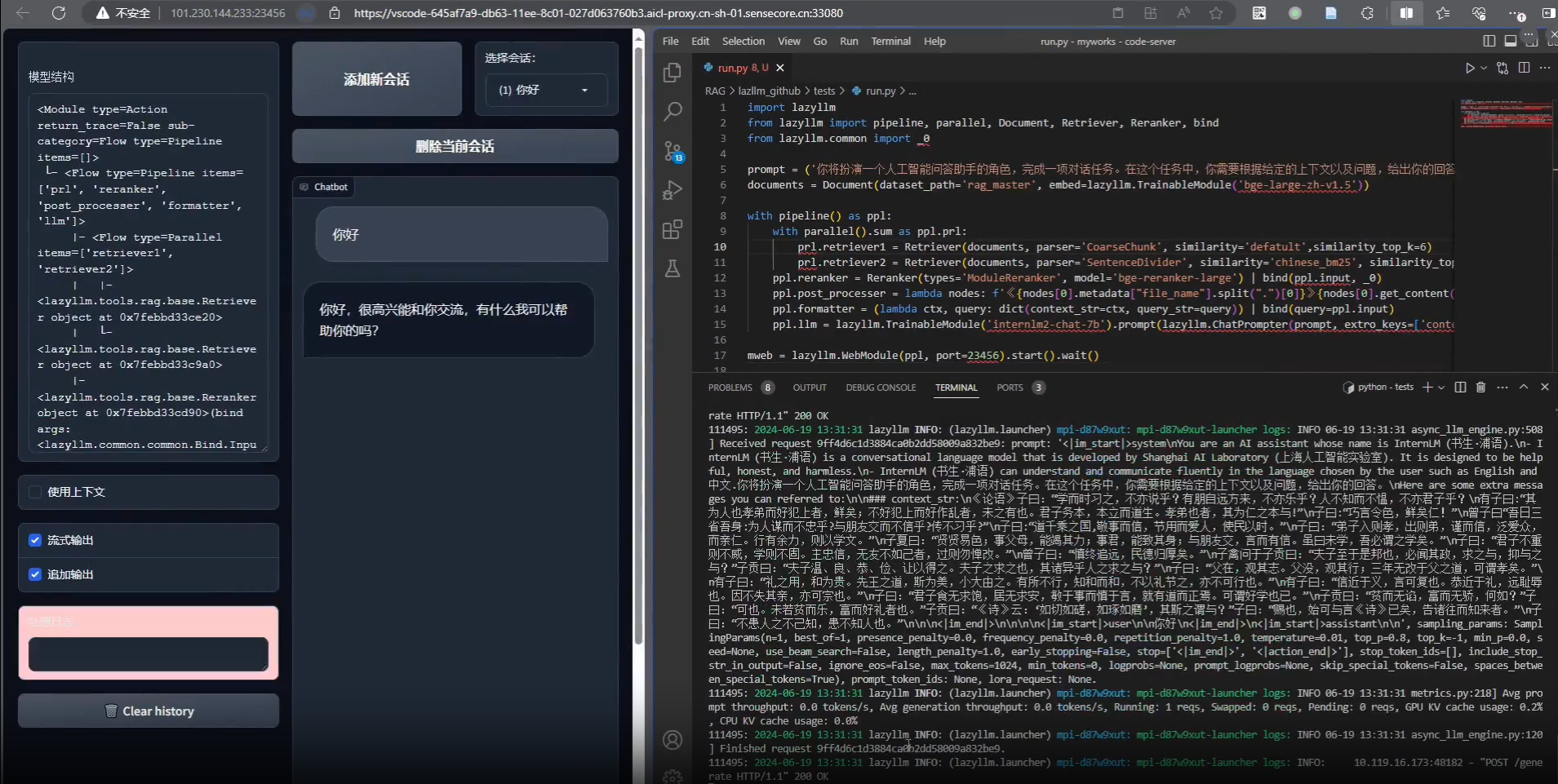

LazyLLMの中核にあるのは、モジュール化とデータフロー管理によってAIアプリケーションを迅速に構築する機能です。以下は、主要機能の詳細なハウツーガイドです:

特長1:複雑なアプリケーションをワンクリックでデプロイ

- 手続き::

- アプリケーション設定ファイルの準備を作成する。

config.yamlモジュールとサービスを定義する。例えばmodules: - name: llm type: language_model url: http://localhost:8000 - name: embedding type: embedding_service url: http://localhost:8001 - サービス開始::

python -m lazyllm deploy - ステータス確認ログ出力にアクセスし、すべてのモジュールが正しく動作していることを確認します。

- アプリケーション設定ファイルの準備を作成する。

- 主な内容この機能により、手動でURLを設定する必要がなくなり、ラピッドプロトタイピングに最適です。

特徴2:クロスプラットフォームの互換性

- 手続き::

- 指定プラットフォームコマンドラインにパラメーターを追加する:

python -m lazyllm deploy --platform slurm - スイッチング環境コードを変更する必要はありません。

--platformパラメーター(例cloudもしかしたらbare_metal).

- 指定プラットフォームコマンドラインにパラメーターを追加する:

- アプリケーションシナリオ開発者はローカルでテストした後、シームレスにクラウドに移行することができ、適応の手間を省くことができる。

機能3:データフロー管理(フロー)

- 手続き::

- データフローの定義Pythonスクリプトで定義済みのFlowを呼び出す:

from lazyllm import pipeline flow = pipeline( step1=lambda x: x.upper(), step2=lambda x: f"Result: {x}" ) print(flow("hello")) # 输出 "Result: HELLO" - 複雑なプロセスの実行パラレルまたはディバーターと組み合わせたマルチタスク:

from lazyllm import parallel par = parallel( task1=lambda x: x * 2, task2=lambda x: x + 3 ) print(par(5)) # 输出 [10, 8]

- データフローの定義Pythonスクリプトで定義済みのFlowを呼び出す:

- 主な内容Flowは、データ変換の重複を減らし、モジュール間の共同開発をサポートするために、標準化されたインターフェースを提供します。

機能4:モジュラー・コンポーネントのカスタマイズ

- 手続き::

- カスタム関数の登録::

from lazyllm import register @register def my_function(input_text): return f"Processed: {input_text}" - アプリケーションへの統合フローまたは配置構成で呼び出される

my_function.

- カスタム関数の登録::

- 高度な使用法ハイブリッドスクリプト開発のためのBashコマンド登録に対応。

ヒントとコツ

- テスト中にコンポーネントを調整するランタイムの追加

--verboseパラメーターで詳細なログを見ることができる:python -m lazyllm deploy --verbose - 地域支援GitHub Issuesでフィードバックを提出すれば、チームはタイムリーに対応します。

- 更新最新のコードを定期的に引っ張ってくる:

git pull origin main

これらのステップを踏むことで、LazyLLMをすぐに使い始めることができ、単純なプロトタイプから生産レベルの大規模なモデルまで、様々なアプリケーションを構築することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません