インセプション・ラボ、初の商用グレード拡散ビッグ・ランゲージ・モデルをリリース

Inception Labsは、既存のLLMより最大10倍高速かつ安価なDiffused Large Language Models(dLLM)のMercuryファミリーを発表し、言語モデリングをインテリジェンスとスピードの新境地に押し上げます。

センター

- Inception Labs社は、Diffused Large Language Models (dLLM)のMercuryファミリーを正式にリリースし、新世代のLLMの誕生と、高速で高品質なテキスト生成技術の新たなレベルの到来を告げた。

- Mercuryは、現在の速度に最適化されたLLMよりも10倍高速です。NVIDIA H100 GPU上では、Mercuryモデルは1,000トークン/秒以上で動作し、これはこれまでカスタムチップでしか実現できなかった速度です。

- コード生成モデル マーキュリーコーダー 現在 運動場 Inception Labsは、APIとネイティブなデプロイメントを通じて、企業のお客様にコードモデルとジェネリックモデルへのアクセスを提供します。

インセプション・ラボのビジョン - 次世代のLLMに力を与える普及

現在の大規模言語モデル(LLM)は一般的に自己回帰モデルを使用している。 トークン テキストの生成。この生成は本質的に直列的であり、後続のトークンを生成する前に前のトークンを生成する必要があり、生成された各トークンは数十億のパラメータを持つニューラルネットワークを評価する必要がある。業界をリードするLLM企業は、モデルの推論とエラー訂正能力を向上させるために、推論時間の計算量の増加に賭けているが、長時間の推論プロセスを生成することは、推論コストの高騰とレイテンシの増加を引き起こし、最終的に製品を使いづらくしている。高品質のAIソリューションを真にユビキタスにするためには、パラダイムシフトが不可欠である。

拡散モデルは、そのようなパラダイムシフトの可能性を提供する。このようなモデルは、「粗いものから細かいものへ」という生成プロセスを用いる。ビデオに示されているように、モデルの出力は純粋なノイズから始まり、いくつかの「ノイズ除去」ステップで徐々に最適化されていく。

自己回帰モデルとは異なり、拡散モデルは以前に出力されたものだけを考慮するという制約を受けない。そのため、推論や応答の構造化に優れている。さらに、拡散モデルはその出力を継続的に最適化することができるため、エラーを効果的に修正し、錯覚を減らすことができる。Sora、Midjourney、Riffusionなど、映像・画像・音声生成における現在の優れたAIソリューションの多くが拡散モデルを中核に据えているのは、こうした利点に基づくものだ。しかし、テキストやコードなどの離散データに拡散モデルを適用する試みは、これまで成功したことがなかった。Mercuryまでは、その状況は完全に破綻していた。

Mercury Coder - 1000+トークン/秒、最先端のインテリジェンスを指先で!

Inception Labsは、初の一般利用可能なdLLMであるMercury Coderのリリースを発表します。

Mercury Coderは、画像拡散モデリングのパイオニアであるだけでなく、直接選好最適化(DPO)や意思決定変換器を含む多くの中核的な生成AIの共同発明者でもあるInception Labsの創設チームによる画期的な研究の成果です。Mercury Coderは、画像拡散モデリングのパイオニアであるだけでなく、直接選好最適化(DPO)、フラッシュ・アテンション、デシジョン・トランスフォーマーなど、多くの中核的な生成AI技術を共同発明したInception Labsの創設チームによる画期的な研究の成果です。

dLLMは、既存の自己回帰型LLMを直接置き換えるものとして使用することができ、RAG(Retrieval Augmentation Generation)、ツール使用、エージェントワークフローを含むすべてのアプリケーションシナリオをサポートします。dLLMは、ユーザークエリを受信すると、トークン単位で回答を生成するのではなく、上のアニメーションに示すように、粗いものから細かいものへと回答を生成します。 トランスフォーマーモデル(Mercury Coderで使用)は、大量のデータでトレーニングされており、複数のトークンを並列に修正して結果を継続的に改善しながら、回答の品質をグローバルに最適化することができます。Transformer モデル(Mercury Coder で使用)は、大量のデータで学習され、回答の品質をグローバルに最適化し、複数のトークンを並行して修正して結果を継続的に改善します。

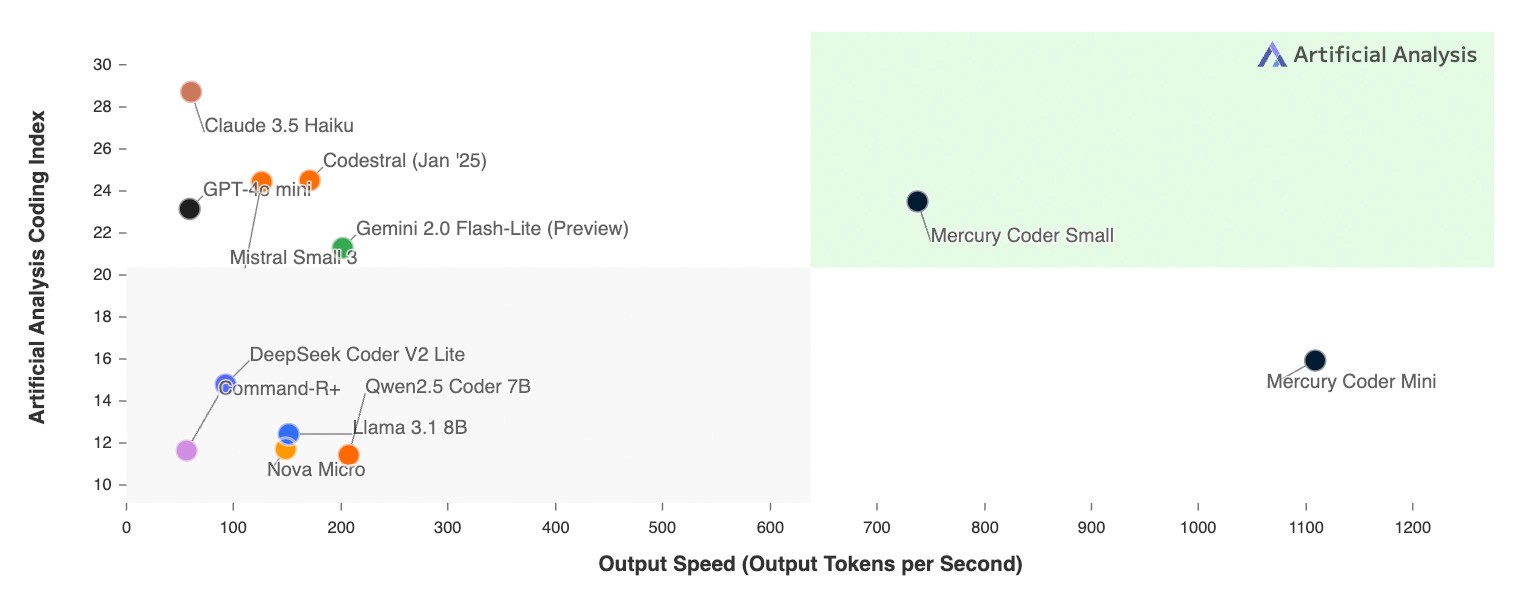

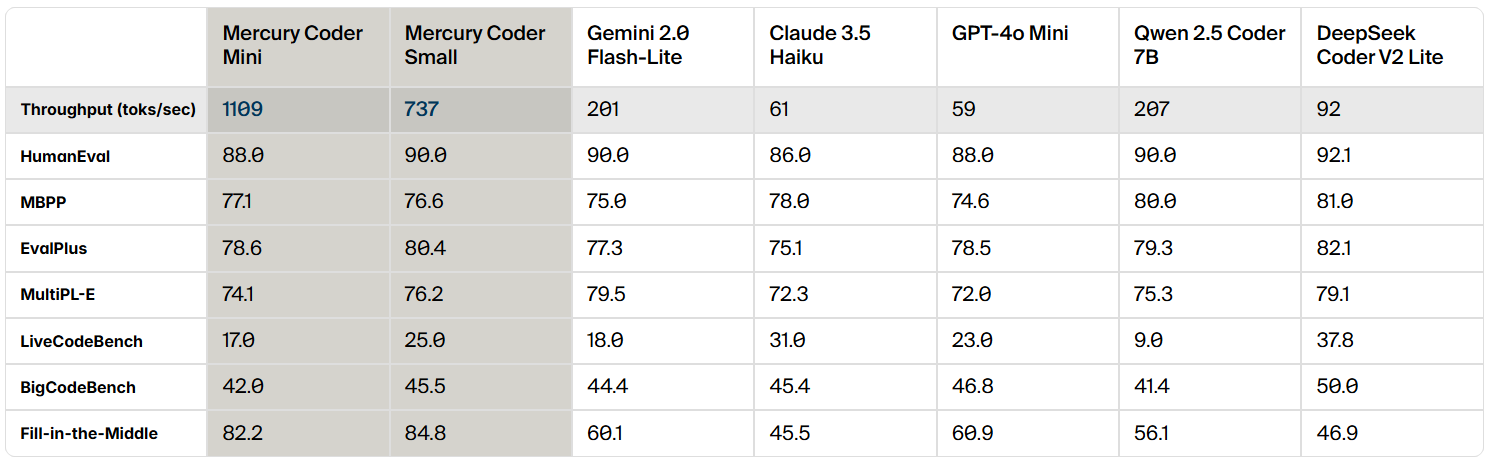

Mercury Coderはコード生成用に最適化されたdLLMであり、標準的なコードベンチマークのレビューでは、Mercury Coderは幅広いベンチマークで優れており、GPT-4o MiniやMercury Coderを上回ることが多い。 クロード 3.5 Haikuのような速度に最適化された自己回帰モデルも最大10倍速い。

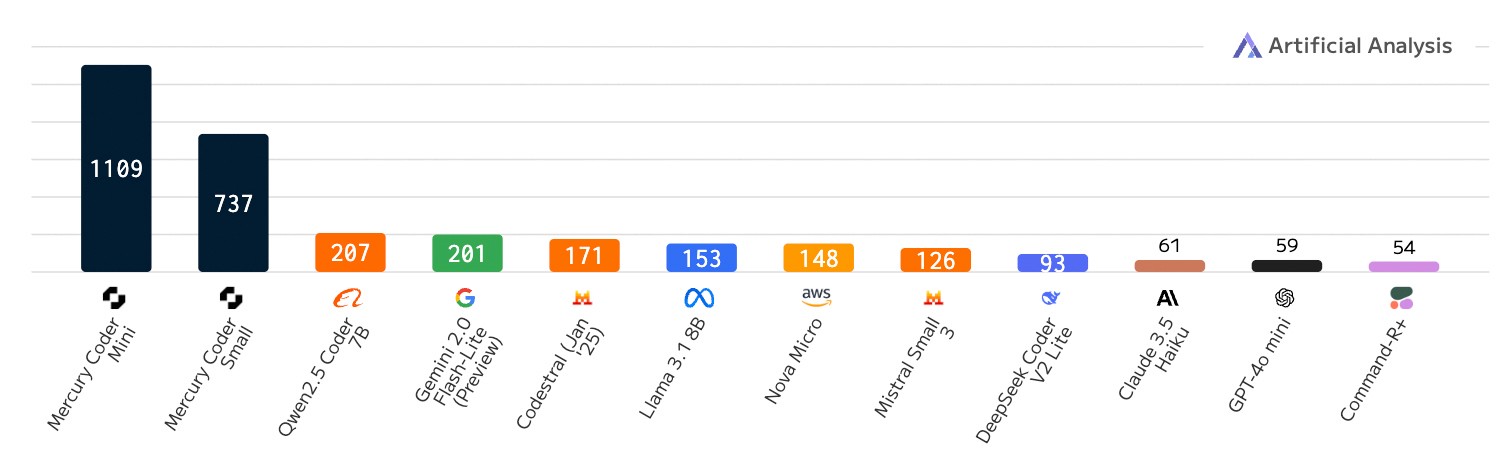

dLLMの特徴は、その驚異的なスピードにある。速度最適化された自己回帰モデルでさえ最大200トークン/秒で実行されるのに対し、Mercury Coderは汎用のNVIDIA H100 GPU上で1000トークン/秒以上で実行され、これは5倍のスピードアップです。Mercury Coderは、50トークン/秒以下で動作するフロンティアモデルよりも20倍以上高速です。

以前は、Groq、Cerebras、SambaNovaのような専用ハードウェアだけが、dLLMのようなスループットを達成することができました。 Mercury Coderのアルゴリズムの改良とハードウェアアクセラレーションは相性がよく、より高速なチップでは、さらに高速化が進む。

速度比較:1秒あたりのトークン出力数、コード記述作業負荷

さらにエキサイティングなのは、開発者がMercury Coderのコード補完機能を好んでいることだ。その中で コパイロット Arenaのベンチマークでは、Mercury Coder Miniが2位タイとなり、GPT-4o MiniやGemini-1.5-Flashなどの速度最適化モデルを上回り、GPT-4oなどの大型モデルの性能にさえ匹敵しました。同時に、Mercury Coderは最速モデルでもあり、GPT-4o Miniより約4倍速い。

Inception Labsは、Mercury Coderのパワーをぜひご自身で体験してください。 運動場 このプラットフォームでは、Mercury Coderのトライアルアクセスを提供しています。Mercury Coderが高品質なコードを短時間で生成する様子を以下のビデオでご覧ください。

これはAIアプリケーションにとって何を意味するのか?

カスタマーサポート、コード生成、エンタープライズオートメーションのマーケットリーダーを含むMercury dLLMの早期導入企業は、標準的な自己回帰ベースモデルからMercury dLLMへの直接的な置き換えに成功しています。この切り替えは、ユーザーエクスペリエンスの向上とコスト削減に直結します。レイテンシを重視するアプリケーションシナリオでは、パートナーはこれまで、厳しいレイテンシ要件を満たすために、より小型で性能の低いモデルを選択しなければならないことがよくありました。現在では、dLLMの優れた性能のおかげで、これらのパートナーは、当初のコストと速度の要件を満たしたまま、より大きく、より強力なモデルを使用することができます。

Mercuryモデルは、既存のハードウェア、データセット、教師ありファインチューニング(SFT)およびアライメント(RLHF)プロセスと完全に互換性があります。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません