Grok 3のベンチマークデータは「水増し」? OpenAIの社員が「xAIはパフォーマンスを誤魔化している可能性がある」と発言

AIのベンチマークや、AIラボが結果を公表する方法をめぐる議論が、ますます公になりつつある。AIの性能は長い間、論争の的になるような方法で測定され、報告されてきたが、今、こうした舞台裏での議論がついにスポットライトを浴びつつある。

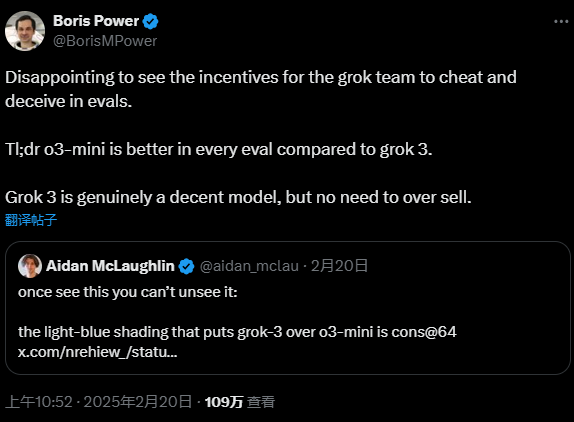

今週、OpenAIの従業員が、イーロン・マスクが設立したAI企業であるxAIが、最新のAIモデルを宣伝するために誤解を招くようなベンチマーク結果を公表していると公に非難した。 グロック 3.xAIの共同設立者の一人であるイーゴリ・バブーシキン氏は、この非難に対して即座に反論し、xAIのアプローチに問題はないと主張した。 この公開討論は、AIの性能評価における透明性の問題を前面に押し出したことは確かだ。

しかし、真実はおそらく両者の間のどこかにある。 技術分野における多くの紛争と同様、真実はしばしば水面下にあり、より深く掘り下げ、精査する必要がある。

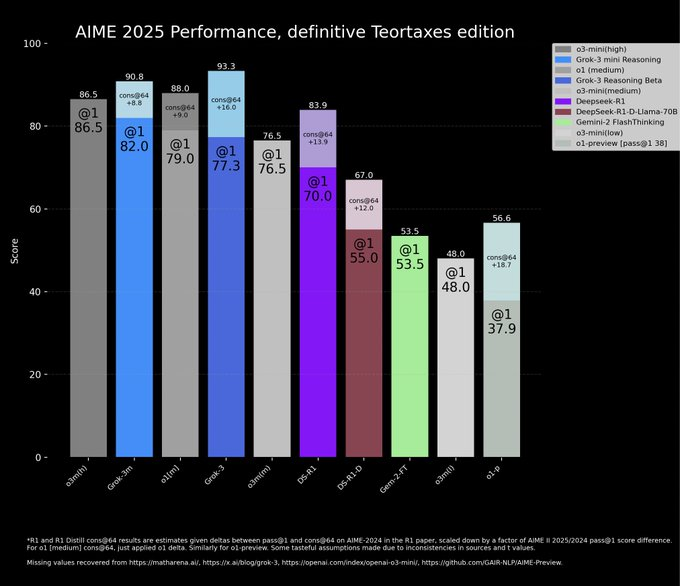

xAIの公式ブログへの投稿で、xAIはAIME 2025ベンチマークにおけるGrok 3の優れたパフォーマンスを示すグラフを紹介している。 AIME 2025は、最近行われた高得点の招待数学試験の問題集で、AIの数学的能力のリトマス試験紙と考えられている。 しかし、専門家がAIMEのAIベンチマークとしての妥当性に長い間疑問を呈してきたことは注目に値する。 xAIがどのような意図でこのような論争の的となるベンチマークを選び、モデル能力を実証したのかは興味深いところだ。 とはいえ、AIME2025とその以前のバージョンは、AIモデルの数学的推論を評価するために今でも広く使われている。

xAIはそのチャートで、Grok 3の両バージョン、Grok 3 Reasoning BetaとGrok 3 mini Reasoningが、AIME 2025テストにおいてOpenAIの現在の最先端モデルであるo3-mini-highを上回ったと主張した。 しかし、OpenAIのスタッフは、xAIのチャートに重大な欠陥があることをXプラットフォームですぐに指摘した。それは、o3-mini-highの "cons@64 "条件下でのAIME 2025テストのスコアが省略されている点である。 この選択的なデータの提示は、xAIの意図に疑問を投げかけるものである。

コンセンサス@64って何? 簡単に言えば、「consensus@64」の略で、特殊な評価方法です。 この方法では、ベンチマークテストの各質問に対してモデルが64回回答を試み、最も頻度の高い回答が最終的な回答となる。 当然のことながら、「cons@64」メカニズムはモデルのベンチマークスコアを大幅に向上させる傾向があります。 xAIはグラフから「cons@64」データを意図的に省略しているため、Grok 3が他のモデルを上回っているような印象を与えるかもしれないが、そうではないかもしれない。 この "トリッキー "なアプローチはフェアなゲームではないのだろうか?

実際のデータを見てみると、Grok 3 Reasoning BetaとGrok 3 mini Reasoningの両方が、AIME 2025の「@1」条件、つまりベンチマークを初めて試みたモデルのスコアで、o3-mini-highよりも実際に低いスコアを出しています。 Grok 3 Reasoning Betaのスコアでさえ、OpenAIのo1モデル(「中程度」の計算に設定)をわずかに上回っているに過ぎない。 しかし、このようなデータ比較をしてもなお、xAIはGrok 3を「世界で最も賢いAI」と宣伝している。 この宣伝戦略は厳密な科学的根拠に基づくものではなく、市場の注目を集めるためのマーケティング戦術に近い。 AI技術が急速に変化している今、地に足の着いた技術進歩がより重要なのか、それとも大げさなマーケティング宣伝が未来を勝ち取るためのより良い方法なのか。 これはAI業界全体が真剣に考えるべき問題かもしれない。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません