glhf.chat:ほとんど(すべて)のオープンソースのビッグモデルを実行し、GPUリソースとAPIサービスに無料でアクセスできる(ベータ期間)。

はじめに

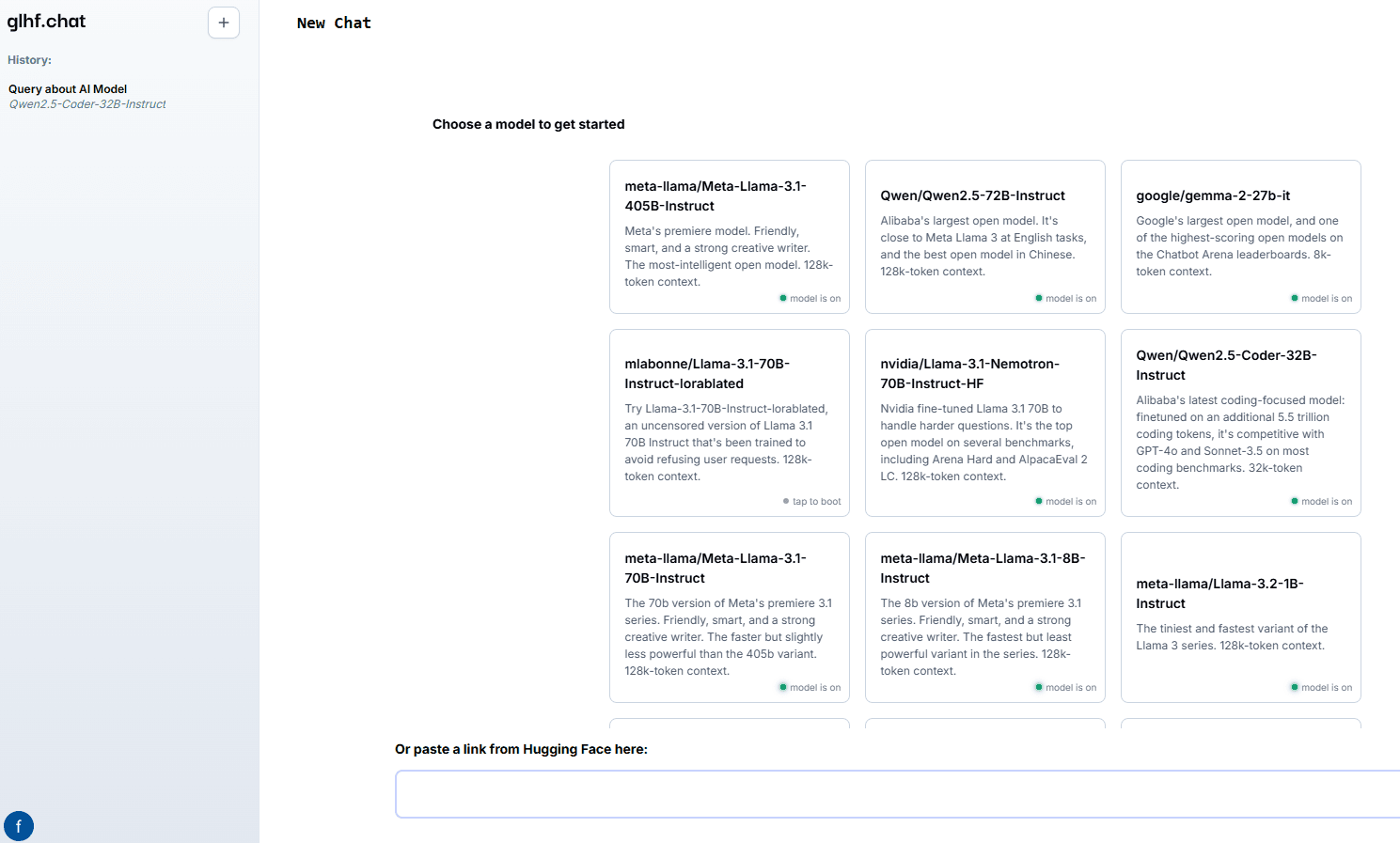

good luck have fun (glhf.chat)は、オープンソースのビッグモデルチャットサービスを提供するウェブサイトです。このプラットフォームでは、ユーザーはvLLMとカスタム自動スケーリングGPUスケジューラを使用して、ほぼすべてのオープンソースビッグモデルを実行することができます。ユーザーはHugging Faceリポジトリへのリンクを貼り付けるだけで、チャットインターフェースやOpenAI互換のAPIを使って対話することができる。このプラットフォームはベータ期間中は無料で提供され、将来的には主要なクラウドGPUプロバイダーよりも低価格で利用できるようになる予定だ。

機能一覧

- Meta Llama、Qwen、Mixtralなど、さまざまなオープンソースのマクロモデルをサポート。

- 最大8基のNvidia A100 80Gb GPUにアクセス可能

- 自動エージェント人気モデルのための推論サービス

- リソースの使用を最適化するためのクラスタのオンデマンド起動とシャットダウン

- OpenAIと互換性のあるAPIを提供し、統合を容易にします。

ヘルプの使用

インストールと使用

- 登録とログインアクセスglhf.チャットをクリックしてアカウントを登録し、完了したらログインしてください。

- モデルを選択対応機種はMeta Llama、Qwen、Mixtralなど。

- リンクを貼り付けるHugging Faceリポジトリのリンクを指定された場所に貼り付けると、プラットフォームが自動的にモデルをロードします。

- チャットインターフェースの使用ウェブサイトに用意されたチャット・インターフェースを介してモデルと対話し、質問やコマンドを入力すると、モデルがリアルタイムで応答を生成します。

- API統合OpenAIと互換性のあるAPIを使用して、OpenAIプラットフォームの機能を独自のアプリケーションに統合することができます。

詳細な機能操作の流れ

- モデルの選択とロード::

- ログイン後、モデル選択ページに移動します。

- サポートされているモデルのリストを参照し、目的のモデルをクリックします。

- Hugging Faceリポジトリへのリンクをポップアップダイアログボックスに貼り付け、"Load Model "ボタンをクリックします。

- モデルの読み込みが終了するまで待ちます。読み込みにかかる時間は、モデルのサイズやネットワークの状態によって異なります。

- チャットインターフェースの使用::

- モデルが読み込まれたら、チャット画面に入る。

- 入力ボックスに質問または指示を入力し、「送信」をクリックします。

- このモデルは入力に基づいて返答を生成し、返答はチャットウィンドウに表示される。

- 複数の質問やコマンドを連続して入力することができ、モデルはそれらを1つずつ処理し応答する。

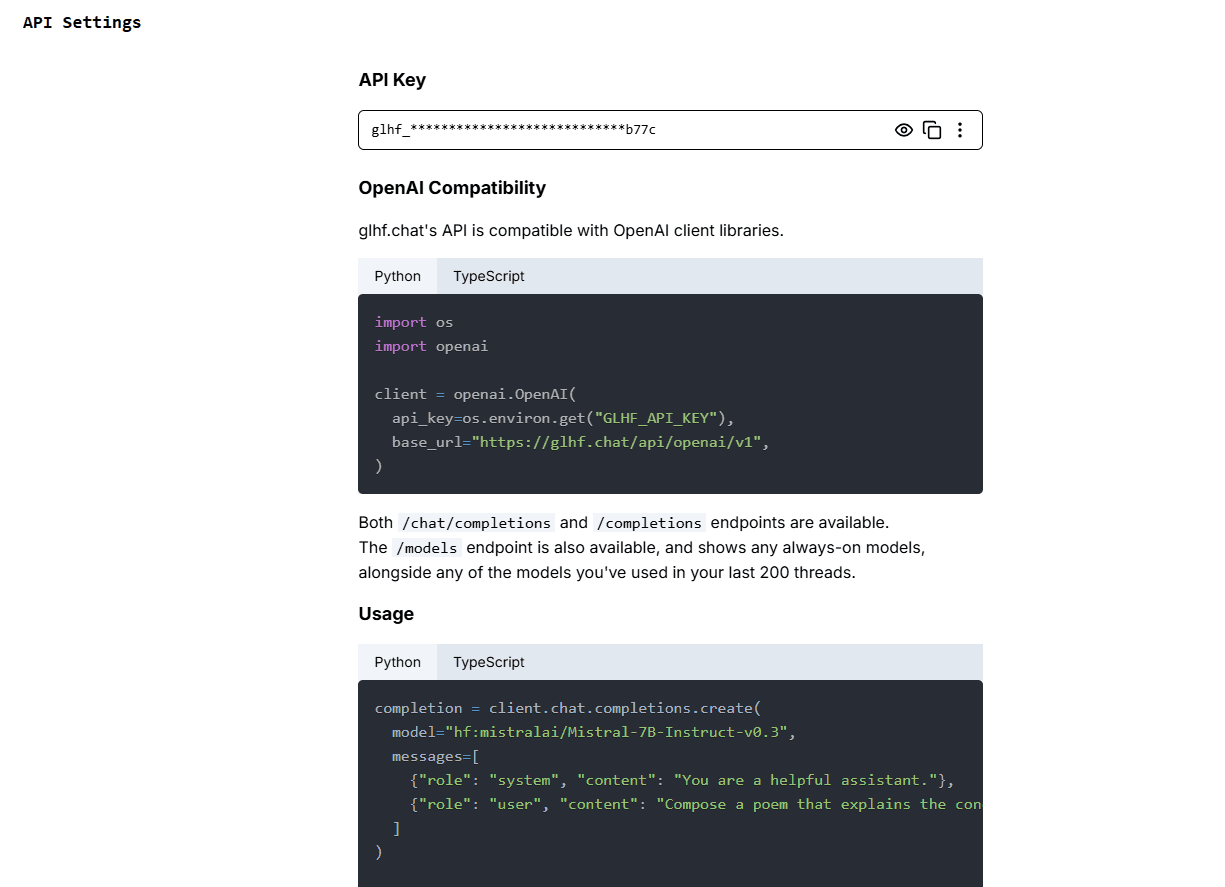

- APIの使用::

- APIキーと手順については、APIドキュメンテーションページをご覧ください。

- アプリケーションにAPIを統合し、ドキュメントに記載されているサンプルコードに従って呼び出しを行う。

- APIを通じてリクエストを送信し、モデルが生成したレスポンスを取得する。

- APIは様々なプログラミング言語をサポートしており、具体的なサンプルコードについてはドキュメントを参照のこと。

リソース管理と最適化

- 自動拡大このプラットフォームでは、ユーザーの需要に応じてGPUリソースを自動的に増減するカスタムGPUスケジューラを使用して、効率的な利用を実現しています。

- オンデマンド・アクティベーションあまり使用されないモデルについては、プラットフォームがオンデマンドでクラスタを起動し、使用されると自動的にシャットダウンするので、リソースを節約できる。

- 無料テストベータテスト期間中、ユーザーはプラットフォームが提供するすべての機能に無料でアクセスでき、テスト終了後には割引料金プランが利用できるようになる。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません