DeepSeek-VL2:高度なマルチモーダル理解のためのエキスパート視覚言語モデル

はじめに

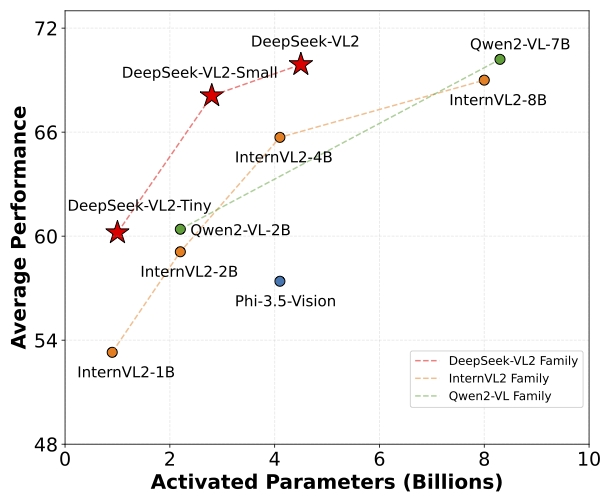

DeepSeek-VL2は、高度なMoE(Mixture-of-Experts)視覚言語モデルのシリーズで、前身のDeepSeek-VLの性能を大幅に向上させています。DeepSeek-VL2ファミリーは、DeepSeek-VL2-Tiny、DeepSeek-VL2-Small、DeepSeek-VL2の3つのバリエーションで構成され、それぞれ1.0B、2.8B、4.5Bの活性化パラメータを持ちます。活性化パラメータを持つ。これらのモデルは、既存のオープンソースの密なモデルやMoEモデルと同等かそれ以下のパラメータ数で、同等かそれ以上の性能を達成しています。

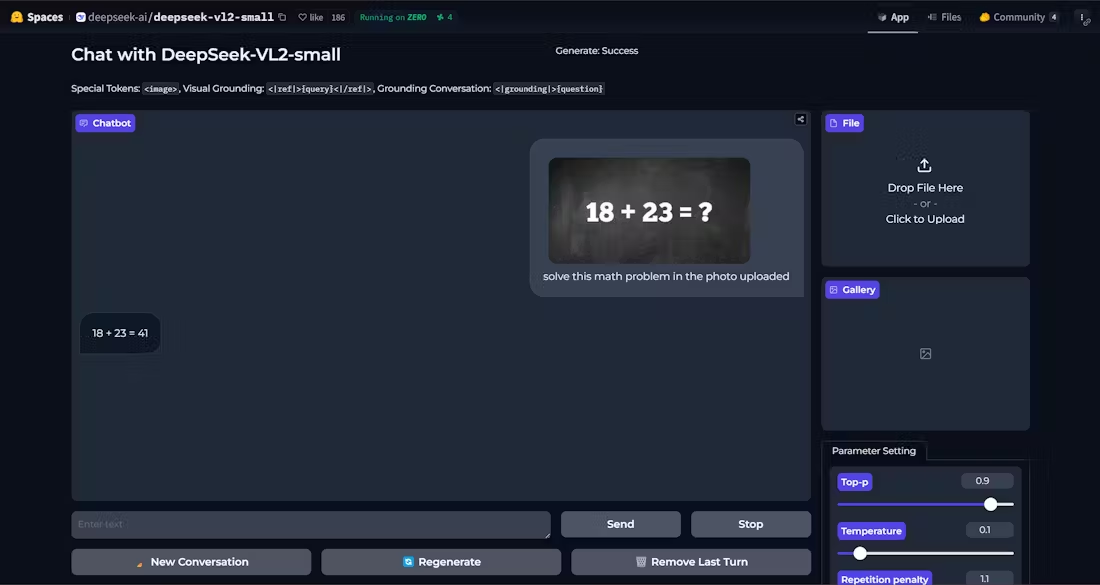

デモ:https://huggingface.co/spaces/deepseek-ai/deepseek-vl2-small

機能一覧

- ビジュアルQ&A正確な解答を提供することで、複雑なビジュアルクイズタスクをサポートします。

- 光学式文字認識(OCR)画像中のテキストコンテンツの効率的な認識。

- ドキュメント理解複雑な文書構造と内容の解析と理解。

- フォーム理解有用な情報を抽出するために、表形式のデータを識別し、処理する。

- グラフィカルな理解グラフやチャートのデータと傾向を分析し、解釈する。

- 視覚オリエンテーション画像内の対象物の位置を正確に特定します。

- マルチバリアント対応タイニー、スモール、スタンダードの3モデルを用意し、さまざまなニーズに応える。

- 高性能高性能を維持しながら、活性化パラメーターの数を削減。

ヘルプの使用

設置プロセス

- Pythonのバージョンが3.8以上であることを確認してください。

- DeepSeek-VL2 リポジトリのクローニング:

git clone https://github.com/deepseek-ai/DeepSeek-VL2.git

- プロジェクト・ディレクトリに移動し、必要な依存関係をインストールする:

cd DeepSeek-VL2

pip install -e .

使用例

単純な推論の例

以下は、DeepSeek-VL2 を使用した簡単な推論のサンプル・コードです:

import torch

from transformers import AutoModelForCausalLM

from deepseek_vl2.models import DeepseekVLV2Processor, DeepseekVLV2ForCausalLM

from deepseek_vl2.utils.io import load_pil_images

# 指定模型路径

model_path = "deepseek-ai/deepseek-vl2-tiny"

vl_chat_processor = DeepseekVLV2Processor.from_pretrained(model_path)

vl_model = DeepseekVLV2ForCausalLM.from_pretrained(model_path)

# 加载图像

images = load_pil_images(["path_to_image.jpg"])

# 推理

inputs = vl_chat_processor(images=images, return_tensors="pt")

outputs = vl_model.generate(**inputs)

print(outputs)

詳細な機能操作の流れ

- ビジュアルQ&A::

- ロードモデルとプロセッサー。

- 画像と質問を入力すると、モデルが答えを返す。

- 光学式文字認識(OCR)::

- 利用する

DeepseekVLV2Processor画像を読み込む。 - このモデルは、画像内のテキストを抽出するための推論に呼び出される。

- 利用する

- ドキュメント理解::

- 文書画像を含む入力を読み込みます。

- モデルは文書構造を解析し、解析結果を返す。

- フォーム理解::

- フォームを含む画像を入力します。

- このモデルは、フォームの構造と内容を認識し、重要な情報を抽出する。

- グラフィカルな理解::

- チャート画像を読み込む。

- このモデルはグラフデータを分析し、解釈と傾向分析を提供する。

- 視覚オリエンテーション::

- 対象物の説明と画像を入力します。

- このモデルは、画像内のターゲットオブジェクトの位置を特定し、その位置座標を返す。

以上の手順により、ユーザーはDeepSeek-VL2の能力をフルに活用して、さまざまな複雑な視覚言語タスクをこなすことができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません