ハードディスク・キャッシング技術のDeepSeek API大規模アプリケーション:大規模モデルの民生化における重要な一歩

-- ビッグモデルAPIの価格競争、ユーザーエクスペリエンスの最適化、テクノロジー・インクルージョンの深い論理についての議論。

画像出典:DeepSeek公式ドキュメント

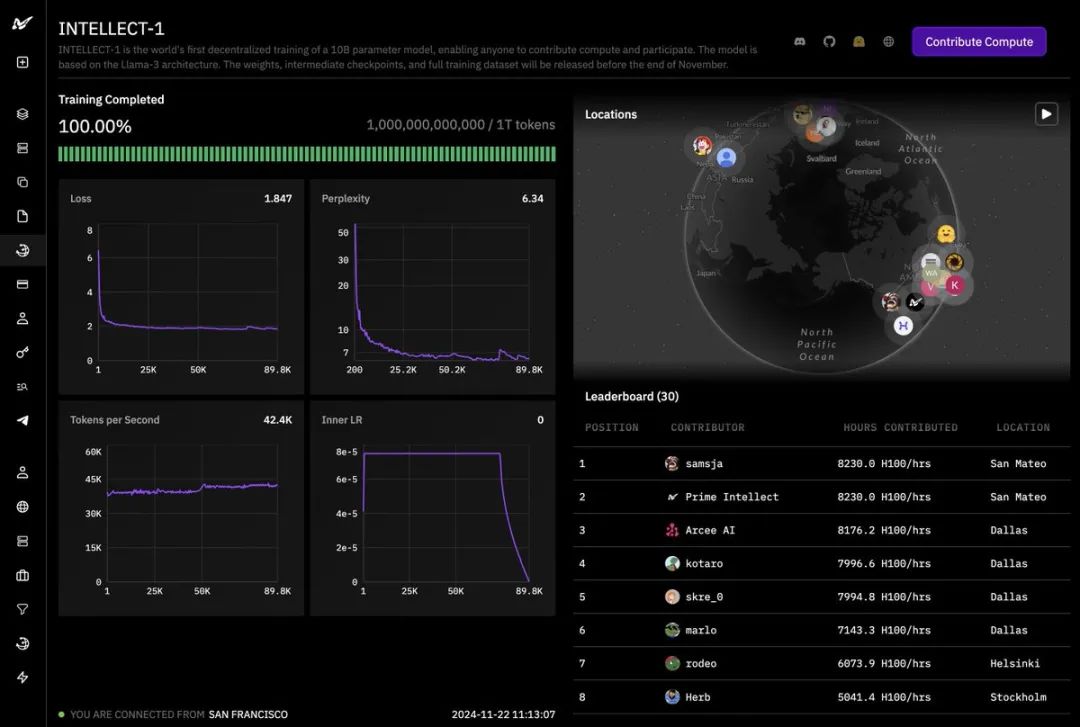

ビッグAIモデルの競争が過熱する中、DeepSeekは最近、同社のAPIサービスを革新的に使用することを発表した。ハードディスク・キャッシュ・テクノロジーDeepSeekの価格調整は衝撃的なもので、キャッシュヒット部分の価格を従来の10分の1に直接引き下げ、業界価格の底上げを再び鮮明にした。長年ビッグモデル技術と業界動向に関心を寄せてきた第三者レビュアーとして、私はディープシークの今回の動きは、技術革新によるコスト革命であると同時に、ビッグモデルAPIのユーザーエクスペリエンスの深い最適化であり、ビッグモデル技術の一般化を加速させる重要な一歩であると考えている。

技術革新:ハードディスク・キャッシュの微妙な違いと性能の飛躍

DeepSeekは、大規模モデルAPIの高コストと待ち時間の問題が、長い間、その普及の制約となってきたこと、そして、ユーザリクエストに多く見られるコンテキストの繰り返しが、これらの問題の主な原因となっていることを深く認識しています。例えば、複数ラウンドのダイアログでは、各ラウンドで以前のダイアログ履歴を再入力する必要があり、長いテキスト処理タスクでは、プロンプトはしばしば繰り返しの参照を含んでいます。繰り返し計算 トークン 演算を無駄にし、レイテンシを増大させる。

このペインポイントに対処するため、DeepSeekは創造的にコンテクスチュアル・ハードドライブ・キャッシング技術を導入しています。核となる原理は、対話履歴、システムプリセット、フューショット例など、将来的に再利用されることが予測されるコンテキストコンテンツを、分散型ハードドライブ配列にインテリジェントにキャッシュすることです。ユーザーが新しいAPIリクエストを開始すると、システムは入力のプレフィックス部分がキャッシュされたコンテンツと一致するかどうかを自動的に検出します(注意:キャッシュにヒットするにはプレフィックスが一致する必要があります)。一致する場合、システムは再計算することなく、高速ハードドライブキャッシュから直接複製を読み出し、レイテンシーとコストの両方を最適化する。

キャッシングがどのように機能するのかをより明確に理解するために、以下の2つを見てみよう。 ディープシーク オフィシャルな例がある:

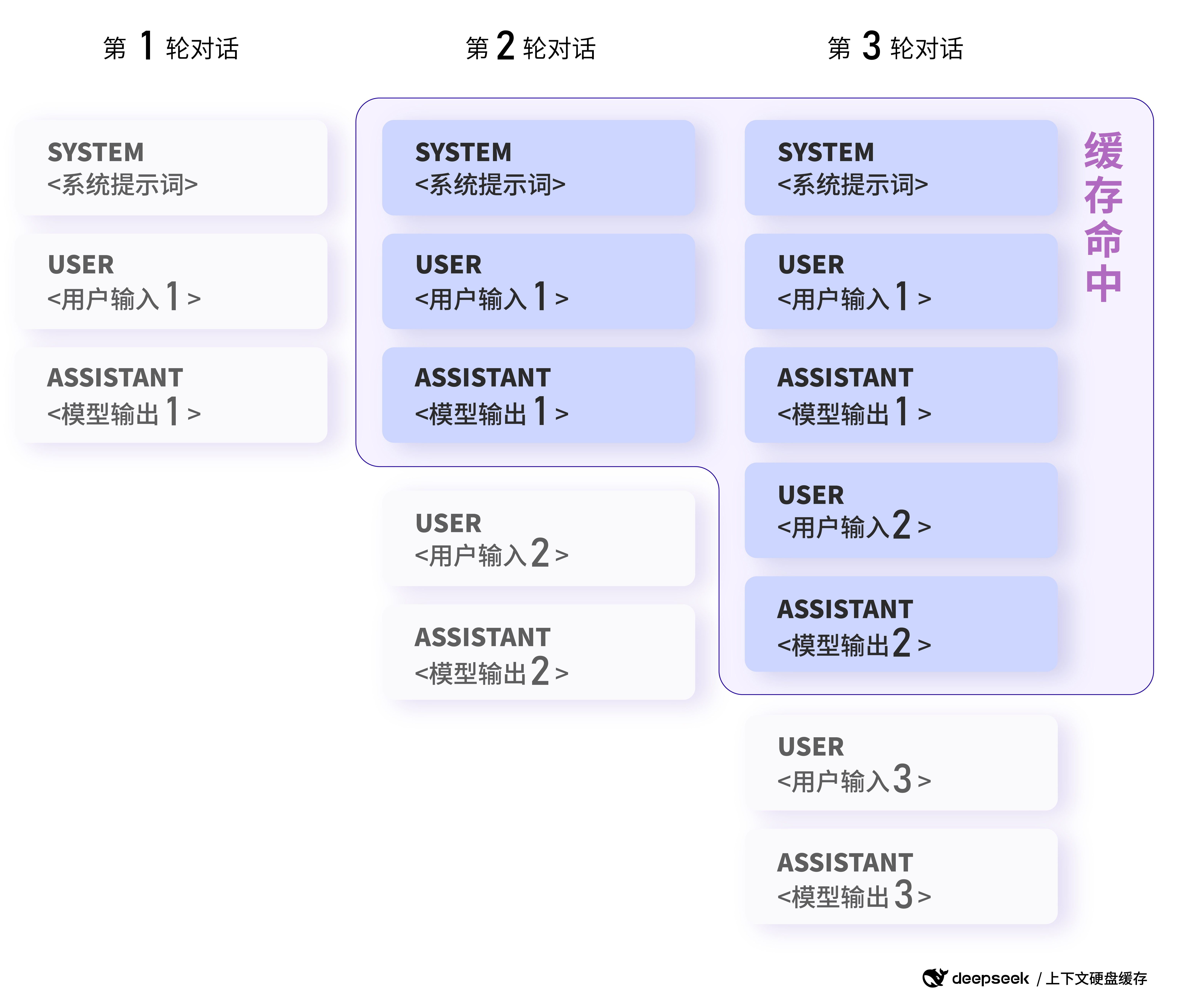

例1:多ラウンド対話シナリオ

コア機能:後続の対話ラウンドでは、前のラウンドのコンテキストキャッシュが自動的にヒットする。

通常、ユーザが1つのトピックについて連続して質問を行うマルチラウンド・ダイアログでは、DeepSeekのハードドライブ・キャッシングにより、ダイアログ・コンテキストを効率的に再利用できます。たとえば、次のような対話シナリオがあります:

最初のリクエスト

messages: [

{"role": "system", "content": "你是一位乐于助人的助手"},

{"role": "user", "content": "中国的首都是哪里?"}

]

つ目のリクエスト:

messages: [

{"role": "system", "content": "你是一位乐于助人的助手"},

{"role": "user", "content": "中国的首都是哪里?"},

{"role": "assistant", "content": "中国的首都是北京。"},

{"role": "user", "content": "美国的首都是哪里?"}

]

画像出典:DeepSeek公式ドキュメント

複数ラウンドの対話シナリオにおけるキャッシュヒットの例:後続の対話ラウンドでは、前のラウンドのコンテキストキャッシュが自動的にヒットする。

2回目のリクエストでは、接頭辞部分(システムメッセージ+最初のユーザーメッ セージ)は最初のリクエストとまったく同じなので、この部分は計算を繰り返すことな くキャッシュにヒットする。

DeepSeekの公式データによると、128Kの入力とほとんどの繰り返しを伴う極端なシナリオでは、最初のトークンのレイテンシの測定値は13秒から500ミリ秒に激減しており、これは驚くべき性能向上である。極端でないシナリオでも、待ち時間を効果的に短縮し、ユーザー体験を向上させることができる。

さらに、DeepSeekのハードドライブ・キャッシング・サービスは、完全に自動化されており、ユーザに依存しません。コードやAPIインタフェースを変更することなく、キャッシングのパフォーマンスと価格のメリットを享受できます。APIから返される使用状況フィールドの新しいprompt_cache_hit_tokens (キャッシュヒット数) によって、ユーザは自分が受け取ったキャッシュヒット数を確認できます。 トークン (トークン数) と prompt_cache_miss_tokens (見逃したトークン数) フィールドを使用して、キャッシュ・ヒットをリアルタイムで監視し、キャッシング・パフォーマンスの評価と最適化を行います。

DeepSeekがハードディスク・キャッシング技術の大規模適用をリードできるのは、その先進的なモデル・アーキテクチャと不可分である。 DeepSeek V2が提案するMLA構造(Multi-head Latent Attention)は、モデルの性能を保証しつつ、コンテキストのKV Cacheのサイズを大幅に圧縮し、KV Cacheを低コストのハードディスクに格納することを可能にし、ハードディスク・キャッシング技術が市場に根付く礎を築く。これにより、KV Cacheを低コストのハードディスクに保存することが可能になり、ハードディスク・キャッシング技術が市場に根付くための基礎が築かれた。

理解 ディープシーク-R1 APIキャッシュのヒット数と価格:DeepSeek-R1 API の使用法 よくある質問

活用シーン:長文のQ&Aからコード解析まで、境界は無限に広がる!

ハードディスク・キャッシング・テクノロジーを使用できるシナリオは多岐にわたり、コンテクスト入力を伴う大規模なモデル・アプリケーションのほとんどすべてが、その恩恵を受けることができる。元記事では、以下の典型的なシナリオを挙げ、より具体的な例を示している:

- あらかじめ設定された長いプロンプトワードを使ったクイズアシスタント:

- コア機能:固定システムプロンプトのキャッシュが可能になり、リクエストあたりのコストを削減。

- 例

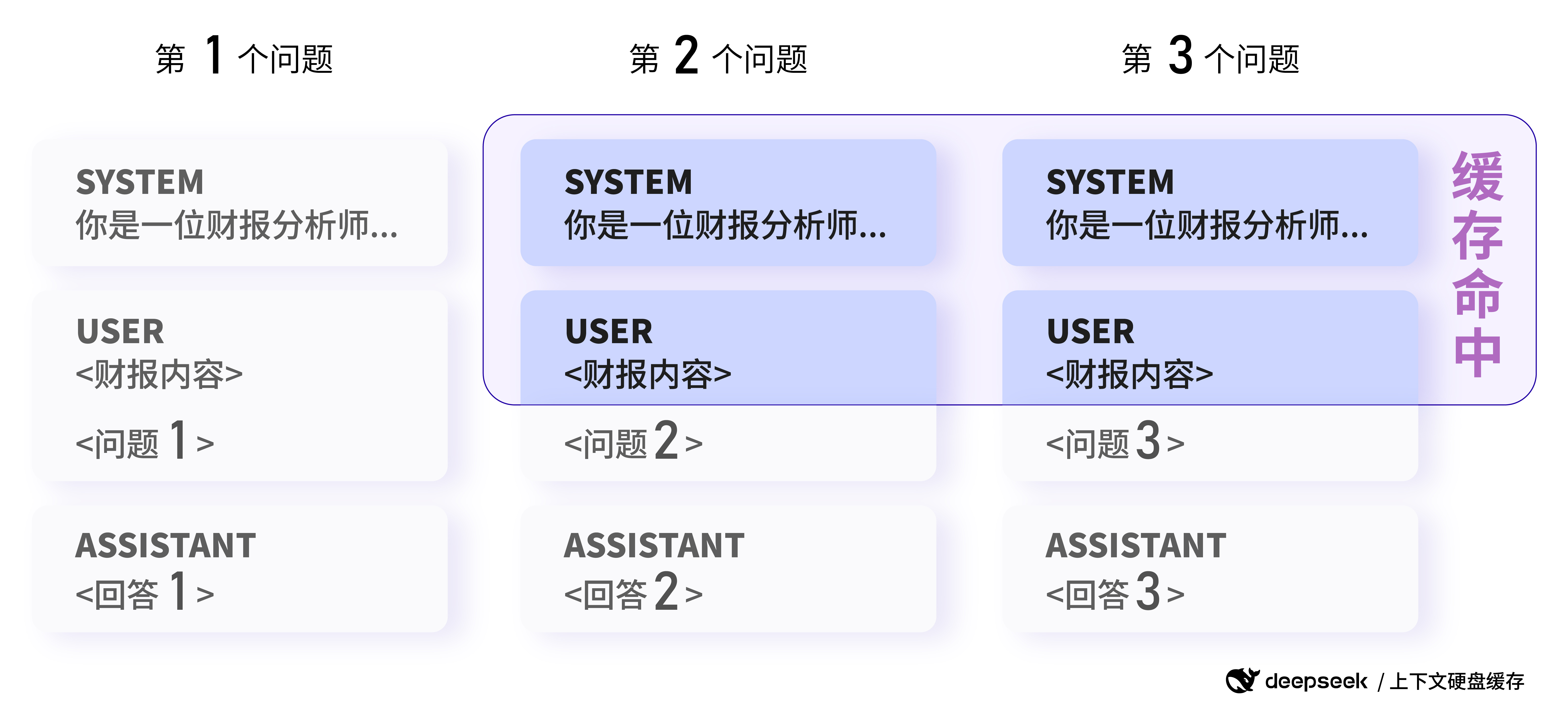

例2:長文のQ&Aシナリオ

コア機能:同じ文書の複数の分析がキャッシュをヒットすることができます。

ユーザーは同じ決算報告書を分析し、異なる質問をする必要がある:

最初のリクエスト

messages: [

{"role": "system", "content": "你是一位资深的财报分析师..."},

{"role": "user", "content": "<财报内容>\n\n请总结一下这份财报的关键信息。"}

]

つ目のリクエスト:

messages: [

{"role": "system", "content": "你是一位资深的财报分析师..."},

{"role": "user", "content": "<财报内容>\n\n请分析一下这份财报的盈利情况。"}

]

2回目のリクエストでは、システムメッセージとユーザーメッセージの部分は1回目のリクエストと同じ接頭辞を持っているので、この部分は計算資源を節約するためにキャッシュにヒットさせることができる。

- 何ラウンドも対話するロールプレイング・アプリ:

- 核となる機能:対話履歴の高度な再利用と大幅なキャッシュ。

- (例1が詳細に示されている)

- 固定テキストコレクションのデータ分析:

- 主な特徴:同じ文書に関する複数の分析およびクイズで、接頭辞の繰り返しが多い。

- 例えば、同じ財務報告書や法律文書について、複数の分析や質疑応答が行われる。(例2が詳細に示されている)

- コード・リポジトリ・レベルでのコード解析およびトラブルシューティング・ツール:

- コア機能:コード解析タスクは多くの場合、大量のコンテキストを含むため、キャッシュはコスト削減に効果的です。

- 数少ないシュート学習:

- コア機能:プロンプトを前置詞に持つフューショット例はキャッシュされ、複数のフューショット呼び出しのコストを削減することができます。

- 例

例3:数ショット学習シナリオ

コア機能:同じFew-shotの例をプレフィックスとしてキャッシュヒットさせることができる。

ユーザーは、歴史知識クイズでモデルの有効性を向上させるためにFew-shot学習を使用する:

最初のリクエスト

messages: [

{"role": "system", "content": "你是一位历史学专家,用户将提供一系列问题,你的回答应当简明扼要,并以`Answer:`开头"},

{"role": "user", "content": "请问秦始皇统一六国是在哪一年?"},

{"role": "assistant", "content": "Answer:公元前221年"},

{"role": "user", "content": "请问汉朝的建立者是谁?"},

{"role": "assistant", "content": "Answer:刘邦"},

{"role": "user", "content": "请问唐朝最后一任皇帝是谁"},

{"role": "assistant", "content": "Answer:李柷"},

{"role": "user", "content": "请问明朝的开国皇帝是谁?"},

{"role": "assistant", "content": "Answer:朱元璋"},

{"role": "user", "content": "请问清朝的开国皇帝是谁?"}

]

つ目のリクエスト:

messages: [

{"role": "system", "content": "你是一位历史学专家,用户将提供一系列问题,你的回答应当简明扼要,并以`Answer:`开头"},

{"role": "user", "content": "请问秦始皇统一六国是在哪一年?"},

{"role": "assistant", "content": "Answer:公元前221年"},

{"role": "user", "content": "请问汉朝的建立者是谁?"},

{"role": "assistant", "content": "Answer:刘邦"},

{"role": "user", "content": "请问唐朝最后一任皇帝是谁"},

{"role": "assistant", "content": "Answer:李柷"},

{"role": "user", "content": "请问明朝的开国皇帝是谁?"},

{"role": "assistant", "content": "Answer:朱元璋"},

{"role": "user", "content": "请问商朝是什么时候灭亡的"},

]

2回目のリクエストでは、同じ4ショットの例がプレフィックスとして使用されるため、この部分はキャッシュによってヒットさせることができ、最後の質問だけが再計算される必要があるため、Few-shot学習のコストが大幅に削減される。

画像出典:DeepSeek公式ドキュメント

データ分析シナリオにおけるキャッシュヒットの例:同じ接頭辞を持つリクエストはキャッシュにヒットする可能性がある(注:ここでの画像は、接頭辞の重複の概念により焦点を当てたオリジナルのデータ分析例に従っており、Few-shot例のシナリオも同じように解釈できる)。

これらのシナリオは氷山の一角にすぎない。ハードドライブ・キャッシング技術の応用は、長いコンテキストのラージモデルAPIの応用のための想像力を本当に広げてくれる。例えば、より強力な長文オーサリングツールを構築したり、より複雑な知識集約的タスクを処理したり、より深く記憶に残る会話AIアプリケーションを開発したりすることができる。

参考:クロードに触発されて

クロード、APIロングテキストキャッシュ機能を革新し、処理効率の劇的な向上とコスト削減を実現

シンプルで効果的なRAG検索戦略:疎+密のハイブリッド検索と並べ替え、そしてテキストチャンクの全体的な文書関連コンテキストを生成するための「キューキャッシング」の使用。

コストメリット:価格が桁違いに下がり、大規模なモデル生態系に利益をもたらす

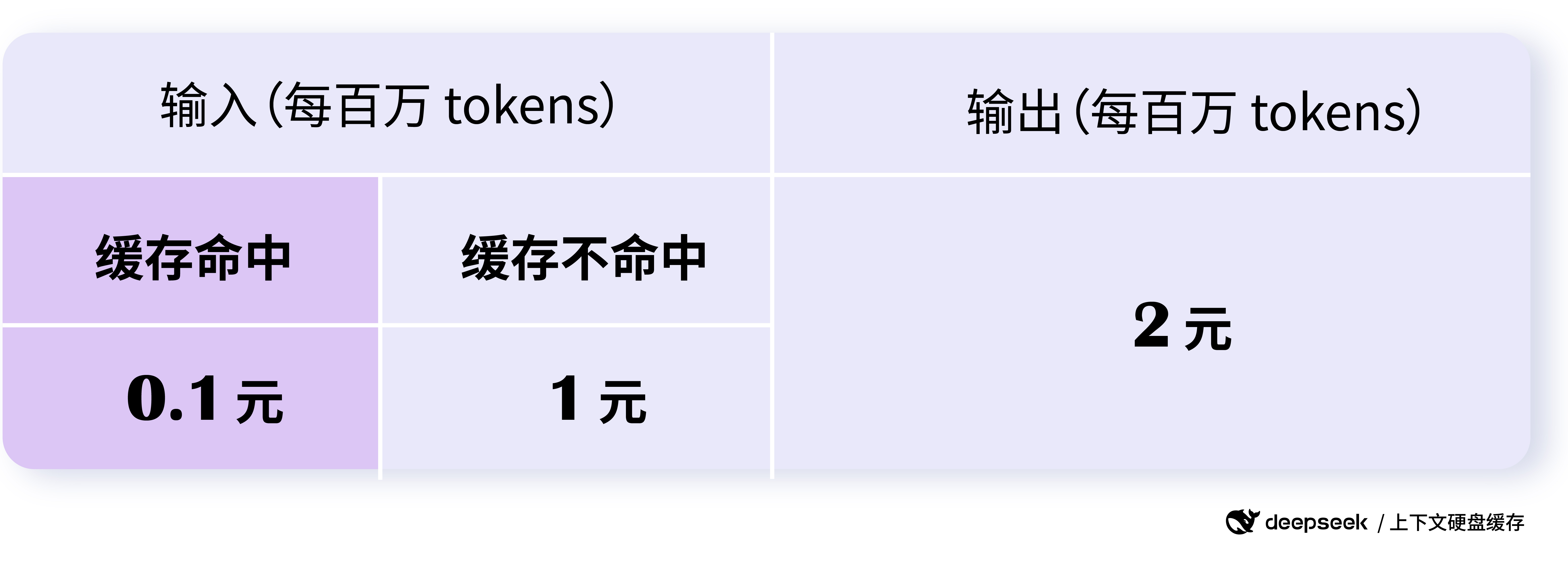

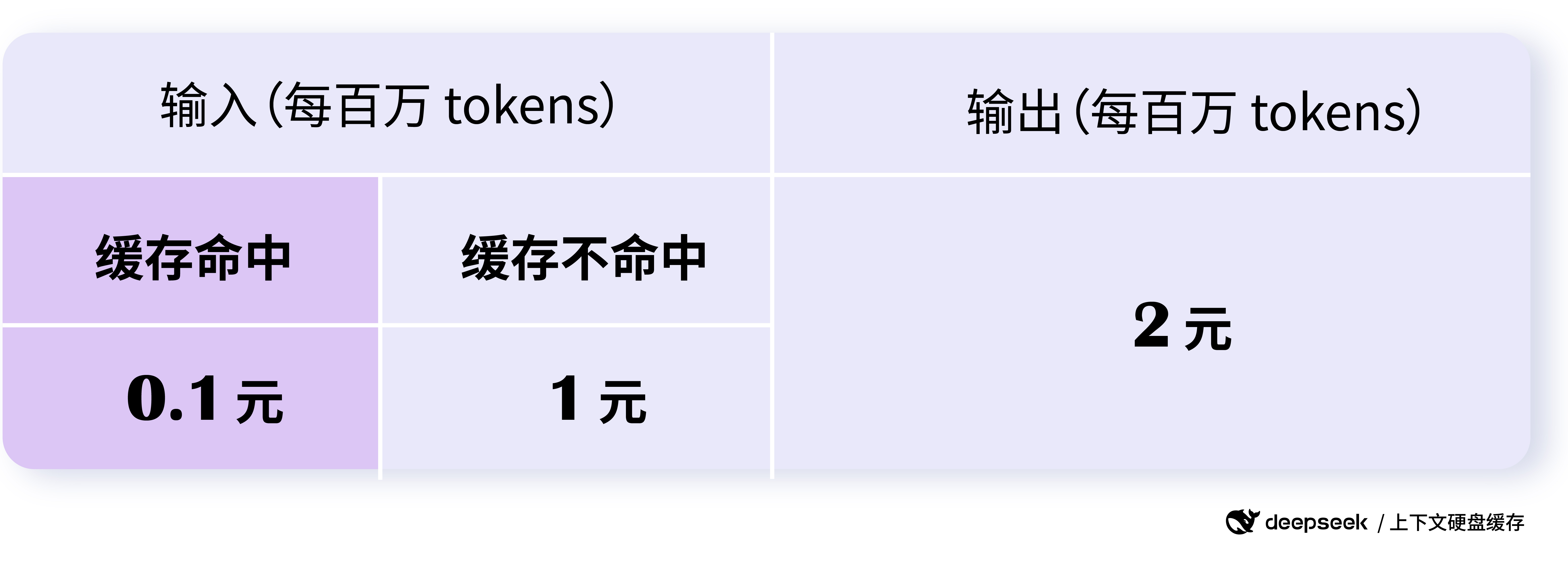

DeepSeek APIの価格調整は「壮大」であり、APIのキャッシュヒット部分の価格は0.10ドル/100万トークン、ヒット部分は1ドル/100万トークンである。キャッシュ・ヒットの価格は100万トークンあたりわずか0.1ドル、ミスの価格は100万トークンあたりわずか1ドルであり、これはキャッシュ・ヒットの従来の価格より一桁低い。

DeepSeekの公式データによると、最大で90%のコスト削減が可能であり、最適化なしでも全体で50%以上のコスト削減が可能です。このコスト優位性は、大型モデル適用の敷居を下げ、大型モデルの普及を加速させる上で大きな意味を持つ。

さらに興味深いのは、ディープシークの価格戦略だ。キャッシュのヒットとミスの価格設定は、ユーザーがキャッシュをできるだけ活用し、プロンプトの設計を最適化し、キャッシュのヒット率を高めることを奨励し、その結果、さらにコストを削減するように梯子状になっている。同時に、キャッシュ・サービス自体もキャッシュ・ストレージ・スペースも追加料金を請求しないので、実にユーザーフレンドリーである。

画像出典:DeepSeek公式ドキュメント

DeepSeek API価格は大幅に引き下げられ、キャッシュヒットのコストはわずか0.1ドル/100万トークンとなっている。

DeepSeek APIの大幅な値下げは、間違いなくビッグモデルの価格競争の進化を加速させるだろう。しかし、これまでの単純な価格競争とは異なり、DeepSeekの値下げは技術革新とコストの最適化に基づく合理的な値下げであり、より持続可能で業界主導型の値下げである。この健全な価格競争は、最終的にビッグモデルのエコシステム全体に利益をもたらし、より多くの開発者と企業がより低コストで高度なビッグモデル技術を享受できるようになる。

無制限のストリーミングと並行性、安全で信頼性の高いキャッシュサービス

パフォーマンスと価格の優位性に加え、DeepSeek APIの安定性とセキュリティも信頼に足るものです。 DeepSeek APIサービスは、1日あたり1兆トークンの容量に基づき設計されており、すべてのユーザーに対して無制限のストリーミングと同時実行が可能なため、高負荷条件下でもサービスの品質が保証されます。

DeepSeekは、データのセキュリティにも十分配慮しています。各ユーザのキャッシュはそれぞれ独立し、論理的に隔離されているため、ユーザデータのセキュリティとプライバシーが確保されています。長時間使用されていないキャッシュは自動的に空になり(通常は数時間から数日)、長期間保管されたり、他の目的に使用されたりすることはなく、潜在的なセキュリティリスクをさらに低減します。

キャッシュシステムは64トークンを記憶単位として使用し、64トークンより少ないものはキャッシュされないことに注意すべきである。また、キャッシュシステムは「ベストエフォート」であり、100%のキャッシュヒットを保証するものではない。さらに、キャッシュの構築には数秒かかりますが、長いコンテキストのシナリオでは、これはまったく許容範囲です。

モデルのアップグレードと今後の展望

ハードドライブ・キャッシング技術の発表に伴い、DeepSeekはdeepseek-chatモデルをDeepSeek-V3に、deepseek-reasonerモデルを新モデルDeepSeek-R1にアップグレードしたことも発表した。 新モデルは、性能と機能を向上させながら価格を大幅に引き下げ、DeepSeek APIの競争力をさらに強化した。DeepSeek APIの競争力をさらに強化します。

公式価格情報によると、DeepSeek-V3 API (deepseek-chat)は2025年2月8日24:00まで割引価格となっており、キャッシュヒットは0.1ドル/100万トークン、ミスインプットは1ドル/100万トークン、アウトプットは2ドル/100万トークンのみとなっている。 DeepSeek-R1 API (deepseek-reasoner)は、32Kの思考連鎖長と8Kの最大出力長を持つ推論モデルとして位置づけられており、インプット価格(キャッシュヒット)は1ドル/100万トークンとなっている。DeepSeek-R1 API (deepseek-reasoner)は、32Kの思考連鎖長と8Kの最大出力長を持つ推論モデルとして位置付けられ、入力価格はキャッシュヒットが$1/100万トークン、ミス入力が$4/100万トークン、出力(思考連鎖と最終的な答えの全てのトークン)が$16/100万トークンである。と最終的な答えのすべてのトークン)。

DeepSeekの一連の革新的な取り組みは、その継続的な技術投資とユーザー第一の哲学を示している。DeepSeekとさらなる革新的な力によって、ビッグモデル・テクノロジーは成熟を加速させ、より包括的なものとなり、あらゆる業界にさらに遠大な変化をもたらすと信じるに足る理由がある。

結語

ディープシークAPIの革新的なハードディスクキャッシング技術の利用と大幅な価格引き下げは画期的なブレークスルーである。DeepSeekの一歩は、ビッグモデルAPIの競争パターンを再定義し、AI技術の普及と応用を加速させ、最終的には、より豊かでオープンで包括的なビッグモデルエコシステムを構築するかもしれない。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません