DeepRetrieval:強化学習による効率的な情報検索クエリ生成

抄録

情報検索システムは、大規模な文書コレクションへの効率的なアクセスに不可欠である。最近のアプローチでは、大規模言語モデル(LLM)を活用し、クエリの強化を通じて検索性能を向上させているが、一般的に、多大な計算リソースと手動でラベル付けされたデータを必要とする高価な教師あり学習や蒸留技術に依存している。本稿では、教師ありデータを必要とせず、試行錯誤を通じてクエリ拡張のためのLLMを直接学習する、新しい強化学習ベースのアプローチであるDeepRetrievalを紹介する。検索リコールを報酬信号として使用することで、我々のシステムは文書検索のパフォーマンスを最大化するために効果的なクエリを生成するように学習する。我々の予備的な結果では、DeepRetrievalは、より小さなモデル(3B対7Bのパラメータ)を使用し、教師付きデータなしで、出版物検索タスクで60.821 TP3T、実験的検索タスクで70.841 TP3Tのリコールを達成した。これらの結果は、我々の強化学習アプローチがより効率的で効果的な情報検索のパラダイムを提供し、文書検索システムの状況を変える可能性があることを示唆している。

著者:Chengjiang Peng(UIUCコンピューターサイエンス学部)

オリジナル:https://arxiv.org/pdf/2503.00223

コードアドレス:https://github.com/pat-jj/DeepRetrieval

1.はじめに

情報検索(IR)システムは、ユーザが大規模な文書コレクションから関連文書を見つけるのを支援する重要な役割を担っている。従来のIRアプローチは、キーワードマッチングや統計的手法に依存しており、ユーザーのクエリの背後にある意味的な意味を理解するのに苦労することが多い。最近の大規模言語モデル(Large Language Models: LLMs)の進歩は、クエリ拡張(Query Augmentation: Bonifacio et al.

しかし、現在のLLMベースのクエリ拡張手法は、一般的に教師あり学習や蒸留技術を採用しており、これにはいくつかの重大な限界がある:

- 学習データを作成するには高価な計算リソースが必要で、数千ドルかかることも多い。

- 強化されたクエリの質は、監視データの質に依存する。

- 小規模なモデルのデータを生成するために大規模なモデルに依存しているため、潜在的なバイアスや限界が生じる。

本研究では、強化学習(RL)を用いてクエリ強化のためのLLMを学習する新しいアプローチであるDeepRetrievalを紹介する。教師ありデータに依存するアプローチとは異なり、DeepRetrievalは、検索リコールを報酬信号として使用し、直接的な試行錯誤を通じてモデルが学習することを可能にする。このアプローチにはいくつかの重要な利点がある:

- 高価な教師ありデータ作成は不要

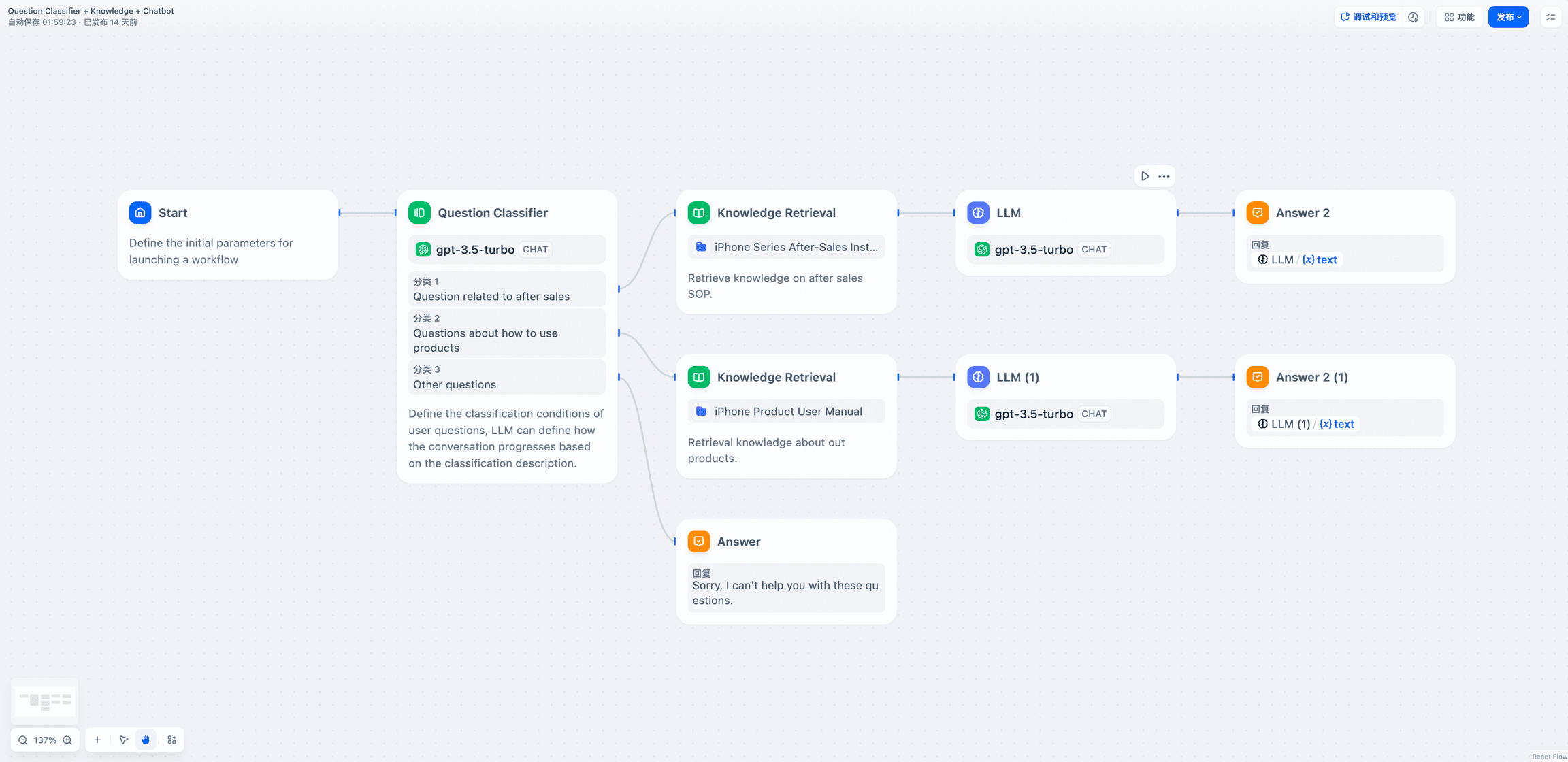

図1:DeepRetrieval:LLMは文書を検索するための拡張クエリを生成する。リコールは計算され、モデルを更新する報酬として使用される。

図1:DeepRetrieval:LLMは文書を検索するための拡張クエリを生成する。リコールは計算され、モデルを更新する報酬として使用される。

- 最終目標(リコールパフォーマンス)に直接最適化される

- 効果的な戦略を学ぶ能力

我々の予備的な結果は、DeepRetrievalが、最近のLEADSシステム(Wang et al.、2025)を含む既存の最先端手法を大幅に上回り、出版物検索タスクで60.821 TP3Tのリコール、裁判検索タスクで70.841 TP3Tのリコールを達成したことを示している。これらの結果は、LEADS (7Bパラメータ)と比較してより小さなモデル(3Bパラメータ)で、教師付きデータなしで得られたことは注目に値する。

2.方法論

我々のDeepRetrievalアプローチは、このパラダイムを情報検索の特定のタスクであるクエリ拡張に適用することで、LLMのための強化学習の最近の進歩を構築する。我々のアプローチは、DeepSeek-R1-Zero (DeepSeek-AI et al., 2025)に直接インスパイアされている。図1は、我々のシステムの全体的なアーキテクチャを示している。

2.1 問題の定式化

発見 D は文書の集まりである。q ユーザーのクエリに対して情報検索システムの目標は、ユーザーからのクエリと同じ情報を返すことである。 q 関連文書のサブセット Dq⊂ D .クエリ拡張では,元のクエリ q 拡張クエリに変換 q'クエリは、関連文書を検索する上でより効果的である。

伝統的に、この増大プロセスは教師あり学習によって学習される。q,q')のペアが学習データとして提供される。これとは対照的に、我々のアプローチは強化学習を使用しており、モデルは試行錯誤を通じて有効な拡張クエリを生成することを学習し、DeepSeek-R1-Zeroが推論問題を解決するために学習する方法と似ています。

2.2 強化された学習フレームワーク

我々は、クエリー強化タスクを強化学習問題として定式化する:

- 情勢元のユーザークエリ q

- ムーブメントモデルによって生成されるクエリの強化 q'

- インセンティブ使用 q' 文書検索時に達成されたリコール

モデルは期待される報酬を最大化するように、すなわち高いリコールを達成する拡張クエリを生成するように訓練される。このような最終目的の直接的な最適化は、人工的に生成された、あるいはより大きなモデルによって生成されたような拡張を最適化する教師ありアプローチとは異なる。

2.3 モデル・アーキテクチャと出力構造

このモデルはユーザのクエリを入力として受け取り、拡張クエリを生成する。このモデルは、最初に推論ステップをセクションで生成し、次に最終的な拡張クエリをJSON形式でセクションで生成する構造になっている。この構造化された生成により、モデルはクエリのすべての側面を考慮し、応答を最終決定する前にさまざまな拡張戦略を探索することができる。

予備実験では、PICOフレームワークに基づく専門的なプロンプトを使用した医学文献検索に焦点を当てた(詳細は付録Aを参照)。検索システムと互換性を持たせるため、JSON形式ではブール演算子(AND、OR)と適切な括弧を使ったグループ化が必要である。しかし、我々のアプローチは汎用的であり、プロンプトとクエリのフォーマットに適切な修正を加えることで、従来のIRデータセットにも適用できる。

2.4 インセンティブ・メカニズム

我々の報酬関数は、検索性能を直接的に最適化することを目的としている。そのプロセスは以下の通りである:

- このモデルは、PICOフレームワークのクエリに応答して、強化されたクエリを生成する。

- 文書コレクション(PubMedまたはClinicalTrials.gov)に対する拡張クエリの実行。

- 検索された関連文書の割合としてリコールを計算する。

- 複合報奨は以下に基づいて算出される:

- 書式の正しさ(JSON構造、適切なラベル付け)

- 想起率を取得し、想起率が高いほど報酬も高くなる。

具体的には、我々の報酬関数は、表1に示すように、想起に基づく階層的採点システムを使用している。

| 再現率 | ≥ 0.7 | ≥ 0.5 | ≥ 0.4 | ≥ 0.3 | ≥ 0.1 | ≥ 0.05 | < 0.05 |

|---|---|---|---|---|---|---|---|

| インセンティブ | +5.0 | +4.0 | +3.0 | +1.0 | +0.5 | +0.1 | -3.5 |

表1:想起パフォーマンスに基づく報酬の階層。より高いリコール値は、より効率的なクエリを生成するようにモデルを動機付け、より大きな報酬を受け取る。

さらに、正しいフォーマットは+1点、正しくないフォーマットは-4点となります。重要なことは、フォーマットが正しくない場合(タグがない、JSON構造が正しくないなど)、回答ボーナスは全く計算されず、フォーマットペナルティのみが発生することです。この報酬構造は、モデルが望ましい出力形式を守りながら、想起を最大化するような整形されたクエリを生成することを強く促します。

2.5 トレーニング・プロセス

私たちのトレーニング・プロセスは次のようなステップを踏んでいる:

- 事前に訓練された重みを使ってモデルを初期化する。

- トレーニングセットの各クエリについて:

- 強化されたクエリを生成する。

- 検索システムに対してクエリーを実行する。

- 再現率(検索された関連文書の割合)を計算する。

- モデルを更新するために、想起ベースの報酬を使用する。

- 収束するまで繰り返す。

このプロセスにより、モデルは明示的な監視なしに、検索パフォーマンスから効果的なクエリ拡張戦略を直接学習することができる。このモデルは、PICOフレームワークのクエリを有効な検索語に変換する能力を徐々に向上させ、関連する医学文献の想起を最大化する。

3.実験

3.1 データセット

2つの医学文献検索タスクで我々のアプローチを評価する:

- 出版物検索PICOフレームワークで表現されたユーザクエリに基づいて、PubMedから関連する医学論文を検索する。

- テスト検索同様のPICOフレームワーククエリに基づき、ClinicalTrials.govから関連する臨床試験を取得する。

これらのデータセットは、医学文献の専門用語と複雑な関係のため、情報検索システムにとって特に困難である。各クエリに対して、拡張クエリによって理想的に検索されるはずのグランドトゥルースの関連文書(PMIDによって特定される)のセットがある。

3.2 指標の評価

主要な評価指標として、検索された関連文書の割合を測定するリコールを使用する。具体的には

- リコール率(出版物検索)検索された関連論文の割合。

- リコール(試行錯誤)検索された関連臨床試験の割合。

3.3 ベースライン

私たちのアプローチをいくつかのベースラインと比較する:

- GPT-4o様々なコンフィギュレーション(サンプルゼロ、サンプルレス、ICL、ICL+サンプルレス)。

- GPT-3.5様々なコンフィギュレーション(サンプルゼロ、サンプルレス、ICL、ICL+サンプルレス)。

- 俳句-3様々なコンフィギュレーション(サンプルゼロ、サンプルレス、ICL、ICL+サンプルレス)。

- ミストラル-7B (Jiang et al.)サンプルはゼロ。

- LEADS(ワンら、2025年)Mistral-7Bを用いた蒸留訓練のための最先端の医学文献検索法。

3.4 実施の詳細

VERLフレームワークを使用1HybridFlow RLHFフレームワークのオープンソース実装であるDeepRetrievalを実装した(Sheng et al.)

我々のトレーニング・コンフィギュレーションは、Proximal Policy Optimisation (PPO)を使用し、主要なパラメーターは以下の通りである:

- ベースラインモデルQwen-2.5-3B-Instruct (Yang et al., 2024)。

図2:DeepRetrievalのトレーニングダイナミクス。リコール計算はトレーニング中のPubMed検索に基づいている。

図2:DeepRetrievalのトレーニングダイナミクス。リコール計算はトレーニング中のPubMed検索に基づいている。

- PPO小ロットサイズ: 16.

- PPOマイクロバッチサイズ: 8.

- 学習率俳優1e-6、評論家1e-5。

- KL係数:: 0.001.

- 最大シーケンス長プロンプトもレスポンスも500トークンです。

メモリ使用量を最適化するために勾配チェックポイントを有効にしたFSDPストラテジーを使用して、2つのNVIDIA A100 80GB PCIeでモデルをトレーニングした。学習プロセスは5サイクル実行した。

図2に示すように、トレーニングダイナミクスは、トレーニングの進行に伴い、パフォーマンスメトリクスの着実な向上を示している。平均報酬(左上)は一貫した上昇傾向を示しており、最初はマイナスの値であったが、すぐにプラスに転じ、トレーニングを通して改善し続けている。同時に、不正解率(中央上)とフォーマットエラー率(右上)は劇的に減少し、モデルが関連文書を検索するために構造化されたクエリを生成することを学習していることを示している。

最も顕著な改善は、全てのリコールしきい値の一貫した増加であった。高い想起値(≥0.5, ≥0.7)に達するクエリの割合は着実に増加し、最も高い想起層(≥0.7)はほぼゼロからトレーニング終了までに~0.25まで増加した。0.9付近で安定した。この進歩は、強化学習が、検索性能を直接最適化することによって、効果的なクエリ拡張を生成するモデルの能力を徐々に高めることができることを明確に示している。

4.結果

4.1 主な結果

DeepRetrievalは、出版物検索タスクで60.821 TP3T、トライアル検索タスクで70.841 TP3Tのリコールを達成し、最先端のLEADSシステムを含むすべてのベースラインを大幅に上回った。

4.2 分析

この結果から、いくつかの重要な見解が浮かび上がった:

- 優れた性能DeepRetrievalは、論文検索タスク(60.821 TP3T対24.681 TP3T)、およびトライアル検索タスク(70.841 TP3T対32.111 TP3T)において、より小さなモデル(3B対7Bパラメータ)を使用しているにもかかわらず、LEADSを大差で上回った。

- 費用対効果DeepRecallalは、高価な蒸留を必要とするLEADS(学習データ生成に1万ドル以上と推定される)とは異なり、教師ありデータを必要としないため、コスト効率が大幅に向上する。

- 多用途出版物や実験的な検索タスクにおける持続的なパフォーマンスは、我々のアプローチが様々な検索シナリオにおいて優れた汎用性を持つことを示している。

- 構造化された発電の効率structureを使用することで、複雑なクエリを推論してから最終的な回答を導き出すことができるため、全体的な品質が向上する。

5.ディスカッション

5.1 強化学習が機能する理由

DeepRetrievalの優れたパフォーマンスにはいくつかの要因がある:

- 直接最適化想起を直接的に最適化することで、モデルは、あらかじめ定義されたパターンにマッチするクエリではなく、検索に有効なクエリを生成することを学習する。

- 探検強化学習のフレームワークにより、モデルは幅広いクエリ強化戦略を探索することができ、教師ありデータにはない効果的な手法を発見できる可能性がある。

- 適応学習画一的なアプローチではなく、クエリや文書コレクションの特性に合わせた強化戦略をとることができる。

- 構造化推論考えるコンポーネントと答えるコンポーネントを別々に使用する2段階の生成アプローチにより、最終的なクエリを送信する前に、質問空間を通してモデルを動作させることができます。

5.2 限界と今後の課題

最初の結果は有望だが、まだいくつかの限界と今後の研究の方向性がある:

- 古典的なIRデータセットでの評価現在の実験では、PICOフレームワークを用いた医学文献検索に焦点を当てている。次の重要なステップは、より一般的な検索シナリオにおける有効性をテストするために、標準的なIRベンチマークテスト(MS MARCO、TREC、BEIRなど)でDeepRecallalを評価することである。

- より高度な手法との比較最近のクエリ強化手法との追加的な比較により、今回の発見をさらに検証することができるだろう。

- モデル・エクステンションモデルが大きくなるにつれて性能がどのように変化するかを調べることで、モデルの大きさと検索性能のトレードオフを知ることができます。

- 奨励金リコール以外の指標(例えば、精度、nDCG)を組み込んだ、より複雑な報酬関数を探求することが、さらなる改善につながるかもしれない。

- 検索パイプラインとの統合DeepRecallalを既存の検索パイプラインにどのように統合できるか、ニューラルと従来の検索手法を組み合わせたハイブリッド・アプローチも含めて検討する。

6.結論

本稿では、情報検索のための新しい強化学習ベースのクエリ拡張手法であるDeepRecallalを紹介する。検索リコールを直接最適化するために3Bパラメータの言語モデルを学習することで、我々は医学文献検索タスクにおいて、教師あり学習や蒸留に依存する既存の手法を大幅に上回る最先端の性能を達成した。

我々のアプローチの主な革新点は、高価な教師ありデータを必要とせずに、試行錯誤を通じて効果的なクエリ強化戦略を学習する能力である。これにより、DeepRecallalは既存のアプローチよりも効率的であるだけでなく、費用対効果も高くなる。

我々の結果は、強化学習が情報検索のための有望なパラダイムを提供し、文書検索システムの状況を変える可能性があることを示している。我々は、このアプローチが他の情報検索タスクやドメインにも拡張可能であり、様々なアプリケーションの検索性能を向上させる一般的なフレームワークを提供できると考えている。

付録A PICOのヒント

医学文献の検索実験では、以下のような専門家の入力プロンプトを使用した:

アシスタントは臨床のスペシャリスト。研究を行い、医学文献のレビューを行っている。彼の仕事はPubMedやClinicalTrials.govで関連文献を探すためにURLを検索するためのクエリー用語を作成することである。

本研究は、PICOフレームワークの定義に基づいている:

P: Patient, Problem or Population(患者、問題、集団) - 調査集団は誰か?

I: 介入 - 考慮した主な介入や暴露要因は何か?

C:対照-介入は何と比較されるか?

O:成果-関連する知見や測定された効果は何か?

アシスタントは タグの中で自分の思考プロセスを示すべきである。

アシスタントは、 タグ内で最終的な答えを返し、例えばJSONフォーマットを使用する必要があります:

<考える

[思考プロセス]</think

<回答

{

"クエリー": "......"

}

</回答

注:クエリは、ブール演算子(AND、OR)と括弧を使用して、用語を適切にグループ化する必要があります。

この専門家による入力プロンプトは、特に医学文献検索用に作成されているが、タスク記述とクエリ構造ガイダンスを変更することにより、他の情報検索(IR)ドメインにも適用することができる。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません