DeepClaude:DeepSeekのR1チェーン推論とClaudeの創造性を融合したチャットインターフェース

はじめに

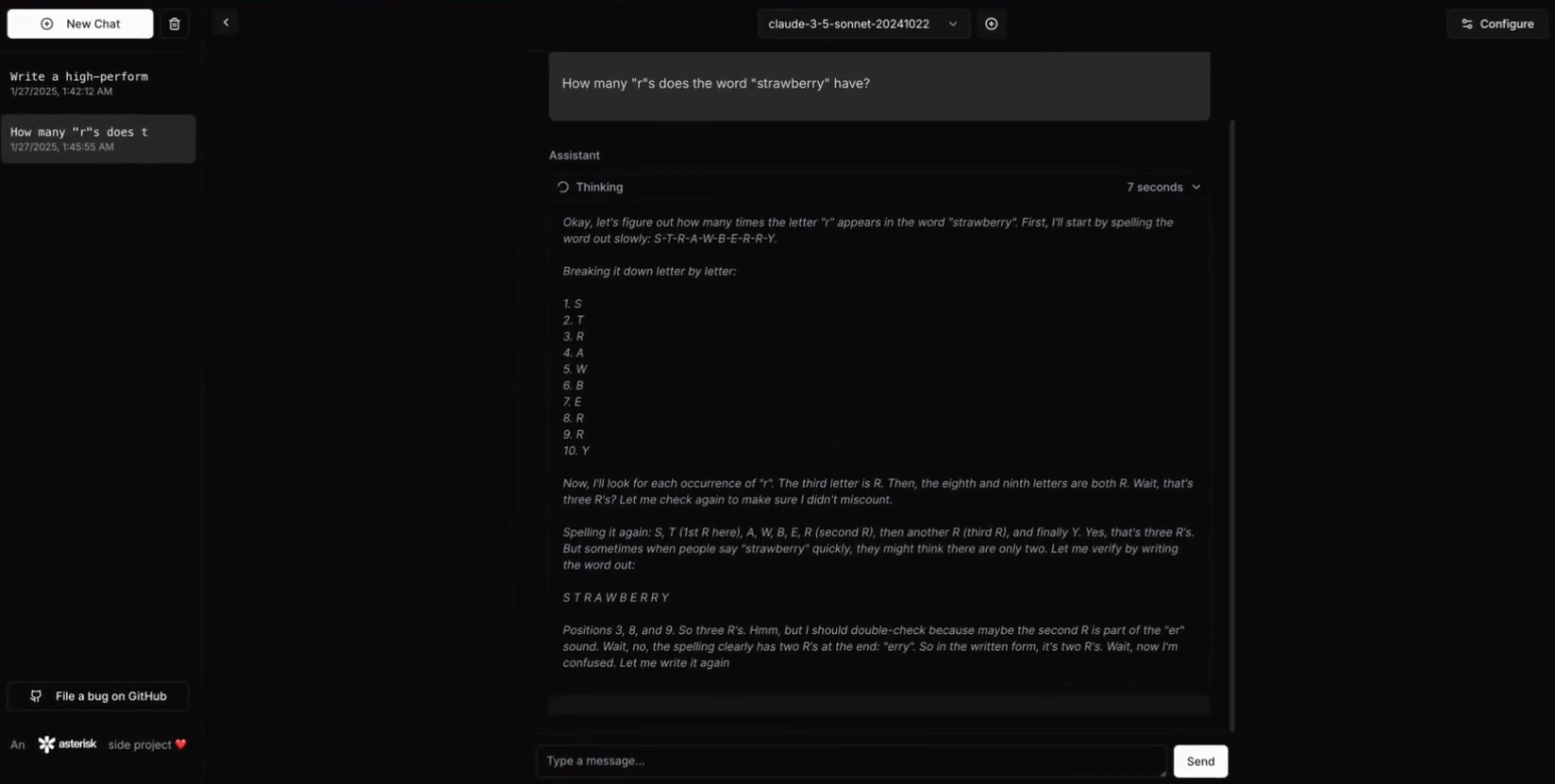

DeepClaude は、高性能な大規模言語モデル (LLM) 推論 API およびチャット・インタフェースで、DeepSeek R1 の連鎖推論 (CoT) 機能と、以下の機能を統合しています。 アンソロピッククロード モデルの創造性とコード生成能力このプロジェクトはOpenAI o1を大幅に上回る、 ディープシーク R1とClaude Sonnet 3.5は、APIキーとデータの完全な制御を維持しながら、両方のモデルの長所を活用する統一されたインターフェイスを提供します。 DeepClaudeの特徴には、ゼロレイテンシーレスポンス、エンドツーエンドのセキュリティ、高い設定可能性、オープンソースのコードベースが含まれます。ユーザーは自分のAPIキーを自分で管理することができ、データのプライバシーとセキュリティを確保することができます。何よりも、DeepClaudeは完全に無料でオープンソースです。

DeepClaudeは推論にR1を使用し、その結果をClaudeに出力させる。

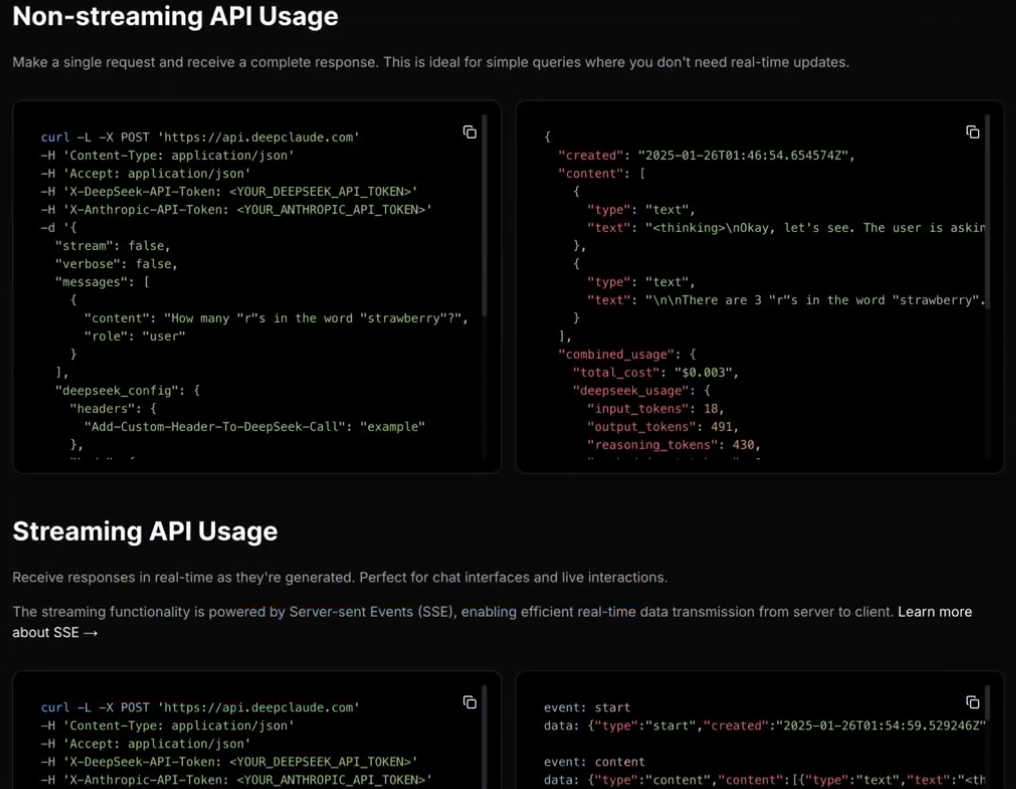

DeepClaudeは、高性能なLLM推論APIも提供している。

機能一覧

- ゼロ・レイテンシー・レスポンス高性能なRust APIによる即時応答。

- プライベートで安全データのプライバシーを確保するためのローカル API キー管理。

- 高度なコンフィギュレーションが可能APIやインターフェイスは、ユーザーのニーズに合わせてカスタマイズすることができます。

- オープンソースフリーでオープンソースのコードベースなので、ユーザーは自由に貢献、修正、デプロイできます。

- デュアルAI機能Claude Sonnet 3.5の創造性とコード生成能力をDeepSeek R1の推論能力と組み合わせる。

- ホスト型 BYOK APIユーザー自身のAPIキーを使用して管理し、完全なコントロールを保証します。

ヘルプの使用

設置プロセス

- 前提条件::

- ラスト1.75以上

- DeepSeek API キー

- Anthropic APIキー

- クローン倉庫::

git clone https://github.com/getAsterisk/deepclaude.git

cd deepclaude

- プロジェクトの構築::

cargo build --release

- 設定ファイルプロジェクト・ルート・ディレクトリに作成

config.tomlドキュメンテーション

[server]

host = "127.0.0.1"

port = 3000

[pricing]

# 配置定价选项

- 運営サービス::

cargo run --release

使用ガイドライン

- APIの使用::

- 基本例::

import requests url = "http://127.0.0.1:3000/api" payload = { "model": "claude", "prompt": "Hello, how can I help you today?" } response = requests.post(url, json=payload) print(response.json())- ストリーミング・レスポンスの例::

import requests url = "http://127.0.0.1:3000/api/stream" payload = { "model": "claude", "prompt": "Tell me a story." } response = requests.post(url, json=payload, stream=True) for line in response.iter_lines(): if line: print(line.decode('utf-8')) - 自ホスト::

- 設定オプションを変更することができます。

config.tomlAPIとインターフェイスの側面をカスタマイズするために、ドキュメントにある設定オプション。

- 設定オプションを変更することができます。

- 安全性::

- ローカルAPIキー管理APIキーとデータのプライバシーを確保する。

- エンドツーエンドの暗号化データ伝送のセキュリティを保護します。

- 捧げる::

- 寄付ガイドラインユーザーはPull Requestを提出したり、問題を報告したりすることで、コードに貢献し、プロジェクトを改善することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません