コマンドR7B:検索と推論の強化、多言語サポート、高速で効率的な生成AI

Rファミリーの最小モデルは、一般的なGPUやエッジデバイス上で強力なAIアプリケーションを構築するために、トップクラスのスピード、効率、品質を提供します。

本日、私たちは コマンド R7Bは、企業向けに特別に開発された大規模言語モデル(LLM)のRシリーズで、最小、最速、最後のモデルです。Command R7Bは、ユーザーにとって重要な実世界のタスクを処理できるオープン・ウェイト・モデルのクラスで、業界をリードする性能を提供します。このモデルは、スピード、費用対効果、計算リソースの最適化を必要とする開発者や企業向けに設計されています。

Rファミリーの他のモデルと同様に、Command R7Bは128kのコンテキスト長を提供し、いくつかの重要なビジネス・アプリケーション・シナリオに優れています。強力な多言語サポート、参照検証されたRAG(Retrieval Augmented Generation)、推論、ツールの使い方、エージェントの振る舞いを兼ね備えています。そのコンパクトなサイズと効率性のおかげで、ローエンドのGPU、MacBook、さらにはCPUでも実行でき、AIアプリケーションを本番稼動させるコストを劇的に削減します。

小型パッケージで高性能

包括的なモデル

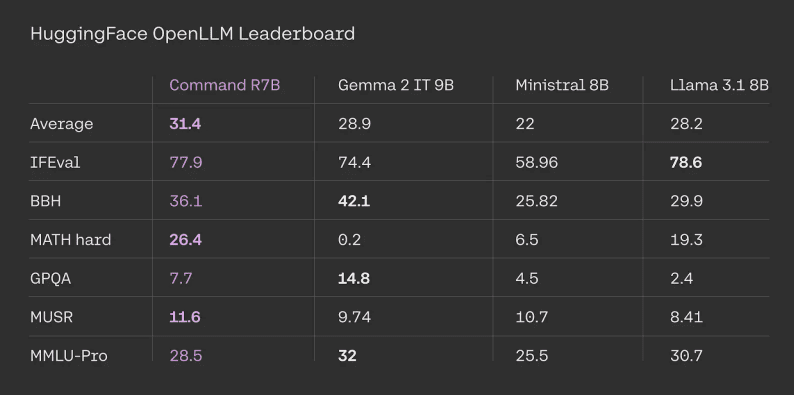

コマンドR7Bは、以下のような標準化された外部検証可能なベンチマークで優れた性能を発揮します。 HuggingFaceオープンLLMリーダーボード.コマンドR7Bはすべてのタスクで平均1位を獲得し、他の同程度のオープン・ウェイト・モデルと比較しても高いパフォーマンスを示した。

HuggingFaceリーダーボードの評価結果。競合の数値は公式リーダーボードから引用しています。Command R7Bの結果は公式HuggingFaceから提供されたヒントと評価コードに基づいて私たちが計算したものです。

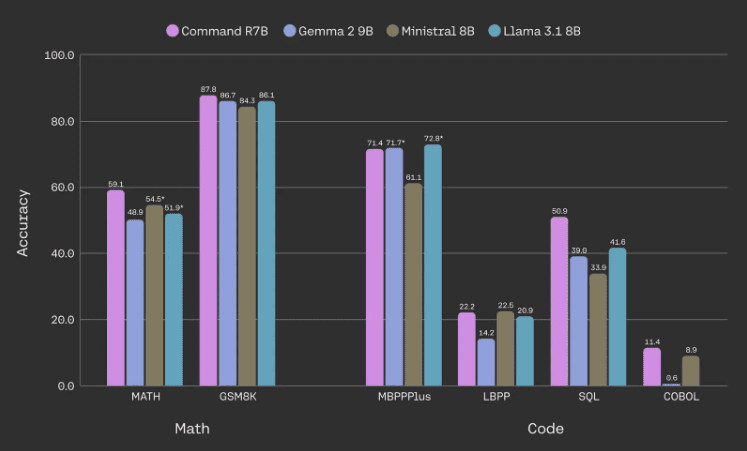

数学、コード、推論タスクの効率向上

コマンドR7Bの主な焦点は、数学と推論、コードライティング、多言語タスクのパフォーマンスを向上させることである。特に、このモデルは、より少ないパラメータで、一般的な数学とコードのベンチマークにおいて、同等のオープン加重モデルの性能に匹敵するか、それを上回ることができます。

数学およびコード・ベンチマークにおけるモデル・パフォーマンス。すべてのデータは内部評価によるものであり、アスタリスクの付いた数値は、より高い外部報告結果によるものである。MBPPPlusの基本バージョンを使用し、LBPPは6つの言語の平均、SQLは3つのデータセット(SpiderDevとTestのみの高難易度セクションと超高難易度セクション、BirdBench、社内データセット)の平均、COBOLは社内で開発したデータセットを使用。

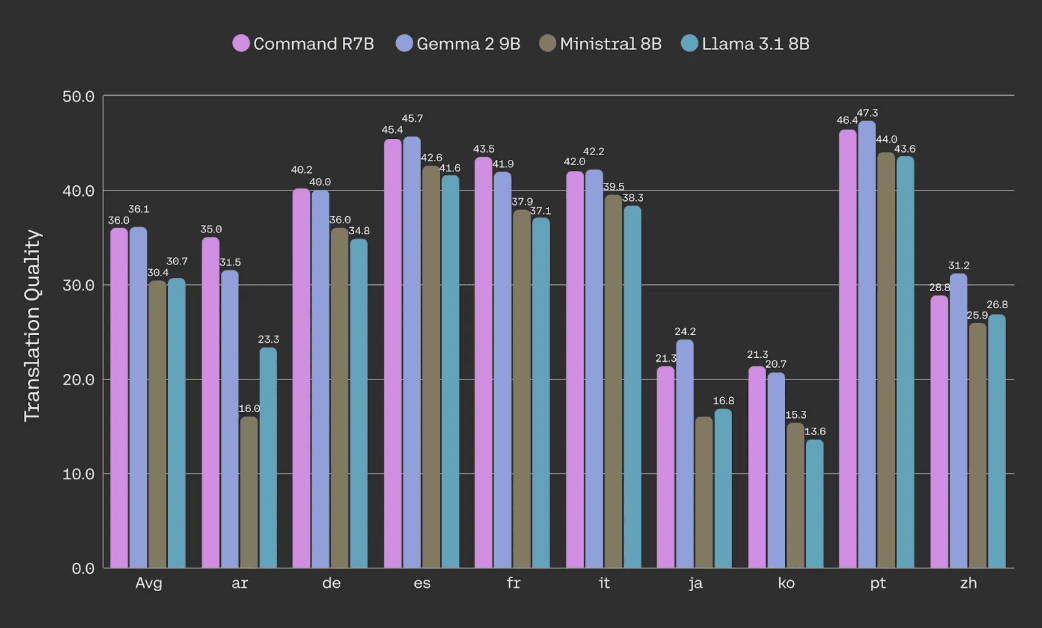

NTREXデータセットを用いた文書翻訳の品質(コーパスspBLEUメトリクスによる)評価。

クラス最高のRAG、ツール使用、インテリジェンス

Command R7Bは、RAG、ツールの使用状況、AIインテリジェンスなどのコアビジネス用途の処理において、同規模の他のオープン加重モデルを凌駕しています。内部文書とデータに基づいた費用対効果の高いモデルを求める組織に最適です。他のRシリーズモデルと同様、当社の ラグ ローカル・インライン・リファレンスが提供され、錯覚を大幅に減らし、事実確認を容易にする。

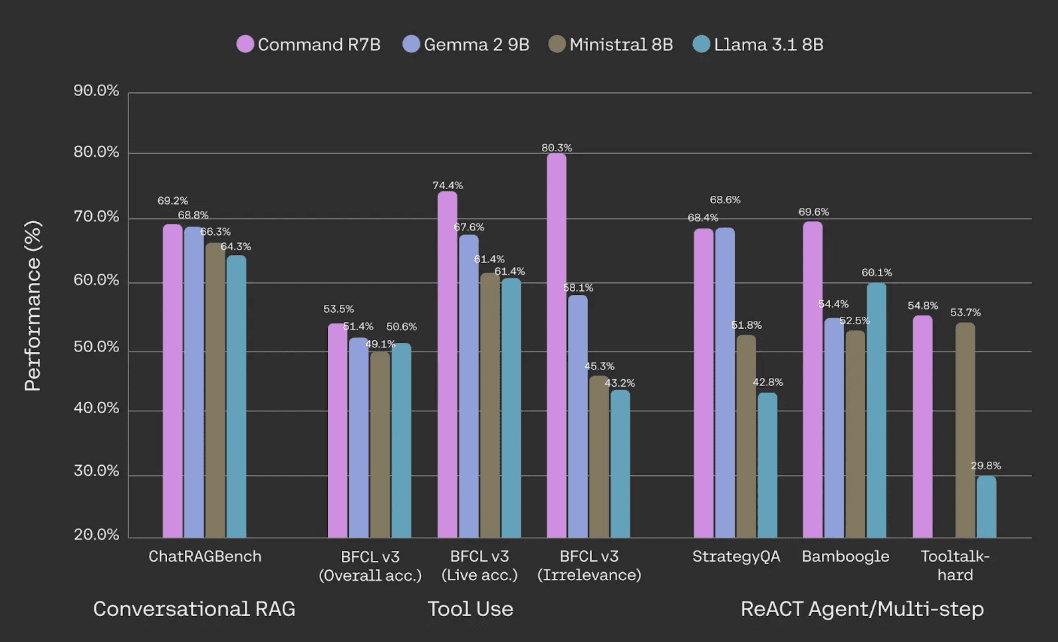

ChatRAGBench(10データセットの平均)、BFCL-v3、StrategyQA、Bamboogle、Tooltalk-hardでの性能評価。方法論と詳細については以下の脚注[1]を参照。

工具の使用に関しては、同程度のスケールモデルと比較して、コマンドR7Bは業界標準の工具をより効率的に使用していることがわかる。 バークレー関数呼び出しリーダーボード これは、コマンドR7Bが実世界の多様で動的な環境におけるツール使用に特に長けており、実世界のアプリケーションにおけるツール使用の重要な側面である、不必要なツールの呼び出しを避けることができることを示している。これは、Command R7Bが実世界における多様で動的な環境でのツール使用に特に長けており、実世界のアプリケーションにおけるツール使用の重要な側面である、不必要なツールの呼び出しを避けることができることを示している。Command R7Bのマルチステップツール使用能力は、高速で効率的なAIインテリジェンスをサポートすることを可能にする。

企業ユースケースに最適化

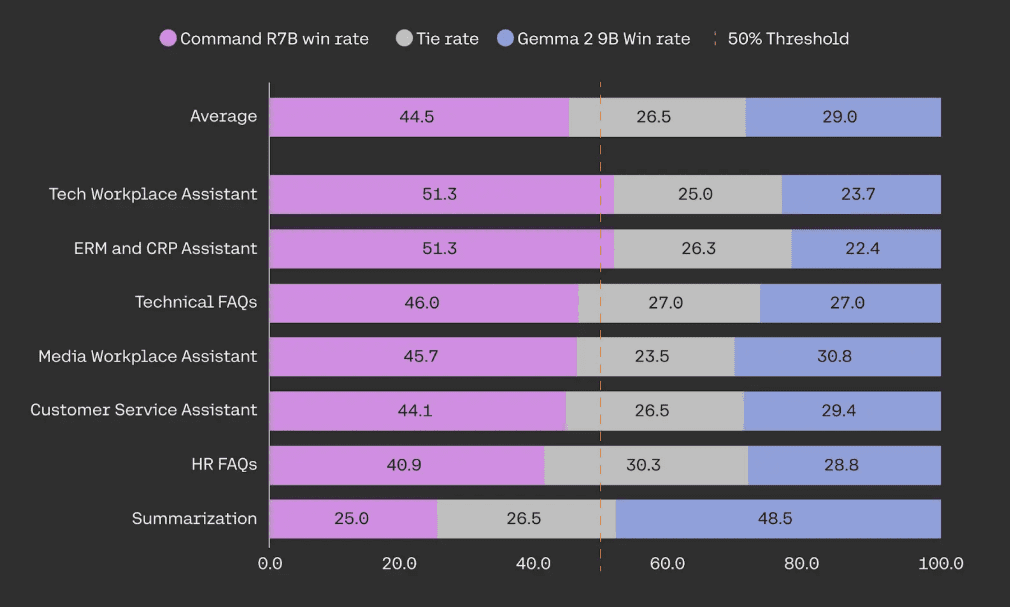

Rシリーズは、効率性とロバストなパフォーマンスの比類ないバランスを提供します。Command R7Bは、カスタマーサービス、人事、コンプライアンス、ITサポート機能など、顧客が関心を寄せるAIアシスタントを構築するためのRAGユースケースに関するブラインドヘッドツーヘッドテストにおいて、同規模のオープンウェイトモデルを上回っています。

人間による評価では、Command R7Bは、949のエンタープライズRAGユースケースでGemma 2 9Bとテストされた。すべての事例は、流暢さ、忠実さ、回答の有用性を評価するために、特別に訓練された人間のアノテーターによって少なくとも3回、ブラインドでアノテーションされた。

効率的で速い

Command R7Bのコンパクトなサイズは、迅速なプロトタイピングと反復のための小さなサービスフットプリントを提供します。チャットボットやコードアシスタントのような高スループットのリアルタイムユースケースに優れています。また、コンシューマーグレードのGPUやCPUなどのインフラの導入コストを劇的に削減することで、デバイスサイドの推論をサポートします。

私たちは、お客様のデータ保護を確実にするため、このプロセスにおいて、企業レベルのセキュリティおよびプライバシー基準に妥協していません。

クイックスタート

コマンドR7Bは本日より発売開始 コヒア・プラットフォーム にも使用できる。 ハグ顔 アクセスについてAI研究コミュニティに最先端技術への幅広いアクセスを提供するため、モデルの重みを公開できることを嬉しく思います。

| コヒーレ API価格 | 輸入 トークン | 出力トークン |

|---|---|---|

| コマンド R7B | $0.0375 / 1m|$0.15 / 1m |

[1] 会話型 RAG: ChatRAGBench ベンチマークにおける 10 個のデータセットでの平均的な性能テスト。会話タスク、長い入力の処理、フォームの分析、金融環境でのデータ情報の抽出と操作など、様々な環境での応答生成能力をテストした。Haiku、GPT3.5、Command Rと組み合わせてPoLL識別器統合(Verga et al., 2024)を使用することで、評価方法を改善し、より高い一貫性を実現した(20,000件の手動評価に基づく、オリジナルバージョンの0.57に対し、Fleiss' kappa = 0.74)。ツール使用:2024年12月12日BFCL-v3ベンチマークでのパフォーマンス。利用可能なスコアはすべて公開リーダーボードによるもので、それ以外は公式コードベースを使用した内部評価。競合他社については、BFCLの「プロンプト」スコアと「関数呼び出し」スコアの高い方を報告する。総合スコア、リアルタイム・サブセット・スコア(実世界の多様で動的な環境におけるツールの使用をテスト)、および非関連サブセット・スコア(モデルがツールを不必要に呼び出すことを回避する方法をテスト)を報告します。 リアクト BamboogleはPoLL統合を使って評価し、StrategyQAは、モデルがフォーマットの指示に従ったかどうかを評価し、最終的に'Yes'か'No'に答えて判断した。'または'No'と答えて判定を行う。ToolTalk-hardは、公式ToolTalkライブラリのソフト成功率を用いて評価される。ToolTalkは、モデルに関数呼び出しAPIを公開することを要求しますが、Gemma 2 9Bにはありません。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません