CoD:密度の連鎖

原文ママhttps://arxiv.org/pdf/2309.04269

速読:疎から密へ:連鎖密度ヒントを用いたGPT-4アブストラクト生成

に収集された:よく使われるプロンプトの知識をまとめる

抄録

自動テキスト要約に含めるべき「適切な」情報量を決定することは、難しい課題である。良い要約は、詳細でエンティティ中心である必要がある一方、長すぎて理解しにくくなることは避けなければならない。このトレードオフをよりよく理解するために、GPT-4が次第に密度の濃い要約を生成できるようにする、密度の連鎖(CoD)と呼ばれるキューイング手法を提案する。CoDにより生成された要約は、通常のキューを用いて生成されたGPT-4要約と比較して、より抽象的で収束性が高く、オープニングバイアスが少ないことがわかった。100のCNN/DailyMailの記事を対象とした人間の嗜好調査を用いて、人間は通常のプロンプトで生成されたGPT-4の要約よりも密度の高い要約を好み、その密度は手動で書かれた要約とほぼ同等であることがわかった。

1.はじめに

近年、自動要約技術は、教師ありの微調整から大規模言語モデル(LLM)を用いたゼロサンプルプロンプトへのパラダイムシフトにより、大きく進歩している。例えば、GPT-4は、追加的な訓練なしに、よく設計されたキューを用いて要約の特徴(例えば、長さ、トピック、スタイル)をきめ細かく制御することができる。

しかし、要約の情報密度は見落とされがちな側面である。理論的には、別の文章を圧縮したものであるため、要約には原文よりも高い情報密度が含まれるはずである。しかし、要約の情報密度は未解決の問題である。要約に含まれる情報が不十分な場合、それは取るに足らないものとなり、情報が多すぎる場合、全体の長さを増やすことなく理解することが難しくなる可能性がある。一定のトークン予算内でより多くの情報を伝えるには、抽象化、圧縮、融合を組み合わせる必要がある。理解不能になる前に、あるいは事実と異なってしまう前に、追加情報を入れるスペースには限界がある。

2.連鎖密度キュー(CoD)

2.1 目標

我々の目標は、要約を評価する際に強い交絡要因であることが示されている長さを制御しながら、情報密度の異なるGPT-4要約を生成することであった。この目的を達成するために、最初の要約が生成され、エンティティが徐々に密になるような連鎖密度(CoD)キューを設計した。具体的には、一定のラウンド数で、原文から注目すべきエンティティのユニークなセットが識別され、長さを増やすことなく前の要約に融合される。最初の要約は、1~3 の最初のエンティティにのみ焦点を当てるため、エンティティが疎である。

2.2 データ

CoD要約を生成するために、CNN/DailyMail要約テストセットから100の記事をランダムに選択した。

2.3 基準点

比較のために、CoDの抄録と、手作業で書かれた箇条書きの参考抄録、共通のプロンプトを用いて作成されたGPT-4の抄録の統計量を比較した:

- 普通のヒント: : "記事の概要を70字以内で簡潔に書いてください。"

必要なトークンの長さは、CoDダイジェストの長さと一致するように設定した(下表のとおり)。

2.4 ヒントの例

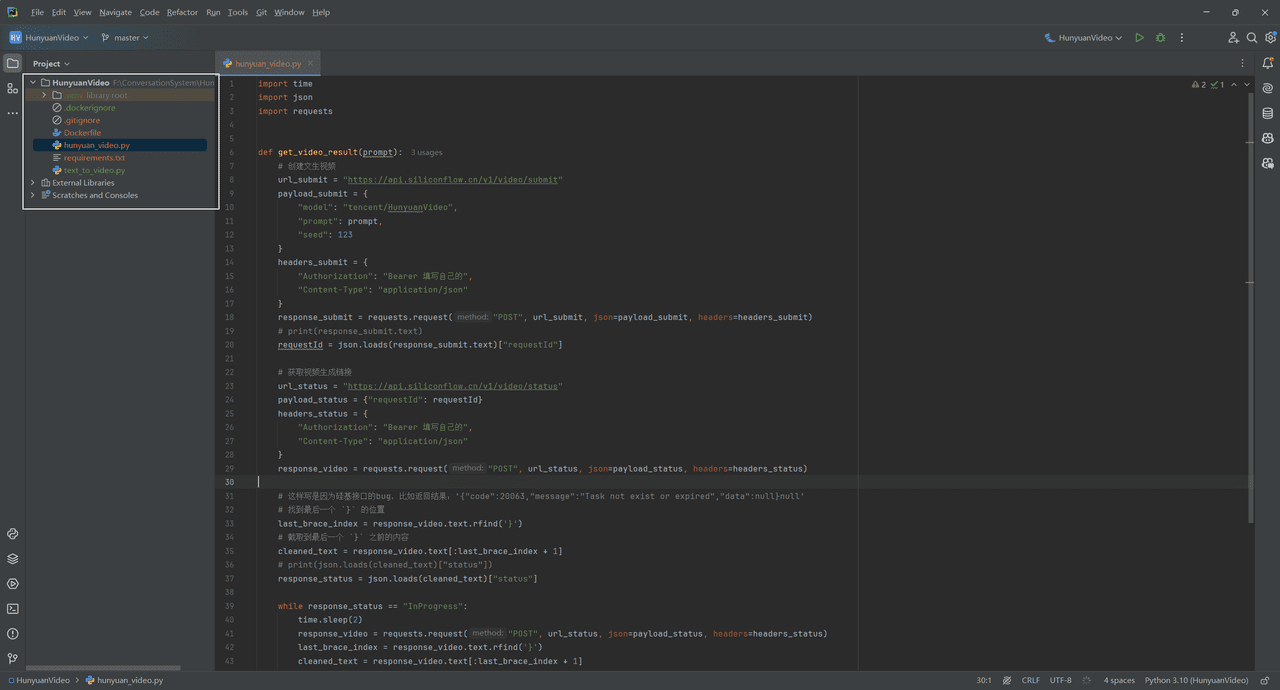

以下はCoDのプロンプトの例である:

请生成一个非常简短的摘要,不超过70个单词。然后,逐步添加1-3个缺失的重要实体,而不增加长度。

フルCoDプロンプトの例(オリジナル英語)。

Article: {{ ARTICLE }}

You will generate increasingly concise, entity-dense summaries of the above article.

Repeat the following 2 steps 5 times.

Step 1. Identify 1-3 informative entities (";" delimited) from the article which are missing from the previously generated summary.

Step 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.

A missing entity is:

- relevant to the main story,

- specific yet concise (5 words or fewer),

- novel (not in the previous summary),

- faithful (present in the article),

- anywhere (can be located anywhere in the article).

Guidelines:

- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific, containing little information beyond the entities marked as missing. Use overly verbose language and fillers (e.g., "this article discusses") to reach ~80 words.

- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.

- Make space with fusion, compression, and removal of uninformative phrases like "the article discusses".

- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article.

- Missing entities can appear anywhere in the new summary.

- Never drop entities from the previous summary. If space cannot be made, add fewer new entities.

Remember, use the exact same number of words for each summary.

Answer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are "Missing_Entities" and "Denser_Summary".

言葉の説明の出番だ。

この詳細なCoDのキュー・ワードは、GPT-4が徐々に密度の高いサマリーを生成するように導くためのもので、核となるアイデアは、サマリーの長さを一定に保ちながら、反復プロセスによって各ラウンドでサマリーに新しいキー・エンティティを追加することである。このキューワードの部分を分解してみよう:

Article: {{ ARTICLE }}これは要約したい記事の内容のプレースホルダーです。{{ ARTICLE }}.You will generate increasingly concise, entity-dense summaries of the above article.これは指令の核心部分であり、簡潔で実体の濃い要約をどんどん生成していくことが目標であることをモデルに伝えている。Repeat the following 2 steps 5 times.反復回数を5回と指定すると、モデルは次の2つのステップを5ラウンド繰り返し、要約の密度を徐々に高めていく。Step 1. Identify 1-3 informative entities (";" delimited) from the article which are missing from the previously generated summary.: ステップ1:欠落しているエンティティの特定.このモデルは、元論文から1つから3つの有益なエンティティを識別する必要があり、それらは以前に生成された抄録に現れてはならない。エンティティはセミコロンで区切られる;分離。Step 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.: ステップ2:より密度の高い要約を作成する. モデルは前の要約に基づいて新しい要約を生成し、ステップ 1 で識別された欠落しているエンティティを組み込む必要がある。新しい要約が以前の要約とまったく同じ長さであることは非常に重要であり、モデルは新しいエンティティに対応するために情報を圧縮し、融合させる。A missing entity is::: 選択されたエンティティが高品質で適切であることを保証するために、「欠落エンティティ」の基準を定義する:- relevant to the main story記事の本筋に関すること。- specific yet concise (5 words or fewer)具体的かつ簡潔に、5語以内で。- novel (not in the previous summary)これまでのサマリーにはない。- faithful (present in the article)記事にあることは本当なのだろう。- anywhere (can be located anywhere in the article)記事中のどこにでも配置できる。

Guidelines:要約作成タスクの実行方法について、より詳細にモデルを指示するための一連のガイドが提供されている:- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific...: 最初の要約のガイダンス最初の要約は長く(~80ワード、4~5文)、情報量は少なくする必要がある。冗長な表現やフィラーワードが使用されてもよい。- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.: 言語の簡素化:: 言語表現を最適化し、新しいエンティティを含める余地を作るために、以前の要約を書き直す必要性を強調。- Make space with fusion, compression, and removal of uninformative phrases like "the article discusses".: スペース・スケーリング技法:: 要約を圧縮するために、フュージョン、圧縮、有益でないフレーズの除去などのテクニックを使用することを明示する。- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article.: 品質目標の概要: 最終的な要約は、密度が高く簡潔であることが求められるが、同時に自己完結的、つまり原文を読まなくても要約の内容が理解できるものでなければならない。- Missing entities can appear anywhere in the new summary.: 物理的位置:: 新たに追加されたエンティティは、新しいサマリーのどこにでも表示することができる。- Never drop entities from the previous summary. If space cannot be made, add fewer new entities.: 団体予約:: 以前のサマリーのエンティティは決して削除しないことを強調する。十分なスペースがない場合は、新しいエンティティを控えめに追加してもよい。- Remember, use the exact same number of words for each summary.: ユニフォーム各ラウンドで作成される要約の長さに一貫性を持たせる必要性を再度強調する。Answer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are "Missing_Entities" and "Denser_Summary".: 出力フォーマットJSONは5つの辞書のリストである必要があり、各辞書は "Missing_Entities"(このラウンドで追加されたエンティティの欠落)と "Denser_Summary"(このラウンドで生成されたより密度の高い要約)をキーに含む。

図1:: 連鎖密度(CoD)のヒントと出力例。各ステップでは、長さを増やすことなく、前の要約に1~3個の詳細(エンティティ)が追加される。新しいエンティティのためのスペースを確保するために、既存のコンテンツが書き換えられる(圧縮、融合など)。注釈者の半数(2/4)は最後の要約を好み、残りは最後の要約を好む。

CoDキュー・ワードの実際の使用例:

ジョー・バイデン米大統領のポーランド訪問」というニュース記事があり、CoDキューを使って密度の異なる一連の要約を生成したいとする。

ステップ1:記事に入る準備

まず、例えばニュース記事の内容を準備する必要がある:

美国总统乔·拜登 неожиданно 抵达波兰进行访问,与波兰总统安杰伊·杜达举行会晤。此次访问正值俄乌冲突一周年之际,预计两国领导人将讨论地区安全、对乌克兰的进一步支持以及加强北约东翼等议题。拜登的访问是对波兰在支持乌克兰难民和向乌克兰提供军事援助方面所做努力的肯定。此外,拜登还计划在华沙就俄乌冲突发表重要讲话,并会见在波兰的美军士兵。

ステップ2:APIリクエストの構築(例としてOpenAI API)

OpenAI API(またはGPT-4モデルをサポートする他のAPI)を使ってリクエストを送信します。 リクエストのボディ部分には、CoDプロンプトの単語と {{ ARTICLE }} 用意された記事の内容に置き換える。

{

"model": "gpt-4",

"prompt": "Article: 美国总统乔·拜登 неожиданно 抵达波兰进行访问,与波兰总统安杰伊·杜达举行会晤。此次访问正值俄乌冲突一周年之际,预计两国领导人将讨论地区安全、对乌克兰的进一步支持以及加强北约东翼等议题。拜登的访问是对波兰在支持乌克兰难民和向乌克兰提供军事援助方面所做努力的肯定。此外,拜登还计划在华沙就俄乌冲突发表重要讲话,并会见在波兰的美军士兵。\nYou will generate increasingly concise, entity-dense summaries of the above article.\n\nRepeat the following 2 steps 5 times.\n\nStep 1. Identify 1-3 informative entities (\";\" delimited) from the article which are missing from the previously generated summary.\nStep 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.\n\nA missing entity is:\n- relevant to the main story, \n- specific yet concise (5 words or fewer), \n- novel (not in the previous summary), \n- faithful (present in the article), \n- anywhere (can be located anywhere in the article).\n\nGuidelines:\n\n- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific, containing little information beyond the entities marked as missing. Use overly verbose language and fillers (e.g., \"this article discusses\") to reach ~80 words.\n- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.\n- Make space with fusion, compression, and removal of uninformative phrases like \"the article discusses\".\n- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article. \n- Missing entities can appear anywhere in the new summary.\n- Never drop entities from the previous summary. If space cannot be made, add fewer new entities. \n\nRemember, use the exact same number of words for each summary.\nAnswer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are \"Missing_Entities\" and \"Denser_Summary\".",

"max_tokens": 1000, // 确保模型有足够的token生成完整JSON输出

"temperature": 0.7// 可调整temperature控制生成结果的随机性

}

ステップ3:APIリクエストの送信とJSONレスポンスの受信

上記の JSON リクエストを OpenAI API エンドポイントに送信する。 APIは、5つの異なる密度の要約と、各ステップで追加されたエンティティの欠落を含むJSON形式のレスポンスを返します。

ステップ4:JSONレスポンスの解析とダイジェストの使用

APIから返されたJSONレスポンスを解析する。 以下のようなJSONリストを取得します:

{

"Missing_Entities": [],

"Denser_Summary": "This article discusses a visit. It is about a president visiting a country. The president is American. The country is Poland. This is related to international relations. The visit is happening during a time of conflict. This conflict involves Russia and Ukraine. The visit aims to show support and discuss important matters. More details will be provided."

},

{

"Missing_Entities": ["Joe Biden"; "Andrzej Duda"],

"Denser_Summary": "U.S. President Joe Biden visited Poland and met with Polish President Andrzej Duda. This visit is about international relations and is happening during the Russia-Ukraine conflict. They will discuss support and security. More details are expected."

},

{

"Missing_Entities": ["one-year anniversary of the Russia-Ukraine conflict"; "regional security"; "support for Ukraine"],

"Denser_Summary": "U.S. President Joe Biden met Polish President Andrzej Duda in Poland on the one-year anniversary of the Russia-Ukraine conflict. They discussed regional security and support for Ukraine, focusing on international relations."

},

{

"Missing_Entities": ["strengthening NATO's eastern flank"; "support for Ukrainian refugees"; "military aid to Ukraine"],

"Denser_Summary": "On the Russia-Ukraine conflict's one-year anniversary, U.S. President Joe Biden visited Poland, meeting President Andrzej Duda to discuss regional security, support for Ukraine (including refugees and military aid), and strengthening NATO's eastern flank."

},

{

"Missing_Entities": ["Warsaw"; "major speech"; "U.S. troops in Poland"],

"Denser_Summary": "To mark the Russia-Ukraine conflict's one-year mark, U.S. President Joe Biden visited Warsaw, Poland, meeting President Andrzej Duda to discuss regional security, Ukrainian refugee and military aid support, strengthening NATO's eastern flank, and Biden's planned major speech and meeting with U.S. troops in Poland."

}

]

ニーズに応じて、適切な密度の要約を選ぶことができる。 例えば、非常に短い要約が必要な場合は、1番目か2番目の要約を選び、より詳細でありながら簡潔な要約が必要な場合は、4番目か5番目の要約を選ぶことができます。

実用的な応用シナリオ:

- ニュースアグリゲーションとコンテンツレコメンデーション:ユーザーやプラットフォームによって異なる情報ニーズを満たすために、異なる密度の要約を提供する。

- 情報検索:検索結果に異なる密度の抄録を表示し、ユーザーが記事の関連性を素早く判断できるようにする。

- 読解補助:要約の密度を徐々に高めることで、読者が本文の内容を最初から最後まで理解できるようにする。

- ソーシャルメディア・コンテンツの生成:さまざまなソーシャルメディア・プラットフォーム(ツイッターやフェイスブックなど)向けに、さまざまな長さと密度の要約を生成。

以上の手順で、CoDキューワードを実践で効果的に使い、GPT-4で高品質で多密度のテキスト要約を作成することができます。

3.統計データ

3.1 直接統計

表1では、NLTKを使用してトークンを計算し、Spacyを使用して一意エンティ ティを測定し、エンティティの密度を比率として計算している。実際、最初の長い要約から不要な単語が削除されるため、第2ステップでは平均5トークンの削減(72から67へ)につながる。エンティティ密度は、人間や通常のGPT-4(それぞれ0.151と0.122)よりも低い最初の0.089から始まり、5段階の高密度化後に0.167まで上昇した。

| CoDのステップ | トークン | ぶっしょう | 密度(E/T) |

|---|---|---|---|

| 1 | 72 | 6.4 | 0.089 |

| 2 | 67 | 8.7 | 0.129 |

| 3 | 67 | 9.9 | 0.148 |

| 4 | 69 | 10.8 | 0.158 |

| 5 | 72 | 12.1 | 0.167 |

| 人類 | 60 | 8.8 | 0.151 |

| 一般GPT-4 | 70 | 8.5 | 0.122 |

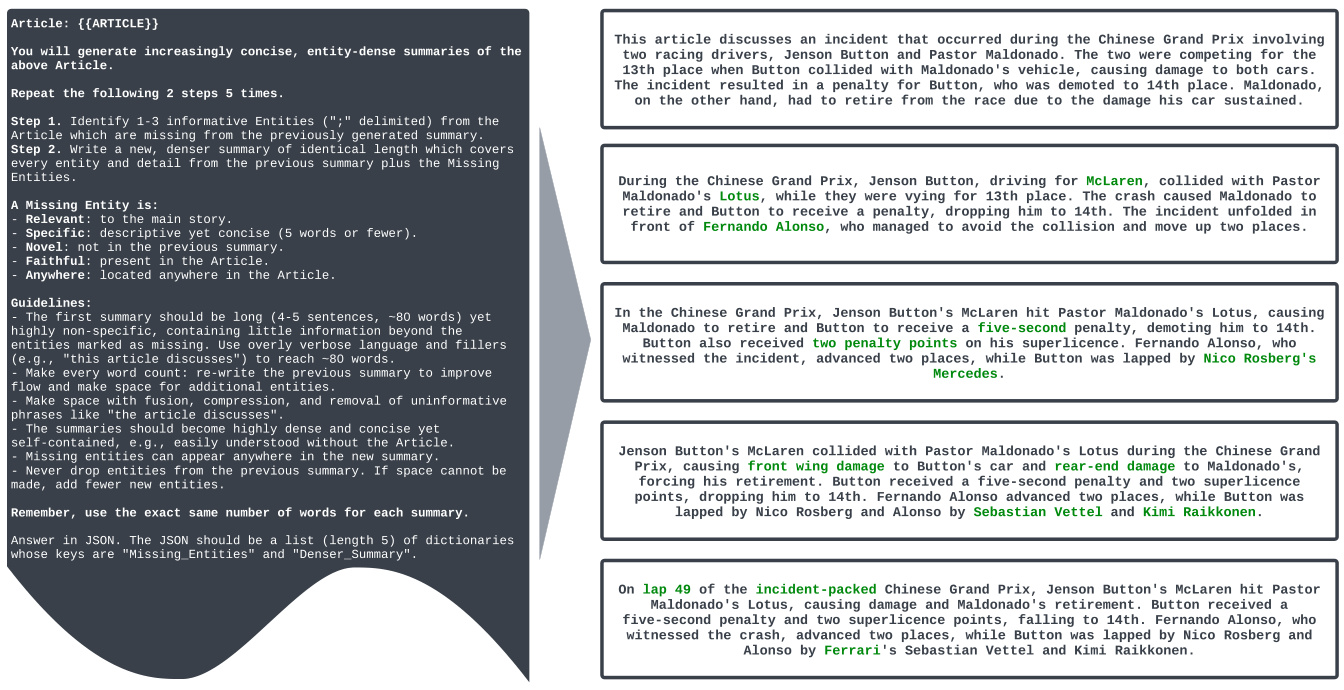

3.2 間接統計

CoDの各ステップでは、追加されたエンティティのためのスペースを確保するためにアブストラクトが繰り返し書き換えられるので、抽象度は増加するはずである。抽出密度(抽出された断片の長さの平均二乗)を使って抽象度を測定する。同様に、固定長のアブストラクトにエンティティが追加されるにつれて、フュージョンのレベルは単調に増加するはずである。ここでは、各抽 象文に対してアライメントされたソース文の平均数として、フュージョンをプロキシします。アライメントには相対 ROUGE ゲイン法を使用し、追加された文の相対 ROUGE ゲインが正でなくなるまで、ソース文をターゲット文にアライメントします。また、コンテンツ分布(要約コンテンツがソースとなった記事内の位置)が変化することも想定している。具体的には、CoDアブストラクトは、最初は強い冒頭のバイアス(Lead Bias)を示すが、徐々に記事の中盤と終盤からエンティティを導入し始めると予想される。これを測定するために、融合でアライメントを使用し、アライメントされたすべてのソース文の平均文ランクを測定します。図2はこれらの仮説を裏付けている。書き換えステップが増加するにつれて、抽象度は上昇し(左のパネル)、融合率は上昇し(中央のパネル)、抄録は記事の中間と末尾からのコンテンツを含み始める(右のパネル)。興味深いことに、すべてのCoDアブストラクトは、手書きアブストラクトやベースラインアブストラクトよりも抽象度が高い。

図2CoDによって生成されたアブストラクトは、より抽象的になる一方で、より収束し、始まりのバイアスは減少している。

4.結果

4.1 人間の嗜好

CoD抄録が提示するトレードオフをよりよく理解するために、GPT-4のスコアリング評価による嗜好に基づく研究を行った。

| CoDのステップ | 1位得票率(単一アノテーター) | 合計 | ||

|---|---|---|---|---|

| 1 | 3.0 2.0 | 13.0 | 17.4 | 8.3 |

| 2 | 25.0 28.0 | 43.0 | 31.4 | 30.8 |

| 3 | 22.0 28.0 21.0 | 24.4 | 23.0 | |

| 4 | 29.0 25.0 13.0 | 26.7 | 22.5 | |

| 5 | 21.0 17.0 10.0 | 16.3 | 15.5 |

表1:: CoDのステップ別1位得票率まとめ。複合的な選好に基づき、CoDステップは、複数が2、中央値が3、期待値が3.06である。

まず、Fleiss' kappa (Fleiss, 1971)が0.112という低い値であったことから、要約間の微妙な違いや課題の性質が主観的なものであることが示唆される。最近の研究では、GPTに基づく要約を判断する際のインスタンスレベルの一致が低いことも指摘されている(Goyal et al.)

しかし、システムレベルでは、いくつかの傾向が現れ始めている。4人のアノテーターのうち3人については、CoDステップ1が100例中1位の票を最も多く獲得した(それぞれ28%、43%、31.4%)。しかし、合計すると、61%(23.0+22.5+15.5)の1位の要約は、3つ以上の高密度化ステップを含んでいた。望ましいCoDステップ数の中央値は真ん中(3)で、望ましいステップは3.06であった。

表1からわかるように、この密度は手書き抄録(0.151)と一致するが、通常のGPT-4プロンプトを使用して生成された抄録(0.122)よりも有意に高い。

4.2 自動インジケーター

評価者として、GPT-4は人間の判断と十分に一致することが示されており(Fu et al., 2023; Liu et al., 2023a)、アノテーションタスクによってはクラウドソーシングの作業者を上回る可能性さえある(Gilardi et al.)人間による評価を補完するために、GPT-4にCoD要約の情報量、質、一貫性、帰属性、総合性を1~5段階で評価してもらった。情報量、質、帰属性の定義はAharoniら(2023)に、一貫性はFabbriら(2021)による。全体的な目的は、共同品質を把握することである。各次元のスコアを把握するために使用したヒントについては、付録Aを参照のこと。表3は、密度が情報量と相関していることを示しているが、それには限界があり、スコアはステップ4(4.74)でピークに達する。論文のない次元である「質」と「一貫性」は、それぞれステップ2と1の後に低下した。抄録はすべて原著論文に帰属するとみなされた。全体的なスコアは、より緻密で情報量の多い抄録に偏っており、ステップ4で最もスコアが高かった。平均して、CoDステップの最初と最後が最も好まれず、中間の3つのステップは近いスコア(それぞれ4.78、4.77、4.76)であった。

付録Aでは、総合的なメトリクスと人間の判断の最も高いサマリーレベルの相関(ピアソン相関0.31)を報告しているが、全体的な相関は低いままであることに注意されたい-この現象は、サマリーが同程度の品質であったDeutschら(2022)の研究でも観察された。

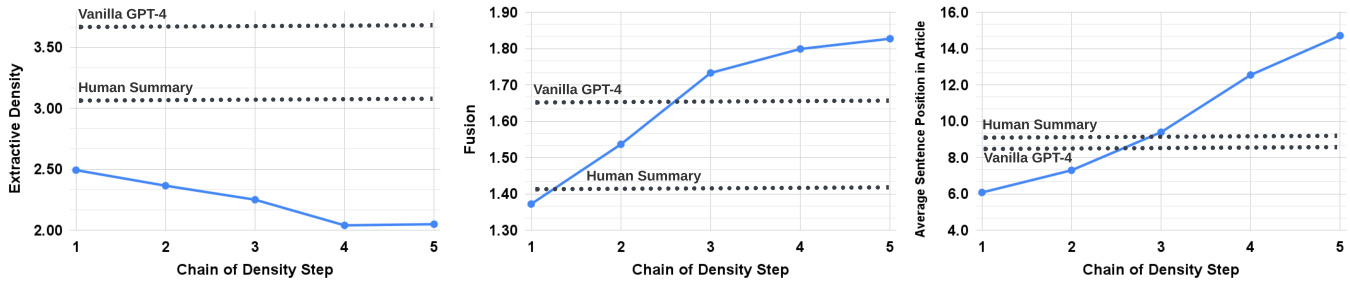

4.3 定性分析

要約の一貫性/読みやすさと、そこに含まれる情報量の間には、明らかなトレードオフがある。これを説明するために、図4では2つのCoDステップを示している。一方の要約はより詳細な情報によって改善され、もう一方は損なわれている。平均して、中間のCoD要約がこのバランスを最もよく達成しているが、このトレードオフを正確に定義し定量化することは今後の研究に任せる。

図4人間に好まれる要約ステップの例(左)と、好まれない要約ステップの例(右)。左の例では、「リバプール」とゴールスコアラーがトピックに関連しているため、一番下の要約が好まれる。2番目の要約は、例えば「試合に戻る可能性のあるルート」を「カウンター攻撃」に合成するなど、賢明な圧縮の余地がある。右側は、"TVMonde "についての詳細を追加しても、エンティティ("Cyber Attack "と "Yves Bigot")のぎこちない融合を補うことはできない。を補うことはできない。

5.関連作品

GPTの概要

Goyalら(2022)は、ニュース記事の要約生成においてGPT-3のベンチマークを行い、人間がGPT-3の要約を、既存の参照ベースと参照なしのメトリクスを反映していない、以前の教師ありのベースラインよりも好むことを発見した。サンプルのGPT-3要約は人間のパフォーマンスと同等であった。

エンティティ・ベースのサマリー

Narayanら(2021)は、キーワード(Li et al., 2020; Dou et al., 2021)や純粋に抽出されたユニット(Dou et al., 2021; Adams et al., 2023a)とは対照的に、要約モデルを教師付きで微調整するための計画ステップとして、エンティティの連鎖を生成することを提案している。エンティティはまた、忠実度を高めるために(Nan et al., 2021; Adams et al;Adams ら、2023b)。

6.結論

我々は、要約の密度が全体的な品質に対する人間の選好に与える影響を調査した。しかし、抄録に含まれるエンティティが多すぎると、読みやすさと一貫性を維持することが難しくなる。固定長で可変密度のアブストラクトのトピックをさらに調査するために、注釈付きのテストセットと注釈なしの大規模なトレーニングセットをオープンソースにしました。

7.制限事項

我々は単一のドメイン、つまりニュースの要約のCoDのみを分析した。アノテーションは高い要約レベルでは一貫性を示さないが、システムレベルの傾向を示し始め、これはLLMベースの評価に関する以前の研究(Goyal et al.)最後に、GPT-4はクローズドソースモデルであるため、モデルの重みを共有することができなかった。しかし、LLAMA-2 のようなオープンソースのモデルで密度を抽出するなど、下流のユースケースのために、すべての評価データ、注釈、注釈のない 5,000 個の CoD を公開しました(Touvron et al.、2023)。

書誌

(参考文献リストは省略)

GPT-4インジケーター

GPT-4のリッカート式評価では、以下のプロンプト・テンプレートを使用します。

摘要: {{摘要}} {{定义}}

以下は、各品質指標に示された定義の例である。

- 情報量:: 情報量の多いアブストラクトは、論文から重要な情報を取り出し、正確かつ簡潔に提示する。

- 質量:: 質の高い要約は理解しやすい。

- 一貫性首尾一貫した抄録はよく構成され、整理されている。

- 帰属要約に含まれるすべての情報は、その記事に完全に帰属しているか。

- 総合的嗜好良いアブストラクトは、簡潔で論理的かつ首尾一貫した方法で論文の主要なアイデアを伝えるべきである。

QualityとCoherenceのキューには、論文のキューは含まれない。これらの定義は、抄録アノテーションに関する過去の研究(Fabbri et al.)

| 次元 | 関連性 |

|---|---|

| 情報量 | 0.215 |

| 質量 | 0.120 |

| 一貫性 | 0.178 |

| 帰属 | 0.245 |

| 傘 | 0.311 |

表2人間の嗜好とGPT-4のリッカートスコアとの相関係数。

メタ評価

要約レベルの相関を計算するために、まず選好データを、その要約が1位票を獲得した回数を示すベクトルに変換した。表4は、当然のことながら、要約全体の評価を把握するように設計されたキューが、全体的な嗜好とのピアソン相関が最も高い(0.31)ことを示しているが、全体的な相関は低いままである。

概要

本論文では、連鎖密度キューイング(CoD)法を用いて、GPT-4がどのように高密度な抄録を生成できるかを検討する。あるレベルの高密度化は抄録の質を向上させるが、高密度化しすぎると可読性と一貫性が損なわれることを発見した。研究チームは、人間の嗜好調査とGPT-4の自動評価によってこの発見を検証し、関連する注釈付きおよび注釈なしの要約データをオープンソース化し、今後の研究のための貴重なリソースを提供した。

要点のまとめ

- 連鎖密度キュー(CoD)長さを増加させることなく、欠落しているエンティティを段階的に追加することで、より密度の高い要約を生成します。

- 物理密度抄録の情報性の尺度としてエンティティ密度を用いると、人間の嗜好は手作業で書かれた抄録の密度に近づくことがわかった。

- 抽象性と統合性CoDは、より抽象的で収束的な、そして始まりのバイアスの少ないアブストラクトを生成する。

- 人間の好み人間は通常のGPT-4要約よりも密度が高いものを好むが、密度が高すぎると可読性が低下する。

- 自動評価GPT-4の自動評価結果は、概ね人間の嗜好と一致していたが、全体的な相関性は低かった。

今後の研究の方向性:

- トレードオフのより正確な定義今後の研究で、情報量と読みやすさのトレードオフをさらに定義し、定量化することができるだろう。

- 多分野への応用: CoD手法を学術論文や技術文書など、他の領域に適用し、その一般性を検証する。

- モデリングの改善: : 高度な情報レベルを維持しつつ、読みやすさを向上させるためにモデルを改善する方法を検討する。

この論文を通して、AIはテキスト処理と生成において目覚ましい進歩を遂げたが、情報内容と読みやすさのバランスという課題に依然として直面していることがわかる。将来、技術が進歩し続ければ、AIが生成するアブストラクトはさらにインテリジェントでユーザーフレンドリーなものになると信じる理由がある。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません