クロード3.7 ソネットとクロード・コード:最先端の推論とエージェント・コーディングの出会い

アンソロピック 同社は本日発表した。 クロード Claude 3.7 Sonnetは、Anthropicの最もスマートなモデルであるだけでなく、市場初のハイブリッド推論モデルでもあります。 年限.

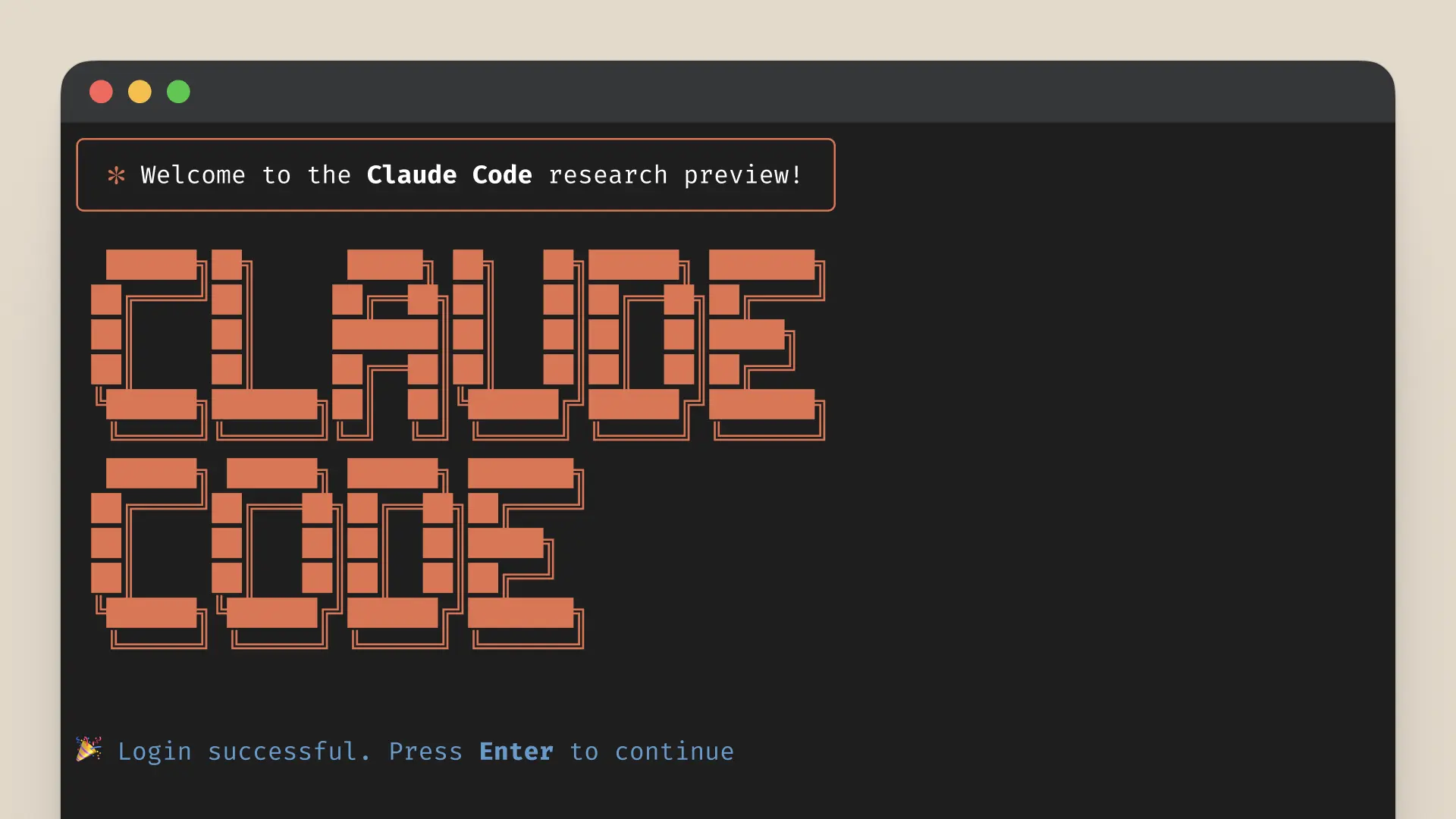

Claude 3.7 Sonnet は、コーディングとフロントエンドのウェブ開発において、特に顕著な改善を示しています。このモデルにはClaude Codeが付属している。Claude Codeはエージェントコーディングのためのコマンドラインツールで、現在は限定的な研究プレビューとして利用可能で、開発者はターミナルから直接Claudeに幅広いエンジニアリングタスクを任せることができる。

Claude 3.7 Sonnetは、すべてのClaudeプラン(Free、Pro、Team、Enterpriseを含む)、およびAnthropic API、Amazon Bedrock、Google Cloud Vertex AIでサポートされるようになりました。拡張思考モードは、Claudeの無料版を除くすべてのプラットフォームで利用可能です。拡張思考モードは、クロードの無料版を除くすべてのプラットフォームで利用可能です。

クロード3.7ソネットの価格は、標準および拡張思考モードの両方で、100万入力あたりという前モデルと同じです。 トークン アウトプット・トークン100万枚につき3ドル、シンキング・トークンを含むアウトプット・トークン100万枚につき15ドル。

クロード3.7 ソネット:最先端の推理が実用化される

Anthropicは、他の推論モデルとは異なる哲学でClaude 3.7 Sonnetを開発しました。人間が同じ脳を使って素早く反応したり、深く考えたりするように、Anthropicは推論が完全に独立したモデルではなく、最先端モデルの本質的に統合された機能であるべきだと考えています。また、この統一されたアプローチは、ユーザーにとってよりスムーズな体験を生み出します。

クロード3.7ソネットは、いくつかの方法でこのアイデアを具現化している。まず、Claude 3.7 Sonnetは、通常のLLMと推論モデルを組み合わせたものである。標準モードでは、モデルが素早く応答するときと、回答する前に長く考えるときをユーザーが選択できる。標準モードでは、クロード3.7ソネットはクロード3.5ソネットのアップグレード版である。拡張思考モードでは、モデルは答える前に自分自身を振り返り、数学、物理学、コマンドフォロー、コーディング、その他多くのタスクのパフォーマンスを向上させます。Anthropicは、モデルがどちらのモードでもほぼ同じようにプロンプトを表示することを発見しました。

第二に、APIを介してクロード3.7ソネットを使用する場合、ユーザーはまた、以下のように考えることをコントロールできる。 予算ユーザーは Claude に最大 N 個のトークンを考えるように指示することができ、N の値は最大 128K 個のトークンの出力制限に設定することができます。このため、ユーザーは必要に応じてスピード(とコスト)と答えの質を柔軟にトレードオフできる。

第三に、推論モデルの開発中、Anthropicは、最適化方向への数学とコンピュータサイエンスの競技トピックへのフォーカスを若干減らし、その代わりに、ビジネスユーザーがLLMを実際にどのように使用するかをより反映させるために、実世界のアプリケーションシナリオによりフォーカスした。

Cursorは、Claudeが複雑なコードベースから高度なツーリングまでの領域で大幅に改善され、実世界のコーディングタスクで再びリーダーであることを指摘し、Cognitionは、Claudeがコード変更の計画とフルスタック更新の処理に関して他のどのモデルよりも優れていることを発見しています。Vercelは、複雑なエージェントワークフローにおけるClaudeの優れた精度を強調しています。 リプリット 他のモデルでは実現が難しい、複雑なウェブアプリケーションやダッシュボードをゼロから構築するためにClaudeを導入することに成功したCanvaの評価では、Claudeは一貫して、より優れた設計であるだけでなく、バグを劇的に削減した、本番で使用可能なコードを生成することが示されました。

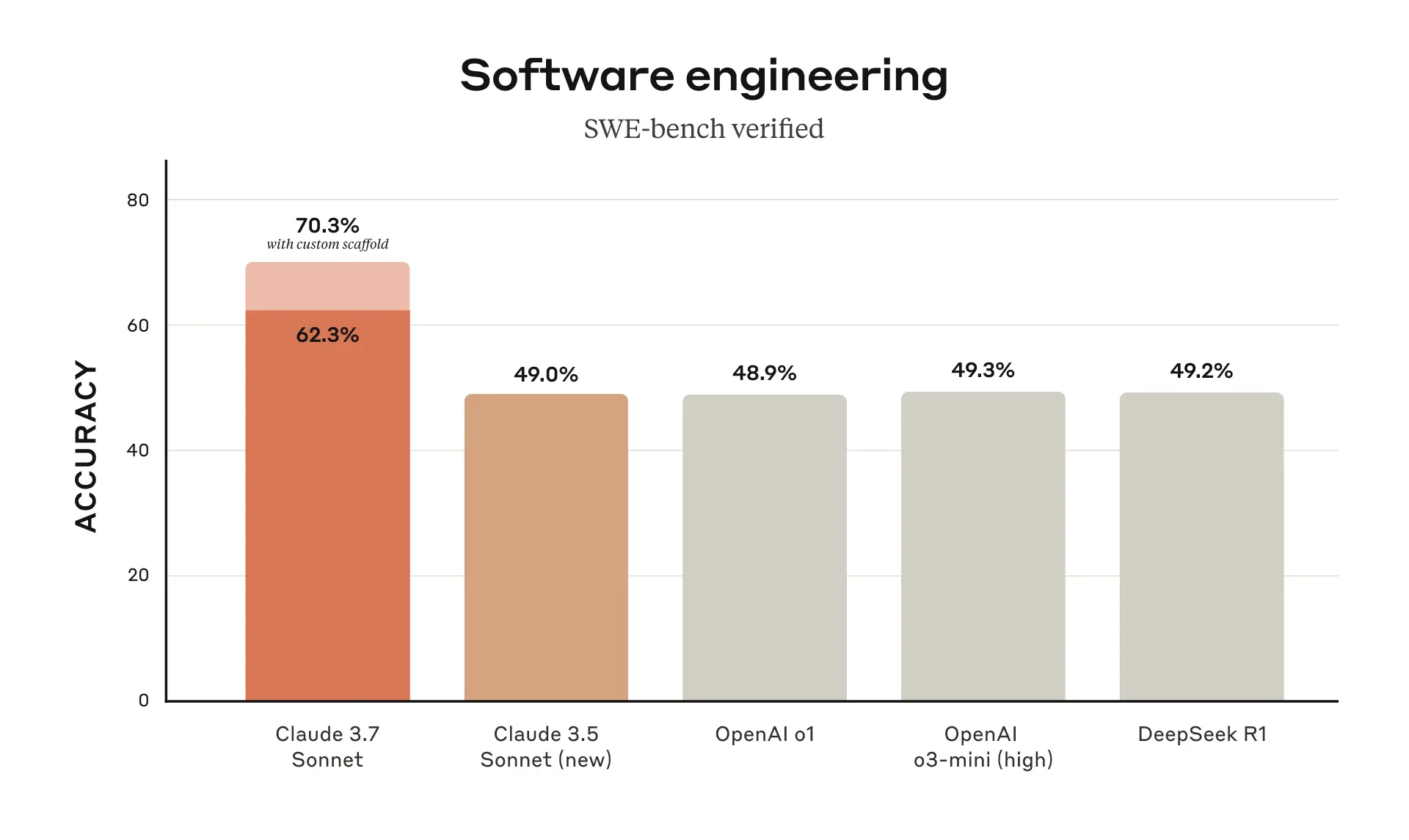

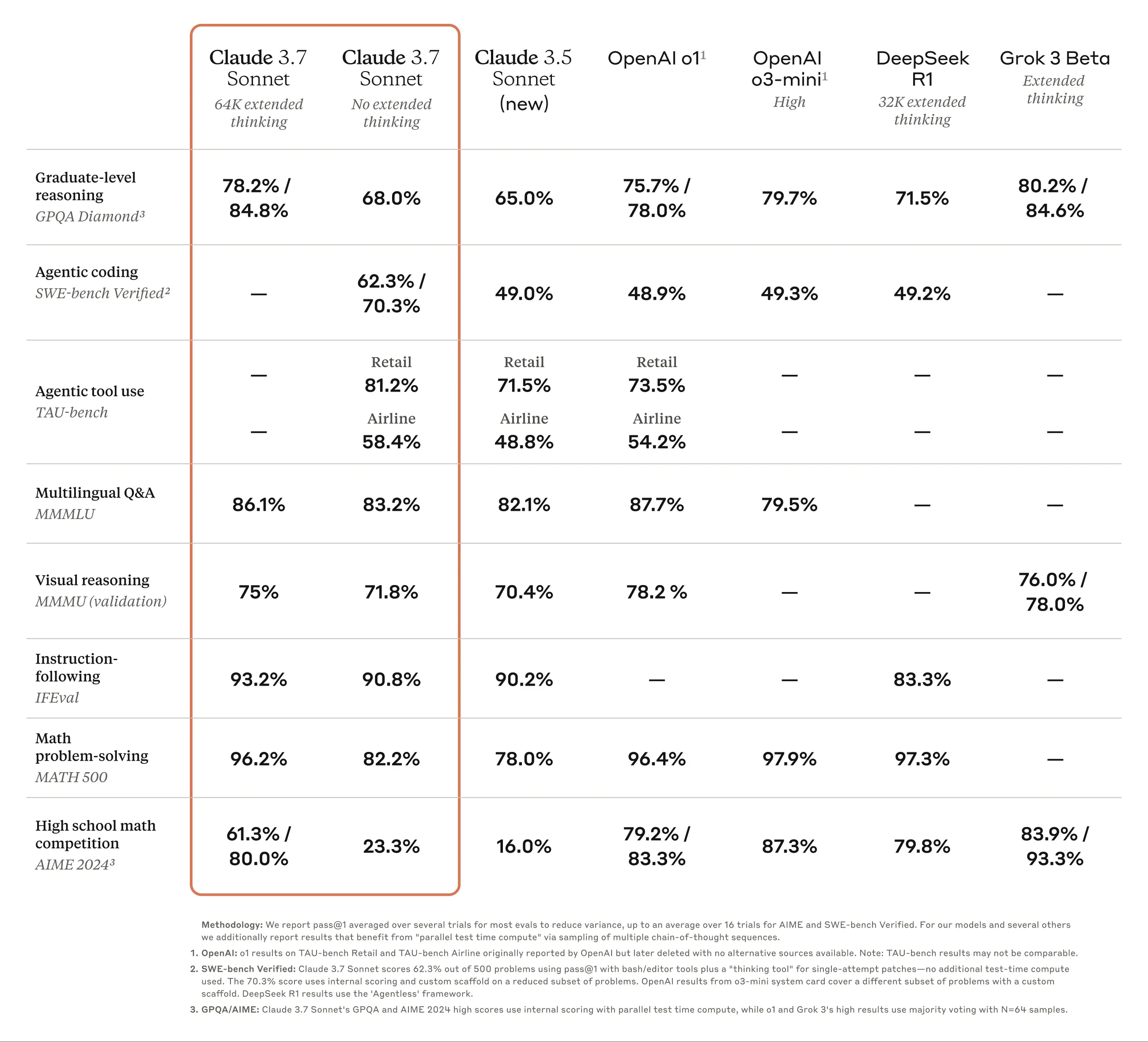

Claude 3.7 Sonnetは、実際のソフトウェア問題を解決するAIモデルの能力を測定するベンチマ ークであるSWE-bench Verifiedで最高のパフォーマンスを達成した。スキャフォールディングの詳細については、付録を参照。

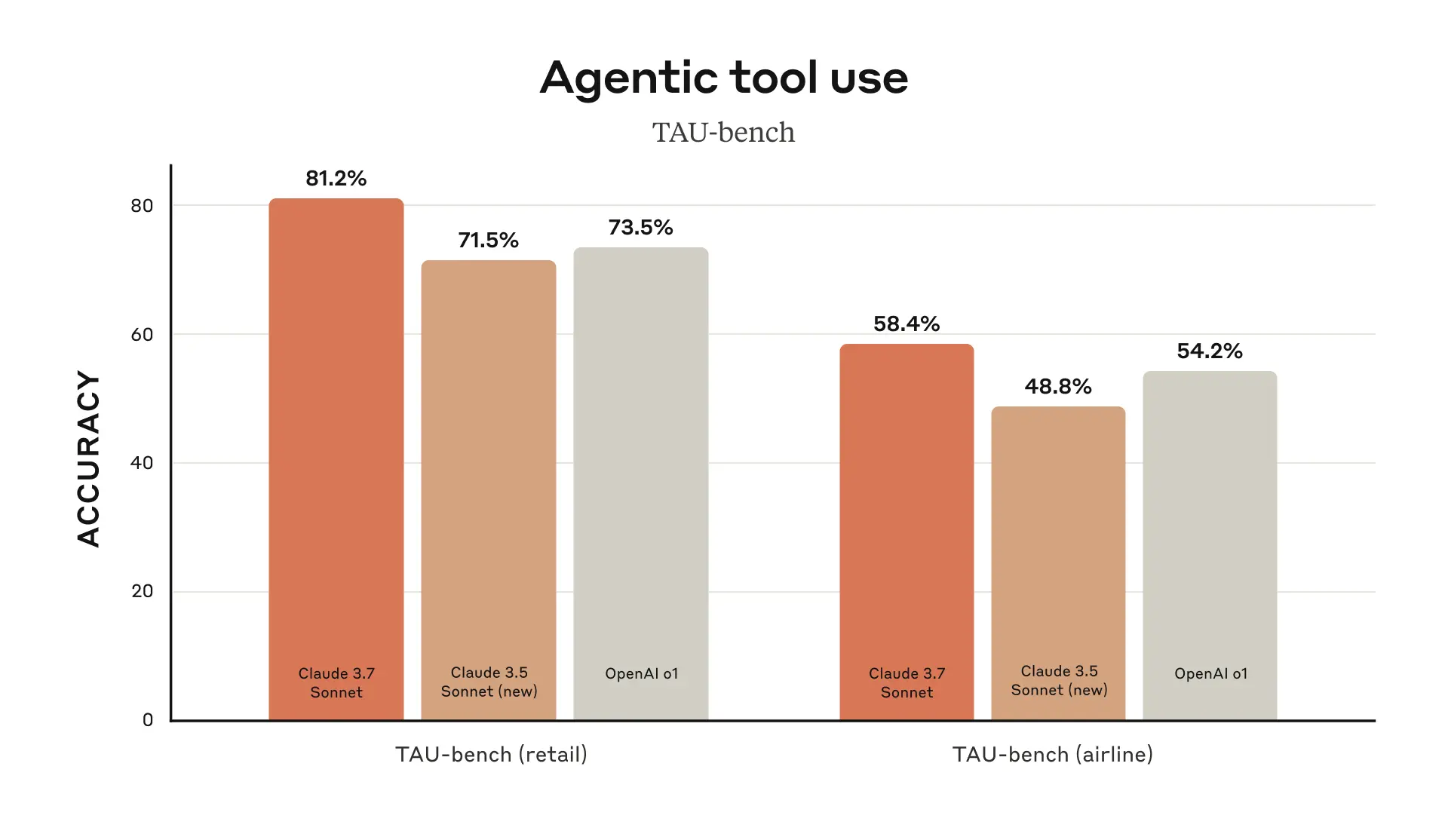

Claude 3.7 Sonnetは、TAU-bench(ユーザーとツールのインタラクションを含む複雑な実世界タスクにおけるAIエージェントのパフォーマンスをテストするためのフレームワーク)で最高のパフォーマンスを達成した。スキャフォールディングの詳細については、付録を参照。

クロード3.7ソネットは、命令追従、一般化推論、マルチモーダル能力、エージェント的エンコーディングに優れており、拡張思考モードは数学と科学のパフォーマンスを大幅に向上させる。従来のベンチマークに加え、クロード3.7ソネットはポケモンゲームのテストでも、これまでのすべてのモデルを凌駕しています。

クロード・コード:開発者のための新しいアシスタント

2024年6月以来、ソネットは世界中の開発者に選ばれているモデルです。現在、Anthropicは限定研究プレビュー版で利用可能です。 クロード・コード -- Anthropic初のエージェント型コーディングツールで、開発者をさらに強化。

Claude Codeは、コードの検索と読み込み、ファイルの編集、テストの記述と実行、コードのコミットとGitHubへのプッシュ、コマンドラインツールの使用など、すべてのステップでユーザーに情報を提供するアクティブな共同作業者です。

Claude Codeはまだ初期段階ですが、特にテスト駆動開発、複雑な問題のデバッグ、大規模なリファクタリングにおいて、Anthropicチームにとって欠かせないツールとなっています。初期のテストでは、Claude Codeは通常手作業で45分以上かかる作業を1回の操作で行うことができ、開発時間と管理コストを大幅に削減することができました。

今後数週間で、Anthropicは、ツール呼び出しの信頼性の向上、長時間実行コマンドのサポートの追加、アプリ内レンダリングの改善、クロード自身の能力理解の強化など、ユーザーの使用状況に基づいて継続的な改善を行う予定です。

AnthropicがClaude Codeを立ち上げる目的は、開発者がどのようにClaudeを使ってコーディングしているかをよりよく理解し、将来のモデルの改良に役立てることです。このプレビューに参加することで、ユーザーはAnthropicがClaudeの構築と改良に使用しているのと同じ強力なツールにアクセスできるようになり、ユーザーからのフィードバックは将来の開発に直接影響することになります。

コードベースでクロードと働く

Anthropicはまた、Claude.aiでのコーディングエクスペリエンスを改善し、AnthropicのGitHub統合がすべてのClaudeプランで利用可能になりました。

Claude 3.7 Sonnetは、Anthropicのこれまでで最高のコーディングモデルです。ユーザーの個人、仕事、オープンソースプロジェクトをより深く理解することで、バグ修正、新機能開発、最も重要なGitHubプロジェクトのドキュメント構築のための、より強力なパートナーとなります。

責任ある建設

Anthropicは、Claude 3.7 Sonnetの大規模なテストと評価を実施し、セキュリティ、信頼性、安全性に関するAnthropicの基準を満たしていることを確認するために、外部の専門家と協力しました。また、Claude 3.7 Sonnetは、前作よりも有害なリクエストと良性のリクエストを区別するニュアンスが向上しており、不必要な拒否が45%少なくなっています。

このバージョンのシステムカードは、複数のカテゴリーにわたる最新のセキュリティ調査結果をカバーし、他のAI研究所や研究者が自身の研究に適用できる、Anthropicの責任ある拡張ポリシー評価の詳細を説明しています。システムカードはまた、コンピュータの使用によってもたらされる新たなリスク、特にプロンプトインジェクション攻撃について説明し、Anthropicがどのようにこれらの脆弱性を評価し、クロードがそれらに抵抗し、軽減するように訓練しているかについて説明しています。さらに、システムカードでは、推論モデルがもたらす潜在的なセキュリティ上の利点、すなわち、モデルがどのように意思決定を行うかを理解する能力、モデルの推論が本当に信頼できるものであるかどうかを検証しています。詳しくはシステムカードをお読みください。

首を長くして

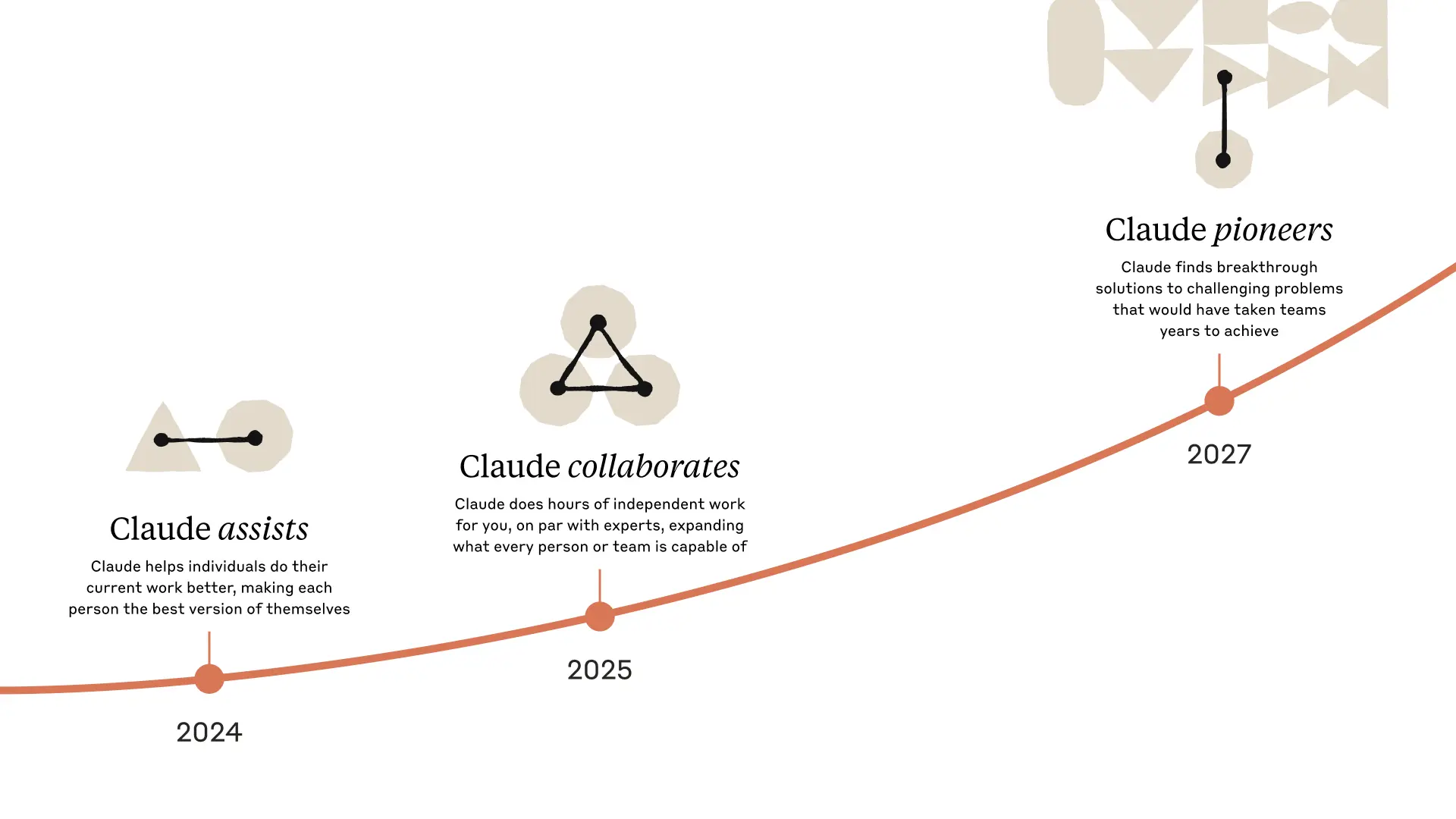

クロード3.7ソネットとクロード・コードのリリースは、AIシステムで人間に真の力を与えるための重要な一歩です。深い推論、自律的な作業、効果的なコラボレーションの能力によって、AIが人間の功績を豊かにし、拡張する未来へと私たちを導いてくれます。

Anthropicは、ユーザーの皆様がこれらの新機能を探求することを楽しみにしており、ユーザーの皆様がどのようなものを作成されるかを楽しみにしています。Anthropicは、Anthropicのモデルを改善し、開発し続けることができるように、ユーザーの皆様からの[フィードバック](mailto: feedback@anthropic.com)を常に歓迎しています。

付記

^1 ^ ネーミングのレッスン

データソースの評価

TAUベンチ

足場に関する情報

このスコアは、クロードに「プランニング」ツールをより良く利用するよう指示するプロンプトの付録を「エアラインエージェントポリシー」に追加することによって得られた。このモードでは、Anthropicの通常の思考モードとは異なり、推論スキルを十分に活用するために、問題解決における複数回の対話の間に思考プロセスを書き留めるようモデルを促します。より多くの思考ステップを使用することによるクロードの追加トークン消費に対応するため、Anthropicは最大ステップ数(モデル完成数)を30から100に増やしました(ほとんどの対話は30ステップ以内に完了し、50ステップを超えた対話は1つだけでした)。

さらに、Claude 3.5 Sonnet(新)のTAUベンチスコアは、Anthropicがオリジナルリリース時に報告したものと異なっています。これは、AnthropicがClaude 3.7 Sonnetとより正確に比較するために、更新されたデータセットでテストを再実行したためです。より正確にクロード3.7ソネットと比較するために。

SWEベンチ検証済み

足場に関する情報

SWE-benchのようなオープンエンドなエージェントタスクを解決するためには、多くのアプローチがあります。いくつかのアプローチは、複雑さ(例えば、どのファイルを調査または編集するか、どのテストを実行するかを決定すること)の多くを、より伝統的なソフトウェアにシフトさせる。 ディープシーク R1 Aideや他のモデルの評価で一般的に使用されているフレームワークで、プロンプトや埋め込み文書検索メカニズム、パッチローカライゼーション、回帰テストのためのベストオブ40リジェクトサンプリングなどを用いてエージェントの能力を強化します。他の足場(例えばAide)は、リトライ、ベストオブN、モンテカルロツリー探索(MCTS)の形でテスト時間の計算を追加してモデルをさらに増強する。

Claude 3.7 SonnetとClaude 3.5 Sonnet(新)では、Anthropicは最小限の足場を使ったよりシンプルなアプローチを採用しています。このアプローチでは、単一のセッションで実行するコマンドと編集するファイルをモデルが決定します。Anthropicの主な「拡張思考なし」のpass@1の結果は、ここで説明した2つのツール(bashユーティリティと文字列置換で動作するファイル編集ツール)をモデルに装備するだけです。- Anthropicの主な "拡張思考なし "のpass@1の結果は、ここで説明した2つのツール-bashユーティリティと文字列置換で動作するファイル編集ツール-と、AnthropicがTAU-benchの結果で言及した "計画ツール"-をモデルに装備するだけである。インフラストラクチャの制限により、Anthropic社内のインフラストラクチャで実際に解くことができたのは489/500の問題だけでした(つまり、ゴールドソリューションはテストに合格しました)。バニラのpass@1スコアでは、Anthropicは公式リーダーボードに合わせるため、11の解けなかった問題を失敗としてカウントしました。透明性のために、AnthropicはAnthropicのインフラストラクチャ上で動作しなかったテストケースを別途公開しています。

ハイ・コンピュート・ナンバー」に対して、Anthropicは、以下に示すように、さらなる複雑さと並列テスト時間計算を使用する:

- 人類は、上記の足場を使って複数の並行試行を行う。

- Anthropicは、Agentlessで使用されている拒絶サンプリング手法と同様に、リポジトリ内の目に見えるリグレッションテストを破損するパッチを破棄します。

- Anthropicは、研究論文に記載されているAnthropicのGPQAとAIMEの結果に類似したスコアリングモデルを使用して残りの試みをランク付けし、提出するための最良の試みを選択しました。

これにより、Anthropicのインフラストラクチャ上で動作するn=489の検証済みタスクのサブセットで70.3%のスコアが得られました。この足場がない場合、Claude 3.7 Sonnetは同じサブセットを使って検証されたSWE-benchで63.7%のスコアを達成しました。Anthropicの内部インフラストラクチャが対応していない11のテストケースを以下に示します:

- scikit-learn__scikit-learn-14710

- django__django-10097

- psf__requests-2317

- sphinx-doc__sphinx-10435

- sphinx-doc__sphinx-7985

- sphinx-doc__sphinx-8475

- matplotlib__matplotlib-20488

- astropy__astropy-8707

- astropy__astropy-8872

- sphinx-doc__sphinx-8595

- sphinx-doc__sphinx-9711

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません