残念ながら、DeepSeek-R1と同時にリリースされたKimi k1.5のテクニカルレポートでは、長いコンテキストとマルチモーダル推論が改善されています。

キミk1.5 テクニカルレポート 速報

1.強力なマルチモーダル推理

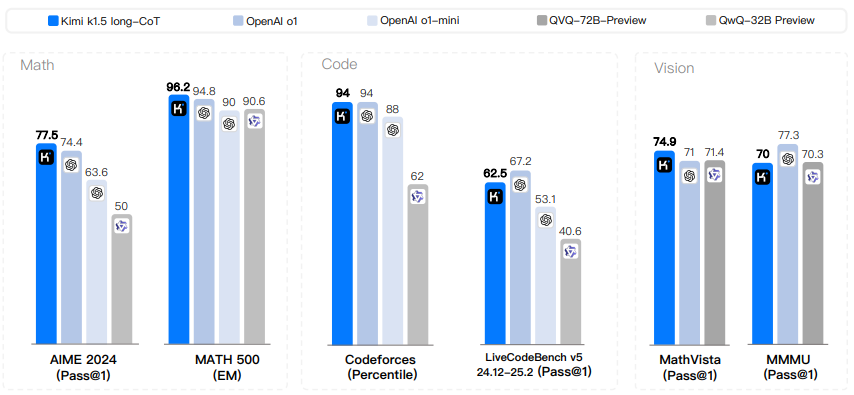

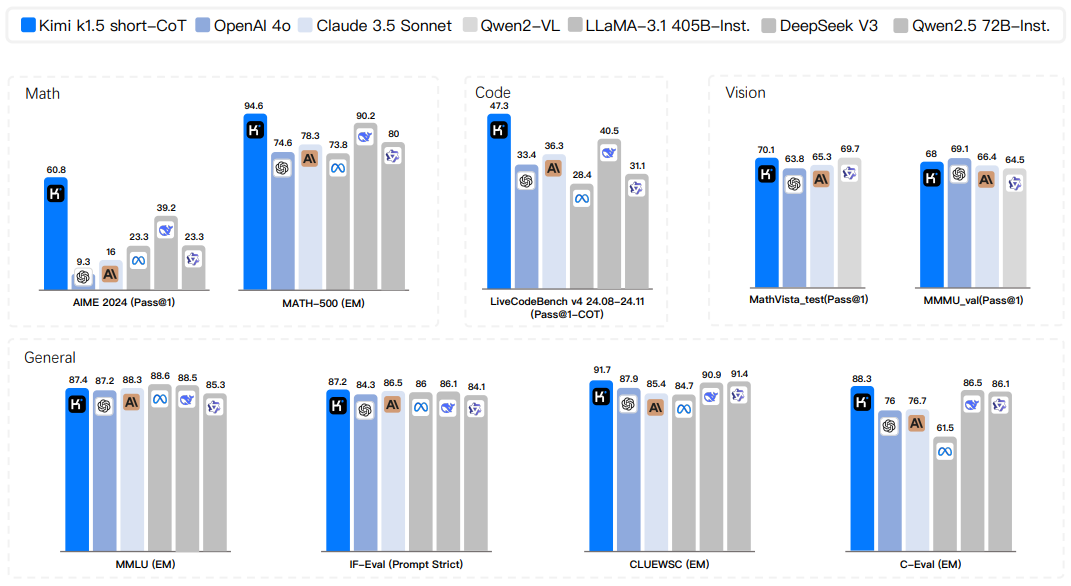

キミ k1.5モデルは、数学、コード、テキスト、視覚推論タスクを含む複数のベンチマークとモダリティにおいて、最先端の推論性能を達成した。

プレーンテキストを扱うだけでなく、画像とテキストの組み合わせも理解し、真のマルチモーダル推論を可能にする。

ロングCoTバージョンとショートCoTバージョンの両方が、強力なパフォーマンスを示している。

AIME、MATH500、Codeforcesなどのデータセットでリーダーシップを発揮している。

また、MathVistaのようなビジュアルベンチマークでも高いパフォーマンスを発揮する。

2.長いコンテクストのRLトレーニングにおけるブレークスルー:

コンテキストウィンドウを128kに拡大することで、モデルの性能は向上し続け、コンテキストの長さが強化学習のスケーリングにとって重要な次元であることが検証された。

- 部分的ロールアウト技法を用いることで、長文脈RLの学習効率を大幅に改善し、より長く複雑な推論プロセスの学習が可能になる。

- 複雑な問題を解決するためには、長いコンテクストが重要であることが実証された。

3.有効なlong2shortメソッド:

- ロングコンテキストモデルの知識を活用し、ショートコンテキストモデルのパフォーマンスを向上させる効果的なロング2ショート法が提案されている。 トークン 効率が良い。

- 短いモデルの性能向上は、モデルのマージ、最短棄却サンプリング、DPOなどの技術によって達成され、短いモデルを直接訓練するよりも効率的である。

長いCoTモデルの思考に関する事前知識を移行することで、短いモデルのパフォーマンスを改善できることが実証された。

4.最適化されたRLトレーニングフレームワーク:

複雑な技術に頼ることなくロバストな性能を達成するために、改良されたポリシー最適化手法が提案されている。

RL学習の効率と効果を改善するために、複数のサンプリング戦略、長さペナルティ、データレシピの最適化が検討されている。

提案された方法論とトレーニング技術の有効性は、アブレーション研究によって検証された。

5.詳細なトレーニングプロセスとシステム設計:

- キミk1.5の詳細なトレーニングレシピが公開され、事前トレーニング、微調整、集中的な学習段階が含まれている。

- 学習と推論時のリソース利用を最適化するためのハイブリッド展開戦略を示す。

- トレーニングデータの品質を保証するためのデータパイプラインと品質管理メカニズムについて詳しく説明する。

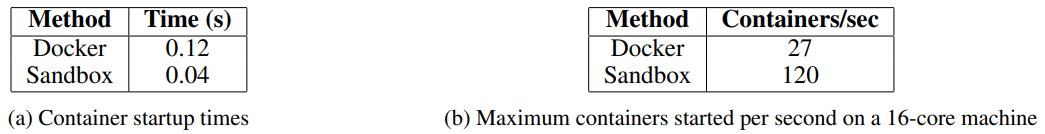

- 生成されたコードの実行と評価のためのセキュアコードサンドボックスを開発。

6.モデルのサイズとコンテキストの長さの探索:

モデルのサイズとコンテキストの長さが性能に及ぼす影響を調査した結果、大きなモデルの方が性能は良いが、より長いコンテキストを使用した小さなモデルは、大きなモデルの性能に近づくか、あるいはそれに匹敵することさえあり、RL訓練によってモデルの性能が向上することが示された。

抄録

次のトークン予測を使用した言語モデルの事前学習は、効果的に計算量を拡張できることが示されているが、利用可能な学習データの量によって制限されている。拡張強化学習(RL)は、AIにおける継続的な改善のための新しい次元を切り開き、報酬を探索する学習によって大規模言語モデル(LLM)の訓練データを拡張することを約束する。しかし、これまでに発表された研究は、競争力のある結果を生み出していない。これを踏まえ、RLを用いて学習した最新のマルチモーダルLLMであるKimi k1.5のRL学習手法、マルチモーダルデータ定式化、インフラ最適化などの学習実践について報告する。モンテカルロ木探索、価値関数、プロセス報酬モデルなどの複雑な技術に頼ることなく、シンプルで効果的なRLフレームワークを確立しています。注目すべきことに、我々のシステムは、複数のベンチマークとモダリティにおいて最先端の推論性能を達成している。例えば、AIMEで77.5、MATH500で96.2、Codeforcesで94パーセンタイル、MathVistaでMathVistaで74.9、OpenAIの01と一致。さらに、我々は、short-CoTモデルを改善するためにlong-CoTテクニックを使用する効果的なlong2shortメソッドを提示し、最先端のshort-CoT推論結果(例えば、AIMEで60.8、MATH500で94.6、LiveCodeBenchで47.9)を生成します。LiveCodeBenchでは47.3であり、GPT-40や クロード ソネット3.5(+550%まで)。

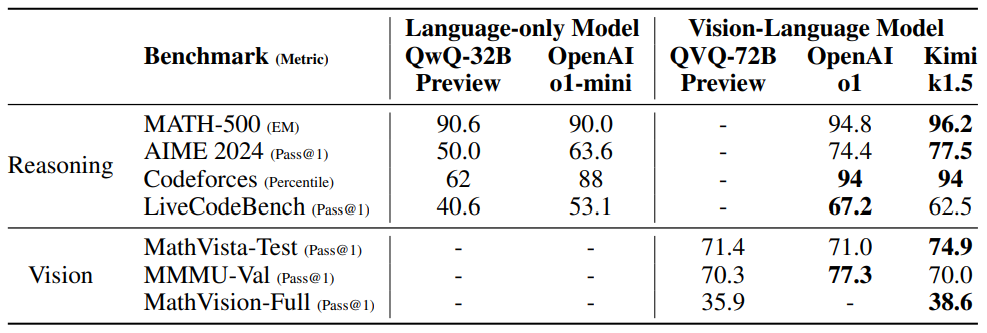

図1:Kimi k1.5 long-CoTの結果。

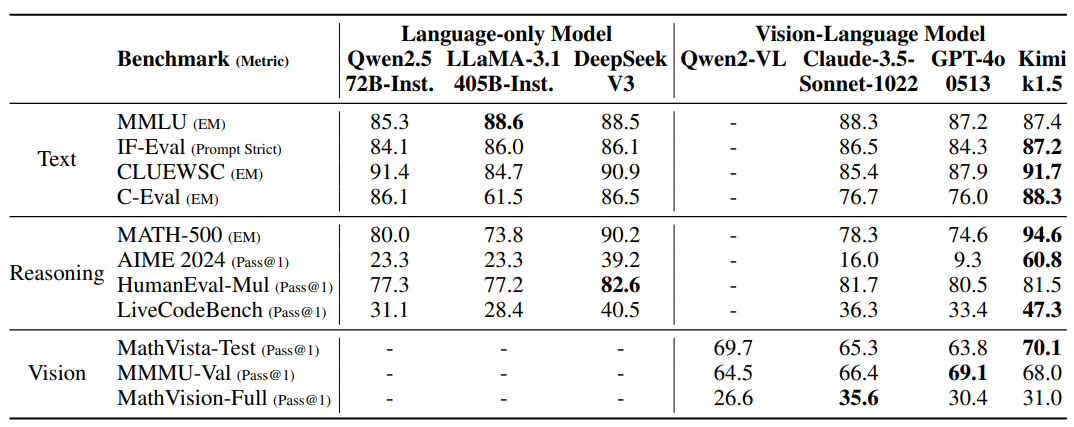

図2:キミk1.5ショートCoTの結果。

1 はじめに

次のトークン予測を使用した言語モデルの事前学習は、モデルパラメータとデータサイズをスケーリングすることで、継続的な知能の向上をもたらす拡張のレンマの文脈で研究されてきた(Kaplan et al.(Kaplan et al. 2020; Hoffmann et al. 2022) しかしながら、このアプローチは利用可能な高品質な学習データの量によって制限される。(本レポートでは、強化学習(RL)を用いて訓練した最新のマルチモーダルLLMであるKimi k1.5の訓練レシピを紹介する。LLMとRLを用いることで、モデルは報酬を探索するように学習するため、既存の静的データセットに制限されない。

k1.5のデザインとトレーニングに関しては、いくつかの重要な要素がある。

- ロングコンテキストエクステンションRLのコンテキストウィンドウを128kまで拡張し、コンテキスト長が長くなるにつれて性能が向上することを確認しました。すなわち、新しい軌跡をサンプリングするために過去の軌跡の大部分を再利用することにより、新しい軌跡をゼロから生成し直すコストを回避する。我々の観察から、コンテキストの長さはLLMにおけるRLの連続的なスケーリングにとって重要な次元であることが示唆される。

- 戦略最適化の改善RLの定式化をlong-CoTを用いて導出し、ロバストな戦略最適化のためにオンラインミラー降下の変形を用いる。このアルゴリズムは、効率的なサンプリング戦略、長さペナルティ、データ定式化の最適化によってさらに改善される。

- 簡易フレームワーク長いコンテキストの拡張と改善されたポリシーの最適化手法の組み合わせにより、LLMを用いた学習のための簡素化されたRLフレームワークが構築される。コンテキストの長さを拡張できるため、学習されたCoTは計画、反射、修正の特性を示す。コンテキストの長さを長くすることで、探索ステップ数が増加する。その結果、より洗練された技術(モンテカルロ木探索、価値関数、プロセス報酬モデルなど)に頼ることなく、ロバストな性能を達成できることを示す。

- 多峰性私たちのモデルは、テキストとビジュアルのデータを使って共同で訓練されているため、両方のモダリティについて共同で推論することができます。

さらに、ロングCoT技術を用いてショートCoTモデルを改善する、効果的なロング2ショートアプローチを提案する。具体的には、我々のアプローチは、long-CoTの活性化とモデルの併合を伴う長さペナルティの適用から構成される。

例えば、AIMEで77.5、MATH500で96.2、Codeforcesで94パーセンタイル、MathVistaで74.9、OpenAIの01と一致。MathVistaで74.9、OpenAIの01と一致。また、我々のモデルは、AIMEで60.8、MATH500で94.6、LiveCodeBenchで47.3といった最先端のshort-CoT推論結果も達成しており、以下のような既存のshort-CoTモデルを大幅に凌駕しています。GPT-40やClaude Sonnet 3.5(+550%まで)などの既存のショートCoTモデルを大幅に凌駕しています。結果を図1と2に示す。

2 方法:LLMを用いた強化学習

キミk1.5の開発には、事前学習、バニラ教師付き微調整(SFT)、Long-CoT教師付き微調整、強化学習(RL)といういくつかの段階があった。本レポートでは、RLに焦点を当て、RLのキューセット管理(セクション2.1)とlong-CoT教師付き微調整(セクション2.2)の概要から始め、セクション2.3ではRLのトレーニング戦略について詳しく説明する。事前訓練とバニラ教師付き微調整に関するより詳細な情報はセクション2.5にある。

2.1 RLキューセットの管理

我々の予備実験を通して、RLキューセットの質と多様性が強化学習の有効性を確保する上で重要な役割を果たすことが分かった。慎重に構築された手がかりセットは、モデルを頑健な推論に導くだけでなく、報酬攻撃や表面パターンの過剰適合のリスクを軽減する。具体的には、3つの重要な特性が高品質なRL手がかり集合を定義する:

- 多様なカバレッジヒント : ヒントは、モデルの適応性を高め、さまざまな領域で幅広く適用できるようにするため、STEM、コーディング、一般的な推論など、さまざまな分野をカバーする必要があります。

- バランスの取れた難易度漸進的な学習を促進し、特定の複雑さレベルへの過剰適合を防ぐために、プロンプトセットには、簡単な問題、中程度の問題、難しい問題を均等に配分する必要があります。

- 正確な評価可能性: : ヒントは、モデルの性能が表面的なパターンやランダムな推測ではなく、健全な推論に基づいて測定されることを保証するために、バリデータによる客観的で信頼性の高い評価を可能にするものでなければならない。

キューセットの多様なカバレッジを達成するために、豊富な推論を必要とし、評価しやすい問題を選択するために自動フィルタを使用します。我々のデータセットには、STEM領域、競技、一般的な推論タスクなど様々な領域からの問題が含まれており、プレーンテキストと画像テキストのクイズデータの両方が含まれている。さらに、異なるトピック領域をバランスよく表現するために、プロンプトをドメインと分野別に分類するラベリングシステムを開発しました (M. Li et al. 2023; W. Liu et al. 2023)。

各プロンプトの難易度を適応的に評価するモデル自身の能力を利用する、モデルベースのアプローチを使用した。具体的には、各プロンプトに対して、SFTモデルが比較的高いサンプリング温度で10個の回答を生成する。その後、合格率が計算され、キューの難易度の代用として使用される(合格率が低いほど難易度が高い)。このアプローチにより、難易度評価をモデルの本質的な能力に合わせることができ、RLトレーニングにおいて非常に効果的となる。このアプローチを利用することで、ほとんどの些細なケースを事前に選別することができ、RLトレーニング中に異なるサンプリング戦略を容易に探索することができる。

潜在的な報酬攻撃(Everitt et al. 2021; Pan et al. 2022)を避けるために、各キューの推論プロセスと最終的な答えを正確に検証できるようにする必要がある。経験的な観察によると、複雑な推論問題の中には、比較的単純で推測しやすい答えを持つものがあり、モデルが誤った推論プロセスを経て正しい答えに到達するという、偽の前方検証を引き起こす可能性がある。この問題に対処するために、多肢選択問題、真偽問題、証明問題など、このようなエラーが発生しやすい問題を除外します。さらに、一般的な質問-回答タスクに対して、攻撃されやすいヒントを特定し除去する、シンプルで効果的な方法を提案する。具体的には、CoT推論ステップなしで、モデルに可能性のある答えを推測させる。モデルがN回の試行で正解を予測した場合、そのヒントは攻撃されやすいと判断され削除される。我々は、N = 8に設定することで、攻撃しやすいヒントがほとんど削除されることを発見した。より高度な検証モデルを開発することは、今後の研究の方向性として残されている。

2.2 Long-CoTの教師付き微調整

改良されたRLキューセットを用いて、キューエンジニアリングを採用し、テキスト入力と画像入力に対して正確に検証された推論パスを含む、小さいが高品質なlong-CoTウォームアップデータセットを構築する。このアプローチはリジェクションサンプリング(RS)と似ているが、キューエンジニアリングによって長いCoT推論パスを生成することに重点を置いている。結果として得られるウォームアップデータセットは、プランニング(モデルが実行前のステップを体系的に概説する)、評価(中間ステップの批判的評価を含む)、リフレクション(モデルがアプローチを再考し改善することを可能にする)、探索(代替ソリューションの検討を促す)など、ヒューマノイドの推論に不可欠な主要な認知プロセスをカプセル化するように設計されています。このウォームアップデータセットに対して軽量SFTを実行することで、モデルがこれらの推論戦略を内面化するように効果的に導くことができる。その結果、ファインチューニングされたlong-CoTモデルは、より詳細で論理的に首尾一貫した応答を生成する能力が向上し、様々な推論タスクにおける性能が向上する。

2.3 学習の強化

2.3.1 問題設定

訓練データセットD = {(xi, yi)}^n_i=1には、質問xiとそれに対応する真の答えyが含まれている。i、我々の目標は、テスト問題を正確に解くために戦略モデルπθを訓練することである。複雑な推論コンテキストでは、問題xから解決策yへのマッピングは簡単なタスクではありません。この課題に対処するため、チェーン・オブ・シンキング(CoT)アプローチは、一連の中間ステップz = (z1, z2, ... , zm)を使用することを提案する。ziは問題解決における重要な中間ステップとなるトークンの一貫したシーケンスである (J. Wei et al., 2022)。問題xを解く際、自己回帰サンプリング・マインドzt ~ πθ(-|x, z1, ... , zt-1)を実行し、次にzt-1を実行する。zt-1)をサンプリングし、最終的な答えy ~ πθ(-|x, z1,... , zm)をサンプリングする。zm)をサンプリングする。このサンプリング・プロセスを表すために、y, z ~ πθを使用する。思考と最終的な答えの両方が言語シーケンスとしてサンプリングされることに注意。

モデルの推論能力をさらに高めるために、推論時に改善されたCoTを生成するために、様々な思考プロセスを探索する計画アルゴリズムを採用する(Yao et al.)これらのアプローチの中心的な洞察は、値の推定によって導かれる思考探索木を明示的に構築することである。これによって、モデルは思考プロセスの様々な継続を探索したり、行き詰まったときにバックトラックして新しい方向を探索したりすることができる。より詳細には、各ノードが部分解s = (x, z1:|s|)を表す探索木をTとする。ここでsは問題xと、それを導く一連の思考z1:|s| = (z1, ... , z|s|)からなる。ここで、|s|はシーケンス中の思考の数を表す。計画アルゴリズムは批評モデルvを用いてフィードバックv(x, z1:|s|)を提供し、問題解決における現在の進捗を評価し、既存の部分解におけるエラーを特定するのに役立つ。フィードバックは、判別スコアか言語系列によって提供されることに注意する(L. Zhang et al. 2024)。すべてのs∈Tからのフィードバックに導かれて、計画アルゴリズムは、最も拡張しそうなノードを選択することで、探索木を拡張する。上記のプロセスは、完全な解が導出されるまで繰り返し実行される。

また、アルゴリズムの観点から計画アルゴリズムにアプローチすることもできる。t回目の反復で利用可能な過去の探索履歴(s1, v(s1), ...st-1, ..., v(st-1))が与えられると、計画アルゴリズムAは次の探索方向A(st|s1, v(s1), ...)を繰り返し決定し、フィードバックを与える。, st-1, v(st-1))を決定し、現在の探索進行状況A(v(st)|s1, v(s1), ... , st).st)でフィードバックを提供する。思考もフィードバックも中間推論ステップと考えることができ、これらの構成 要素は言語トークン列として表現できるので、表現を簡単にするために、 sとvの代わりにzを使う。したがって、我々は計画アルゴリズムを、推論ステップA(-|z1, z2, ...)のシーケンスに直接作用するとみなす。 )を、一連の推論ステップA(-|z1, z2, ... )の写像とみなす。このフレームワークでは、計画アルゴリズムが使用する探索木に格納されたすべての情報は、アルゴリズムに提供される完全なコンテキストに広がる。これは、高品質のCoTを生成するための興味深い視点を提供する:探索木を明示的に構築し、計画アルゴリズムを実装する代わりに、このプロセスを近似するモデルを訓練することができる。ここで、思考量(すなわち言語トークン)は、従来プランニングアルゴリズムに割り当てられていた計算予算と類似している。長いコンテキストウィンドウの最近の進歩は、訓練とテストの段階でのシームレスなスケーラビリティを促進する。実現可能であれば、このアプローチにより、モデルは自己回帰予測を介して推論空間上で直接暗黙的な探索を実行することができる。その結果、モデルは訓練問題の集合を解くことを学習するだけでなく、個々の問題を効率的に解く能力を発達させ、未知のテスト問題に対する汎化を向上させる。

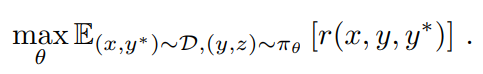

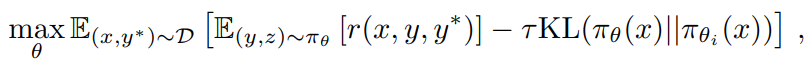

そこで、強化学習(RL)を用いてCoTを生成するモデルの学習を考える(OpenAI 2024)。rを報酬モデルとすると、r(x, y, y*) ∈ {0, 1}の値を割り当てることで、与えられた質問xに対して提案された答えyの正しさの根拠を、真の答えy*に基づいて提供する。検証可能な問題では、報酬は事前に定義された基準やルールによって直接決定されます。例えば、コーディング問題では、答えがテストケースをパスするかどうかを評価します。自由形式の真の答えを持つ問題では、答えが真の答えと一致するかどうかを予測するために、報酬モデルr(x, y, y*)を学習します。質問xが与えられると、モデルπθはサンプリングプロセスz ~ πθ(-|x), y ~ πθ(-|x, z)を介してCoTと最終的な答えを生成します。生成されたCoTの品質は、正しい最終回答を生成できるかどうかに依存する。まとめると、我々は戦略を最適化するために以下の目的を考慮する。

RL学習を拡張することで、単純な手がかりに基づくCoTとプランニングを強化したCoTの両方を活用するモデルの学習を目指す。このモデルは、推論中に言語シーケンスを自己回帰的にサンプリングするため、高度なプランニングアルゴリズムが必要とする展開中の複雑な並列化を回避することができる。しかし、単純な手がかりベースのアプローチとの重要な違いは、モデルが一連の推論ステップに従うだけではいけないということです。その代わりに、探索的思考全体を文脈情報として活用することで、エラーの識別、バックトラック、解の改善などの主要な計画スキルも学習する必要がある。

2.3.2 戦略の最適化

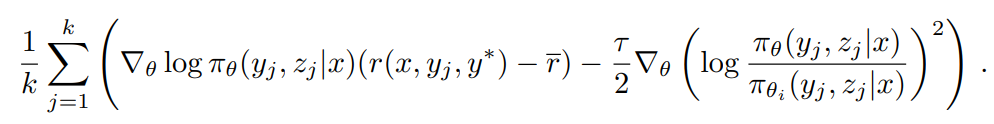

学習アルゴリズムとして、オンライン戦略ミラー降下の変形を適用する(Abbasi-Yadkori et al.2019; Mei et al.2019; Tomar et al.2020)。アルゴリズムは反復的に実行される。i回目の反復では、現在のモデルπθiを参照モデルとして使用し、以下の相対エントロピー正則化政策最適化問題を最適化する。

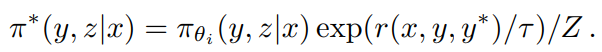

ここでτ > 0は正則化の度合いを制御するパラメータである。この目的は閉形式の解を持つ

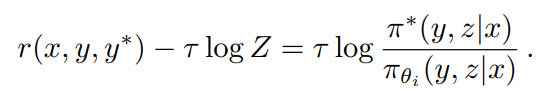

ここで、Z = Σy',z' πθi (y', z'|x) exp(r(x, y', y*)/τ) は正規化係数である。両辺の対数をとると、任意の (y, z) に対して、以下の制約が満たされることがわかります。

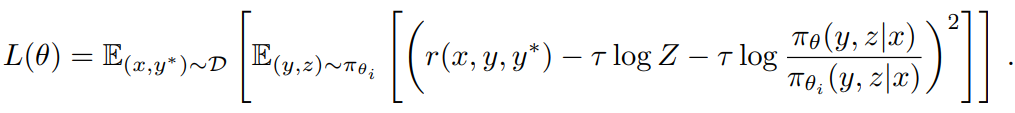

これにより、以下のような交換損失が発生した。

τ log Z を近似するために、標本 (y1, z1), ... , (yk, zk) ~ πθ を使用する。(yk, zk) ~ πθ: τ log Z ≈ log 1/k Σ^k_j=1 exp(r(x, yj, y*)/τ).また、サンプリング報酬の経験平均τ = mean(r(x, y1, y*), ...) を使用することがわかります。r(x、yk、y*))を使用すると、有効な実用的結果が得られる。これは、τ → ∞となるにつれて、τ log Z が πθi の下での期待報酬に近づくからである。最後に、置換損失の勾配をとることにより、学習アルゴリズムを導出する。各問題 x に対して、参照ポリシー πθi を用いて k 個の応答がサンプリングされ、勾配は次式で与えられる。

戦略勾配法に慣れている人にとっては、この勾配は、サンプリングされた報酬の平均をベースラインとして使用する(2)の戦略勾配に似ている(Kool et al. 2019; Ahmadian et al. 2024)。主な違いは、応答がオンライン戦略ではなくπθiからサンプリングされることと、l2正則化が適用されることである。従って、これは通常のオンライン正則化政策勾配アルゴリズムのオフライン政策の場合への自然な拡張と見なすことができる(Nachum et al. 2017)。Dから問題のバッチをサンプリングし、パラメータをθi+1 に更新します。また、各反復の開始時にオプティマイザをリセットします。これは各反復が参照方 針の変更により異なる最適化問題を考慮するためです。

我々は、以前の研究(Ahmadian et al. 2024)でも利用されていたバリューネットワークを学習システムから除外した。この設計の選択により訓練効率は大幅に改善されたが、古典的なRLにおけるクレジットの割り当てのための伝統的な価値関数の使用は、我々の文脈には適切ではない可能性があるという仮説も立てた。モデルが部分的なCoT (z1, z2, ... , zt)を生成し、2つの潜在的なCoTを持つ状況を考える。zt+1は直接正解に導くが、z't+1はエラーを含むとする。もしオラクル価値関数にアクセス可能であれば、zt+1がz't+1よりも高い価値を保持することを示すだろう。標準的な信用配分の原則に従えば、z't+1を選択することは、現在の戦略よりもマイナスの利点があるため、ペナルティを受けることになる。しかし、z't+1 を探索することは、長い CoT を生成するためのモデルを訓練する上で価値がある。長いCoTから導かれる最終的な答えの根拠を報酬信号として使用することで、モデルは、うまく回復して正しい答えに到達する限り、z't+1を採用する試行錯誤のパターンから学習することができます。この例から導き出される重要な結論は、複雑な問題を解決する能力を高めるために、モデルに様々な推論経路を探索するように促すべきだということです。この探索的アプローチは、重要なプランニング・スキルの開発をサポートする多くの経験を生み出す。トレーニング問題の精度を最高レベルまで向上させることよりも、我々の主な目標は、効果的な問題解決戦略をモデルに装備させることに集中することである。

2.3.3 長さのペナルティ

我々は、RL学習中にモデルの応答の長さが著しく長くなる考え過ぎ現象を観察した。これは性能の向上につながるが、長すぎる推論プロセスは訓練や推論の際にコストがかかり、一般的に人間は考えすぎを嫌う。この問題に対処するため、我々は長さボーナスを導入し、トークンの長さの急激な増加を制限することで、モデルのトークン効率を向上させる。問題x, ...に対してk個のサンプル応答(y1, z1)が与えられたとする。(yk, zk) と真の答え y* が与えられたとき、len(i) を (yi, zi) の長さ、min_len = min_i len(i)、max_len = max_i len(i)とする。max_len = min_lenの場合、同じ長さなので、すべてのレスポンスに対して長さボーナスをゼロに設定する。そうでない場合、長さボーナスは次式で与えられる。

基本的には、正解の場合は短い回答を奨励し、長い回答にはペナルティを課し、不正解の場合は長い回答に明示的にペナルティを課します。この長さに基づく報酬と重み付けパラメータは、元の報酬に追加されます。

我々の予備実験では、長さペナルティはトレーニングの初期段階を遅くする可能性がある。この問題を軽減するために、長さペナルティを訓練の初期段階で徐々に暖めることを提案する。具体的には、長さペナルティなしの標準的な戦略で最適化を行い、残りの訓練では一定の長さペナルティを適用する。

2.3.4 サンプリング戦略

RLアルゴリズム自体は比較的良好なサンプリング特性を持つが(難しい問題ほど大きな勾配が得られる)、その学習効率には限界がある。そのため、事前に定義されたサンプリング手法を用いることで、より高い性能を得ることができる。我々は、サンプリング戦略をさらに改善するために複数の信号を利用する。第一に、我々が収集するRL訓練データは、当然ながら異なる難易度ラベルを持つ。例えば、数学の競技問題は小学校の算数の問題よりも難しい。第二に、RL訓練プロセスは同じ問題を複数回サンプリングするので、難易度の指標として各問題の成功率を追跡することもできる。この事前知識を活用し、学習効率を向上させるために2つのサンプリング方法を提案する。

コース・サンプリング 最初に簡単なタスクで訓練を行い、徐々に難易度の高いタスクに移行する。初期のRLモデルの性能は限られているため、限られた計算予算を非常に難しい問題に費やすと、一般的に正しいサンプルがほとんど得られず、学習効率が低下する。同時に、私たちが収集するデータには等級と難易度のラベルが自然に含まれているため、難易度ベースのサンプリングは学習効率を向上させる直感的で効果的な方法となる。

優先サンプリング コース・サンプリングに加えて、モデルの性能が低い問題に焦点を当てるために、プライオリティ・サンプリング戦略を用いる。各問題iの成功率siを記録し、成功率の低い問題ほど高い確率でサンプリングされるように、1/siに比例する方法で問題をサンプリングする。これにより、モデルの努力を最も弱い部分に向けることができ、学習のスピードが上がり、全体的な性能が向上する。

2.3.5 トレーニングレシピの詳細情報

コーディングのためのテストケース作成 Web上の多くのコーディング問題にはテストケースが存在しないため、RLを用いたモデル学習のオマケとして利用できるテストケースを自動生成する方法を考案した。我々の焦点は、主に特別な審判を必要としない問題である。また、より質の高いテストケースを生成するために、これらの問題に対する実際の解答が利用可能であることを前提とする。

私たちは、広く認知されているテストケース生成ライブラリCYaRon¹を用いて、私たちのアプローチを強化する。CYaRonの使い方の説明と問題の説明がジェネレーターへの入力となる。各問題に対して、まずジェネレーターを使って50のテストケースを生成し、各テストケースに対して10個の実際の解答をランダムにサンプリングする。提出された問題に対してテストケースを実行する。提出された 7 件のうち少なくとも 10 件が一致した場合、テストケースは有効であるとみなされます。この一連のフィルタリングの後、テストケースを選択します。9件の提出のうち少なくとも10件が選択されたテストケースのセットを通過した場合、その質問と関連する選択されたテストケースがトレーニングセットに追加されます。

統計的に、1,000のオンラインコンペティション問題のサンプルから、約614の問題は特別な審判を必要としませんでした。少なくとも40の有効なテストケースを生成する463のテストケースジェネレータを開発し、323の問題を含むトレーニングセットを作成しました。

数学の報酬をモデル化する 数学の解答を評価する際の1つの課題は、異なる書式が同じ基本的な解答を表すことがあるということである。例えば、a² - 4と(a + 2)(a - 2)は両方とも有効な解答かもしれない。我々は、報酬モデルの得点精度を向上させるために2つのアプローチを使用した:

- 古典的なRM:InstructGPT(Ouyang et al. 2022)のアプローチからヒントを得て、価値ベースのヘッダー報酬モデルを実装し、微調整のために約80万点のデータを収集した。このモデルは最終的に「質問」、「参照」、「応答」を入力とし、応答が正しいかどうかを示すスカラーを出力する。

- 思考連鎖RM:最近の研究(Ankner et al. 2024; McAleese et al. 2024)により、思考連鎖(CoT)推論で補強された報酬モデルは、特にきめ細かい正しさの基準を必要とするタスク(数学など)において、古典的なアプローチを大幅に上回ることが示されている。そこで、Kimiモデルを微調整するために、約80万個のCoTラベル付き例からなる等しいサイズのデータセットを収集した。古典的なRMと同じ入力に基づき、チェーンオブシンキングアプローチはJSONフォーマットで段階的推論プロセスを明示的に生成し、最終的な正誤判定を提供する。

RLのトレーニングでは、より正しいフィードバックを確実にするために思考連鎖RMを使用した。

ビジュアル・データ このモデルの実世界での画像推論能力を向上させ、視覚入力と大規模言語モデル(LLM)のより効率的なアライメントを達成するために、我々の視覚強化学習(Vision RL)データは、実世界データ、合成視覚推論データ、テキストレンダリングデータの3つの異なるカテゴリーから収集されている。

- 実世界のデータは、グラフの理解と推論を必要とするすべての学年レベルの科学的問題、視覚的知覚と推論を必要とする位置推測タスク、複雑な図を理解する分析タスクを幅広くカバーしている。これらのデータセットは、実世界のシナリオで視覚的推論を行うモデルの能力を向上させる。

- 合成視覚的推論データは人間が生成したもので、空間的関係、幾何学的パターン、オブジェクトの相互作用の理解など、特定の視覚的推論能力を向上させるように設計されたプログラムによって作成された画像やシーンを含む。これらの合成データセットは、モデルの視覚的推論能力をテストするための制御された環境を提供し、無限のトレーニング例を提供します。

- テキストレンダリングされたデータは、テキストコンテンツを視覚的なフォーマットに変換することで作成され、異なるモダリティ間でテキストベースのクエリを処理する際にモデルが一貫性を維持できるようにします。テキスト文書、コードスニペット、構造化データを画像に変換することで、入力がプレーンテキストであるか、画像としてレンダリングされたテキスト(スクリーンショットや写真など)であるかにかかわらず、モデルが一貫した応答を提供することを保証します。これはまた、テキストを多用する画像を処理するモデルの能力強化にも役立ちます。

入力モード間で一貫したパフォーマンスを確保しながら、実世界のさまざまなアプリケーションを効果的に管理できる包括的な視覚言語モデルを構築するためには、それぞれのタイプのデータが不可欠である。

2.4 Long2short:Short-CoTモデルのコンテキスト圧縮

long-CoTモデルは強力な性能を達成するが、標準的なshort-CoT LLMよりも多くのテスト時間Tokenを消費する。しかし、long-CoTモデルの思考に関する先験的知識をshort-CoTモデルに転送することで、限られたテスト時間Token予算でも性能を向上させることができる。我々は、このlong2short問題に対して、モデルマージ(Yang et al., 2024)、最短棄却サンプリング、DPO(Rafailov et al:

モデルのマージ モデルのマージは、汎化能力を維持するのに役立つことがわかっている。また、長いCoTモデルと短いCoTモデルをマージすることで、トークンの効率が向上することもわかった。このアプローチでは、長いCoTモデルと短いモデルを組み合わせて、トレーニングなしで新しいモデルを得ます。具体的には、2つのモデルの重みを単純に平均化することでマージします。

最小不合格サンプリング 我々は、我々のモデルが、同じ問題に対して大きく異なる長さの応答を生成することを観察した。これに基づき、我々は最短拒絶サンプリング法を考案した。この方法は同じ問題をn回(我々の実験ではn = 8)サンプリングし、教師ありの微調整のために最も短い正しい応答を選択する。

特許庁 最短棄却サンプリングと同様に、複数の応答サンプルを生成するためにロングCoTモデルを利用します。最も短い正解が正のサンプルとして選択され、より長い回答は負のサンプルとみなされ、より長い不正解とより長い正解(選択された正のサンプルの1.5倍の長さ)が含まれる。これらのポジティブとネガティブのペアが、DPOトレーニングに使用されるペア嗜好データを構成する。

ロング2ショートRL 標準的なRLトレーニングフェーズの後、性能とトークン効率のバランスが最も良いモデルをベースモデルとして選択し、別のlong2short RLトレーニングフェーズを実施する。第2フェーズでは、セクション2.3.3で紹介した長さペナルティを適用し、最大ロールアウト長を大幅に削減することで、必要以上に長いが正しい可能性のある回答にさらにペナルティを課す。

2.5 その他のトレーニング詳細

2.5.1 事前トレーニング

Kimi k1.5のベースモデルは、多様で高品質なマルチモーダルコーパスで学習される。言語データは、英語、中国語、コード、数学的推論、知識の5つのドメインをカバーしています。字幕、画像とテキストのインターリーブ、OCR、知識、QAデータセットを含むマルチモーダルデータにより、我々のモデルは視覚言語能力を獲得することができます。厳密な品質管理により、事前学習データセット全体の関連性、多様性、バランスを保証します。(1)強力な言語的基礎を確立した後、徐々にマルチモーダルな統合を行う視覚言語的事前トレーニング、(2)特に推論と知識ベースのタスクの能力を強化するために、選択データと合成データを使用するクールダウン期間、(3)シーケンス処理を131,072トークンにスケールアップするロングコンテキストアクティベーション。は付録Bを参照。

2.5.2 バニラ監督による微調整

我々は、いくつかの領域をカバーするバニラSFTのコーパスを作成した。推論以外のタスク(質問と回答、文章作成、テキスト処理など)については、まず手動アノテーションによってシードデータセットを作成した。このシードデータセットはシードモデルの学習に使用される。その後、様々なプロンプトを収集し、シードモデルを使用して各プロンプトに対する複数の回答を生成する。その後、アノテーターがこれらの回答をランク付けし、最も高いランクの回答を改善して最終バージョンを生成する。数学問題やコーディング問題など、ルールと報酬のモデリングに基づく検証の方が手作業による判断よりも正確かつ効率的である推論タスクについては、拒絶サンプリングを使用してSFTデータセットを拡張する。

我々のバニラSFTデータセットには、約100万のテキスト例が含まれている。具体的には、一般的なQ&Aが50万例、コーディングが20万例、数学と科学が20万例、クリエイティブライティングが5,000例、要約、文書クイズ、翻訳、ライティングなどのロングコンテキストタスクが20,000例である。さらに、図の解釈、OCR、画像ベースの対話、視覚的コーディング、視覚的推論、視覚的補助を使った数学・科学の問題など、さまざまなカテゴリーをカバーする100万件の視覚的なテキスト例を構築した。

まず、32kTokenのシーケンス長で1エポック学習させ、次に128kTokenのシーケンス長で1エポック学習させる。第1フェーズ(32k)では、学習率は2×10-5から2×10-6に減衰し、第2フェーズ(128k)では1×10-5に再加速し、最終的に1×10-6に減衰する。学習効率を向上させるために、各学習シーケンスに複数の学習例をパッケージ化した。

2.6 RLインフラ

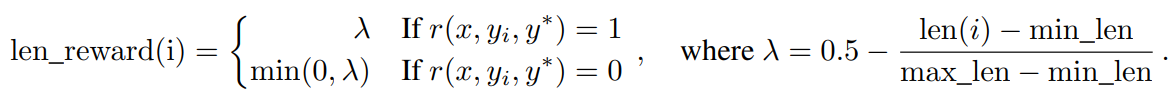

図3:LLMの大規模強化学習学習システム

(a) システム概要

(b) 部分的なロールアウト

2.6.1 LLMのための大規模強化学習トレーニングシステム

AIの分野では、強化学習(RL)が大規模言語モデル(LLM)(Ouyang et al.ら2017)、AlphaStar(Vinyalsら2019)、OpenAI Dota Five(Bernerら2019)などのシステムがある。この伝統に従って、Kimi k1.5システムは、持続的な学習と適応を通じてモデルの推論を強化するように慎重に設計された反復同期RLフレームワークを採用している。このシステムにおける重要な革新は、複雑な推論軌道の処理を最適化するように設計された部分的ロールアウト技術の導入である。

図3aに示すように、RLトレーニングシステムは反復同期アプローチによって動作し、各反復はロールアウトフェーズとトレーニングフェーズから構成される。ロールアウト・フェーズでは、中央のマスター・サーバーによって調整されたロールアウト・ワーカーが、モデルと相互作用してロールアウト軌道を生成し、様々な入力に対する一連の応答を生成する。これらの軌跡はリプレイバッファに保存され、時間的相関を遮断することで多様で偏りのない訓練データセットを保証する。その後の訓練フェーズでは、訓練ワークブックがこれらの経験にアクセスし、モデルの重みを更新する。この循環プロセスにより、モデルは継続的に操作から学習し、パフォーマンスを向上させるために時間をかけて戦略を調整することができる。

中央マスターサーバーは中央司令塔として機能し、ロールアウトワークフロー、トレーニングワークフロー、報酬モデルによる評価、およびリプレイバッファ間のデータフローと通信を管理します。システムが協調して動作するようにし、負荷のバランスをとり、効率的なデータ処理を促進します。

トレーニング作業ルーチンは、モデルのパラメータを改善し、パフォーマンスを向上させる勾配更新を計算するために、1回の反復で完了するか、複数回の反復に分割されたロールアウト軌道にアクセスする。このプロセスは、モデルの出力の質を評価し、トレーニングプロセスを導くために必要なフィードバックを提供する報酬モデルによって監督される。報酬モデルの評価は、モデル戦略の有効性を判断し、モデルを最適なパフォーマンスへと導く上で非常に重要である。

さらに、このシステムにはコード実行サービスが含まれており、これはコード関連の問題に対処するために特別に設計されており、報酬モデルの不可欠な部分である。このサービスは、実際のコーディングシナリオでモデルの出力を評価し、モデルの学習が実際のプログラミング課題に密接に沿ったものであることを保証します。実際のコード実行に対してモデルの解を検証することで、このフィードバック・ループは、モデルの戦略を改善し、コード関連のタスクにおけるパフォーマンスを向上させるために不可欠です。

2.6.2 長いCoT RLの部分的ロールアウト

私たちの研究の主なアイデアの1つは、長いコンテキストのRLトレーニングを拡張することです。部分ロールアウトは、長い軌跡と短い軌跡の両方のロールアウトを管理することで、長いCoT特性を扱うという課題に効果的に対処する重要なテクニックである。このテクニックは、各ロールアウト軌道の長さを制限する出力トークンの固定バジェットを確立する。ロールアウト段階で軌跡がトークン制限を超えた場合、未完了部分は再生バッファに保存され、次の反復で継続される。これにより、単一の長い軌跡がシステムのリソースを独占することがない。さらに、ロールアウト・ワークフローは非同期に実行されるため、一部のワークフローが長い軌跡を処理している間に、他のワークフローは独立して新しい短いロールアウト・タスクを処理することができる。非同期動作は、すべてのロールアウトワークフローがトレーニングプロセスに積極的に貢献することを保証することにより、計算効率を最大化し、システムの全体的なパフォーマンスを最適化する。

図3bに示すように、パーシャル・ロールアウト・システムは、反復(反復n-mから反復nまで)にわたって長い応答を断片に分解することで機能する。再生バッファは、これらの応答フラグメントを維持するための中央記憶メカニズムとして機能し、現在の反復(反復n)のみをオンラインで計算する必要がある。以前のセグメント(反復n-mからn-1)は、バッファから効率的に再利用することができ、ロールアウトを繰り返す必要がない。このセグメント化されたアプローチにより、計算オーバーヘッドが大幅に削減される。一度に応答全体をロールアウトする代わりに、システムはセグメントを段階的に処理して保存するため、高速な反復時間を維持しながら、より長い応答を生成することができる。トレーニング中、特定のセグメントを損失計算から除外することで、学習プロセスをさらに最適化し、システム全体を効率的かつスケーラブルにすることができる。

部分ロールアウトの実装は、重複検出も提供する。このシステムは、生成されたコンテンツの重複シーケンスを識別し、早期に終了させることで、出力の品質を維持しながら不要な計算を削減する。検出された重複コンテンツには追加のペナルティを課すことができ、キューセットに冗長なコンテンツが生成されるのを効果的に防ぐことができる。

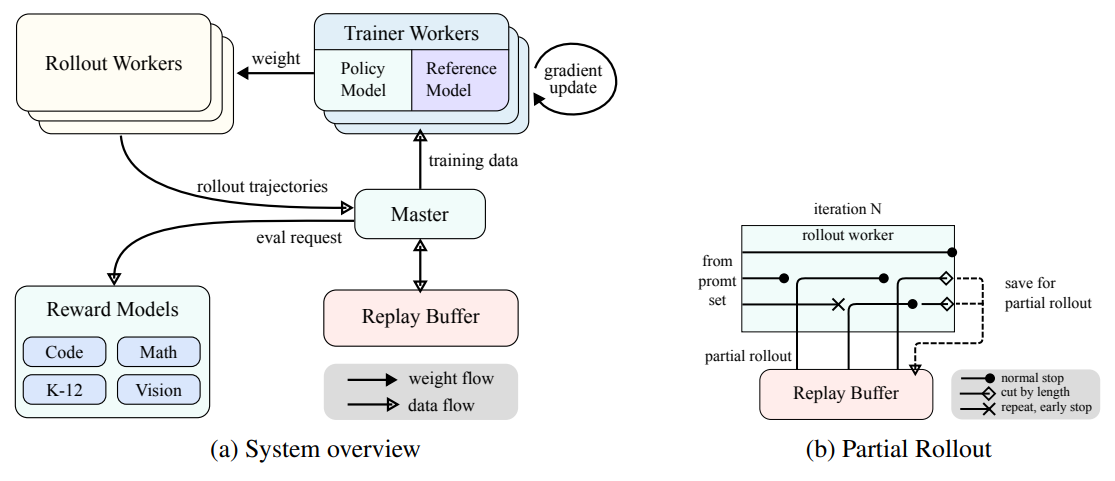

2.6.3 トレーニングと推論のハイブリッド展開

RLのトレーニング・プロセスは以下の段階からなる:

図4:ハイブリッド展開のフレームワーク

- トレーニング段階まず、メガトロン(Shoeybi et al. ブイエルエルエム (megatronはトレーニングプロセスを開始します。トレーニングが完了すると、メガトロンはGPUメモリをアンロードし、現在の重みをvLLMに転送する準備をします。

- 推論段階Megatronのアンロード後、vLLMは仮想モデルの重みで起動し、Mooncake経由でMegatronから転送された最新の重みで更新する(Qin et al.)ロールアウト完了後、チェックポイントエンジンは全てのvLLMプロセスを停止する。

- フォローアップ研修段階vLLMに割り当てられたメモリーが解放されると、メガトロンはメモリーをアンロードし、別のトレーニングを開始する。

既存の仕事では、以下のすべての機能を同時にサポートすることは難しいことがわかりました。

- 複雑な並列戦略MegatronはvLLMとは異なる並列化戦略を持っている可能性がある。Megatronの複数のノードに分散されたトレーニングの重みは、vLLMと共有するのが難しいかもしれません。

- アイドルGPUリソースの最小化オンライン・ポリシーRLの場合、最近の研究(例えば、SGLang(L. Zheng et al.2024)やVLLM)では、トレーニング中に一部のGPUが予約され、トレーニングGPUがアイドル状態になる可能性がある。

- ダイナミックなスケーラビリティ場合によっては、学習プロセスを一定に保ったまま推論ノードの数を増やすことで、大幅な高速化が達成できる。我々のシステムは、必要なGPUノード数を効率的に利用することができる。

図4に示すように、MegatronとvLLM(セクション2.6.3)の上にこのハイブリッド展開フレームワークを実装した結果、トレーニングから推論までのフェーズは1分未満、逆は約10秒で完了した。

ハイブリッド展開戦略 KubernetesのSidecarコンテナを活用し、利用可能なすべてのGPUを共有することで、1つのポッドで両方のワークロードを並列処理する、トレーニングと推論タスクのハイブリッドデプロイメント戦略を提案する。この戦略の主な利点は以下の通りです:

- これにより、効率的なリソースの共有と管理が容易になり、トレーニングノードが推論ノードの待ち時間にアイドル状態になるのを防ぐことができる(両ノードが別々のノードに配置されている場合)。

- 異なる配置画像を使用することで、訓練と推論を独立して繰り返し、より良いパフォーマンスを得ることができる。

- アーキテクチャはvLLMに限らず、他のフレームワークも簡単に統合できる。

チェックポイントエンジン チェックポイント・エンジンはvLLMプロセスのライフサイクルを管理する役割を担い、vLLMに対する様々な操作をトリガーするHTTP APIを公開する。全体的な一貫性と信頼性を確保するため、etcdサービスによって管理されるグローバル・メタデータ・システムを使用して、操作と状態をブロードキャストします。

vLLM がアンインストールされると、主に CUDA グラフ、NCCL バッファ、および NVIDIA ドライバが原因で、GPU メモリを完全に解放することが難しくなります。vLLMへの変更を最小限に抑えるため、GPUの利用率とフォールトトレランスを向上させるために、vLLMを終了し、必要なときに再起動します。

Megatronのワークアラウンドは、所有するチェックポイントを共有メモリ内のHugging Faceフォーマットに変換する。この変換ではパイプライン並列とエキスパート並列も考慮されるため、これらのチェックポイントではテンソル並列のみが保持される。共有メモリ上のチェックポイントはフラグメント化され、グローバルなメタデータシステムに登録される。Mooncakeを使用して、RDMA経由でピアノード間でチェックポイントを転送します。ウェイトファイルのロードとテンソル並列変換の実行には、vLLMのいくつかの変更が必要です。

サンドボックスは、コード実行とコードベンチマークのために最適化された、ユーザが投稿したコードを実行するためのセキュアな環境として開発した。コンテナイメージを動的に切り替えることで、サンドボックスはMultiPL-E (Cassano, Gouwar, D. Nguyen, S. Nguyen, et al. 2023)、DMOJ Judge Server²、Lean、Jupyter Notebook、その他のイメージを通じて、さまざまなユースケースをサポートします。

コーディングタスクにおけるRLのために、Sandboxは一貫した反復可能な評価メカニズムを提供することで、トレーニングデータ判定の信頼性を保証します。そのフィードバックシステムは、プログラミング言語間の公平で偏りのないベンチマーク比較を保証するために統一されたコンテキストを維持しながら、コード実行フィードバックやレポレベルの編集などの多段階評価をサポートします。

自動再起動やローリングアップデートなどのKubernetesの機能により、可用性とフォールトトレランスが確保される。

パフォーマンスを最適化し、RL環境をサポートするために、私たちはコード実行サービスにいくつかのテクノロジーを統合し、効率性、スピード、信頼性を向上させています。これらには以下が含まれます:

- クルンの使用Dockerの代わりにcrunをコンテナランタイムとして使用することで、コンテナの起動時間を大幅に短縮しています。

- Cグループの再利用これは、コンテナごとにcgroupを作成したり破棄したりすることがボトルネックになるような、並行性の高いシナリオでは重要です。

- ディスク使用量の最適化ディスクへの書き込みを制御するためにtmpfsとしてマウントされたオーバーレイファイルシステムを使用することで、固定サイズの高速ストレージスペースを提供します。このアプローチは一時的なワークロードに有利である。

これらの最適化により、コード実行におけるRLの効率が改善され、RLが生成したコードを評価するための一貫して信頼できる環境が提供される。

3 実験

3.1 評価

k1.5はマルチモーダルモデルであるため、様々なベンチマークテストにおいて、様々なモードの包括的な評価を行った。詳細な評価設定は付録Cにある。ベンチマークテストは、以下の3つの主要カテゴリーから構成される:

- テキスト・ベンチマークMMLU (Hendrycks et al., 2020), IF-Eval (J. Zhou et al., 2023), CLUEWSC (L. Xu et al., 2020), C-EVAL (Y. Huang et al., 2023).

- 推論ベンチマークHumanEval-Mul, LiveCodeBench (Jain et al. 2024), Codeforces, AIME 2024, MATH-500 (Lightman et al. 2023).

- ビジュアル・ベンチマークMMMU (Yue, Ni, et al. 2024)、MATH-Vision (K. Wang et al. 2024)、MathVista (Lu et al. 2023)。

3.2 主な結果

K1.5ロングCoTモデル Kimi k1.5 long-CoTモデルの性能を表2に示す。このモデルの長期推論能力は、long-CoT教師付き微調整(セクション2.2で説明)と視覚テキスト協調強化学習(セクション2.3で説明)により大幅に向上している。テスト時の計算による拡張は、その性能をさらに向上させ、様々なモダリティにおいてモデルが最先端の結果を達成することを可能にする。我々の評価では、拡張されたコンテキストにおいて情報を推論、理解、合成するモデルの能力が著しく向上していることが明らかになり、これはマルチモーダルAI能力の進歩を表している。

K1.5ショートCoTモデル Kimi k1.5 short-CoTモデルのパフォーマンスを表3に示す。このモデルには、従来の教師あり微調整(セクション 2.5.2 で説明)、強化学習(セクション 2.3 で検討)、長短精密化(セクション 2.4 で概説)など、様々な技法が統合されています。その結果、k1.5 short-CoTモデルは、主要なオープンソースモデルやプロプライエタリモデルと比較して、多くのタスクにおいて競争力のある、あるいは優れたパフォーマンスを提供することが示された。これらには、テキスト、視覚、推論の課題が含まれ、自然言語理解、数学、コーディング、論理推論において大きな優位性がある。

表2:Kimi k1.5 long-CoTとフラッグシップ・オープンソースおよびプロプライエタリ・モデルのパフォーマンス。

表3:Kimi k1.5 short-CoTとフラッグシップのオープンソースおよびプロプライエタリ・モデルの性能。VLMモデルの性能は、OpenCompassベンチマーク・プラットフォーム(https://opencompass.org.cn/)から取得した。

3.3 ロング・コンテクスト・エクステンション

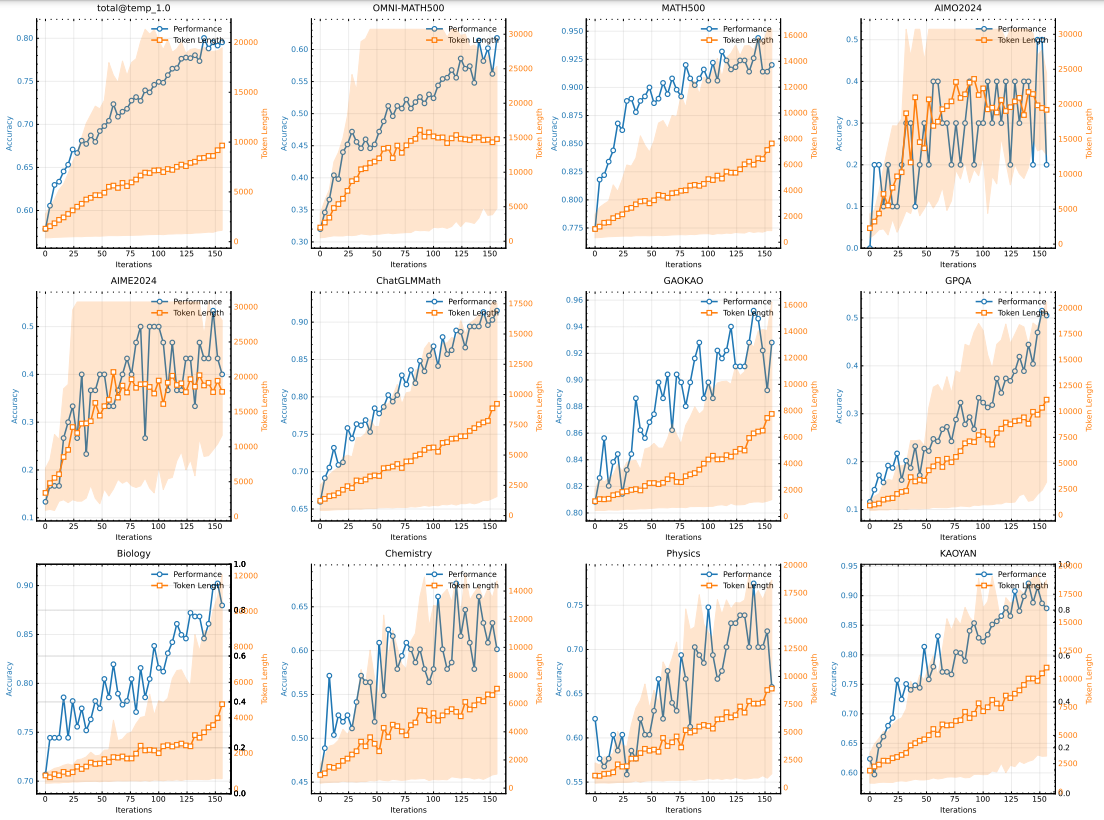

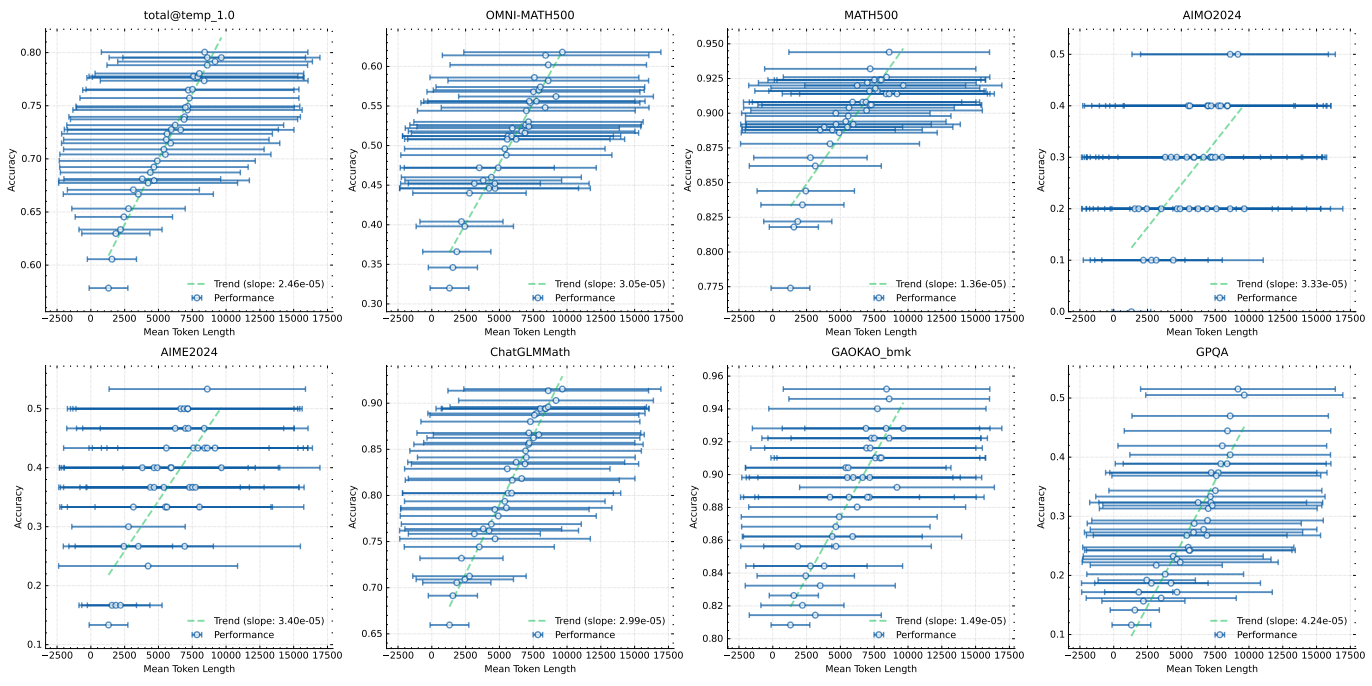

LLMを用いたRLの拡張特性を調べるために、中型のモデルを使用する。図5は、数学的手がかりセットで学習した小型モデルの反復学習における学習精度と応答長の変化を示している。学習が進むにつれて、応答長と学習精度が同時に増加していることがわかる。このことは、モデルが複雑な問題に対してより詳細な解を生成することを学習していることを示唆している。図6は、モデルの出力コンテキストの長さと問題解決能力の間に強い相関関係があることを示している。最終的にk1.5を実行すると、コンテキスト長は128kに拡張され、ハード推論ベンチマークテストにおいて継続的な改善が観察された。

図5:トレーニング反復回数の増加に伴うトレーニング精度と長さの変化。上記のスコアは、k1.5 long-CoTモデルよりはるかに小さいモデルサイズを持つ内部long-cotモデルによるものであることに注意。網掛け部分は応答長の95パーセンタイルを示す。

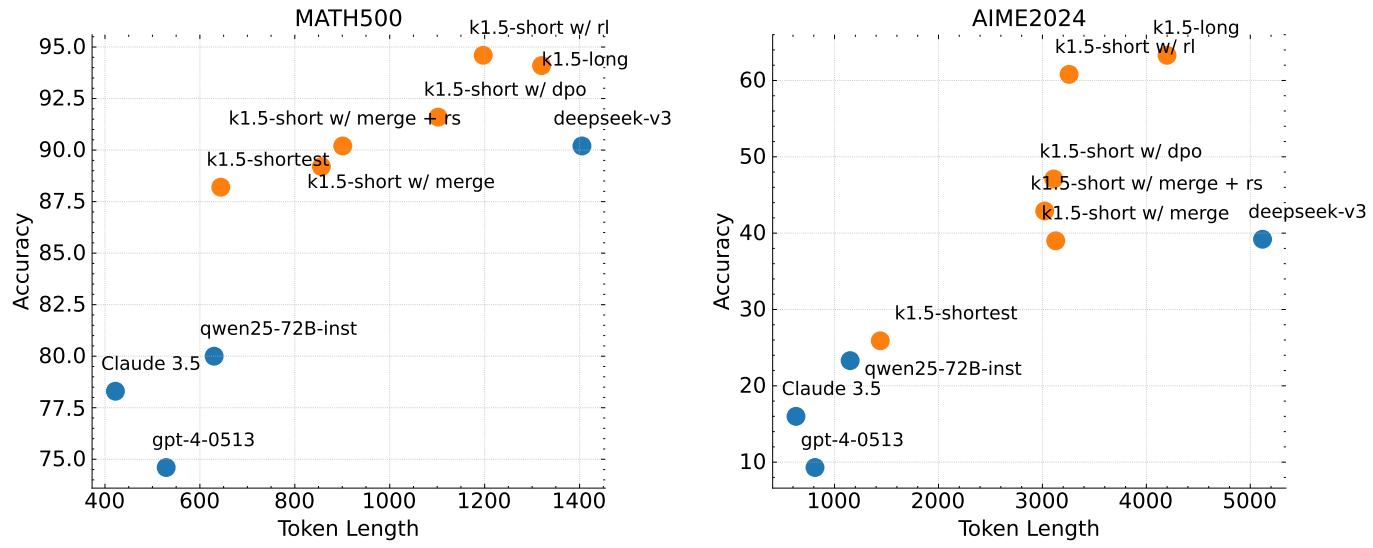

3.4 ロング2ショート

提案するlong2short RLアルゴリズムを、2.4節で紹介したDPO法、最短棄却サンプリング法、モデルマージ法と比較し、long2short問題(X. Chen et al., 2024)のToken効率、特に、得られたlong-cotモデルをいかにしてshortモデルに有益なものにするかに注目する。図7において、k1.5-longはlong2short訓練に選択したlong-cotモデルを示す。k1.5-short w/ rlはlong2short RL訓練を用いて得られたshortモデルを示す。k1.5-short w/ dpoはDPO訓練によりToken効率を改善するために訓練されたshortモデルを示す。k1.5-short w/ mergeはモデルマージを示す。k1.5-shortestはlong2short学習で得られた最短モデルを示す。図7に示すように、提案するlong2short RLアルゴリズムは、DPOやモデルマージなどの他の手法と比較して、最も高いトークン効率を示す。注目すべきは、k1.5ファミリーのすべてのモデル(オレンジでマーク)が、他のモデル(青でマーク)よりも優れたトークン効率を示していることである。例えば、k1.5-short w/ rlは、平均3,272トークンしか使用しないのに、AIME2024(平均8回実行)で60.8のPass@1スコアを達成しています。モデルである。

図6:応答長が長くなるにつれてモデルの性能は向上する

図7:Long2Shortのパフォーマンス。k1.5ファミリーはすべて、他のモデルよりもトークン効率が良いことを示している。

3.5 アブレーション研究

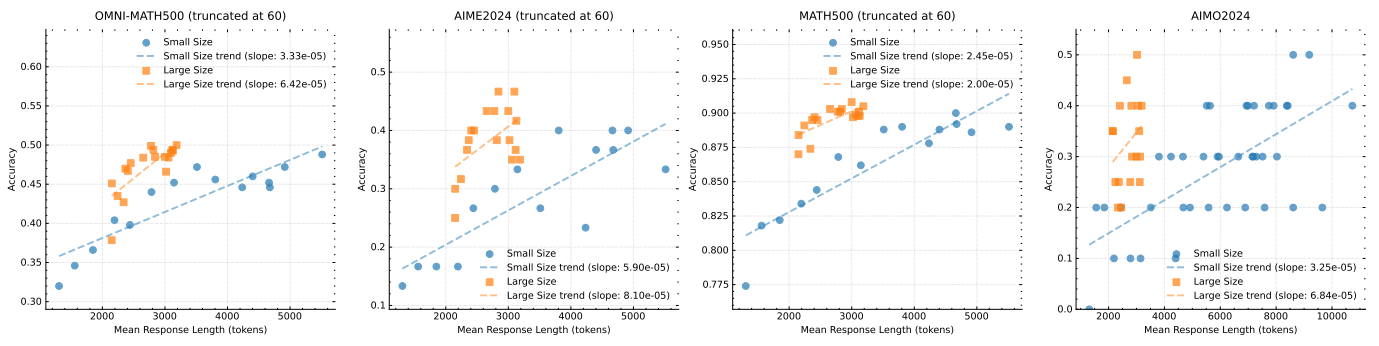

モデルのサイズとコンテキストの長さの拡張 我々の主な貢献は、拡張CoTを生成するモデルの能力を強化するためにRLを適用し、その結果、推論を改善することである。自然な疑問は、単純にモデルサイズを大きくした場合と比較してどうなのか、ということである。我々のアプローチの有効性を実証するために、同じデータセットを用いてサイズの異なる2つのモデルを訓練し、RL訓練中のすべてのチェックポイントにおける評価結果と平均推論長を記録した。これらの結果を図8に示す。最初は大きいモデルの方が小さいモデルよりも優れているが、RLによって最適化された長いCoTを利用することで、小さいモデルでも同等の性能を達成できることは注目に値する。しかし、大きなモデルの方が小さなモデルよりもトークン効率が良いことが一般的です。このことは、可能な限り最高の性能を得ることが目的であれば、より大きなモデルのコンテキストの長さを長くする方が上限が高く、よりトークン効率が高いことも示唆している。しかし、テスト時に計算の予算が確保できるのであれば、より長いコンテキスト長でより小さなモデルをトレーニングすることは、実行可能な解決策かもしれない。

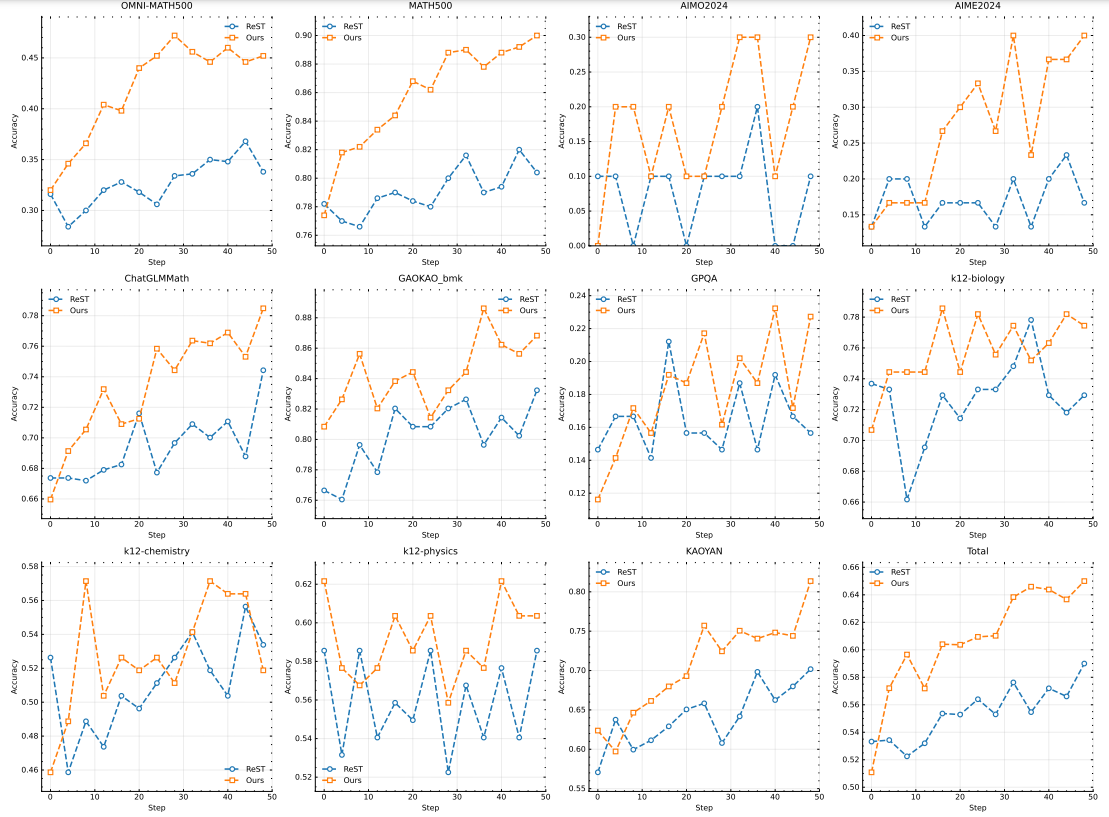

負のグラデーションの効果 ReSTと、我々の手法を含む他のRLベースの手法との主な違いは、ReSTが、不正確な応答にペナルティを与える負の勾配を適用することなく、現在のモデルからサンプリングされた最良の応答をフィッティングすることによって、モデルを反復的に改善することである。図10に示すように、我々の手法はReSTと比較して高いサンプル複雑度を示しており、これは負の勾配を組み込むことで、長いCoTを生成するモデルの効率が大幅に改善されることを示唆している。我々の手法は推論の質を向上させるだけでなく、学習プロセスを最適化し、より少ない学習サンプルでロバストな性能を実現する。この発見は、ReSTと他のRLベースの手法との間の性能差は、他のドメインでは(Gulcehre et al. 2023)ほど顕著ではないため、我々の設定において、ポリシー最適化アルゴリズムの選択が重要であることを示唆している。このように、我々の結果は、長いCoTを生成する効率を最大化するために、適切な最適化戦略を選択することの重要性を強調している。

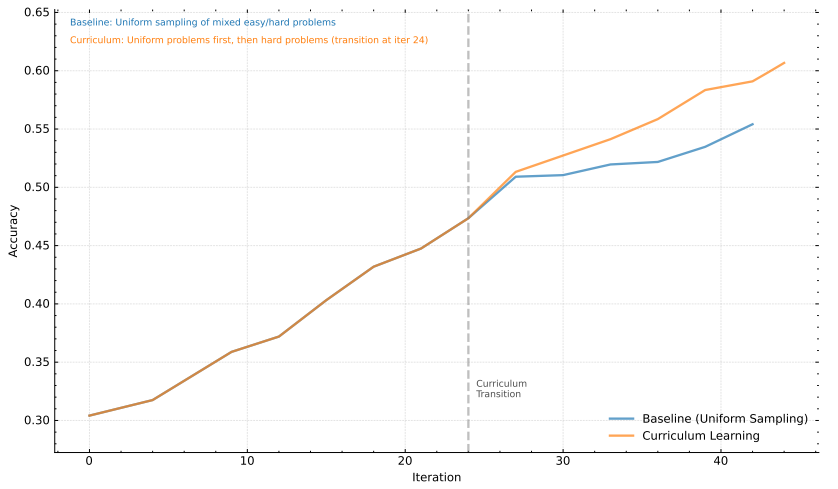

サンプリング戦略 さらに、セクション2.3.4で紹介したコースサンプリング戦略の有効性を実証する。訓練データセットDには様々な難易度の問題が含まれている。我々のコースサンプリング手法では、最初にDをウォームアップフェーズに使用し、その後、難しい問題のみに焦点を当ててモデルを訓練する。この方法を、コースチューニングを行わずに一様なサンプリング戦略を用いるベースライン法と比較する。図9に示すように、我々の結果は、提案するコースサンプリング手法が著しく性能を向上させることを明確に示している。この改善は、モデルが複雑な問題をより強く理解し、対処する能力を開発することを可能にする、モデルに段階的に挑戦する手法の能力に起因する。最初の汎化の後、より難しい問題に訓練努力を集中させることで、モデルは推論と問題解決能力をより強化することができる。

図8:異なるモデルサイズにおけるモデルの性能と応答長

図9:モデルのパフォーマンスに対するコース学習アプローチの分析。

4 結論

本稿では、RLを用いて学習した最新のマルチモーダルLLMであるk1.5の学習レシピとシステム設計を紹介する。私たちが実践から得た重要な洞察の一つは、LLMの継続的な改善にはコンテキストの長さのスケーリングが重要であるということです。私たちは、最適化された学習アルゴリズムと、部分的なロールアウトなどのインフラの最適化を採用し、効率的な長いコンテキストのRL学習を実現しています。長いコンテキストのRLトレーニングの効率とスケーラビリティをどのようにさらに向上させるかは、今後の重要な課題である。

図10:ReSTを使用したポリシー最適化の比較。

もう一つの貢献は、ポリシーの最適化を改善するために、複数の技術を組み合わせることである。具体的には、LLMを用いてlong-CoT RLを定式化し、ロバストな最適化のためのオンラインミラー降下の変形を導出した。また、ロバストなRL性能を達成するために、サンプリング戦略、長さペナルティ、最適データ定式化についても実験を行った。

より洗練された技術(モンテカルロ木探索、価値関数、プロセス報酬モデルなど)を使わなくても、長いコンテキストの拡張と改善されたポリシーの最適化により、強力なパフォーマンスが達成できることを示す。将来的には、モデルの探索能力を損なうことなく、クレジットの割り当てを改善し、考えすぎを減らす方法を調査することも興味深い。

我々はまた、long2short法の可能性を観察した。これらの手法はshort-CoTモデルの性能を大幅に改善する。さらに、long2short法をlong-CoT RLと反復的に組み合わせることで、トークンの効率をさらに向上させ、与えられたコンテキスト長バジェットに対して最高の性能を引き出すことができる。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません