オートディープリサーチ:マルチエージェント連携による文献検索と研究報告書の作成

はじめに

Auto-Deep-Researchは、香港大学データインテリジェンス研究所(HKUDS)によって開発されたオープンソースのAIツールで、ユーザーがディープリサーチタスクを自動化するのに役立ちます。AutoAgentフレームワーク上に構築されており、OpenAI、Anthropic、Deepseek、およびAutoAgentのような様々な大規模言語モデル(LLM)をサポートしています。 グロック など、複雑なファイルデータのやり取りやウェブ検索を扱うことができる。OpenAIのDeep Researchのようなサブスクリプションを必要とする高コストのツールとは対照的に、Auto-Deep-Researchは完全に無料で、ユーザーはLLMのAPIキーを提供するだけで使用できます。その高いパフォーマンスと柔軟性で知られるこのツールは、GAIAベンチマークで好成績を収めており、効率的なリサーチソリューションを必要とする研究者、開発者、ユーザーに適しています。

機能一覧

- 綿密な調査の自動化ユーザーが入力したトピックに基づいて、関連情報を自動的に検索・照合し、詳細なレポートを作成します。

- マルチモデル対応様々な大規模言語モデルに対応しており、ユーザーは必要に応じて適切なモデルを選択することができます。

- ファイルデータの相互作用画像、PDF、テキストファイルなどのアップロードと加工をサポートし、研究のためのデータソースを強化します。

- ワンタッチスタート複雑な設定は不要で、簡単なコマンドを入力するだけで、すぐに使い始めることができます。

- ウェブ検索機能ウェブリソースとソーシャルメディア(プラットフォームXなど)のデータを組み合わせて、より包括的な情報を提供する。

- オープンソースで無料ユーザーが機能をカスタマイズしたり、ローカル環境にデプロイできるように、完全なソースコードが提供されています。

ヘルプの使用

設置プロセス

Auto-Deep-Researchのインストールはシンプルかつ直感的で、PythonとDocker環境に大きく依存している。以下はその詳細な手順である:

1.環境準備

- PythonのインストールPython 3.10以降がインストールされていることを確認してください。推奨

conda仮想環境を作る:conda create -n auto_deep_research python=3.10 conda activate auto_deep_research

- DockerのインストールこのツールはDockerコンテナ化された実行環境を使用するので、まずDocker Desktopをダウンロードしてインストールしてください。

2.ソースコードのダウンロード

- GitHub リポジトリをローカルにクローンする:

git clone https://github.com/HKUDS/Auto-Deep-Research.git cd Auto-Deep-Research

3.依存関係のインストール

- プロジェクト・ディレクトリで以下のコマンドを実行して、必要なPythonパッケージをインストールする:

pip install -e .

4.APIキーの設定

- プロジェクトのルート・ディレクトリで、テンプレート・ファイルをコピーし、編集する:

cp .env.template .env - テキストエディタで開く

.envファイルに、必要に応じてLLMのAPIキーを記入してください:OPENAI_API_KEY=your_openai_key DEEPSEEK_API_KEY=your_deepseek_key XAI_API_KEY=your_xai_key注:すべてのキーが必要なわけではなく、使用する予定のモデルキーを設定するだけでよい。

5.スタートアップツール

- 以下のコマンドを入力し、オートディープリサーチを開始する:

auto deep-research - コンテナ名やモデルの指定など、オプションのパラメータ設定:

auto deep-research --container_name myresearch --COMPLETION_MODEL grok

主な機能

綿密な調査の自動化

- 研究テーマを入力する起動すると、「ヘルスケアにおける人工知能」のような研究トピックの入力が求められます。

- 自動実行このツールは、ウェブ検索と内蔵モデルを使用して、ユーザーの介入なしに関連情報を分析します。

- レポートの作成終了すると、結果はMarkdown形式でターミナルに出力されるか、ソースと詳細な分析結果を含むファイルとして保存されます。

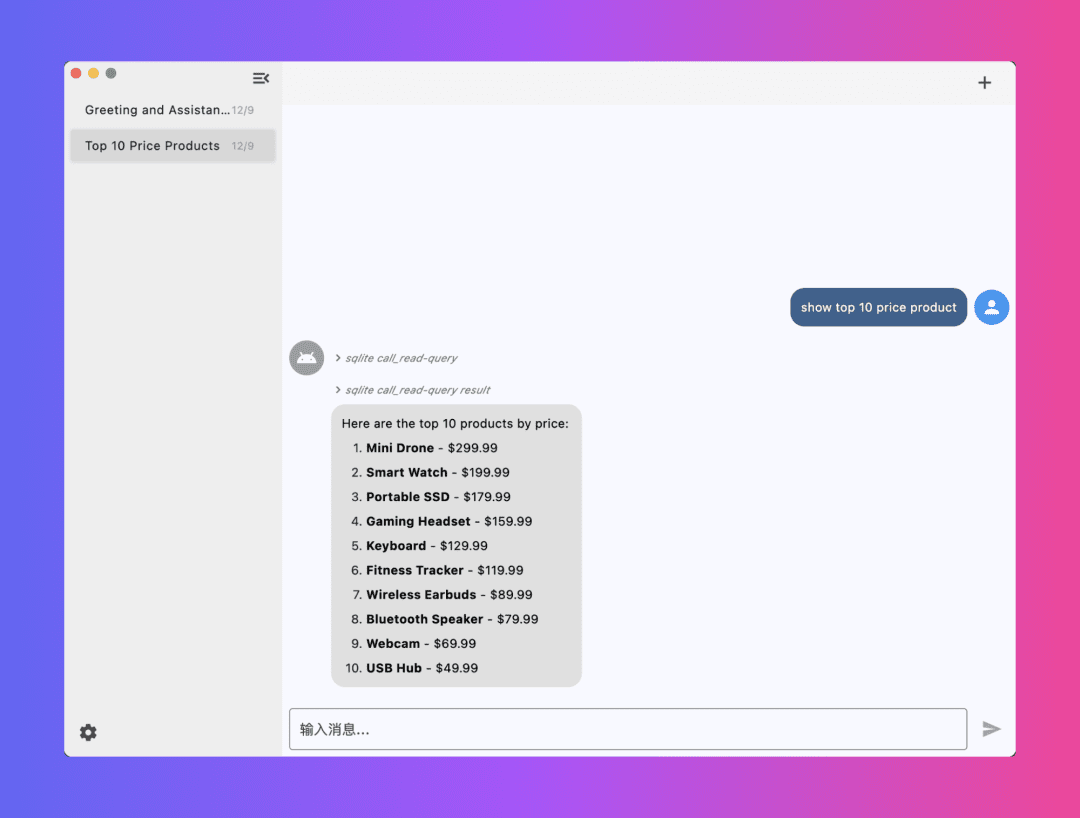

ファイルデータの相互作用

- ファイルのアップロードコマンドラインでファイルパスを指定する:

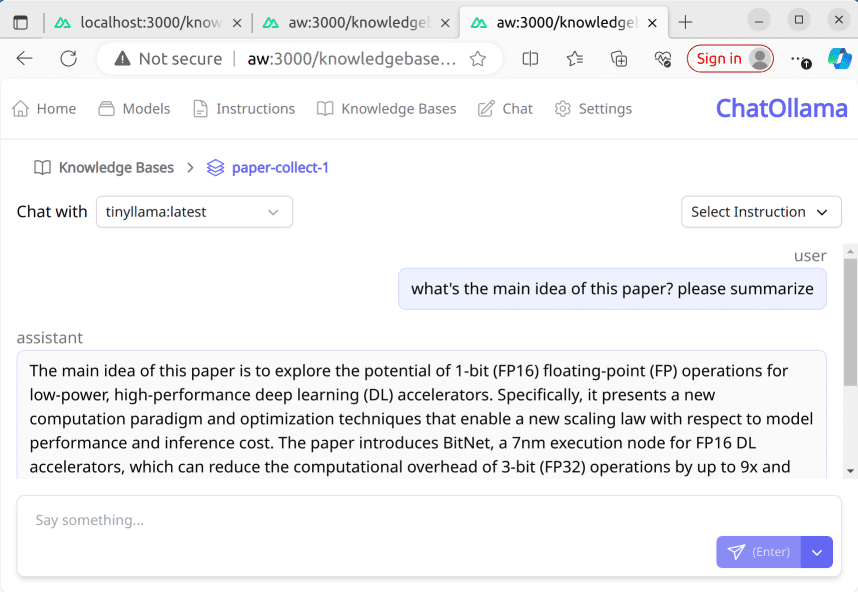

auto deep-research --file_path ./my_paper.pdf - 加工データこのツールは、PDF、画像、またはテキストの内容を解析し、研究に組み込む。

- 複合分析アップロードされたファイルデータは、ウェブ検索結果と統合され、より包括的な結論を提供します。

大規模言語モデルの選択

- サポートモデルを見るモデル名については、LiteLLMのドキュメントを参照してください。

- モデルの指定例えば、起動コマンドにパラメーターを追加する:

auto deep-research --COMPLETION_MODEL deepseek - 動作試験モデルのパフォーマンスとAPIの応答性に基づいて、エクスペリエンスを最適化するための選択肢を調整します。

注目の機能

ワンタッチ・スタート体験

- Dockerイメージや複雑なパラメータを手動で設定する代わりに、単純に

auto deep-researchツールは自動的に必要な環境を取り出し、起動する。 - カスタマイズが必要な場合は

--container_name複数のインスタンスを簡単に管理できるように、パラメータ名付きコンテナ。

ウェブ検索とソーシャルメディアの統合

- このツールには、ウェブコンテンツを自動的にクロールするウェブ検索機能が組み込まれている。Xプラットフォームのデータを取り入れたい場合は、リサーチトピックにキーワードを記載すれば、ツールが関連記事を検索してくれる。

- 例:「最新のAI研究動向」と入力すると、Xユーザーによる議論や技術ブログへのリンクが表示される。

ほら

- APIキーのセキュリティを付けないでください。

.env鍵の公開を避けるため、ファイルは公開リポジトリにアップロードされる。 - ネットワーク環境Dockerとネットワーク接続が正しく機能していることを確認してください。

- パフォーマンス最適化ローカルのハードウェアが限られている場合は、ラグを引き起こす大規模なモデルの実行を避けるために、クラウドベースのLLMを使用することをお勧めします。

以上の手順で、ユーザーは簡単にAuto-Deep-Researchを使い始めることができる。Auto-Deep-Researchは、学術研究と技術探求の両方を効率的にサポートするツールである。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません