AppAgent:マルチモーダルインテリジェンスによるスマートフォンの自動操作

はじめに

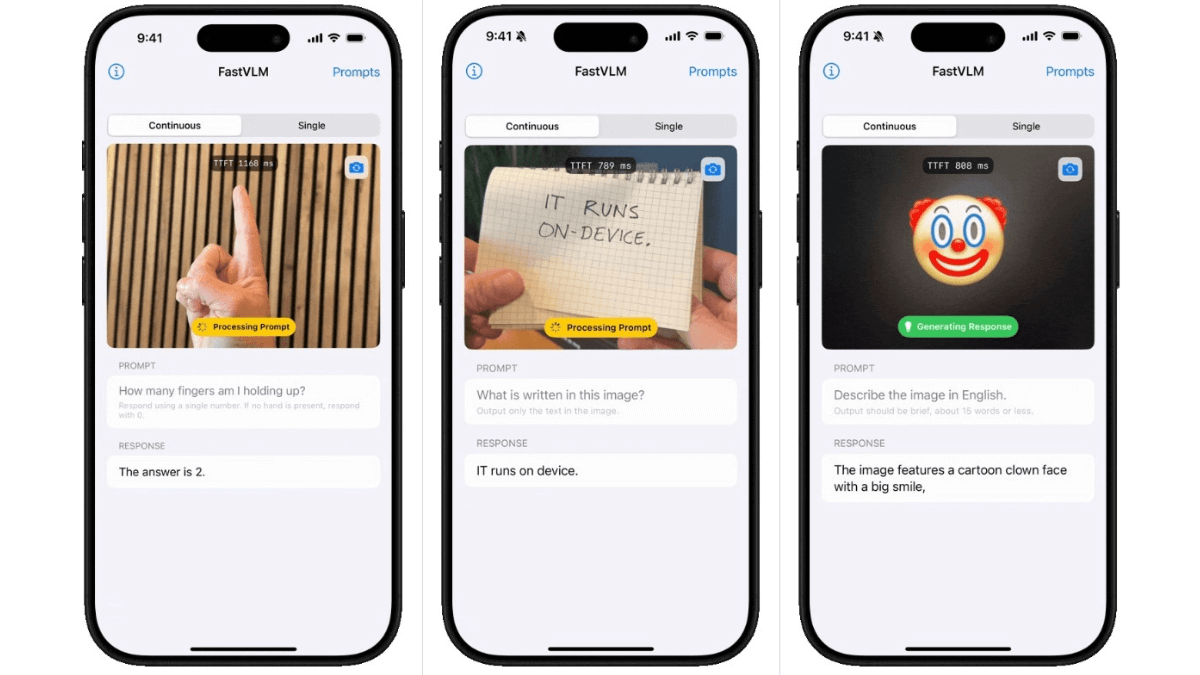

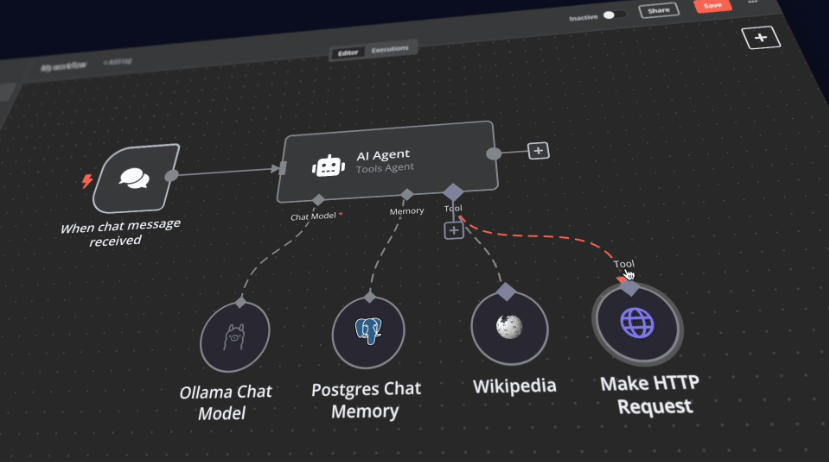

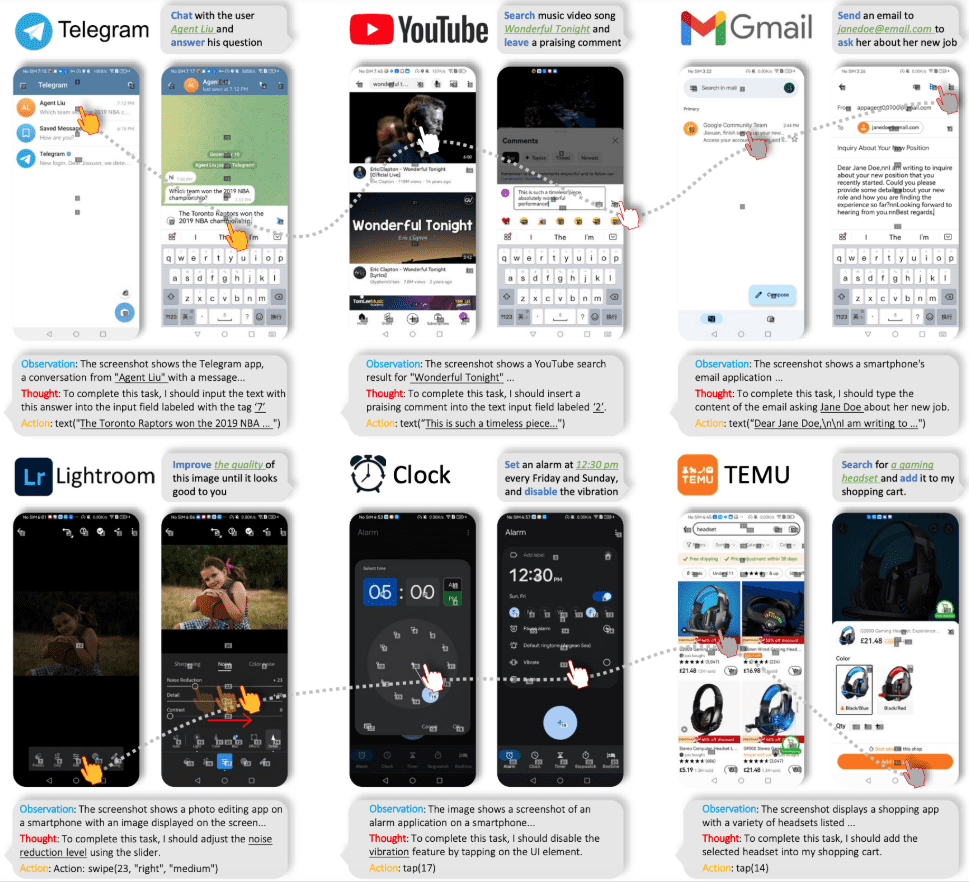

AppAgentは、スマートフォンのアプリケーションを操作するために設計されたLarge Language Model(LLM)に基づくマルチモーダルエージェントフレームワークです。このフレームワークは、タップやスワイプのような人間のインタラクションを模倣した簡略化された操作空間を通じて、異なるアプリケーション間での適用性を拡大し、システムのバックエンドへのアクセスを不要にします。AppAgentは、自律的に探索したり人間のデモンストレーションを観察したりすることで新しいアプリケーションの使い方を学習し、複雑なタスクを実行するための知識ベースを生成します。

テンセントは、現在の携帯電話のインターフェースとユーザーのコマンドを認識することで、携帯電話のインターフェースを直接操作することができ、実際のユーザーのように携帯電話を操作することができるマルチモーダルインテリジェントボディ「AppAgent」を発表した!例えば、写真編集ソフトを操作して写真を編集したり、地図アプリケーションを開いてナビゲートしたり、ショッピングをしたりすることができる。

プロジェクト・ホームページ:https://appagent-official.github.io

論文へのリンク:https://arxiv.org/abs/2312.13771

学位論文の抄録

近年の大規模言語モデル(Large Language Models: LLM)の進歩により、複雑なタスクを実行できる知的なスマートボディが作成されている。本稿では、スマートフォンアプリを操作するために設計された、ラージ・ランゲージ・モデルに基づくインテリジェント・ボディのための新しいマルチモーダルなフレームワークを紹介する。本フレームワークは、あたかも人間がクリック&スワイプ操作を行っているかのように、簡略化された操作空間を通してスマートフォンアプリを操作することを可能にする。この革新的なアプローチは、システムのバックエンドへの直接アクセスを必要としないため、さまざまなアプリケーションに適しています。インテリジェント・ボディの機能の中核には、学習に対する革新的なアプローチがあります。インテリジェント・ボディは、自己探索や人間の実演を観察することで、新しいアプリケーションのナビゲートや使い方を学習する。その過程で、さまざまなアプリケーションで複雑なタスクを実行するための知識ベースを構築します。我々のインテリジェンスの有用性を実証するため、ソーシャルメディア、電子メール、地図、ショッピング、複雑な画像編集ツールなど、10種類のアプリケーションにおける50のタスクについて徹底的にテストした。テスト結果は、私たちのインテリジェンスが幅広い高度なタスクを効率的に処理できることを示しています。

機能一覧

- 自主探索エージェントは自律的にアプリケーションを探索し、インタラクティブな要素を記録し、ドキュメントを作成することができます。

- 人間デモンストレーション学習エージェントは人間の実演を観察することでタスクを学習し、適切な文書を生成する。

- 指令の実施展開段階では、エージェントは生成されたドキュメントに基づいて複雑なタスクを実行する。

- マルチモーダル入力GPT-4VまたはQwen-VL-Maxモデルを使用し、テキスト入力とビジュアル入力の両方に対応。

- CAPTCHA処理CAPTCHAによる認証が可能です。

- UI要素の認識タグのないUI要素を配置するには、グリッドオーバーレイを使用します。

ヘルプの使用

インストールと設定

- ダウンロードとインストールGitHubページからプロジェクトファイルをダウンロードし、必要な依存関係をインストールします。

- 設定ファイルルート・ディレクトリの

config.yamlファイルを使用して、GPT-4V または Qwen-VL-Max モデルの API キーを設定します。 - 接続機器USBを使用してAndroidデバイスを接続し、開発者向けオプションでUSBデバッグを有効にします。

自己探求モデル

- 探査開始走る

learn.pyファイルを開き、自律探索モードを選択し、アプリケーション名とタスクの説明を入力する。 - 相互作用の記録エージェントは自動的にアプリケーションを探索し、インタラクション要素を記録し、ドキュメントを生成します。

人間デモンストレーション・モード

- スタートアップ・デモ走る

learn.pyファイルを開き、Human Demo Modeを選択し、アプリケーション名とタスクの説明を入力する。 - エグゼクティブ・デモエージェントがすべてのやりとりを記録し、文書を作成します。

指令の実施

- タスクを開始する走る

run.pyファイルを作成し、アプリケーション名とタスクの説明を入力し、適切なドキュメント・ライブラリを選択します。 - 操作するエージェントは、ドキュメントに基づいて複雑なオペレーションを完了するためのタスクを実行します。

詳しい操作手順

- ダウンロード・プロジェクトGitHubのページにアクセスし、プロジェクトファイルをダウンロードして展開する。

- 依存関係のインストールターミナルで実行

pip install -r requirements.txtすべての依存関係をインストールします。 - 構成モデル必要に応じて修正する

config.yamlファイルを使用して、GPT-4V または Qwen-VL-Max モデルの API キーを設定します。 - 接続機器USBを使用してAndroidデバイスを接続し、デバイスのUSBデバッグモードを有効にします。

- 探索またはデモンストレーションを開始する走る

learn.pyファイルを開き、自律探索または人間デモンストレーション・モードを選択し、アプリケーション名とタスクの説明を入力する。 - ドキュメントの作成エージェントはすべてのインタラクションを記録し、その後のタスク実行のためのドキュメントを作成する。

- 操作する走る

run.pyアプリケーション名とタスクの説明を入力し、適切なドキュメントライブラリを選択すると、エージェントはドキュメントに基づいてタスクを実行します。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません