Génération Agentique Intelligente de Récupération Améliorée : un aperçu de la technologie Agentique RAG

résumés

Les grands modèles de langage (LLM), tels que le GPT-4 d'OpenAI, le PaLM de Google et le LLaMA de Meta, ont radicalement changé l'intelligence artificielle (IA) en permettant la génération de textes semblables à ceux des humains et la compréhension du langage naturel. Cependant, leur dépendance à l'égard de données d'apprentissage statiques limite leur capacité à répondre à des requêtes dynamiques en temps réel, ce qui se traduit par des résultats obsolètes ou inexacts. La génération augmentée par récupération (RAG) est apparue comme une solution pour augmenter les LLM en intégrant la récupération de données en temps réel afin de fournir des réponses contextuelles pertinentes et opportunes. Malgré les promesses de la RAG, les systèmes traditionnels de RAG sont limités en termes de flux de travail statiques et manquent de la flexibilité nécessaire pour prendre en compte le raisonnement en plusieurs étapes et la gestion de tâches complexes.

La génération augmentée de recherche agentique (RAG agentique) surmonte ces limitations en intégrant des agents d'intelligence artificielle autonomes dans le processus de RAG. Ces agents utilisent des modèles de conception agentique - réflexion, planification, utilisation d'outils et collaboration multi-agents - pour gérer dynamiquement les stratégies de recherche, affiner de manière itérative la compréhension du contexte et adapter les flux de travail afin de répondre aux exigences de tâches complexes. Cette intégration permet au système Agentic RAG d'offrir une flexibilité, une évolutivité et une prise en compte du contexte inégalées dans un large éventail d'applications.

Cette étude explore de manière exhaustive la RAG agentique, en commençant par ses principes sous-jacents et l'évolution du paradigme de la RAG. Il détaille la catégorisation des architectures RAG agentiques, met en évidence leurs principales applications dans des secteurs tels que les soins de santé, la finance et l'éducation, et explore des stratégies de mise en œuvre pratiques. En outre, il aborde les défis liés à la mise à l'échelle de ces systèmes, à la garantie d'une prise de décision éthique et à l'optimisation des performances des applications du monde réel, tout en donnant un aperçu détaillé des cadres et des outils de mise en œuvre de la RAG agentique.

Mots-clés. Grands modèles de langage (LLM) - Intelligence artificielle (IA) - Compréhension du langage naturel - Retrieval Augmented Generation (RAG) - RAG agentique - Agents autonomes d'IA - Réflexion - Planification - Utilisation d'outils - Collaboration multi-agents - Modèles agentiques - Compréhension contextuelle - Adaptation dynamique - Évolutivité - Récupération de données en temps réel - Classification RAG agentique - Applications dans le domaine de la santé - Applications dans le domaine financier - Applications dans le domaine de l'éducation - Prise de décision éthique en IA - Optimisation des performances - Raisonnement à plusieurs étapes

1 Introduction

Les grands modèles de langage (LLM) [1, 2] [3], tels que le GPT-4 d'OpenAI, le PaLM de Google et le LLaMA de Meta, ont radicalement changé l'intelligence artificielle (IA) en générant des textes semblables à ceux des humains et en effectuant des tâches complexes de traitement du langage naturel. Ces modèles ont stimulé l'innovation dans le domaine du dialogue [4], notamment les agents conversationnels, la création automatisée de contenu et la traduction en temps réel. Des progrès récents ont étendu leurs capacités à des tâches multimodales telles que la génération de texte à image et de texte à vidéo [5], permettant la création et l'édition de vidéos et d'images basées sur des invites détaillées [6], ce qui élargit l'éventail des applications potentielles de l'IA générative.

Malgré ces progrès, les LLM sont toujours confrontés à des limitations importantes en raison de leur dépendance à l'égard des données statiques de pré-entraînement. Cette dépendance entraîne généralement des informations obsolètes, des réponses fantômes [7] et une incapacité à s'adapter aux scénarios dynamiques du monde réel. Ces défis soulignent la nécessité de systèmes capables d'intégrer des données en temps réel et d'affiner dynamiquement les réponses pour maintenir la pertinence et la précision du contexte.

Retrieval Augmented Generation (RAG) [8, 9] est apparu comme une solution prometteuse à ces défis. RAG améliore la pertinence et la rapidité des réponses en combinant les capacités génératives des LLM avec des mécanismes de recherche externes [10]. Ces systèmes récupèrent des informations en temps réel à partir de sources telles que les bases de connaissances [11], les API ou le Web, comblant ainsi le fossé entre les données d'apprentissage statiques et les exigences dynamiques des applications. Cependant, les flux de travail RAG traditionnels sont toujours limités par leur conception linéaire et statique, ce qui limite leur capacité à effectuer des raisonnements complexes en plusieurs étapes, à intégrer une compréhension approfondie du contexte et à affiner les réponses de manière itérative.

L'évolution des agents [12] a encore renforcé les capacités des systèmes d'IA. Les agents modernes, y compris les agents mobiles et basés sur le LLM [13], sont des entités intelligentes capables de percevoir, de raisonner et d'exécuter des tâches de manière autonome. Ces agents utilisent des modèles de flux de travail basés sur les agents, tels que la réflexion [14], la planification [15], l'utilisation d'outils et la collaboration multi-agents [16], ce qui leur permet de gérer des flux de travail dynamiques et de résoudre des problèmes complexes.

La convergence de la RAG et de l'intelligence agentique a donné naissance à la génération augmentée de recherche agentique (RAG agentique) [17], un paradigme qui intègre des agents dans le processus de RAG. La RAG agentique met en œuvre des stratégies de recherche dynamiques, une compréhension contextuelle et un raffinement itératif [18], permettant un traitement adaptatif et efficace de l'information. Contrairement à la RAG traditionnelle, la RAG agentique emploie des agents autonomes pour orchestrer la recherche, filtrer les informations pertinentes et affiner les réponses, et elle excelle dans les scénarios qui exigent précision et adaptabilité.

Cette étude explore les principes sous-jacents, la classification et les applications des RAG agentiques. Il donne un aperçu complet des paradigmes de RAG tels que le RAG simple, le RAG modulaire et le RAG graphique [19] et de leur évolution vers les systèmes de RAG agentiques. Les principales contributions comprennent une classification détaillée des cadres de RAG agentiques, des applications dans des domaines tels que les soins de santé [20, 21], la finance et l'éducation [22], ainsi qu'un aperçu des stratégies de mise en œuvre, de l'évaluation comparative et des considérations éthiques.

Le document est structuré comme suit : la section 2 présente RAG et son évolution, en soulignant les limites des approches traditionnelles. La section 3 détaille les principes de l'intelligence agentique et les modèles agentiques. La section 4 présente une classification des systèmes de RAG agentiques, y compris les cadres mono-agent, multi-agent et basés sur les graphes. La section 5 examine les applications de la RAG agentique, tandis que la section 6 traite des outils de mise en œuvre et des cadres. La section 7 se concentre sur les repères et les ensembles de données, et la section 8 conclut sur les orientations futures des systèmes de RAG agentiques.

2 Base pour la génération d'améliorations de la recherche

2.1 Aperçu de la Génération Augmentée de Récupération (GAR)

La génération augmentée par récupération (RAG) représente une avancée majeure dans le domaine de l'intelligence artificielle, en combinant la puissance générative des grands modèles de langage (LLM) avec la récupération de données en temps réel. Bien que les LLM aient démontré des capacités exceptionnelles dans le traitement du langage naturel, leur dépendance à l'égard des données statiques de pré-entraînement se traduit souvent par des réponses obsolètes ou incomplètes. RAG remédie à cette limitation en récupérant dynamiquement des informations pertinentes à partir de sources externes et en les incorporant dans le processus de génération, ce qui permet de générer des résultats contextuellement exacts et réactifs en temps opportun.

2.2 Principaux éléments du RAG

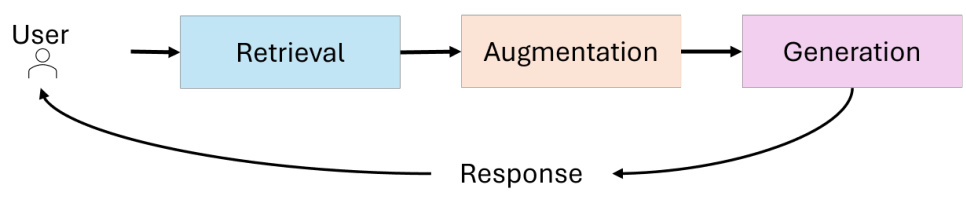

L'architecture du système RAG intègre trois composants principaux (voir figure 1) :

- récupérer (données)Les chercheurs sont chargés d'interroger des sources de données externes telles que des bases de connaissances, des API ou des bases de données vectorielles. Les extracteurs avancés utilisent la recherche vectorielle dense et des modèles basés sur des transformateurs pour améliorer la précision de l'extraction et la pertinence sémantique.

- renforcerTraitement des données : traiter les données récupérées pour extraire et résumer les informations les plus pertinentes par rapport au contexte de la requête.

- générantLa combinaison des informations récupérées avec la connaissance pré-entraînée du LLM pour générer des réponses cohérentes et adaptées au contexte.

Figure 1 : Composantes essentielles de la RAG

2.3 Évolution du paradigme RAG

Le domaine de la génération augmentée de recherche (RAG) a fait des progrès significatifs pour faire face à la complexité croissante des applications du monde réel où la précision contextuelle, l'évolutivité et le raisonnement en plusieurs étapes sont essentiels. Partant d'une simple recherche par mot clé, elle s'est transformée en systèmes complexes, modulaires et adaptatifs capables d'intégrer diverses sources de données et des processus décisionnels autonomes. Cette évolution met en évidence le besoin croissant de systèmes RAG capables de traiter des requêtes complexes de manière efficace et efficiente.

Cette section examine l'évolution du paradigme des RAG, en décrivant les principales étapes du développement - RAG simple, RAG avancé, RAG modulaire, RAG graphique et RAG basé sur des agents - ainsi que leurs caractéristiques, leurs forces et leurs limites. En comprenant l'évolution de ces paradigmes, le lecteur peut apprécier les progrès réalisés dans les capacités de recherche et de génération, ainsi que leurs applications dans divers domaines.

2.3.1 RAG simple

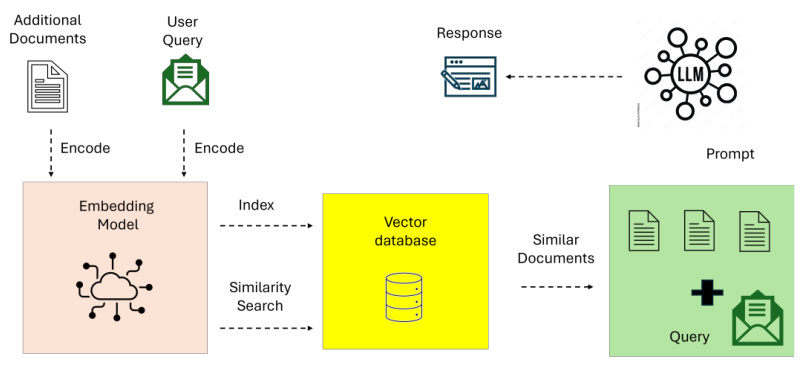

Le RAG simple [23] représente la mise en œuvre de base de la génération améliorée par la recherche. La figure 2 illustre des RAG simples pour des flux de travail de recherche et de lecture simples, en mettant l'accent sur la recherche par mot-clé et les ensembles de données statiques. Ces systèmes s'appuient sur des techniques simples d'extraction par mot-clé, telles que TF-IDF et BM25, pour extraire des documents d'ensembles de données statiques. Les documents récupérés sont ensuite utilisés pour améliorer la génération de modèles linguistiques.

Figure 2 : Vue d'ensemble de Naive RAG.

Le RAG simple se caractérise par sa simplicité et sa facilité de mise en œuvre, et convient aux tâches impliquant des requêtes basées sur des faits avec une complexité contextuelle minimale. Il présente toutefois plusieurs limites :

- Manque de connaissance du contexteLes documents retrouvés ne parviennent souvent pas à saisir les nuances sémantiques d'une requête parce qu'ils reposent sur la correspondance lexicale plutôt que sur la compréhension sémantique.

- Fragmentation de la productionL'absence de prétraitement avancé ou d'intégration contextuelle conduit souvent à des réponses incohérentes ou trop génériques.

- problème d'évolutivitéLes techniques de recherche basées sur les mots-clés ont tendance à donner de mauvais résultats lorsqu'elles traitent de grands ensembles de données et ne parviennent généralement pas à identifier les informations les plus pertinentes.

Malgré ces limites, le système simple RAG fournit une preuve de concept essentielle pour combiner la recherche et la génération, jetant les bases de paradigmes plus complexes.

2.3.2 RAG avancé

Les systèmes RAG avancés [23] s'appuient sur les limites des systèmes RAG simples en intégrant la compréhension sémantique et des techniques de recherche améliorées. La figure 3 met en évidence l'amélioration sémantique et le processus itératif et contextuel de la RAG avancée dans la recherche. Ces systèmes utilisent des modèles de recherche dense tels que la recherche de paragraphes denses (DPR) et des algorithmes de classement neuronal pour améliorer la précision de la recherche.

Figure 3 : Vue d'ensemble de l'Advanced RAG

Les principales caractéristiques de l'Advanced RAG sont les suivantes

- Recherche vectorielle denseLes requêtes et les documents sont représentés dans un espace vectoriel de haut niveau, ce qui permet un meilleur alignement sémantique entre les requêtes de l'utilisateur et les documents récupérés.

- réorganisation du contexteLe modèle neuronal réorganise les documents recherchés afin de donner la priorité aux informations les plus pertinentes sur le plan contextuel.

- Recherche itérativeLe RAG avancé introduit un mécanisme de recherche multi-sauts qui permet de raisonner sur des requêtes complexes à travers de multiples documents.

Grâce à ces progrès, les RAG avancés conviennent aux applications qui exigent une grande précision et une compréhension nuancée, telles que la synthèse de la recherche et les recommandations personnalisées. Toutefois, les problèmes de surcharge de calcul et d'évolutivité limitée demeurent, en particulier lorsqu'il s'agit de grands ensembles de données ou de requêtes en plusieurs étapes.

2.3.3 RAG modulaire

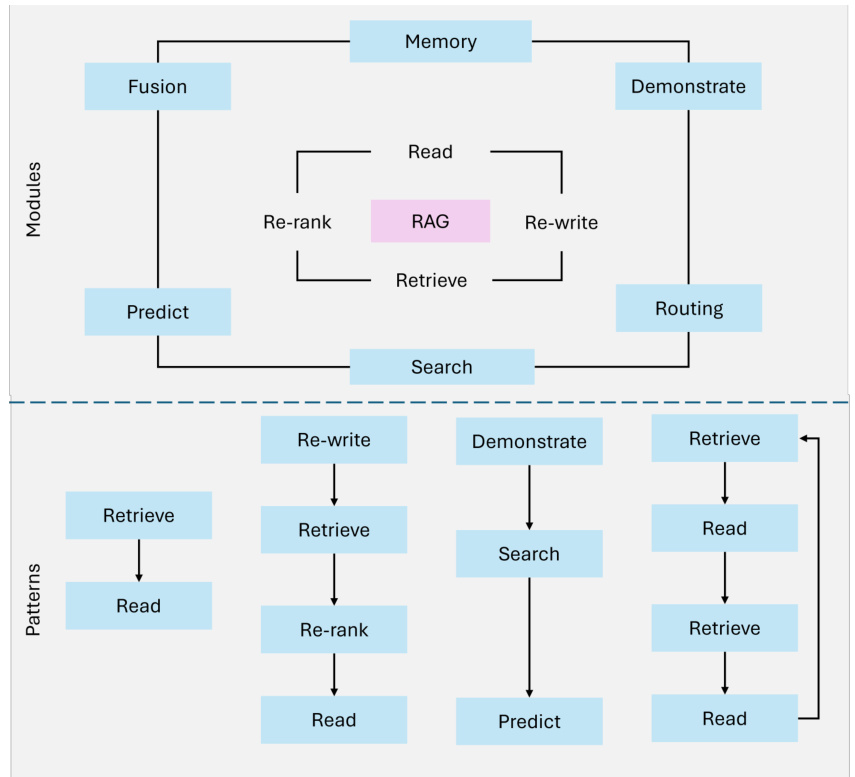

Les RAG modulaires [23] représentent la dernière évolution du paradigme des RAG et mettent l'accent sur la flexibilité et la personnalisation. Ces systèmes décomposent les processus de recherche et de génération en composants distincts et réutilisables afin de permettre une optimisation spécifique au domaine et une adaptabilité de la tâche. La figure 4 illustre l'architecture modulaire, avec des stratégies de recherche hybrides, des processus composables et l'intégration d'outils externes.

Les principales innovations du RAG modulaire sont les suivantes

- stratégie de recherche hybrideLa recherche d'informations dans les documents de l'entreprise : Combinaison de méthodes de recherche éparses (par exemple, Sparse Encoder - BM25) et de techniques de recherche denses (par exemple, DPR - Dense Paragraph Retrieval) afin de maximiser la précision pour différents types de requêtes.

- intégration des outilsLes applications de calcul : Intégrer des API externes, des bases de données ou des outils de calcul pour traiter des tâches spécifiques, telles que l'analyse de données en temps réel ou des calculs spécifiques à un domaine.

- Processus composablesLe RAG modulaire permet de remplacer, d'augmenter ou de reconfigurer les récupérateurs, les générateurs et d'autres composants, ce qui permet un degré élevé d'adaptation à des cas d'utilisation spécifiques.

Par exemple, un système RAG modulaire conçu pour l'analyse financière pourrait récupérer les cours boursiers en temps réel par le biais d'une API, analyser les tendances historiques à l'aide d'une recherche intensive et générer des informations exploitables en matière d'investissement grâce à un modèle linguistique personnalisé. Grâce à cette modularité et à cette personnalisation, le système RAG modulaire est bien adapté aux tâches complexes et pluridisciplinaires, offrant à la fois évolutivité et précision.

Figure 4 : Vue d'ensemble du système modulaire RAG

2.3.4 Figure RAG

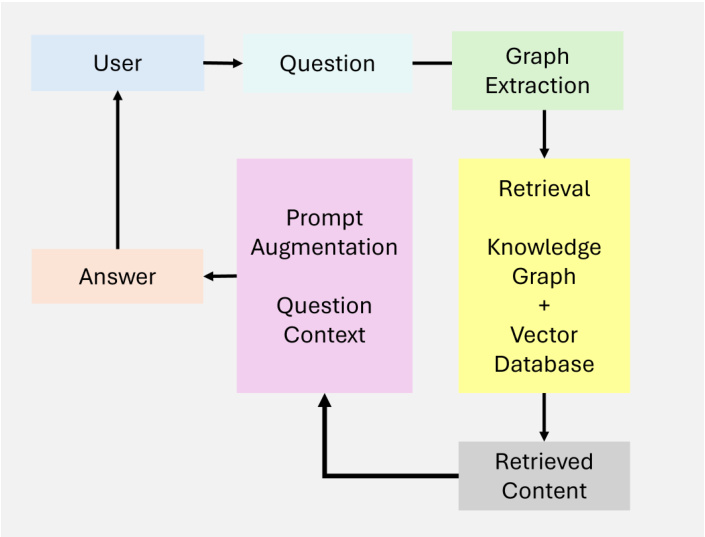

Graph RAG [19] étend les systèmes traditionnels de génération d'amélioration de la recherche en intégrant des structures de données basées sur les graphes, comme le montre la figure 5. Ces systèmes utilisent les relations et les hiérarchies dans les données graphiques pour améliorer le raisonnement multi-sauts et l'amélioration contextuelle. En intégrant la recherche basée sur les graphes, les RAG graphiques sont en mesure de produire des résultats plus riches et plus précis, en particulier pour les tâches qui nécessitent une compréhension relationnelle.

La figure RAG se caractérise par sa capacité à :

- connectivité des nœudsLes relations entre les entités : saisir et raisonner sur les relations entre les entités.

- Gestion hiérarchique des connaissancesLa gestion des données structurées et non structurées par l'intermédiaire de hiérarchies de graphes.

- sensible au contexteLes chemins d'accès aux graphes : Ajouter une compréhension relationnelle en utilisant les chemins d'accès aux graphes.

Cependant, le graphique RAG présente certaines limites :

- Extensibilité limitéeLes données de l'enquête sur l'utilisation de l'Internet : La dépendance à l'égard de la structure des graphes peut limiter l'évolutivité, en particulier pour un large éventail de sources de données.

- Dépendance à l'égard des donnéesLe projet : Des données graphiques de haute qualité sont essentielles pour obtenir des résultats significatifs, ce qui limite son application à des ensembles de données non structurés ou mal annotés.

- Complexité de l'intégrationLe rapport : L'intégration de données graphiques dans des systèmes de recherche non structurés accroît la complexité de la conception et de la mise en œuvre.

Graph RAG est bien adapté aux applications dans des domaines tels que le diagnostic médical et la recherche juridique, où le raisonnement sur les relations structurées est essentiel.

Figure 5 : Aperçu du graphique RAG

2.3.5 RAG par procuration

Les RAG basés sur des agents représentent un changement de paradigme en introduisant des agents autonomes capables de prendre des décisions dynamiques et d'optimiser le flux de travail. Contrairement aux systèmes statiques, les RAG basés sur des agents emploient des stratégies de raffinement itératif et de recherche adaptative pour faire face à des requêtes complexes, en temps réel et multi-domaines. Ce paradigme exploite la modularité du processus de recherche et de génération tout en introduisant l'autonomie des agents.

Les principales caractéristiques du RAG basé sur des agents sont les suivantes

- autodéterminationLes agents évaluent et gèrent de manière indépendante les stratégies de recherche en fonction de la complexité de la requête.

- Raffinement itératifLes résultats de l'évaluation de l'efficacité de la recherche et de la pertinence de la réponse : Intégrer des boucles de rétroaction pour améliorer la précision de la recherche et la pertinence de la réponse.

- Optimisation du flux de travail: Planification dynamique des tâches pour rendre les applications en temps réel plus efficaces.

Malgré ces avancées, les RAG basés sur des agents sont confrontés à un certain nombre de défis :

- Complexité de la coordinationLa gestion des interactions entre les agents nécessite des mécanismes de coordination complexes.

- surcharge de calculLes agents de la Commission européenne : L'utilisation de plusieurs agents augmente les besoins en ressources pour les flux de travail complexes.

- contraintes d'évolutivitéLe système est évolutif, mais sa nature dynamique peut exercer une pression sur les gros volumes de requêtes.

Les RAG basés sur des agents ont excellé dans des applications telles que l'assistance à la clientèle, l'analyse financière et les plateformes d'apprentissage adaptatif, où l'adaptabilité dynamique et la précision contextuelle sont essentielles.

2.4 Défis et limites des systèmes traditionnels de GCR

Les systèmes traditionnels de génération augmentée de recherche (RAG) ont considérablement étendu les capacités des grands modèles de langage (LLM) en intégrant la recherche de données en temps réel. Cependant, ces systèmes sont toujours confrontés à un certain nombre de défis majeurs qui entravent leur efficacité dans les applications complexes du monde réel. Les limitations les plus notables concernent l'intégration du contexte, le raisonnement en plusieurs étapes et les problèmes d'évolutivité et de latence.

2.4.1 Intégration contextuelle

Même lorsque les systèmes RAG parviennent à récupérer des informations pertinentes, ils ont souvent du mal à les intégrer de manière transparente dans la réponse générée. La nature statique du processus de recherche et la connaissance limitée du contexte conduisent à des résultats fragmentés, incohérents ou trop génériques.

EXEMPLE : Une requête telle que "Les progrès récents de la recherche sur la maladie d'Alzheimer et leurs implications pour un traitement précoce" peut générer des articles scientifiques et des lignes directrices médicales pertinents. Cependant, les systèmes traditionnels de RAG sont souvent incapables de synthétiser ces résultats en explications cohérentes qui relient les nouveaux traitements à des scénarios de patients spécifiques. De même, pour une question telle que "Quelles sont les meilleures pratiques durables pour l'agriculture à petite échelle dans les régions arides ?", un système conventionnel peut extraire des articles sur les méthodes agricoles générales, mais omettre des pratiques durables d'une importance cruciale pour les environnements arides.

Tableau 1. Analyse comparative des paradigmes RAG

| Paradigme | Caractéristiques principales | Points forts |

|---|---|---|

| RAG naïf | - Basé sur des mots-clés récupération (par exemple, TF-IDF. BM25) | - Simple et facile à mettre en œuvre - Convient aux requêtes basées sur des faits |

| RAG avancé | - Modèles de recherche denses (par exemple, DPR) - Classement et reclassement neuronaux - Recherche multi-sauts | - Recherche de haute précision - Amélioration du contexte pertinence |

| RAG modulaire | - Recherche hybride (peu dense et dense) - Intégration d'outils et d'API - Pipelines composables et spécifiques à un domaine | - Grande flexibilité et personnalisation - Convient à diverses applications - Évolutif |

| Graphique RAG | - Intégration de structures basées sur des graphes - Raisonnement multi-sauts - Enrichissement contextuel via les nœuds | - Capacités de raisonnement relationnel - Atténuation des hallucinations - Idéal pour les tâches liées aux données structurées |

| RAG agentique | - Agents autonomes - Prise de décision dynamique - Raffinement itératif et flux de travail optimisation | - Adaptable aux changements en temps réel - Évolutif pour les tâches multi-domaines - Haute précision |

2.4.2 Raisonnement en plusieurs étapes

De nombreuses requêtes dans le monde réel nécessitent un raisonnement itératif ou multi-sauts, c'est-à-dire la récupération et la synthèse d'informations à partir de plusieurs étapes. Les systèmes traditionnels de RAG sont souvent mal préparés pour affiner la recherche sur la base d'informations intermédiaires ou du retour d'information de l'utilisateur, ce qui se traduit par des réponses incomplètes ou décousues.

Exemple : une question complexe telle que "Quelles leçons tirées des politiques européennes en matière d'énergies renouvelables peuvent être appliquées aux pays en développement et quels sont les impacts économiques potentiels ?" De nombreux éléments d'information doivent être réconciliés, y compris les données politiques, la contextualisation aux régions en développement et l'analyse économique. Les systèmes traditionnels de GCR sont souvent incapables de relier ces éléments disparates en une réponse cohérente.

2.4.3 Problèmes d'évolutivité et de latence

Avec l'augmentation du nombre de sources de données externes, l'interrogation et le classement de grands ensembles de données deviennent de plus en plus intensifs en termes de calcul. Cela entraîne une latence importante, qui compromet la capacité du système à fournir des réponses en temps voulu dans les applications en temps réel.

Exemple : dans les environnements où le temps est compté, comme l'analyse financière ou l'assistance à la clientèle en temps réel, les retards dus à l'interrogation de plusieurs bases de données ou à l'utilisation de vastes ensembles de documents peuvent réduire l'utilité globale du système. Par exemple, les retards dans l'extraction des tendances du marché dans le domaine du trading à haute fréquence peuvent faire manquer des opportunités.

2.5 RAG à base d'agents : un changement de paradigme

Les systèmes de RAG traditionnels, avec leurs flux de travail statiques et leur capacité d'adaptation limitée, ont souvent du mal à gérer les raisonnements dynamiques à plusieurs étapes et les tâches complexes du monde réel. En intégrant des agents autonomes capables de prendre des décisions dynamiques, d'effectuer des raisonnements itératifs et de mettre en œuvre des stratégies de recherche adaptatives, les RAG basés sur des agents surmontent leurs limites inhérentes tout en conservant la modularité des paradigmes antérieurs. Cette évolution permet de résoudre des tâches plus complexes et multi-domaines avec une précision accrue et une meilleure compréhension du contexte, ce qui positionne les RAG basés sur des agents comme la base de la prochaine génération d'applications d'IA. En particulier, les systèmes RAG basés sur des agents réduisent la latence grâce à des flux de travail optimisés et affinent les résultats de manière incrémentale, en relevant les défis qui ont longtemps entravé l'évolutivité et l'efficacité des RAG traditionnels.

3 Principes fondamentaux et contexte de l'intelligence des agents

L'intelligence des agents constitue la base des systèmes de Génération Augmentée de Récupération (GAR) basés sur des agents, leur permettant d'aller au-delà de la nature statique et réactive de la GAR traditionnelle. En intégrant des agents autonomes capables de prendre des décisions dynamiques, de raisonner par itération et de travailler en collaboration, les systèmes de RAG basés sur des agents font preuve d'une plus grande adaptabilité et d'une plus grande précision. Cette section explore les principes fondamentaux qui sous-tendent l'intelligence des agents.

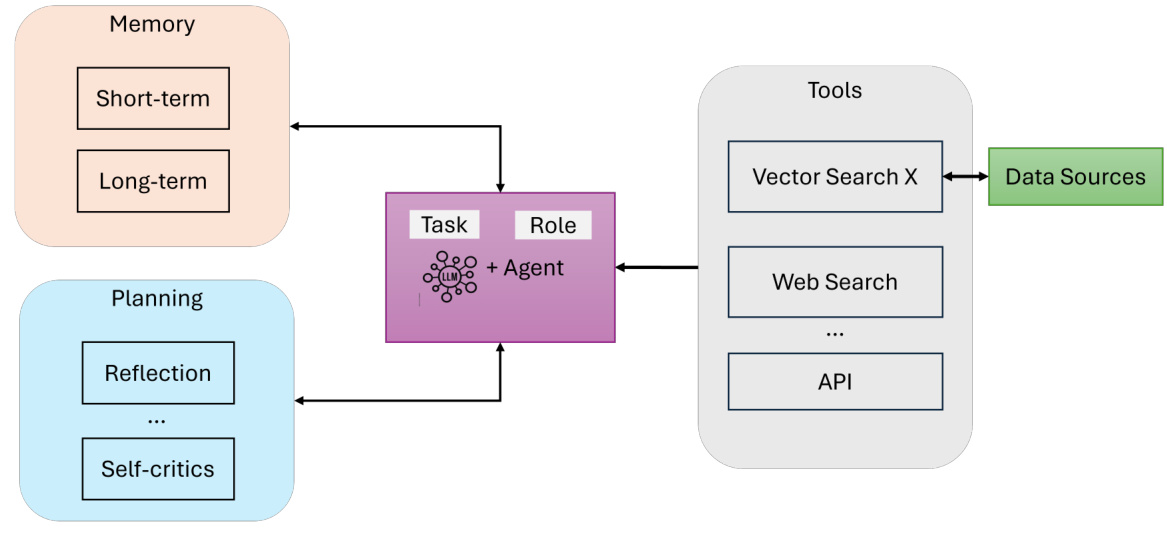

Composantes d'un agent d'intelligence artificielle. Un agent d'intelligence artificielle se compose essentiellement des éléments suivants (voir figure 6) :

- LLM (avec des rôles et des tâches définis)Le moteur de raisonnement : il sert de moteur de raisonnement principal et d'interface de dialogue pour l'agent. Il interprète les requêtes des utilisateurs, génère des réponses et maintient la cohérence.

- Mémoire (à court et à long terme)La mémoire à court terme [25] permet de suivre l'état immédiat du dialogue. La mémoire à court terme [25] enregistre l'état immédiat du dialogue, tandis que la mémoire à long terme [25] stocke les connaissances accumulées et l'expérience de l'agent.

- Planification (réflexion et autocritique)Les tâches complexes sont décomposées de manière efficace [15] en guidant le processus de raisonnement itératif de l'agent par la réflexion, l'acheminement des requêtes ou l'autocritique [26].

- Outils (recherche vectorielle, recherche sur le web, API, etc.)Les agents peuvent aller au-delà de la génération de texte et accéder à des ressources externes, à des données en temps réel ou à des systèmes informatiques spécialisés.

Figure 6 : Aperçu des agents d'intelligence artificielle

3.1 Modèle de procuration

Les modèles d'agents [27, 28] fournissent des moyens structurés pour guider le comportement des agents dans les systèmes de génération augmentée de recherche (RAG) basés sur des agents. Ces modèles permettent aux agents de s'adapter, de planifier et de collaborer de manière dynamique, ce qui garantit que le système peut traiter de manière précise et évolutive des tâches complexes dans le monde réel. Quatre modèles clés constituent la base du flux de travail des agents :

3.1.1 Réflexion

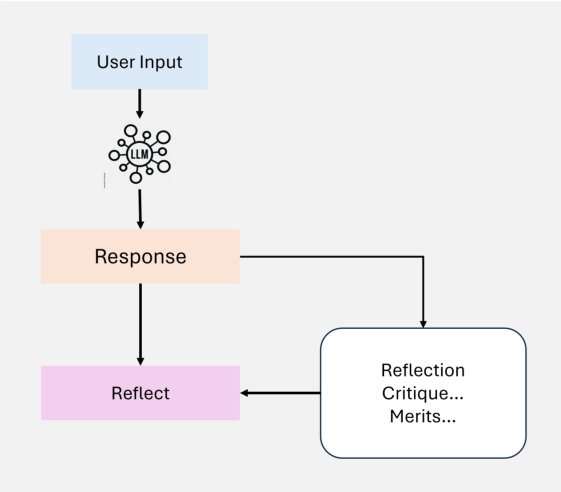

La réflexion est un modèle de conception fondamental dans le flux de travail de l'agent qui permet à l'agent d'évaluer et d'affiner ses résultats de manière itérative. En intégrant un mécanisme d'auto-rétroaction, l'agent peut identifier et résoudre les erreurs, les incohérences et les domaines à améliorer, améliorant ainsi la performance de tâches telles que la génération de code, la génération de texte et les questions-réponses (comme le montre la figure 7). En pratique, la réflexion consiste à inciter l'agent à critiquer sa production en termes de correction, de style et d'efficacité, puis à incorporer ce retour d'information dans les itérations suivantes. Des outils externes, tels que des tests unitaires ou des recherches sur le web, peuvent encore améliorer ce processus en validant les résultats et en mettant en évidence les lacunes.

Figure 7 : Vue d'ensemble de l'auto-agencement Réflexion

Dans les systèmes multi-agents, la réflexion peut impliquer différents rôles, par exemple un agent génère le résultat tandis qu'un autre agent le critique, ce qui facilite l'amélioration collaborative. Par exemple, dans le domaine de la recherche juridique, les agents peuvent affiner les réponses de manière itérative pour garantir l'exactitude et l'exhaustivité en réévaluant la jurisprudence extraite. La réflexion a montré des gains de performance significatifs dans des études telles que Self-Refine [29], Reflexion [30] et CRITIC [26].

3.1.2 Planification

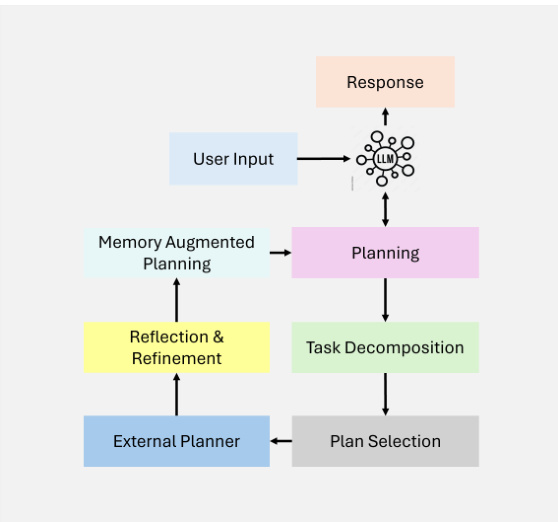

La planification [15] est un modèle de conception clé dans les flux de travail des agents qui leur permet de décomposer de manière autonome des tâches complexes en sous-tâches plus petites et plus faciles à gérer. Cette capacité est essentielle pour le raisonnement multi-sauts et la résolution itérative de problèmes dans des scénarios dynamiques et incertains (comme le montre la figure 8).

Figure 8 : Vue d'ensemble de la planification agentique

En utilisant la planification, les agents peuvent déterminer de manière dynamique la séquence des étapes nécessaires pour atteindre des objectifs plus importants. Cette capacité d'adaptation permet aux agents de s'attaquer à des tâches qui ne peuvent être prédéfinies, ce qui garantit une certaine souplesse dans la prise de décision. Bien que puissante, la planification peut produire des résultats moins prévisibles que les flux de travail déterministes tels que la réflexion. La planification est particulièrement adaptée aux tâches qui nécessitent une adaptation dynamique, lorsque les flux de travail prédéfinis ne sont pas suffisants. Au fur et à mesure que la technologie mûrit, son potentiel de développement d'applications innovantes dans tous les domaines continuera de croître.

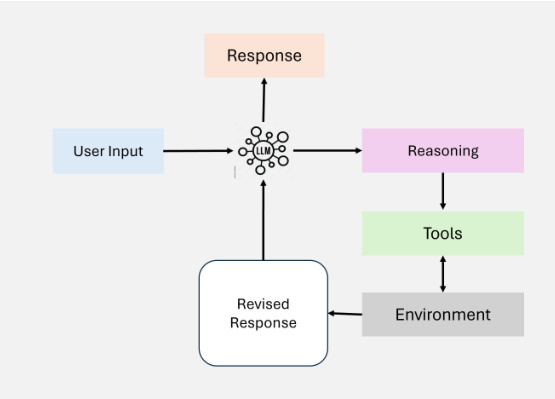

3.1.3 Utilisation d'outils

L'utilisation d'outils permet aux agents d'étendre leurs capacités en interagissant avec des outils externes, des API ou des ressources informatiques, comme le montre la figure 9. Ce modèle permet à l'agent de recueillir des informations, d'effectuer des calculs et de manipuler des données au-delà de ses connaissances préformées. En intégrant dynamiquement des outils dans le flux de travail, les agents peuvent s'adapter à des tâches complexes et fournir des résultats plus précis et adaptés au contexte.

Figure 9 : Aperçu de l'utilisation des outils

Les flux de travail des agents modernes intègrent l'utilisation d'outils dans une variété d'applications, y compris la recherche d'informations, le raisonnement informatique et l'interface avec des systèmes externes. La mise en œuvre de ce modèle a considérablement évolué avec le développement des capacités d'invocation des fonctionnalités du GPT-4 et des systèmes capables de gérer l'accès à de nombreux outils. Ces développements ont facilité les flux de travail complexes des agents, qui peuvent sélectionner et exécuter de manière autonome les outils les plus pertinents pour une tâche donnée.

Bien que l'utilisation d'outils ait considérablement amélioré les flux de travail des agents, il reste des défis à relever pour optimiser la sélection des outils, en particulier lorsqu'il existe un grand nombre d'options disponibles. Des techniques inspirées de la génération améliorée par la recherche (RAG), telles que la sélection basée sur l'heuristique, ont été proposées pour résoudre ce problème.

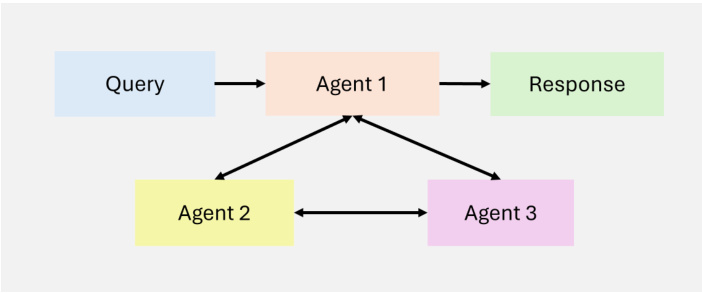

3.1.4 Multi-agents

La collaboration multi-agents [16] est un modèle de conception clé dans les flux de travail des agents qui permet la spécialisation des tâches et le traitement parallèle. Les agents communiquent entre eux et partagent les résultats intermédiaires, ce qui garantit l'efficacité et la cohérence du flux de travail global. En assignant des sous-tâches à des agents spécialisés, ce modèle améliore l'évolutivité et l'adaptabilité des flux de travail complexes. Les systèmes multi-agents permettent aux développeurs de décomposer les tâches complexes en sous-tâches plus petites et plus faciles à gérer, qui sont assignées à différents agents. Cette approche améliore non seulement la performance des tâches, mais fournit également un cadre puissant pour la gestion d'interactions complexes. Chaque agent dispose de sa propre mémoire et de son propre flux de travail, qui peut inclure l'utilisation d'outils, la réflexion ou la planification, ce qui permet une résolution dynamique et collaborative des problèmes (voir figure 10).

Figure 10 : Vue d'ensemble de MultiAgent

Bien que la collaboration multi-agents offre un grand potentiel, il s'agit d'un paradigme de conception beaucoup moins prévisible que des flux de travail plus matures tels que la réflexion et l'utilisation d'outils. Cela dit, des cadres émergents comme AutoGen, Crew AI et LangGraph offrent de nouvelles façons de mettre en œuvre des solutions multi-agents efficaces.

Ces modèles sont la pierre angulaire du succès des systèmes de RAG basés sur des agents, leur permettant d'adapter dynamiquement les flux de travail de recherche et de génération pour répondre aux exigences d'environnements divers et dynamiques. En utilisant ces modèles, les agents peuvent gérer des tâches itératives et contextuelles qui dépassent les capacités des systèmes RAG traditionnels.

4 Classification des systèmes RAG basés sur des agents

Les systèmes RAG (Retrieval Augmented Generation) basés sur des agents peuvent être classés dans différents cadres architecturaux en fonction de leur complexité et de leurs principes de conception. Il s'agit notamment des architectures à agent unique, des systèmes à agents multiples et des architectures à agents hiérarchiques. Chaque cadre vise à relever des défis spécifiques et à optimiser les performances dans différentes applications. La présente section propose une catégorisation détaillée de ces architectures, en soulignant leurs caractéristiques, leurs avantages et leurs limites.

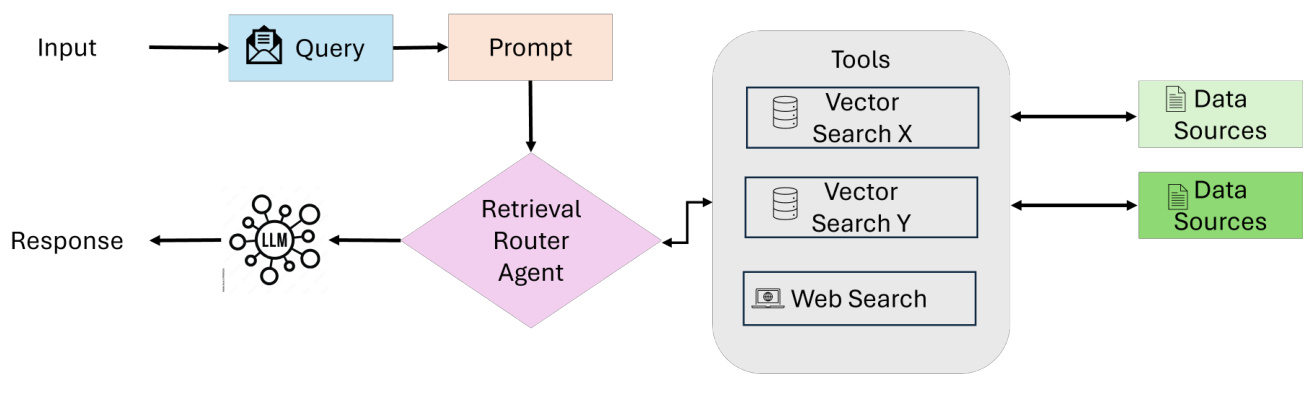

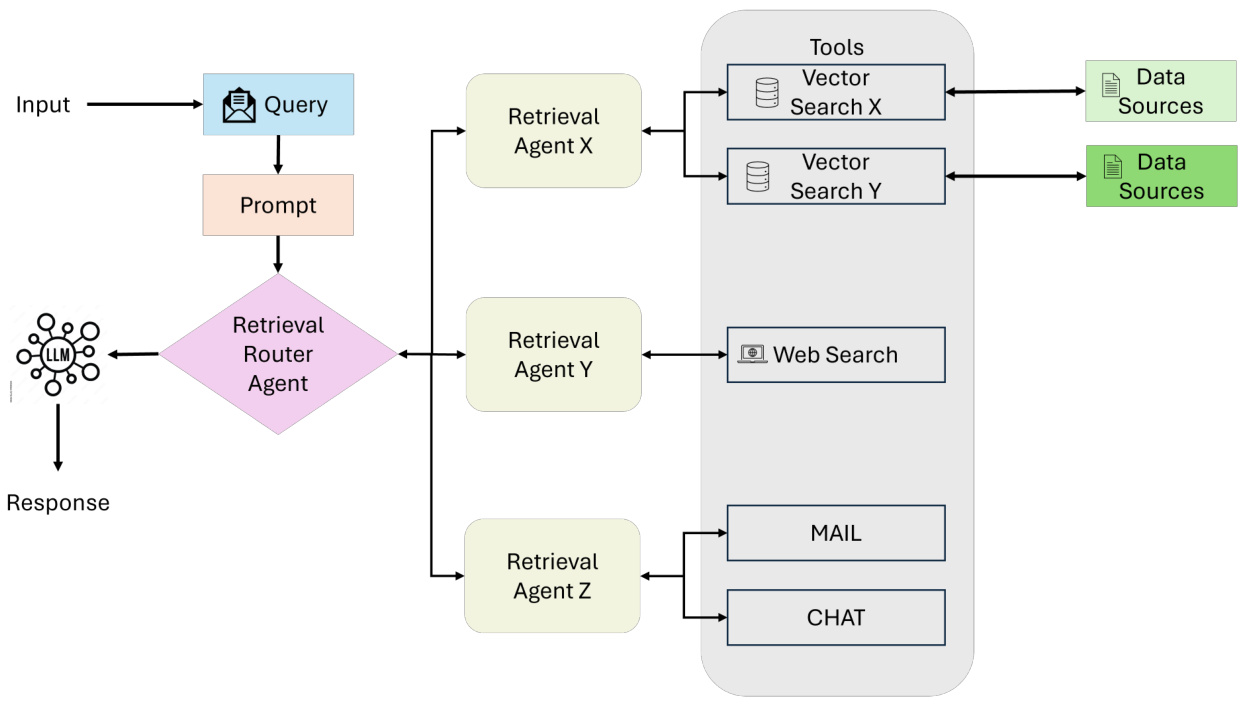

4.1 Proxy à agent unique RAG : Routeur

Les RAG à agent unique [31] agissent comme un système décisionnel centralisé dans lequel un agent gère la recherche, l'acheminement et l'intégration des informations (comme le montre la figure 11). Cette architecture simplifie le système en combinant ces tâches en un seul agent unifié, ce qui la rend particulièrement adaptée aux environnements disposant d'un nombre limité d'outils ou de sources de données.

flux de travail

- Soumission et évaluation des demandes de renseignementsLe processus commence lorsque l'utilisateur soumet une requête. Un agent de coordination (ou agent de recherche principal) reçoit la requête et l'analyse pour déterminer la source d'information la plus appropriée.

- Sélection des sources de connaissancesEn fonction du type de requête, l'agent coordonnateur choisit parmi plusieurs options de recherche :

- Base de données structuréePour les requêtes nécessitant l'accès à des données tabulaires, le système peut utiliser un moteur Text-to-SQL qui interagit avec des bases de données telles que PostgreSQL ou MySQL.

- recherche sémantiqueLorsqu'il s'agit d'informations non structurées, il utilise la recherche vectorielle pour récupérer les documents pertinents (par exemple, des PDF, des livres, des dossiers d'organisation).

- Recherche sur InternetPour des informations en temps réel ou des informations contextuelles générales, le système utilise des outils de recherche sur le web pour accéder aux données en ligne les plus récentes.

- système de recommandationPour les requêtes personnalisées ou contextuelles, le système utilise un moteur de recommandation pour fournir des suggestions sur mesure.

- Intégration des données et synthèse LLMUne fois que les données pertinentes ont été extraites d'une source sélectionnée, elles sont transmises au grand modèle linguistique (LLM), qui rassemble les informations collectées, en intégrant les idées provenant de sources multiples dans une réponse cohérente et pertinente du point de vue du contexte.

- Production d'électricitéLe système génère enfin une réponse complète, orientée vers l'utilisateur, à la requête initiale. La réponse est présentée dans un format concis et exploitable et comprend éventuellement des références ou des citations des sources utilisées.

Principales caractéristiques et avantages

- Simplicité centraliséeUn agent unique gère toutes les tâches de recherche et de routage, ce qui rend l'architecture facile à concevoir, à mettre en œuvre et à entretenir.

- Efficacité et optimisation des ressourcesAvec moins d'agents et une coordination plus simple, le système nécessite moins de ressources informatiques et peut traiter les requêtes plus rapidement.

- routage dynamiqueL'agent évalue chaque requête en temps réel et sélectionne la source de connaissances la plus appropriée (par exemple, bases de données structurées, recherche sémantique, recherche sur le web).

- Polyvalence des outilsPrise en charge de plusieurs sources de données et d'API externes, ce qui permet de prendre en charge les flux de travail structurés et non structurés.

- Convient aux systèmes simplesPour les applications dont les tâches sont bien définies ou dont les besoins d'intégration sont limités (par exemple, extraction de fichiers, flux de travail basés sur le langage SQL).

Figure 11 : Vue d'ensemble des groupes consultatifs régionaux (GCR) à organisme unique

Cas d'utilisation : Soutien à la clientèle

attirer l'attention sur qqch.: Pouvez-vous m'indiquer l'état de la livraison de ma commande ?

Processus du système (flux de travail de l'agent unique): :

- Soumission et évaluation des demandes de renseignements: :

- L'utilisateur soumet une requête, qui est reçue par l'agent de coordination.

- Coordonner avec les agents l'analyse des demandes et l'identification des sources d'information les plus appropriées.

- Sélection des sources de connaissances: :

- Récupérer les données de suivi de la base de données de gestion des commandes.

- Obtenez des mises à jour en temps réel de l'API du transporteur.

- En option, une recherche sur Internet peut être effectuée pour identifier les conditions locales affectant la livraison, telles que les conditions météorologiques ou les retards logistiques.

- Intégration des données et synthèse LLM: :

- Transmettre les données pertinentes au LLM, qui consolide les informations en une réponse cohérente.

- Production d'électricité: :

- Le système génère une réponse concise et exploitable qui permet de suivre en temps réel les mises à jour et les alternatives possibles.

réactif: :

Réponse intégréeUPS : Votre colis est actuellement en transit et devrait arriver demain soir. Le suivi en temps réel d'UPS indique qu'il se trouve dans un centre de distribution régional.

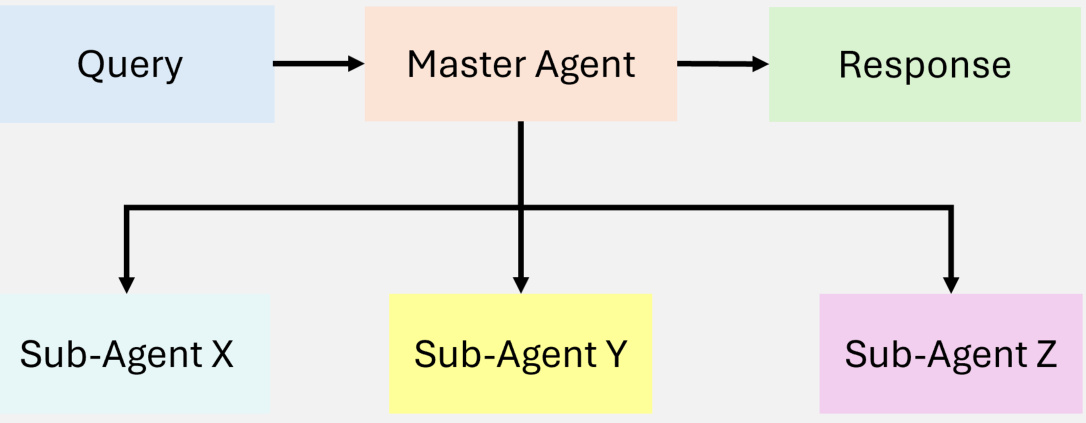

4.2 Système multi-agents RAG

Le RAG multi-agents [31] représente une évolution modulaire et évolutive de l'architecture à agent unique, visant à traiter des processus complexes et divers types de requêtes en tirant parti de plusieurs agents spécialisés (comme le montre la figure 12). Au lieu de s'appuyer sur un seul agent pour gérer toutes les tâches - raisonnement, extraction et génération de réponses - le système attribue des responsabilités à plusieurs agents, chacun étant optimisé pour un rôle ou une source de données spécifique.

flux de travail

- Demande de renseignementsLe processus commence par une requête de l'utilisateur, qui est reçue par un agent de coordination ou un agent de recherche principal. Cet agent joue le rôle de coordinateur central et délègue la requête à un agent de recherche spécialisé en fonction des exigences de la requête.

Figure 12 : Vue d'ensemble des systèmes multi-agents agentiques RAG

- Agents de recherche spécialisésLes requêtes sont assignées à plusieurs agents de recherche, chacun se concentrant sur un type spécifique de source de données ou de tâche. Exemple :

- Agent 1Les logiciels de gestion de l'information : Traiter des requêtes structurées, par exemple en interagissant avec des bases de données basées sur SQL telles que PostgreSQL ou MySQL.

- Agent 2Les recherches sémantiques permettent d'extraire des données non structurées à partir de sources telles que les PDF, les livres ou les dossiers internes.

- Agent 3Les services d'information : Ils se concentrent sur la récupération d'informations publiques en temps réel à partir de recherches sur le web ou d'API.

- Agent 4: Spécialisé dans les systèmes de recommandation qui fournissent des suggestions contextuelles pertinentes basées sur le comportement ou le profil de l'utilisateur.

- Accès aux outils et récupération des donnéesChaque agent achemine la requête vers l'outil ou la source de données appropriés dans son domaine, par exemple :

- recherche vectorielle: pour la pertinence sémantique.

- Texte vers SQLPour les données structurées.

- Recherche sur InternetPour une information publique en temps réel.

- APIPour accéder à des services externes ou à des systèmes propriétaires.

Le processus de recherche est exécuté en parallèle, ce qui permet de traiter efficacement différents types de requêtes.

- Intégration des données et synthèse LLMUne fois la recherche terminée, toutes les données de l'agent sont transmises au grand modèle linguistique (LLM), qui consolide les informations récupérées en une réponse cohérente et contextuelle qui intègre de manière transparente des informations provenant de sources multiples.

- Production d'électricitéLe système génère une réponse complète qui est renvoyée à l'utilisateur sous une forme concise et exploitable.

Principales caractéristiques et avantages

- modularisationChaque agent fonctionne de manière indépendante, ce qui permet d'ajouter ou de supprimer des agents de manière transparente en fonction des besoins du système.

- évolutivitéLe traitement parallèle de plusieurs agents permet au système de traiter efficacement des volumes importants de requêtes.

- Spécialisation des tâchesChaque agent est optimisé pour un type spécifique de requête ou de source de données, ce qui améliore la précision et la pertinence de la recherche.

- l'efficacitéEn assignant des tâches à des agents spécialisés, le système minimise les goulets d'étranglement et améliore les performances des flux de travail complexes.

- polyvalenceLes applications sont multiples : recherche, analyse, prise de décision, assistance à la clientèle, etc.

défi

- Complexité de la coordinationLe rôle de la communication inter-agents et de la délégation de tâches nécessite des mécanismes de coordination complexes.

- surcharge de calculLe traitement parallèle de plusieurs agents peut augmenter l'utilisation des ressources.

- intégration des donnéesL'intégration de résultats provenant de différentes sources dans une réponse cohérente n'est pas facile et nécessite des capacités avancées en matière de gestion de l'apprentissage tout au long de la vie.

Cas d'utilisation : assistant de recherche multidisciplinaire

attirer l'attention sur qqch.Le point sur les énergies renouvelables : Quels sont les impacts économiques et environnementaux de l'adoption des énergies renouvelables en Europe ?

Processus du système (flux de travail multi-agents): :

- Agent 1Les données statistiques : Utiliser des requêtes SQL pour extraire des données statistiques de bases de données économiques.

- Agent 2: Recherche d'articles académiques pertinents à l'aide d'outils de recherche sémantique.

- Agent 3Les énergies renouvelables : Effectuez une recherche sur le web pour connaître les dernières nouvelles et les mises à jour des politiques en matière d'énergies renouvelables.

- Agent 4Le système de recommandation : Consulter le système de recommandation pour suggérer des contenus pertinents, tels que des rapports ou des commentaires d'experts.

réactif: :

Réponse intégréeSelon le rapport politique de l'UE, l'adoption des énergies renouvelables en Europe a permis de réduire les émissions de gaz à effet de serre de 20% au cours de la dernière décennie. Sur le plan économique, les investissements dans les énergies renouvelables ont permis de créer environ 1,2 million d'emplois, avec une croissance significative dans les secteurs solaire et éolien. Des recherches universitaires récentes ont également mis en évidence les compromis possibles en termes de stabilité du réseau et de coûts de stockage de l'énergie".

4.3 Système RAG hiérarchique basé sur des agents

Le système RAG [17], basé sur des agents hiérarchiques, utilise une approche structurée à plusieurs niveaux pour la recherche et le traitement des informations, ce qui améliore l'efficacité et la prise de décision stratégique (comme le montre la figure 13). Les agents sont organisés selon une structure hiérarchique, les agents de niveau supérieur supervisant et guidant les agents de niveau inférieur. Cette structure permet une prise de décision à plusieurs niveaux et garantit que les requêtes sont traitées par les ressources les plus appropriées.

Figure 13 : Illustration d'un RAG agentique hiérarchique

flux de travail

- Récépissé de demande de renseignementsL'utilisateur soumet une requête, qui est reçue par l'agent de niveau supérieur, responsable de l'évaluation initiale et de la mise en service.

- la prise de décision stratégiqueL'agent de niveau supérieur évalue la complexité de la requête et décide des agents subordonnés ou des sources de données à privilégier. En fonction du domaine de la requête, certaines bases de données, API ou outils de recherche peuvent être considérés comme plus fiables ou plus pertinents.

- Délégation à un subordonnéLes agents de haut niveau assignent des tâches à des agents de niveau inférieur spécialisés dans des méthodes de recherche particulières (par exemple, bases de données SQL, recherches sur le web ou systèmes propriétaires). Ces agents exécutent les tâches qui leur sont assignées de manière indépendante.

- Polymérisation et synthèseLes agents de haut niveau recueillent et intègrent les résultats des agents subordonnés, consolidant les informations en réponses cohérentes.

- Livraison de la réponseLa réponse finale, synthétisée, est renvoyée à l'utilisateur, en veillant à ce que la réponse soit à la fois complète et adaptée au contexte.

Principales caractéristiques et avantages

- Priorités stratégiquesLes agents de haut niveau peuvent hiérarchiser les sources de données ou les tâches en fonction de la complexité de la requête, de la fiabilité ou du contexte.

- évolutivitéLes tâches sont assignées à plusieurs niveaux d'agents, ce qui permet de traiter des requêtes très complexes ou à multiples facettes.

- Amélioration de la capacité de prise de décisionLes agents de haut niveau exercent une surveillance stratégique afin d'améliorer la précision et la cohérence de la réponse.

défi

- Complexité de la coordinationLa communication inter-agents à plusieurs niveaux peut augmenter le coût de la coordination.

- Allocation des ressourcesLes tâches sont réparties de manière efficace entre les différents niveaux tout en évitant les goulets d'étranglement.

Cas d'utilisation : système d'analyse financière

attirer l'attention sur qqch.Les énergies renouvelables : Quelles sont les possibilités d'investissement dans les énergies renouvelables sur la base des tendances actuelles du marché ?

Processus du système (flux de travail des agents hiérarchiques): :

- agent au sommet de la hiérarchieLes données financières et les indicateurs économiques fiables doivent être privilégiés par rapport aux sources de données moins validées.

- Agents de niveau intermédiaireLes données de marché en temps réel (par exemple, le cours des actions, les performances du secteur) sont extraites d'API exclusives et de bases de données SQL structurées.

- Agents de bas niveauLes services d'information et de conseil de l'Union européenne : effectuer des recherches sur Internet pour trouver des annonces et des politiques récentes et consulter des systèmes de référence pour suivre les avis d'experts et les analyses de l'actualité.

- Polymérisation et synthèseLes résultats de l'agrégation de proxy au plus haut niveau qui intègrent des données quantitatives et des idées politiques.

réactif: :

Réponse intégréeLes analystes estiment que les secteurs éolien et solaire devraient continuer à gagner du terrain, tandis que les technologies émergentes telles que l'hydrogène vert présentent un risque modéré mais peuvent offrir des rendements élevés. Les analystes estiment que les secteurs éolien et solaire devraient continuer à gagner du terrain, tandis que les technologies émergentes telles que l'hydrogène vert présentent un risque modéré mais peuvent offrir des rendements élevés."

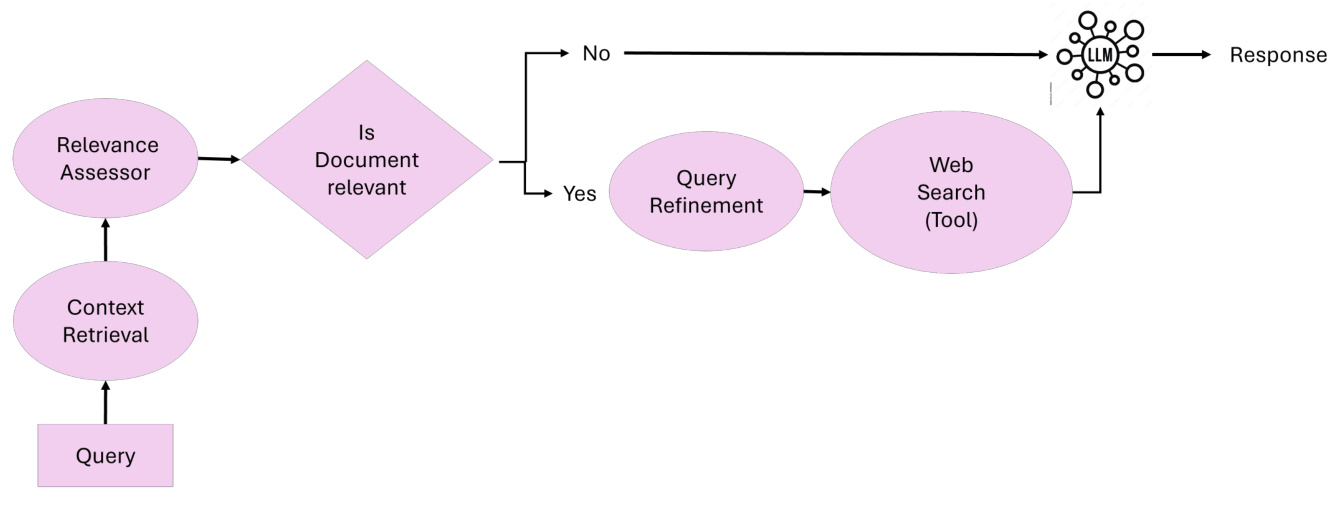

4.4 Proxy Corrective RAG

Corrective RAG [32] [33] introduit la capacité d'autocorriger les résultats de la recherche, en améliorant l'utilisation des documents et la qualité de la génération des réponses (comme le montre la figure 14). En intégrant des agents intelligents dans le flux de travail, Corrective RAG [32] [33] garantit l'affinement itératif des documents contextuels et des réponses afin de minimiser les erreurs et de maximiser la pertinence.

Figure 14 : Vue d'ensemble du RAG correctif agentique

Corriger l'idée centrale de RAGLe principe de base du RAG correctif réside dans sa capacité à évaluer dynamiquement les documents extraits, à effectuer des actions correctives et à affiner la requête afin d'améliorer la qualité de la réponse générée. Le RAG correctif adapte sa méthodologie comme suit :

- Évaluation de la pertinence des documentsLes documents récupérés sont évalués par un agent d'évaluation de la pertinence. Les documents inférieurs au seuil de pertinence déclenchent une étape de correction.

- Affinement et amélioration de l'enquêteLes requêtes sont affinées par un agent d'affinage des requêtes qui utilise la compréhension sémantique pour optimiser la recherche afin d'obtenir de meilleurs résultats.

- Recherche dynamique à partir de sources externesLorsque le contexte est insuffisant, l'agent externe de recherche de connaissances effectue une recherche sur le web ou accède à d'autres sources de données pour compléter les documents récupérés.

- synthèse des réponsesLes informations validées et affinées sont transmises à l'agent de synthèse des réponses pour la génération de la réponse finale.

flux de travailLe système correctif RAG repose sur cinq agents clés :

- agent de recherche contextuelleLe document contextuel initial est extrait de la base de données vectorielles.

- Agent d'évaluation de la pertinenceLes documents sont évalués en fonction de leur pertinence et les documents non pertinents ou ambigus sont signalés en vue d'une action corrective.

- Agent d'affinage des demandes de renseignementsLes résultats de l'analyse de l'information sont présentés en détail dans le tableau suivant : réécriture des requêtes pour améliorer l'efficacité de la recherche et utilisation de la compréhension sémantique pour optimiser les résultats.

- Agent externe d'extraction de connaissancesLes services d'aide à la décision : Effectuer des recherches sur le web ou accéder à d'autres sources de données lorsque la documentation contextuelle n'est pas suffisante.

- Agent de synthèse des réponsesLe rôle de la Commission européenne : Intégrer toutes les informations validées dans une réponse cohérente et précise.

Principales caractéristiques et avantages :

- Correction itérativeLes résultats de recherche sont identifiés et corrigés de manière dynamique, ce qui garantit une grande précision des réponses.

- Adaptation dynamique: Intégration de la recherche sur le web en temps réel et de l'affinement des requêtes pour améliorer la précision de la recherche.

- Proxy ModulaireChaque agent effectue des tâches spécialisées afin de garantir des opérations efficaces et évolutives.

- Garanties factuellesLa correction du RAG minimise le risque d'hallucinations ou de désinformation en validant tous les contenus récupérés et générés.

Cas d'utilisation : assistant de recherche universitaire

attirer l'attention sur qqch.: Quels sont les derniers résultats de la recherche sur l'IA générative ?

Processus du système (correction des flux de travail RAG): :

- Demande de renseignementsLes utilisateurs soumettent des requêtes au système.

- recherche contextuelle: :

- agent de recherche contextuelleRécupérer les documents initiaux de la base de données des articles publiés sur l'IA générative.

- Les documents récupérés sont transmis à l'étape suivante pour évaluation.

- Évaluation de la pertinence :

- Agent d'évaluation de la pertinenceÉvaluer la correspondance entre le document et la requête.

- Classer les documents selon qu'ils sont pertinents, ambigus ou non pertinents. Les documents non pertinents sont signalés en vue d'une action corrective.

- Action corrective (si nécessaire) :

- Agent d'affinage des demandes de renseignementsRéécriture des requêtes pour améliorer la spécificité.

- Agent externe d'extraction de connaissancesEffectuer des recherches sur Internet pour obtenir des documents et des rapports supplémentaires provenant de sources externes.

- Synthèse des réponses.

- Agent de synthèse des réponsesIntégrer les documents validés dans des résumés complets et détaillés.

Réponse.

Réponse intégrée: "Les résultats récents de la recherche en IA générative comprennent des modèles de diffusion, l'apprentissage par renforcement dans les tâches texte-vidéo, et des avancées dans les techniques d'optimisation pour la formation de modèles à grande échelle. Voir les recherches présentées à NeurIPS 2024 et AAAI 2025 pour plus de détails."

4.5 RAG basé sur des agents adaptatifs

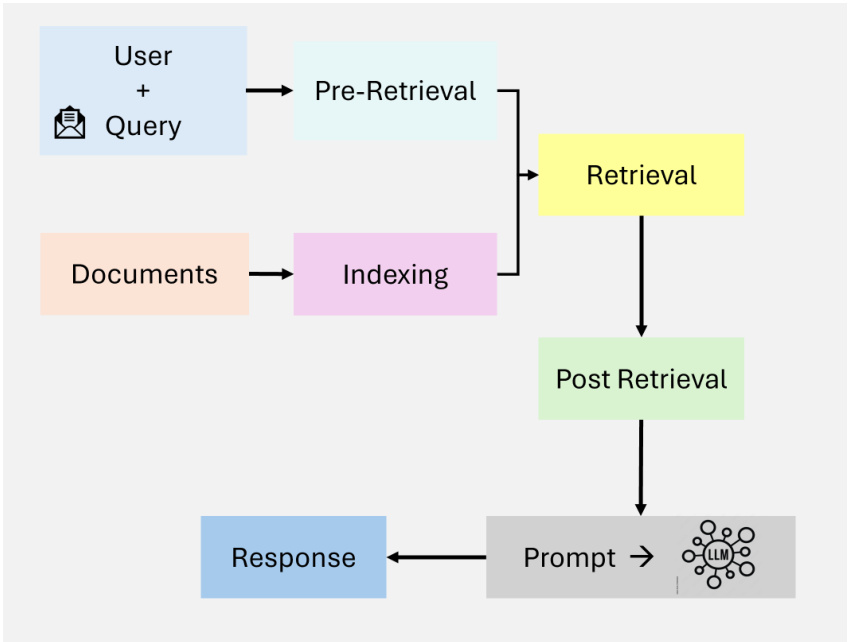

Adaptive Retrieval Augmented Generation (Adaptive RAG) [34] améliore la flexibilité et l'efficacité des grands modèles de langage (LLM) en adaptant dynamiquement la stratégie de traitement des requêtes en fonction de la complexité de la requête entrante. Contrairement aux flux de recherche statiques, la RAG adaptative [35] utilise des classificateurs pour analyser la complexité de la requête et déterminer l'approche la plus appropriée, allant de la recherche en une étape au raisonnement en plusieurs étapes, ou même en contournant complètement la recherche pour les requêtes simples, comme le montre la figure 15.

Figure 15 : Vue d'ensemble de la RAG adaptative et agentique

L'idée centrale du RAG adaptatif Le principe fondamental du RAG adaptatif réside dans sa capacité à ajuster dynamiquement la stratégie de recherche en fonction de la complexité de la requête. Le RAG adaptatif ajuste sa méthode comme suit :

- simple requêtePour les questions factuelles qui nécessitent une recherche supplémentaire (par exemple, "Quel est le point d'ébullition de l'eau ?"), le système génère des réponses directement en utilisant les connaissances préexistantes. Pour les questions factuelles qui nécessitent une recherche supplémentaire (par exemple, "Quel est le point d'ébullition de l'eau ?"), le système génère des réponses directement en utilisant les connaissances préexistantes.

- simple requêtePour les tâches modérément complexes qui nécessitent un contexte minimal (par exemple, "Quel est l'état de ma dernière facture d'électricité ?"), le système effectue une recherche en une seule étape pour obtenir les détails pertinents. ), le système effectue une recherche en une seule étape pour obtenir les détails pertinents.

- requête complexePour les requêtes à plusieurs niveaux nécessitant un raisonnement itératif (par exemple, "Comment la population de la ville X a-t-elle évolué au cours de la dernière décennie, et quels sont les facteurs qui y ont contribué ?) ), le système utilise la recherche en plusieurs étapes, en affinant progressivement les résultats intermédiaires pour fournir des réponses complètes.

flux de travailLe système Adaptive RAG repose sur trois éléments principaux :

- Trieur Rôle.

- Un petit modèle linguistique analyse les requêtes pour prédire leur complexité.

- Le classificateur est formé à l'aide d'ensembles de données étiquetés automatiquement, dérivés des résultats de modèles antérieurs et de modèles de requêtes.

- Sélection dynamique de stratégies.

- Pour les requêtes simples, le système évite les recherches inutiles et génère des réponses directement à l'aide de LLM.

- Pour les requêtes simples, il utilise un processus de recherche en une seule étape pour obtenir le contexte pertinent.

- Pour les requêtes complexes, il active la recherche en plusieurs étapes afin d'assurer un raffinement itératif et un meilleur raisonnement.

- Intégration du LLM.

- Le LLM intègre les informations récupérées dans une réponse cohérente.

- L'interaction itérative entre le LLM et les classificateurs permet d'affiner les requêtes complexes.

Principales caractéristiques et avantages.

- Adaptation dynamique: Adaptation des stratégies de recherche à la complexité des requêtes afin d'optimiser l'efficacité des calculs et la précision des réponses.

- Efficacité des ressourcesLes objectifs sont les suivants : minimiser les frais généraux inutiles pour les requêtes simples tout en garantissant un traitement approfondi des requêtes complexes.

- Précision accrueLe raffinement itératif garantit que les requêtes complexes sont résolues avec une grande précision.

- dextéritéLe système peut être étendu pour intégrer des voies supplémentaires, telles que des outils spécifiques à un domaine ou des interfaces de programmation (API) externes.

Cas d'utilisation. Assistant de soutien à la clientèle

Conseil. Pourquoi mon colis est-il retardé et quelles sont mes options ?

Processus du système (flux de travail adaptatif du RAG).

- Catégorie de demande de renseignements.

- Le classificateur analyse la requête et détermine qu'il s'agit d'une requête complexe nécessitant un raisonnement en plusieurs étapes.

- Sélection dynamique de stratégies.

- Le système active un processus de recherche en plusieurs étapes basé sur la classification de la complexité.

- Recherche en plusieurs étapes.

- Récupérer les détails du suivi dans la base de données des commandes.

- Obtenez des mises à jour en temps réel de l'API Courier.

- Effectuer une recherche sur le web pour trouver des facteurs externes tels que les conditions météorologiques ou les perturbations locales.

- Synthèse des réponses.

- Le LLM intègre toutes les informations récupérées dans une réponse complète et exploitable.

Réponse.

Réponse intégréeVotre colis a été retardé en raison de conditions météorologiques défavorables dans votre région. Il se trouve actuellement au centre de distribution local et devrait arriver dans les deux jours. Vous pouvez également venir le chercher au centre de distribution."

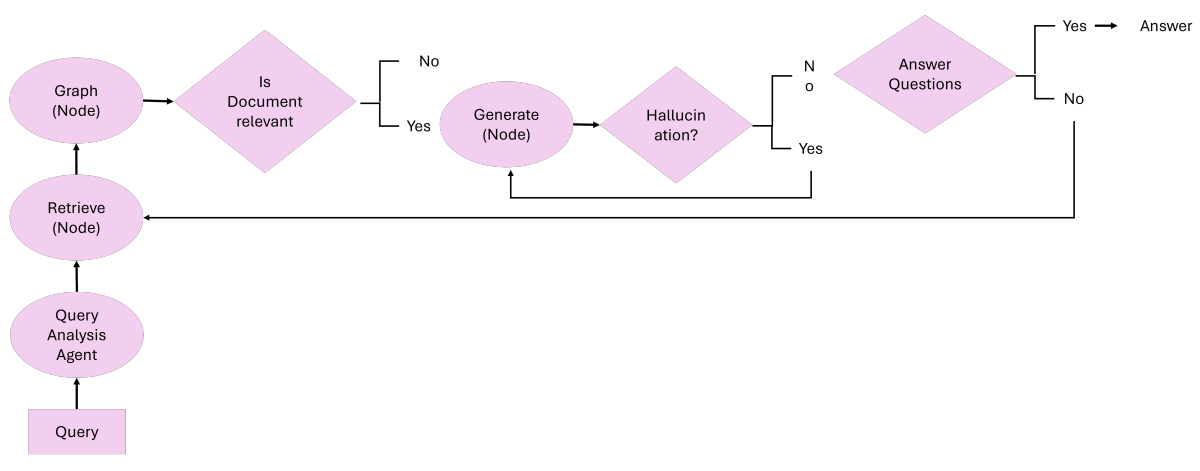

4.6 RAG basés sur des graphes et des agents

4.6.1 Agent-G : un cadre basé sur des agents pour les RAG de graphes

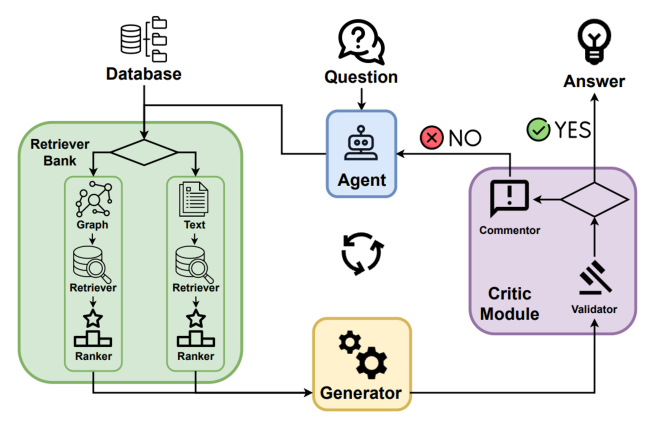

Agent-G [8] présente une architecture innovante basée sur des agents qui associe des bases de connaissances graphiques à la recherche de documents non structurés. En combinant des sources de données structurées et non structurées, ce cadre améliore la précision du raisonnement et de la recherche des systèmes de génération augmentée de recherche (RAG). Il utilise des bibliothèques de récupérateurs modulaires, des interactions dynamiques entre agents et des boucles de rétroaction pour garantir des résultats de haute qualité, comme le montre la figure 16.

Figure 16 : Vue d'ensemble de l'Agent-G : cadre agentique pour le graphique RAG

L'idée centrale de l'Agent-G Le principe fondamental d'Agent-G réside dans sa capacité à assigner dynamiquement des tâches de recherche à des agents spécialisés utilisant des bases de connaissances graphiques et des fichiers texte :

- base de connaissances graphiqueLes données structurées sont utilisées pour extraire des relations, des hiérarchies et des connexions (par exemple, la cartographie des maladies par rapport aux symptômes dans le domaine médical).

- document non structuré: : Les systèmes traditionnels de recherche de texte fournissent des informations contextuelles pour compléter les données graphiques.

- Module critique: évaluer la pertinence et la qualité des informations extraites afin de s'assurer qu'elles correspondent à la requête.

- boucle de rétroaction: Raffinement de la recherche et de la synthèse grâce à une validation itérative et à des requêtes supplémentaires.

flux de travailLe système Agent-G repose sur quatre éléments principaux :

- Bibliothèque du Retriever.

- Un ensemble d'agents modulaires spécialisés dans la recherche de données graphiques ou non structurées.

- L'agent sélectionne dynamiquement les sources pertinentes en fonction des exigences de la requête.

- Module de critique.

- Valider la pertinence et la qualité des données extraites.

- Signaler les résultats peu fiables en vue d'une nouvelle recherche ou d'un affinement.

- Interaction dynamique des agents.

- Des agents spécifiques à une tâche collaborent pour intégrer différents types de données.

- Assurer une recherche et une synthèse coordonnées entre les figures et les sources textuelles.

- Intégration du LLM.

- Synthétiser les données validées en une réponse cohérente.

- Le retour d'information itératif du module de critique garantit l'alignement sur l'intention de la requête.

Principales caractéristiques et avantages.

- amélioration du raisonnementLa recherche d'informations sur l'environnement : Combinaison de relations structurées dans des graphes et d'informations contextuelles provenant de documents non structurés.

- Adaptation dynamique: Adaptation dynamique des stratégies de recherche aux exigences de la requête.

- Amélioration de la précisionLe module Critique réduit le risque que la réponse contienne des données non pertinentes ou de mauvaise qualité.

- Modularité évolutiveLes agents peuvent être ajoutés pour effectuer des tâches spécialisées afin d'améliorer l'évolutivité de l'application.

Cas d'utilisation : Diagnostic médical

Conseil. Quels sont les symptômes courants du diabète de type 2 et quel est leur lien avec les maladies cardiaques ?

Processus du système (flux de travail Agent-G).

- Réception et distribution des requêtesLe système reçoit des requêtes et identifie le besoin d'utiliser à la fois des données structurées et non structurées pour répondre complètement à la question.

- Chart Finder.

- Extraction de la relation entre le diabète de type 2 et les maladies cardiaques à partir du graphique des connaissances médicales.

- Identifier les facteurs de risque communs tels que l'obésité et l'hypertension en explorant les hiérarchies et les relations graphiques.

- Document Retriever.

- Recherchez dans la littérature médicale des descriptions de symptômes du diabète de type 2 (par exemple, soif accrue, mictions fréquentes, fatigue).

- Ajouter des informations contextuelles pour compléter les informations basées sur les graphiques.

- Module de critique.

- Évaluer la pertinence et la qualité des données graphiques et des données documentaires récupérées.

- Signaler les résultats peu fiables en vue d'un affinement ou d'une nouvelle interrogation.

- synthèse des réponsesLe LLM intègre les données de validation provenant de l'extracteur de graphes et de l'extracteur de documents dans une réponse cohérente, garantissant ainsi l'alignement sur l'intention de la requête.

Réponse.

Réponse intégréeLes symptômes du diabète de type 2 comprennent une soif accrue, des mictions fréquentes et de la fatigue. Des études ont montré une corrélation 50% entre le diabète et les maladies cardiaques, principalement en raison de facteurs de risque communs tels que l'obésité et l'hypertension artérielle."

4.6.2 GeAR : Graph Augmentation Agent for Retrieval Augmentation Generation (agent d'augmentation des graphes pour la génération d'augmentation de la recherche)

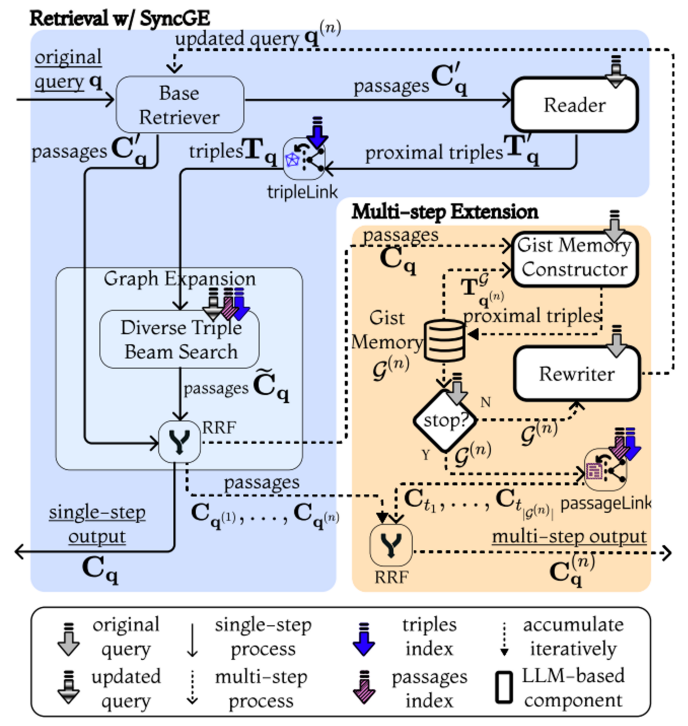

GeAR [36] présente un cadre basé sur des agents qui améliore les systèmes traditionnels de génération augmentée de recherche (RAG) en intégrant des mécanismes de recherche basés sur les graphes. En utilisant des techniques d'extension des graphes et une architecture basée sur des agents, GeAR relève les défis des scénarios de recherche multi-sauts et améliore la capacité du système à traiter des requêtes complexes, comme le montre la figure 17.

Figure 17 : Aperçu de GeAR : Graph-Enhanced Agent for Retrieval-Augmented Generation[36].

- extension graphiqueBM25) en étendant le processus de recherche aux données structurées sous forme de graphe, ce qui permet au système de saisir les relations et les dépendances complexes entre les entités.

- cadre de procurationLe projet : intègre une architecture basée sur un agent qui utilise des extensions de graphes pour gérer les tâches de recherche plus efficacement, permettant une prise de décision dynamique et autonome au cours du processus de recherche.

flux de travailLe système GeAR fonctionne grâce aux éléments suivants :

- Figure Module d'extension.

- L'intégration de données graphiques dans le processus de recherche permet au système de prendre en compte les relations entre les entités au cours du processus de recherche.

- Améliorer la capacité de l'outil de recherche de base à traiter les requêtes multi-sauts en étendant l'espace de recherche aux entités connectées.

- Recherche basée sur des agents.

- Un cadre d'agent est utilisé pour gérer le processus de recherche, permettant aux agents de sélectionner et de combiner dynamiquement des stratégies de recherche en fonction de la complexité de la requête.

- Les agents peuvent décider de manière autonome d'un chemin de recherche en utilisant des extensions de graphes pour améliorer la pertinence et la précision des informations récupérées.

- Intégration du LLM.

- La combinaison des informations récupérées avec les avantages des extensions de graphes et les capacités de la modélisation du langage étendu (LLM) pour générer des réponses cohérentes et contextuellement pertinentes.

- Cette intégration garantit que le processus de génération s'inspire à la fois de documents non structurés et de données graphiques structurées.

Principales caractéristiques et avantages.

- Recherche multi-sauts amélioréeLes extensions de graphes de GeAR permettent au système de traiter des requêtes complexes qui requièrent un raisonnement sur plusieurs éléments d'information interdépendants.

- Prise de décision par procurationLe cadre de substitution permet une sélection dynamique et autonome des stratégies de recherche, améliorant ainsi l'efficacité et la pertinence.

- Amélioration de la précision: En intégrant des données graphiques structurées, GeAR améliore la précision des informations extraites afin de générer des réponses plus précises et plus adaptées au contexte.

- évolutivitéLa nature modulaire du cadre de l'agent permet d'intégrer des stratégies de recherche et des sources de données supplémentaires en fonction des besoins.

Cas d'utilisation : Quiz multi-sauts

Conseil. Qui a influencé le mentor de J.K. Rowling ?

Processus du système (GeAR Workflow).

- agent au sommet de la hiérarchieLes résultats de l'enquête sont les suivants : évaluer la nature multi-sauts de la requête et déterminer la nécessité de combiner l'expansion des graphes et la recherche de documents pour répondre à la question.

- Figure Module d'extension.

- Identifiez le mentor de J.K. Rowling comme l'entité clé de la requête.

- Retracer les influences littéraires des mentors en explorant les données de la structure de la carte des relations littéraires.

- Recherche basée sur des agents.

- Un agent sélectionne de manière autonome un chemin de recherche étendu au graphe afin de recueillir des informations pertinentes sur l'impact du mentor.

- Intégrer un contexte supplémentaire pour les détails non structurés des mentors et de leurs influences en interrogeant des sources de données textuelles.

- synthèse des réponsesLes résultats de la recherche de documents et de graphes peuvent être combinés pour générer une réponse qui reflète fidèlement les relations complexes de la requête.

Réponse.

Réponse intégréeLe mentor de J.K. Rowling, [nom du mentor], a été fortement influencé par [nom de l'auteur], connu pour son [œuvre ou genre célèbre]. Ce lien met en évidence les relations en cascade dans l'histoire littéraire, où les idées influentes sont souvent transmises par plusieurs générations d'écrivains."

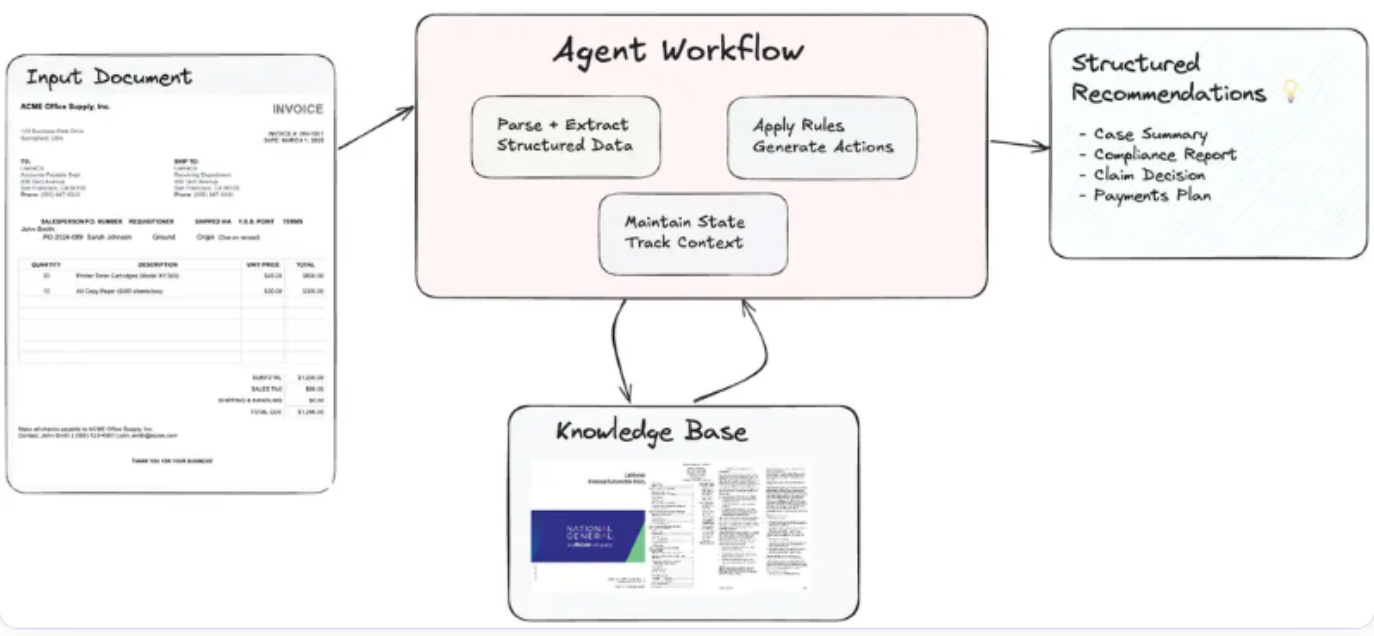

4.7 Flux de documents basés sur des agents dans des GCR basés sur des agents

Flux de documents agentiques (ADW)[37] étend le paradigme traditionnel de la génération augmentée de la recherche (RAG) en automatisant le travail de connaissance de bout en bout. Ces flux de travail orchestrent des processus complexes centrés sur les documents qui intègrent l'analyse, l'extraction, le raisonnement et la production structurée de documents à l'aide d'agents intelligents (voir figure 18). Les systèmes ADW remédient aux limites du traitement intelligent des documents (IDP) et de la RAG en maintenant l'état, en orchestrant des flux de travail à plusieurs étapes et en appliquant aux documents une logique propre à un domaine.

flux de travail

- Analyse de documents et structuration de l'information: :

- Utiliser des outils d'entreprise (par exemple, LlamaParse) pour analyser les documents afin d'extraire les champs de données pertinents tels que les numéros de factures, les dates, les informations sur les fournisseurs, les entrées et les conditions de paiement.

- Organiser des données structurées en vue d'un traitement ultérieur.

- Maintien de l'état d'un processus à l'autre: :

- Le système conserve l'état du contexte documentaire en question, garantissant ainsi la cohérence et la pertinence des flux de travail en plusieurs étapes.

- Suivre l'évolution des documents à travers les différentes étapes du traitement.

- recherche de connaissances: :

- Récupérer les références pertinentes dans des bases de connaissances externes (par exemple, LlamaCloud) ou des index vectoriels.

- Récupérer en temps réel des conseils spécifiques à un domaine pour améliorer la prise de décision.

- Programmation basée sur des agents: :

- Les agents intelligents appliquent des règles commerciales, effectuent des raisonnements multi-sauts et génèrent des recommandations exploitables.

- Orchestrer les composants tels que les analyseurs, les récupérateurs et les API externes pour une intégration transparente.

- Production de résultats exploitables: :

- Les résultats sont présentés dans un format structuré, adapté à des cas d'utilisation spécifiques.

- Synthétiser les recommandations et les informations extraites dans des rapports concis et exploitables.

Figure 18 : Vue d'ensemble des flux de documents agentiques (ADW) [37].

Cas d'utilisation : flux de travail pour le paiement des factures

attirer l'attention sur qqch.Les factures peuvent être envoyées à l'adresse suivante : Générer un rapport d'avis de paiement sur la base des factures soumises et des termes du contrat du fournisseur concerné.

Processus du système (flux de travail ADW): :

- L'analyse des factures permet d'extraire des détails clés tels que le numéro de la facture, la date, les informations sur le fournisseur, les entrées et les conditions de paiement.

- Récupérer les contrats des fournisseurs appropriés afin de valider les conditions de paiement et d'identifier les remises applicables ou les exigences en matière de conformité.

- Générer un rapport de recommandation de paiement comprenant le montant initial dû, les éventuelles remises pour paiement anticipé, l'analyse de l'impact budgétaire et les actions stratégiques de paiement.

réactifRéponse consolidée : "La facture INV-2025-045 d'un montant de $15,000.00 a été traitée. Si le paiement est effectué avant le 2025-04-10, une remise pour paiement anticipé de 2% est disponible, réduisant le montant dû à $14,700.00.Étant donné que le sous-total dépasse $10,000.00, une remise pour commande groupée de 5% a été appliquée. Il est recommandé d'approuver le paiement anticipé afin d'économiser 21 TP3T et d'assurer l'allocation en temps voulu des fonds pour les prochaines phases du projet.

Principales caractéristiques et avantages

- Maintenance conditionnelleLes documents doivent être présentés dans leur contexte et aux différentes étapes du flux de travail afin d'assurer la cohérence entre les processus.

- programmation en plusieurs étapesLes tâches à accomplir sont les suivantes : gérer des flux de travail complexes faisant intervenir de multiples composants et outils externes ; gérer des flux de travail complexes faisant intervenir de multiples composants et outils externes.

- Intelligence spécifique à un domaineLes services d'appui à la décision : Appliquer des règles et des lignes directrices adaptées aux besoins de l'entreprise pour obtenir des conseils précis.

- évolutivitéLe traitement de documents à grande échelle est possible grâce à l'intégration modulaire et dynamique d'agents.

- Augmenter la productivitéLes services d'aide à la décision : automatiser les tâches répétitives tout en améliorant l'expertise humaine dans la prise de décision.

4.8 Analyse comparative des cadres RAG basés sur des agents

Le tableau 2 présente une analyse comparative complète de trois cadres architecturaux : le RAG traditionnel, le RAG basé sur des agents et le flux de documents basé sur des agents (ADW). L'analyse met en évidence leurs forces et faiblesses respectives ainsi que les scénarios les mieux adaptés, ce qui donne des indications précieuses pour l'application dans différents cas d'utilisation.

Tableau 2 : Analyse comparative : RAG traditionnels vs. RAG basés sur des agents vs. flux de documents basés sur des agents (ADW)

| caractérisation | GCR traditionnel | Proxy RAG | Flux de documents basés sur des agents (ADW) |

|---|---|---|---|

| recomptage (par exemple, les résultats d'une élection) | Tâches isolées de recherche et de génération | Collaboration et raisonnement multi-agents | Flux de travail de bout en bout centrés sur les documents |

| Maintenance du contexte | contraintes | Réalisation par modules de mémoire | Gestion du statut dans un flux de travail en plusieurs étapes |

| Adaptation dynamique | minimal | votre (honorifique) | Adapté au flux de documents |

| Organisation du flux de travail | hiatus | Orchestrer des tâches multi-agents | Traitement intégré des documents en plusieurs étapes |

| Utilisation d'outils/API externes | Intégration de base (par exemple, outils de recherche) | Extension par le biais d'outils (par exemple, API et bases de connaissances) | Intégration poussée avec les règles de gestion et les outils spécifiques au domaine |

| évolutivité | Limité à de petits ensembles de données ou à des requêtes | Système multi-agents évolutif | Flux de travail multidisciplinaires évolutifs pour l'entreprise |

| inférence complexe | Basique (par exemple, un simple quiz) | Raisonnement à plusieurs étapes à l'aide d'agents | Raisonnement structuré à travers les documents |

| application majeure | Système de questions-réponses, recherche de connaissances | Connaissances et raisonnement pluridisciplinaires | Examen des contrats, traitement des factures, analyse des réclamations |

| tranchant | Installation simple et rapide | Raisonnement collaboratif de haute précision | Automatisation de bout en bout, intelligence spécifique au domaine |

| défi | Mauvaise compréhension du contexte | Complexité de la coordination | Frais généraux des ressources, normalisation des champs |

L'analyse comparative met en évidence la trajectoire évolutive des RAG traditionnels, des RAG basés sur des agents et des flux de documents basés sur des agents (ADW). Alors que les RAG traditionnels offrent les avantages de la simplicité et de la facilité de déploiement pour les tâches de base, les RAG à base d'agents introduisent des capacités de raisonnement et une évolutivité accrues grâce à la collaboration multi-agents. Il est essentiel de comprendre les points forts et les limites de chaque cadre pour choisir l'architecture qui répond le mieux aux besoins spécifiques de l'application et aux exigences opérationnelles.

5 Application du RAG par procuration

Les systèmes RAG (Retrieval Augmented Generation) basés sur des agents démontrent un potentiel de transformation dans une variété de domaines. En combinant la recherche de données en temps réel, les capacités de génération et la prise de décision autonome, ces systèmes relèvent des défis complexes, dynamiques et multimodaux. Cette section explore les applications clés de la RAG basée sur des agents, en détaillant comment ces systèmes façonnent des domaines tels que l'assistance à la clientèle, les soins de santé, la finance, l'éducation, les flux de travail juridiques et les industries créatives.

5.1 Assistance à la clientèle et assistants virtuels