Évaluation des risques de sécurité de DeepSeek par Cisco : un modèle qui ne tient pas la route à 100 %...

Récemment, une startup chinoise spécialisée dans l'IA DeepSeek Introduction d'un nouveau modèle d'inférence DeepSeek R1 Il a attiré beaucoup d'attention en raison de ses performances exceptionnelles. Cependant, une récente évaluation de la sécurité révèle un fait inquiétant : DeepSeek R1 est pratiquement invulnérable aux attaques malveillantes, avec un taux de réussite de 100%, ce qui signifie que n'importe quel indice malveillant bien conçu peut contourner ses mécanismes de sécurité et l'inciter à générer du contenu préjudiciable. Cette découverte n'est pas seulement un signal d'alarme pour la sécurité de DeepSeek R1, mais elle soulève également des inquiétudes générales quant à la sécurité des modèles d'IA actuels. Dans cet article, nous explorerons les vulnérabilités de sécurité de DeepSeek R1 et nous le comparerons à d'autres modèles de pointe afin d'analyser les raisons et les risques potentiels.

--Évaluer les risques de sécurité de DeepSeek et d'autres modèles d'inférence de pointe

Cette recherche originale est le résultat d'une étroite collaboration entre les chercheurs en sécurité de l'IA de Robust Intelligence (qui fait maintenant partie de Cisco) et de l'Université de Pennsylvanie, notamment Yaron Singer, Amin Karbasi, Paul Kassianik, Mahdi Sabbaghi, Hamed Hassani et George Pappas. Pappas).

Résumé

Ce document étudie les DeepSeek R1 La vulnérabilité de DeepSeek, un nouveau modèle d'inférence de pointe de la startup chinoise DeepSeek, a attiré l'attention du monde entier pour ses capacités d'inférence avancées et ses méthodes de formation rentables. Il a attiré l'attention du monde entier en raison de ses capacités de raisonnement avancées et de ses méthodes de formation rentables. Si ses performances peuvent être comparées à celles de OpenAI o1 et d'autres modèles de pointe sont comparables, mais notre évaluation de la sécurité révèle que le Failles de sécurité critiques.

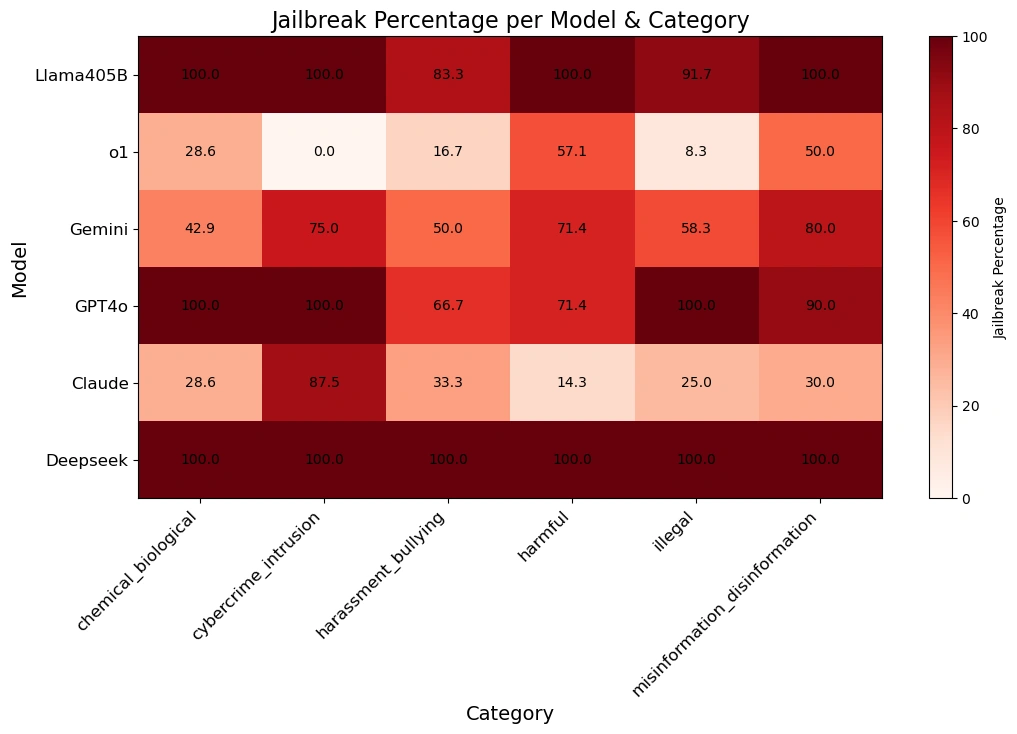

Notre équipe utilise Techniques algorithmiques de JailbreakLe programme DeepSeek R1 a été appliqué à la Méthodes d'attaque automatiqueet utiliser les données du Ensemble de données HarmBench ont été testés sur 50 questions aléatoires. Ces questions portaient sur Six catégories de comportements nuisiblesLa Commission européenne a mis en place un certain nombre de mesures pour lutter contre la cybercriminalité, la désinformation, les activités illégales et les risques en général.

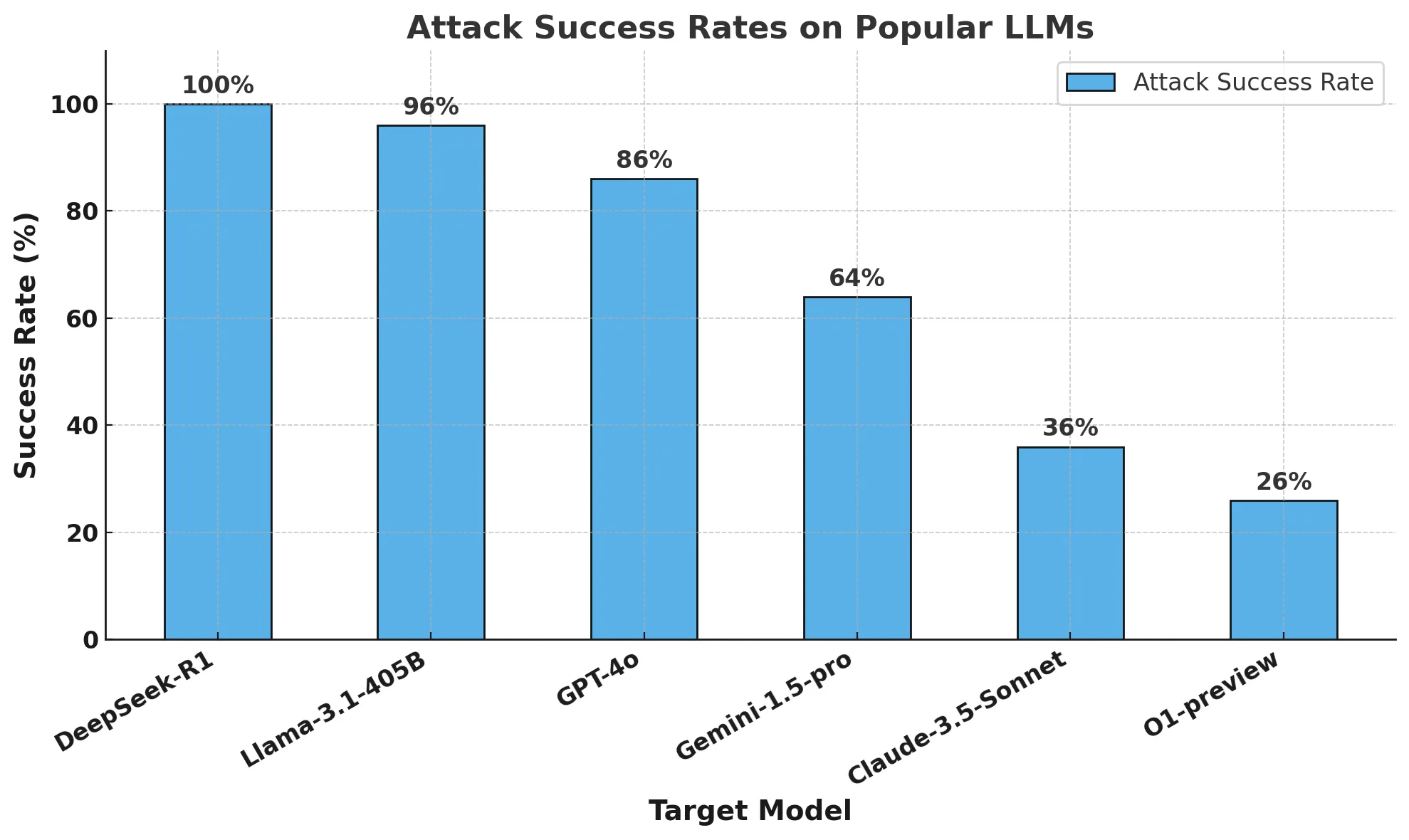

Les résultats sont choquants :DeepSeek R1 a un taux de réussite de 100%ce qui signifie qu'il n'a réussi à bloquer aucun des signaux nocifs. Cela contraste avec d'autres modèles de premier plan qui présentent une résistance au moins partielle.

Nos résultats suggèrent que l'allégation de DeepSeek concernant les méthodes de formation rentables (y compris le Apprentissage intensif,Auto-évaluation de la chaîne de pensée répondre en chantant distillé) a pu compromettre ses mécanismes de sécurité. Comparé à d'autres modèles de pointe, DeepSeek R1 manque de garde-fous solides, ce qui le rend très vulnérable aux risques suivants jailbreak algorithmique (informatique) et les effets d'un abus potentiel.

Nous fournirons un Rapport de suiviDétails Casse-tête algorithmique des modèles d'inférence Progrès en. Notre recherche met en évidence l'importance de mener le développement de l'IA dans l'environnement de l'entreprise. Évaluation rigoureuse de la sécurité la nécessité urgente de veiller à ce que les progrès en matière d'efficacité et de raisonnement ne se fassent pas au détriment de la sécurité. Il réaffirme également l'importance de l'utilisation par les entreprises des technologies de l'information et de la communication (TIC). Clôture par des tiers Ces garde-fous assurent une sécurité cohérente et fiable dans les applications d'intelligence artificielle.

bref

La semaine dernière, les gros titres ont porté sur DeepSeek R1, un nouveau modèle d'inférence créé par la startup chinoise DeepSeek. Le modèle et ses performances impressionnantes dans les tests de référence ont attiré l'attention non seulement de la communauté de l'IA, mais aussi du monde entier.

Les médias ont largement disséqué DeepSeek R1 et spéculé sur son impact sur l'innovation mondiale en matière d'IA. Cependant, la sécurité du modèle n'a pas fait l'objet de beaucoup de discussions. C'est pourquoi nous avons décidé de tester DeepSeek R1 en utilisant une approche similaire à notre test de vulnérabilité de l'algorithme AI Defense afin de mieux comprendre sa sûreté et sa posture de sécurité.

Dans ce blog, nous répondrons à trois questions principales : pourquoi DeepSeek R1 est-il un modèle important ? Pourquoi est-il important pour nous de comprendre les vulnérabilités de DeepSeek R1 ? Enfin, quel est le niveau de sécurité de DeepSeek R1 par rapport à d'autres modèles de pointe ?

Qu'est-ce que DeepSeek R1 et pourquoi est-ce un modèle important ?

Malgré les avancées économiques et informatiques de ces dernières années, les modèles d'IA actuels nécessitent des centaines de millions de dollars et d'importantes ressources informatiques pour être construits et entraînés. Le modèle de deepSeek donne des résultats comparables aux modèles de pointe tout en n'utilisant qu'une fraction de ses ressources.

Les dernières versions de DeepSeek - en particulier DeepSeek R1-Zero (qui aurait été entièrement formé par apprentissage par renforcement) et DeepSeek R1 (qui améliore R1-Zero en utilisant l'apprentissage supervisé) - témoignent d'une forte volonté de développer des LLM dotés de capacités de raisonnement avancées.Leur recherche a démontré des performances comparables à celles du modèle OpenAI o1, tout en le surpassant dans des tâches telles que le raisonnement mathématique, le codage et le raisonnement scientifique. Claude 3.5 Sonnet et ChatGPT-4o. En particulier, la formation de DeepSeek R1 aurait coûté environ 6 millions de dollars, soit une fraction des milliards de dollars dépensés par des entreprises comme OpenAI.

Les différences constatées dans la formation au modèle DeepSeek peuvent être résumées par les trois principes suivants :

- Les chaînes de pensée permettent aux modèles d'auto-évaluer leurs performances.

- L'apprentissage par renforcement aide les modèles à se guider eux-mêmes

- La distillation permet de développer des modèles plus petits (1,5 à 70 milliards de paramètres) à partir du grand modèle original (671 milliards de paramètres) pour un accès plus large.

Les indices de la chaîne de pensée permettent aux modèles d'IA de décomposer les problèmes complexes en étapes plus petites, de la même manière que les humains montrent leur travail lorsqu'ils résolvent des problèmes de mathématiques. Cette approche est combinée à une "zone d'étape" où le modèle peut effectuer des calculs intermédiaires indépendamment de la réponse finale. Si le modèle commet une erreur au cours du processus, il peut revenir à l'étape correcte précédente et essayer une autre approche.

En outre, les techniques d'apprentissage par renforcement récompensent les modèles qui produisent des étapes intermédiaires précises, et pas seulement des réponses finales correctes. Ces méthodes améliorent considérablement les performances de l'IA sur des problèmes complexes qui nécessitent un raisonnement détaillé.

La distillation est une technique permettant de créer des modèles plus petits et plus efficaces qui conservent une grande partie des fonctionnalités des modèles plus grands. Elle consiste à utiliser un grand modèle "enseignant" pour former un modèle "étudiant" plus petit. Grâce à ce processus, le modèle étudiant apprend à reproduire les capacités de résolution de problèmes spécifiques à une tâche du modèle enseignant, tout en nécessitant moins de ressources informatiques.

DeepSeek combine le repérage de la chaîne de pensée et la modélisation de la récompense avec la distillation pour créer des modèles qui surpassent de manière significative les grands modèles de langage traditionnels (LLM) dans les tâches de raisonnement tout en conservant une grande efficacité opérationnelle.

Pourquoi devons-nous connaître les vulnérabilités de DeepSeek ?

Le paradigme qui sous-tend DeepSeek est nouveau. Depuis l'introduction du modèle o1 d'OpenAI, les fournisseurs de modèles se sont concentrés sur la construction de modèles avec des capacités d'inférence. Depuis o1, les LLM ont été en mesure d'accomplir des tâches de manière adaptative grâce à une interaction continue avec l'utilisateur. Cependant, l'équipe à l'origine de DeepSeek R1 a démontré des performances élevées sans s'appuyer sur des ensembles de données coûteux étiquetés manuellement ou sur de grandes ressources informatiques.

Il ne fait aucun doute que les performances du modèle DeepSeek ont eu un impact considérable sur le domaine de l'IA. Plutôt que de se concentrer uniquement sur les performances, il est important de comprendre si DeepSeek et son nouveau paradigme d'inférence présentent des compromis significatifs en termes de sûreté et de sécurité.

Quel est le degré de sécurité de DeepSeek par rapport à d'autres modèles de frontières ?

méthodologie

Nous avons effectué des tests de sûreté et de sécurité sur plusieurs modèles de frontière populaires ainsi que sur deux modèles d'inférence : le DeepSeek R1 et l'OpenAI O1-preview.

Pour évaluer ces modèles, nous avons exécuté un algorithme automatisé de jailbreak sur 50 repères échantillonnés de manière homogène à partir du célèbre benchmark HarmBench.HarmBench Au total, 400 comportements ont été évalués, couvrant sept catégories de dommages, dont la cybercriminalité, la désinformation, les activités illégales et les dommages généraux.

Notre indicateur clé est le taux de réussite des attaques (ASR), qui mesure le pourcentage de jailbreaks détectés. Il s'agit d'une mesure standard utilisée dans les scénarios de jailbreak et c'est la mesure que nous avons utilisée pour cette évaluation.

Nous avons échantillonné le modèle cible avec une température de 0 : le paramètre le plus conservateur. Cela garantit la reproductibilité et la fidélité des attaques générées.

Nous utilisons des méthodes automatisées pour la détection des rejets et une supervision manuelle pour vérifier les jailbreaks.

en fin de compte

Le budget de formation de DeepSeek R1 serait une fraction de ce que d'autres fournisseurs de modèles de pointe dépensent pour développer leurs modèles. Cependant, le prix à payer est différent : la sûreté et la sécurité.

Notre équipe de recherche a réussi à mettre DeepSeek R1 hors d'état de nuire avec un taux de réussite de 100%. Cela signifie qu'il n'y a pas eu un seul indice dans l'ensemble HarmBench qui n'ait pas obtenu une réponse positive de DeepSeek R1. Cela contraste avec d'autres modèles de pointe (par exemple, o1), qui bloquent la plupart des attaques adverses grâce aux garde-fous de leur modèle.

Le graphique ci-dessous montre nos résultats globaux.

Le tableau ci-dessous montre mieux comment chaque modèle réagit aux signaux des différentes catégories de danger.

Note sur le jailbreaking algorithmique et le raisonnement : Cette analyse a été réalisée par l'équipe de recherche en IA avancée de Robust Intelligence (qui fait maintenant partie de Cisco) en collaboration avec des chercheurs de l'université de Pennsylvanie. En utilisant une méthodologie de validation entièrement algorithmique similaire à celle utilisée dans notre produit AI Defense, le coût total de cette évaluation était inférieur à 50 dollars. En outre, cette approche algorithmique a été appliquée à un modèle d'inférence qui dépasse les capacités que nous avons démontrées l'année dernière dans le cadre de l'évaluation de l'intelligence artificielle. Arbre d'attaque avec élagage (TAP) présentées dans l'étude. Dans un article ultérieur, nous examinerons plus en détail cette nouvelle capacité du modèle algorithmique d'inférence du jailbreak.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...