Prompt Optimizer : un outil open source permettant d'optimiser les mots-guides pour les modèles d'IA grand public

Introduction générale

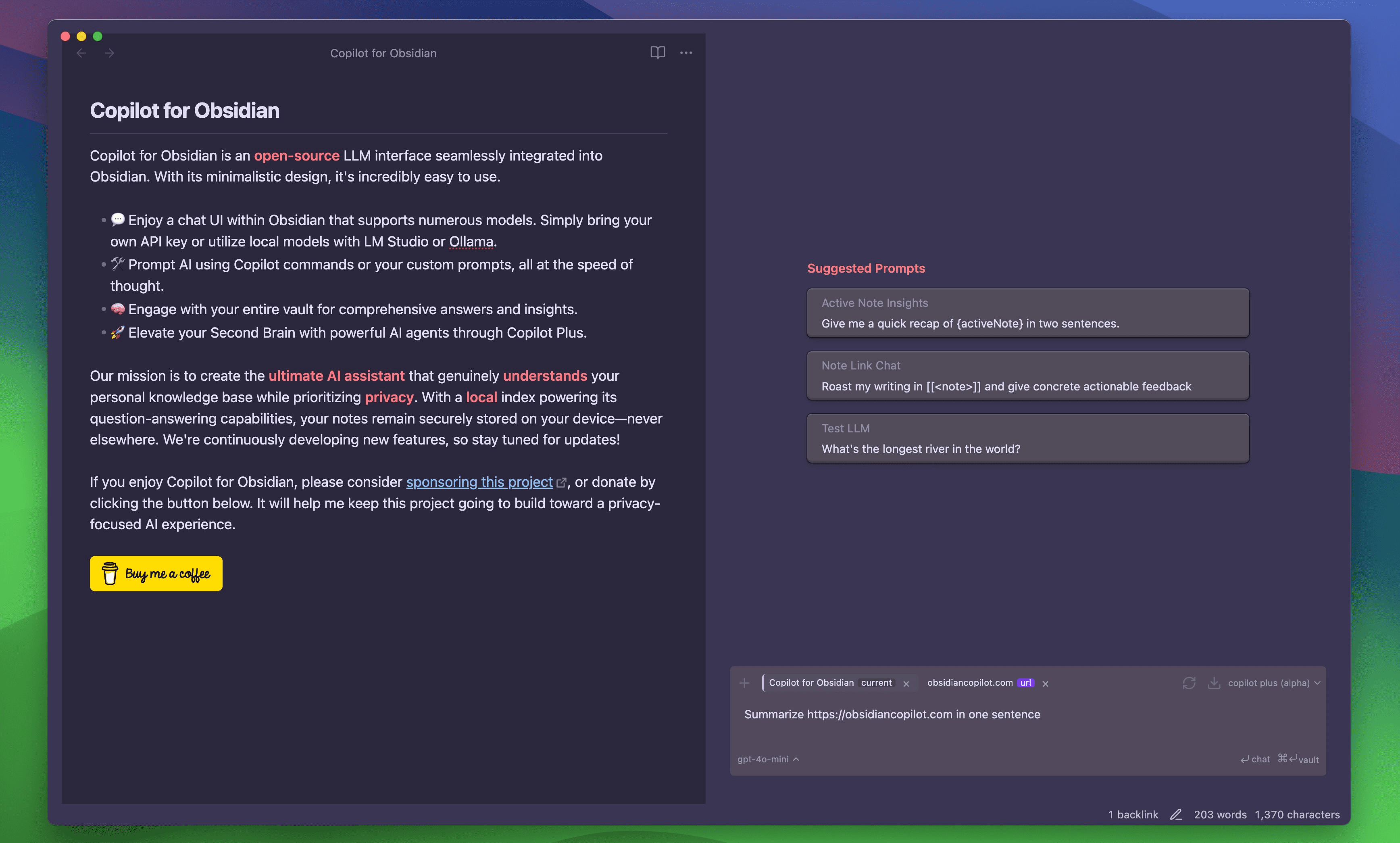

Prompt Optimizer est un outil open source axé sur l'optimisation des mots-guides, développé par linshenkx sur GitHub. Il aide les utilisateurs à optimiser les mots-guides des modèles d'IA à l'aide d'algorithmes intelligents afin d'améliorer la qualité et la précision du contenu généré. L'outil permet un déploiement en un clic dans Vercel, ce qui est facile à utiliser et convient aux développeurs et aux passionnés d'IA. Le projet intègre plusieurs modèles d'IA courants (par exemple OpenAI, Gemini, DeepSeek, etc.) et fournit des tests en temps réel afin que les utilisateurs puissent voir immédiatement les résultats optimisés. En outre, il met l'accent sur la protection de la vie privée, tous les traitements de données étant effectués côté client, et les clés d'API et l'historique étant stockés par cryptage local pour garantir la sécurité. Il a déjà suscité beaucoup d'intérêt sur la plateforme X, et les utilisateurs ont déclaré qu'il s'agissait d'un "excellent outil dans la boîte à outils".

Liste des fonctions

- Optimisation intelligente des repèresLes algorithmes optimisent automatiquement les invites saisies par l'utilisateur afin d'améliorer la qualité des résultats générés par l'IA.

- Test d'effet en temps réelLes modèles d'évaluation de la qualité de l'eau et de la qualité de l'air sont également pris en compte dans l'évaluation de la qualité de l'eau et de la qualité de l'air.

- Intégration de plusieurs modèlesCompatible avec OpenAI, Gemini, DeepSeek et d'autres modèles d'IA grand public pour répondre à des besoins diversifiés.

- Déploiement en un clic vers VercelLe système de gestion de l'information est un processus de déploiement facile qui ne nécessite pas de configuration complexe pour être opérationnel.

- Mécanismes de protection de la vie privéeLe système de gestion de l'information de l'Union européenne (UE) est un système de gestion de l'information de l'Union européenne (UE) qui permet à l'UE de gérer l'information de l'Union européenne de manière efficace.

- Structures d'ingénierie à paquets multiplesExtensible avec des fonctionnalités de base (core), des bibliothèques de composants d'interface utilisateur (ui), des applications web (web) et des plug-ins Chrome (extension).

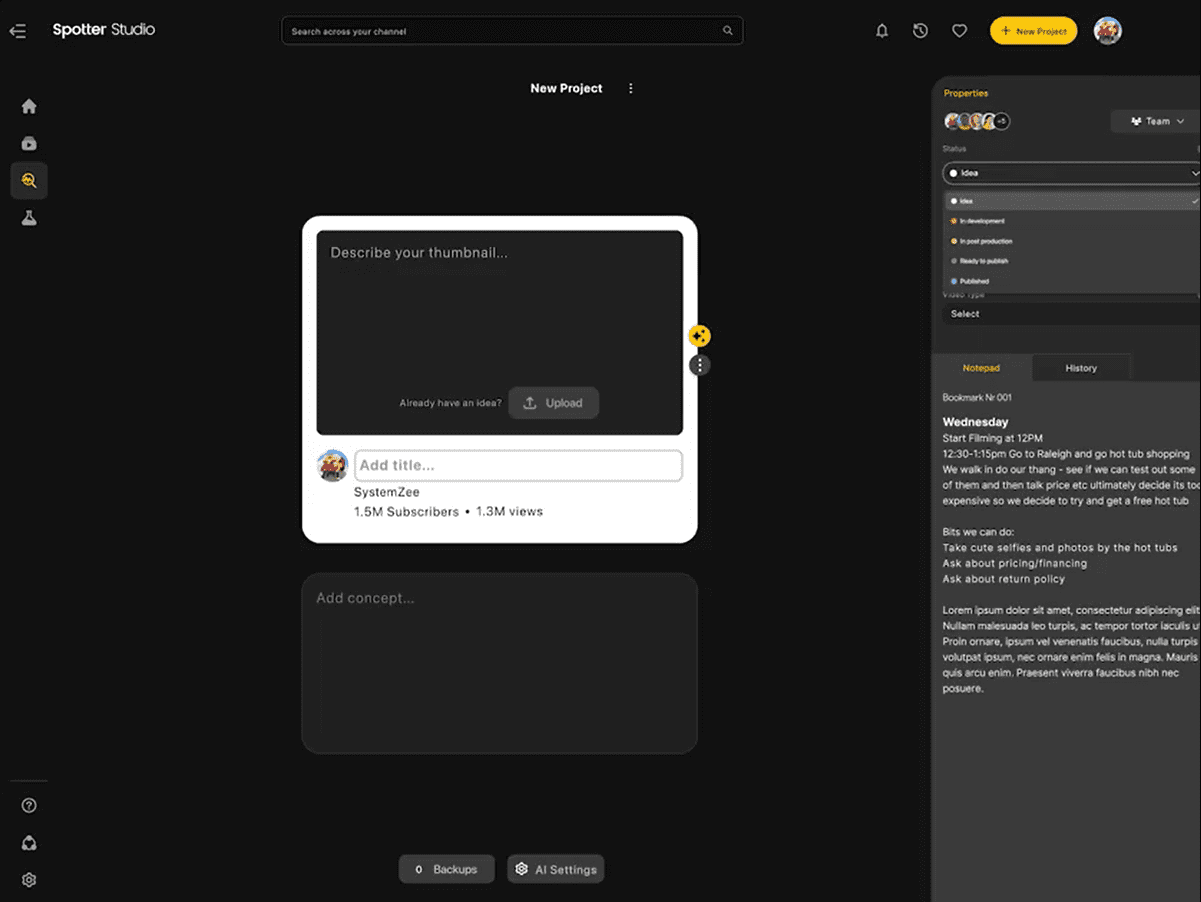

- Gestion de l'histoireLes utilisateurs peuvent ainsi revoir et réutiliser les schémas de mots repères précédents.

Utiliser l'aide

Processus d'installation

Prompt Optimizer est un projet open source basé sur GitHub qui prend en charge le développement local et le déploiement en un clic de Vercel. Voici les étapes détaillées de l'installation et de l'utilisation :

Mode 1 : Installation et fonctionnement locaux

- projet de clonage

Clonez le projet localement en entrant la commande suivante dans le terminal :git clone https://github.com/linshenkx/prompt-optimizer.git

Allez ensuite dans le répertoire du projet :

cd prompt-optimizer

- Installation des dépendances

Le projet utilise pnpm comme outil de gestion des paquets, il faut donc s'assurer que pnpm est installé (via le fichiernpm install -g pnpm(Installer). Exécutez ensuite :pnpm installCeci installera tous les paquets de dépendances nécessaires.

- Configuration des clés API

Le projet prend en charge plusieurs modèles d'IA et doit configurer les clés API correspondantes. Dans le répertoire racine du projet, créez le fichier.envajoutez les éléments suivants (choisissez la configuration en fonction de vos besoins réels) :VITE_OPENAI_API_KEY=your_openai_api_key VITE_GEMINI_API_KEY=your_gemini_api_key VITE_DEEPSEEK_API_KEY=your_deepseek_api_key VITE_CUSTOM_API_KEY=your_custom_api_key VITE_CUSTOM_API_BASE_URL=your_custom_api_base_url VITE_CUSTOM_API_MODEL=your_custom_model_nameLa clé peut être obtenue auprès du fournisseur de services d'IA correspondant (par exemple, sur le site web de l'OpenAI).

- Démarrer les services de développement

Exécutez la commande suivante pour démarrer l'environnement de développement local :pnpm devVous pouvez également utiliser la commande suivante pour reconstruire le système et l'exécuter à nouveau (recommandé pour le démarrage initial ou après une mise à jour) :

pnpm dev:freshAu démarrage, le navigateur s'ouvre automatiquement

http://localhost:xxxx(le numéro de port spécifique dépend de l'invite du terminal), vous pouvez accéder à l'interface de l'outil.

Approche 2 : Déploiement de Vercel en un clic

- Visitez la page du projet sur GitHub

Ouvrez https://github.com/linshenkx/prompt-optimizer et cliquez sur le bouton "Fork" dans le coin supérieur droit pour copier le projet sur votre compte GitHub. - Importation à Vercel

Connectez-vous à Vercel, cliquez sur "Nouveau projet", sélectionnez "Importer le dépôt Git" et entrez l'adresse de votre projet (par ex.https://github.com/your-username/prompt-optimizer). - Configuration des variables d'environnement

Dans les paramètres du projet Vercel, allez à la page "Variables d'environnement" et ajoutez la clé API ci-dessus (par ex.VITE_OPENAI_API_KEY) pour assurer la cohérence avec la configuration locale. - Projets de déploiement

Cliquez sur le bouton "Déployer" et Vercel construira et déploiera automatiquement le projet. Une fois le déploiement terminé, vous recevrez une URL publique (par ex.https://prompt-optimizer-yourname.vercel.app), l'outil est accessible via ce lien.

Principales fonctions

1. optimisation des signaux intelligents

- procédure: :

- Ouvrez la page d'accueil de l'outil et localisez la zone de texte "Enter Prompt Words".

- Saisissez un mot-clé initial, par exemple "Aidez-moi à écrire un article sur l'IA".

- En cliquant sur le bouton "Optimiser", le système analysera et générera automatiquement des messages optimisés, par exemple "Veuillez rédiger un article bien structuré et approfondi sur le développement de la technologie de l'IA".

- Les résultats de l'optimisation sont affichés ci-dessous et peuvent être copiés et utilisés directement.

- Scénarios d'utilisationLe système est idéal pour les tâches qui requièrent une meilleure qualité des résultats de l'IA, telles que l'écriture, la génération de code, etc.

2) Tests d'effets en temps réel

- procédure: :

- Sous les messages optimisés, cliquez sur le bouton "Résultats du test".

- Sélectionnez le modèle d'IA cible (par exemple OpenAI ou Gemini) et le système appellera le modèle correspondant pour générer la sortie.

- Les résultats des tests sont affichés sur l'interface, ce qui permet de les comparer avec la sortie du mot repère original.

- Scénarios d'utilisationLes résultats de l'optimisation sont vérifiés et les mots repères sont rapidement ajustés.

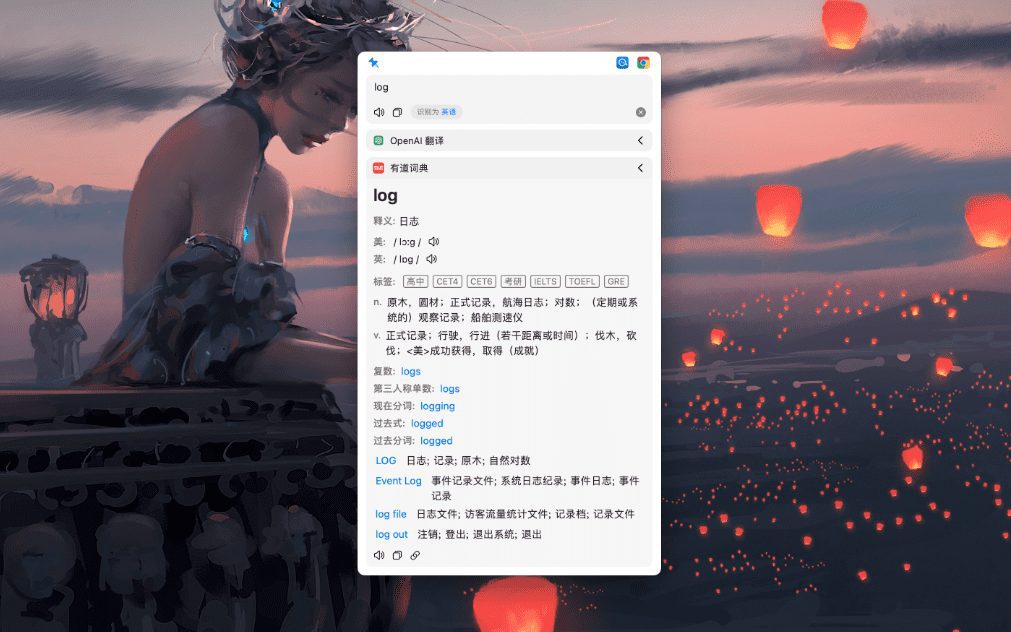

3. configurer le support multi-modèle

- procédure: :

- Sur la page Paramètres (généralement l'icône de l'engrenage dans le coin supérieur droit), allez à l'option "Sélection du modèle".

- Sélectionnez un modèle configuré (par exemple OpenAI, Gemini) dans le menu déroulant ou saisissez manuellement les informations relatives à l'API pour un modèle personnalisé.

- Après avoir enregistré les paramètres, vous pouvez revenir à l'interface principale pour optimiser et tester le modèle sélectionné.

- Scénarios d'utilisationLes modèles d'évaluation des risques : changement de modèle souple lorsqu'il s'agit de comparer les effets d'un modèle à l'autre.

4. affichage de l'historique

- procédure: :

- Cliquez sur le bouton "Historique" (généralement une icône d'horloge) à l'écran.

- Le système répertorie les mots clés précédemment optimisés et les résultats de leurs tests.

- Cliquez sur un enregistrement pour afficher les détails ou pour réutiliser directement le mot clé.

- Scénarios d'utilisationLes scénarios d'optimisation antérieurs sont passés en revue afin d'éviter la duplication des efforts.

mise en garde

- Assurez-vous que la connexion réseau est stable et que les appels API nécessitent un accès en temps réel aux services externes.

- Les clés d'API doivent être conservées en toute sécurité pour éviter les fuites.

- Si vous rencontrez des problèmes de déploiement ou de fonctionnement, vous pouvez vous référer au tableau "Issues" sur la page GitHub pour obtenir de l'aide.

Avec les étapes ci-dessus, les utilisateurs peuvent rapidement commencer à utiliser Prompt Optimizer, ce qui facilite l'optimisation des mots-guides et améliore les performances des modèles d'IA, qu'ils soient développés localement ou déployés en ligne.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...