Comment les robots d'OpenAI ont agi comme une attaque DDoS pour détruire le site web d'une entreprise de sept personnes

Samedi, le PDG de Triplegangers, Oleksandr Tomchuk, a été informé que le site de commerce électronique de son entreprise était en panne. Cela ressemblait à une sorte d'attaque par déni de service distribué.

Il découvre rapidement que le coupable est l'un des robots d'OpenAI, qui tente sans relâche d'explorer l'ensemble de son énorme site web.

"Nous avons plus de 65 000 produits et chaque produit a une page", a déclaré Tomchuk à TechCrunch, "chaque page contient au moins trois photos".

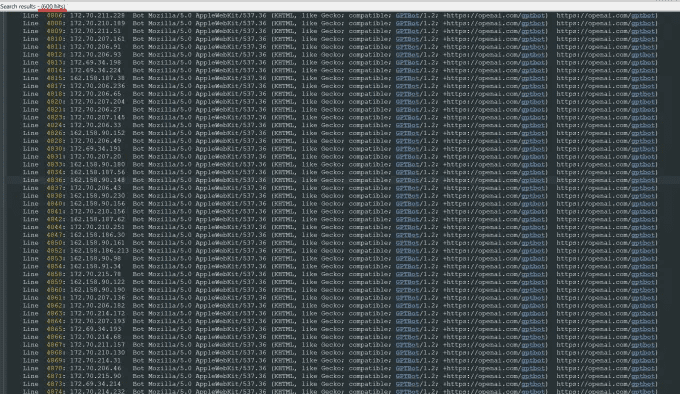

OpenAI a envoyé des "dizaines de milliers" de requêtes au serveur pour essayer de télécharger tout ce contenu, y compris des centaines de milliers de photos et leurs descriptions détaillées.

"OpenAI a utilisé 600 adresses IP pour explorer les données, et nous sommes encore en train d'analyser les journaux de la semaine dernière, donc le nombre est peut-être encore plus élevé", a-t-il déclaré à propos des adresses IP que le robot a utilisées pour essayer d'accéder à son site.

"Leurs robots détruisaient notre site", a-t-il déclaré. "Il s'agissait en fait d'une attaque DDoS".

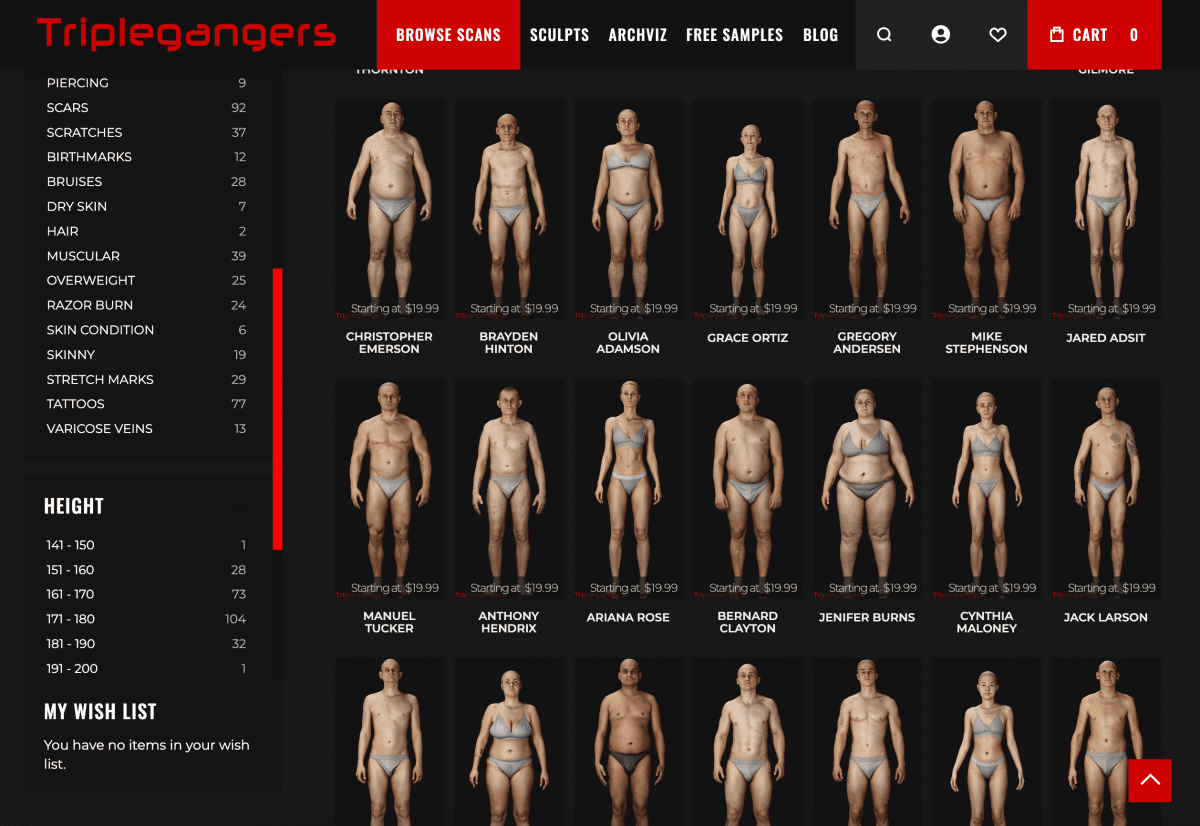

Le site web de Triplegangers est son activité. Cette société de sept employés a passé plus d'une décennie à rassembler ce qu'elle appelle la plus grande base de données de "doubles numériques humains" sur le web, c'est-à-dire des fichiers d'images 3D scannés à partir de mannequins réels.

Elle vend des fichiers d'objets 3D ainsi que des photographies aux artistes 3D, aux producteurs de jeux vidéo et à tous ceux qui ont besoin de reconstituer numériquement les caractéristiques du corps humain réel - des mains aux cheveux, en passant par la peau et le corps tout entier.

L'équipe de Tomchuk est basée en Ukraine, mais elle est également licenciée à Tampa, en Floride, aux États-Unis, et son site web comporte une page de conditions d'utilisation qui interdit aux robots d'accéder à ses images sans autorisation. Mais cela ne suffit pas. Le site doit utiliser un fichier robot.txt correctement configuré contenant des balises qui indiquent explicitement au robot d'OpenAI, GPTBot, de ne pas accéder au site. (OpenAI a plusieurs autres robots, ChatGPT-User et OAI-SearchBot, qui ont leurs propres balises, basées sur leurs pages d'information sur le crawler).

Robot.txt, également connu sous le nom de Robots Exclusion Protocol (protocole d'exclusion des robots), est conçu pour indiquer aux sites des moteurs de recherche ce qu'ils ne doivent pas explorer lorsqu'ils indexent le web. openAI indique sur sa page d'information qu'il se conformera à de tels fichiers lorsqu'ils sont configurés avec sa propre balise "no-crawl", bien qu'il prévienne également que ses robots peuvent prendre jusqu'à 24 heures pour reconnaître un fichier robot.txt mis à jour.

Comme Tomchuk l'a expérimenté, si un site n'utilise pas correctement le fichier robot.txt, OpenAI et d'autres considèrent que cela signifie qu'ils peuvent explorer le contenu à leur guise. Il ne s'agit pas d'un système opt-in.

Pour ne rien arranger, non seulement les Triplegangers qui travaillent aux États-Unis sont déconnectés par le robot d'OpenAI, mais M. Tomchuk s'attend à une augmentation significative des factures AWS en raison de l'activité de l'unité centrale et des téléchargements du robot.

Robot.txt n'est pas non plus infaillible. Les entreprises d'IA s'y conforment volontairement. Une autre entreprise d'IA, Perplexity, s'est fait connaître l'été dernier à la suite d'une enquête du magazine Wired, lorsque certains éléments de preuve ont laissé entendre que Perplexité Nous n'avons pas le temps de nous y conformer.

Impossible de déterminer l'objet de l'accès

Mercredi, quelques jours après le retour du robot d'OpenAI, les Triplegangers avaient correctement configuré le fichier robot.txt et créé un compte Cloudflare pour bloquer son GPTBot et plusieurs autres robots qu'il avait trouvés, tels que Barkrowler (un crawler SEO) et Bytespider (le crawler de TikTok). M. Tomchuk espère également avoir bloqué les robots d'autres sociétés de modélisation de l'IA. Il a indiqué que le site n'était pas tombé en panne jeudi matin.

Mais Tomchuk n'a toujours pas de moyen raisonnable de découvrir exactement ce qu'OpenAI a réussi à faire pour accéder au matériel ou le supprimer. OpenAI n'a pas répondu à la demande de commentaire de TechCrunch. OpenAI n'a pas répondu à la demande de commentaire de TechCrunch, et OpenAI n'a pas encore réussi à mettre en place son outil de retrait promis depuis longtemps, comme l'a récemment rapporté TechCrunch.

Cette question est particulièrement épineuse pour Triplegangers. "Les droits sont une question importante dans notre secteur d'activité, car nous scannons de vraies personnes", explique-t-il. En vertu de lois telles que le GDPR européen, "ils ne peuvent pas simplement prendre une photo de n'importe qui sur le web et l'utiliser".

Le site web de Triplegangers est également une trouvaille particulièrement savoureuse pour les crawlers d'IA. Le site web de Triplegangers contient des photos étiquetées détaillées : race, âge, tatouages et cicatrices, tous les types de corps, etc.

Ironiquement, c'est l'avidité du robot OpenAI qui rappelle aux Triplegangers à quel point ils sont exposés. Il affirme que s'il avait gratté plus doucement, Tomchuk ne l'aurait jamais su.

C'est effrayant parce que ces entreprises semblent exploiter une faille pour explorer des données, et elles disent "si vous mettez à jour votre robot.txt avec nos balises, vous pouvez vous retirer"", a déclaré M. Tomchuk, mais c'est aux propriétaires d'entreprises qu'il incombe de trouver des moyens de les arrêter. de l'entreprise sur la façon de les arrêter.

Il souhaite que les autres petites entreprises en ligne sachent que le seul moyen de savoir si un robot d'intelligence artificielle accède à des contenus protégés par le droit d'auteur sur un site web est de le rechercher activement. Il n'est certainement pas le seul à être terrorisé par ces robots. D'autres propriétaires de sites web ont récemment expliqué à Business Insider comment les robots d'OpenAI détruisaient leurs sites web et augmentaient leurs factures d'AWS.

En 2024, le problème s'aggrave de manière exponentielle. Une nouvelle étude réalisée par la société de publicité numérique DoubleVerify a révélé que les robots d'indexation par IA et les outils d'indexation ont entraîné une augmentation de 861 TP3T du "trafic général non valide" en 2024, c'est-à-dire du trafic qui ne provient pas d'utilisateurs réels.

Néanmoins, "la plupart des sites ne savent toujours pas qu'ils sont explorés par ces robots", prévient M. Tomchuk. "Nous devons maintenant surveiller quotidiennement l'activité des journaux pour repérer ces robots.

À bien y réfléchir, le modèle fonctionne un peu comme une extorsion mafieuse : si vous n'êtes pas protégé, les robots d'IA prendront ce qu'ils veulent.

"Ils devraient demander la permission et ne pas se contenter de saisir des données", a déclaré M. Tomchuk.

Lecture connexe.

1) OpenAI a lancé un nouvel outil d'exploration du web appelé GPTBot pour résoudre les problèmes de confidentialité et de propriété intellectuelle soulevés par la collecte de données sur les sites web publics. Cette technologie vise à collecter de manière transparente des données web publiques et à les utiliser pour entraîner ses modèles d'IA, le tout sous la bannière de l'OpenAI.

2) OpenAI utilise des robots ("bots") et des agents utilisateurs pour effectuer des actions pour ses produits qui sont soit automatisées soit déclenchées par des demandes d'utilisateurs. openAI utilise la balise robots.txt suivante pour permettre aux webmasters de gérer la façon dont leurs sites web et leur contenu fonctionnent avec l'IA. . Chaque paramètre est indépendant des autres - par exemple, un administrateur de site peut autoriser OAI-SearchBot à apparaître dans les résultats de recherche tout en désactivant GPTbot pour indiquer que le contenu exploré ne doit pas être utilisé pour entraîner le modèle de base d'IA générative d'OpenAI. Pour les résultats de recherche, veuillez noter qu'il faut compter environ 24 heures pour que les ajustements soient effectués à partir de la mise à jour du fichier robots.txt d'un site vers notre système.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...

![[转]Deepseek R1可能找到了超越人类的办法](https://aisharenet.com/wp-content/uploads/2025/01/5caa5299382e647.jpg)