LiteLLM : SDK Python pour l'appel unifié de plusieurs API de Big Model, outil d'appel et de gestion LLM multiplateforme

Introduction générale

LiteLLM est un SDK Python et un serveur proxy développé par BerriAI pour simplifier et unifier l'invocation et la gestion de plusieurs API de grands modèles de langage (LLM). Il prend en charge plus de 100 API de grands modèles, y compris OpenAI, HuggingFace, Azure, etc., et les unifie dans le format OpenAI, ce qui permet aux développeurs de passer facilement d'un service d'IA à l'autre et de le gérer. LiteLLM permet aux utilisateurs d'appeler plus de 100 API LLM au format OpenAI via un serveur proxy et un SDK Python, ce qui améliore considérablement l'efficacité et la flexibilité du développement.

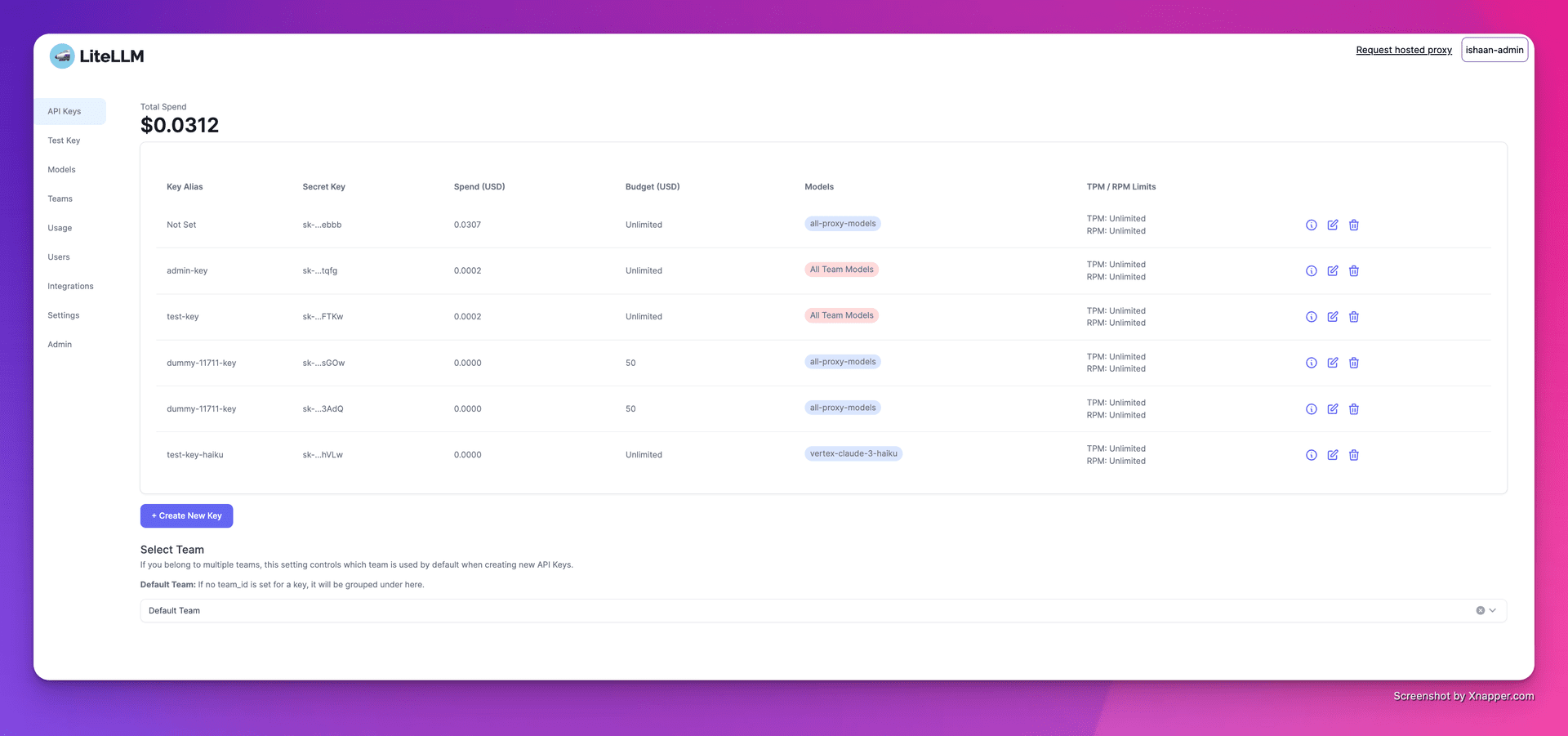

1. créer des clés

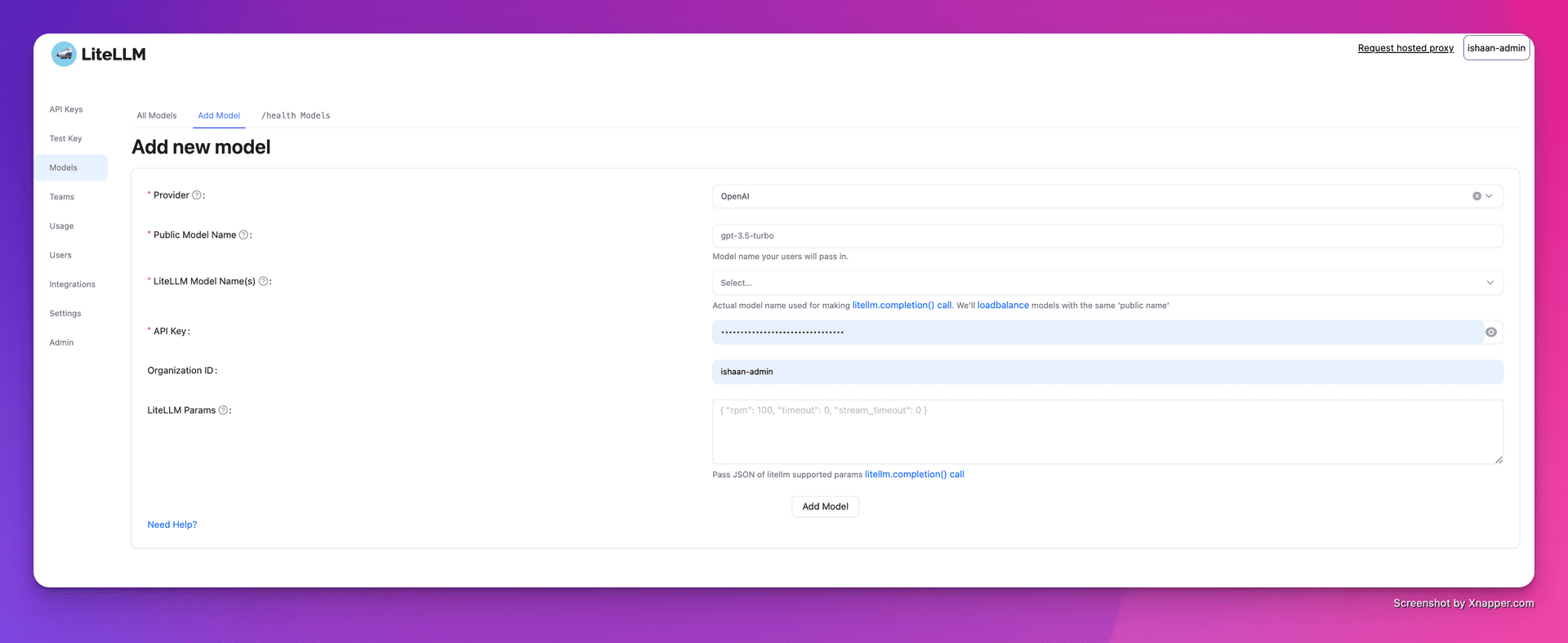

2. ajouter des modèles

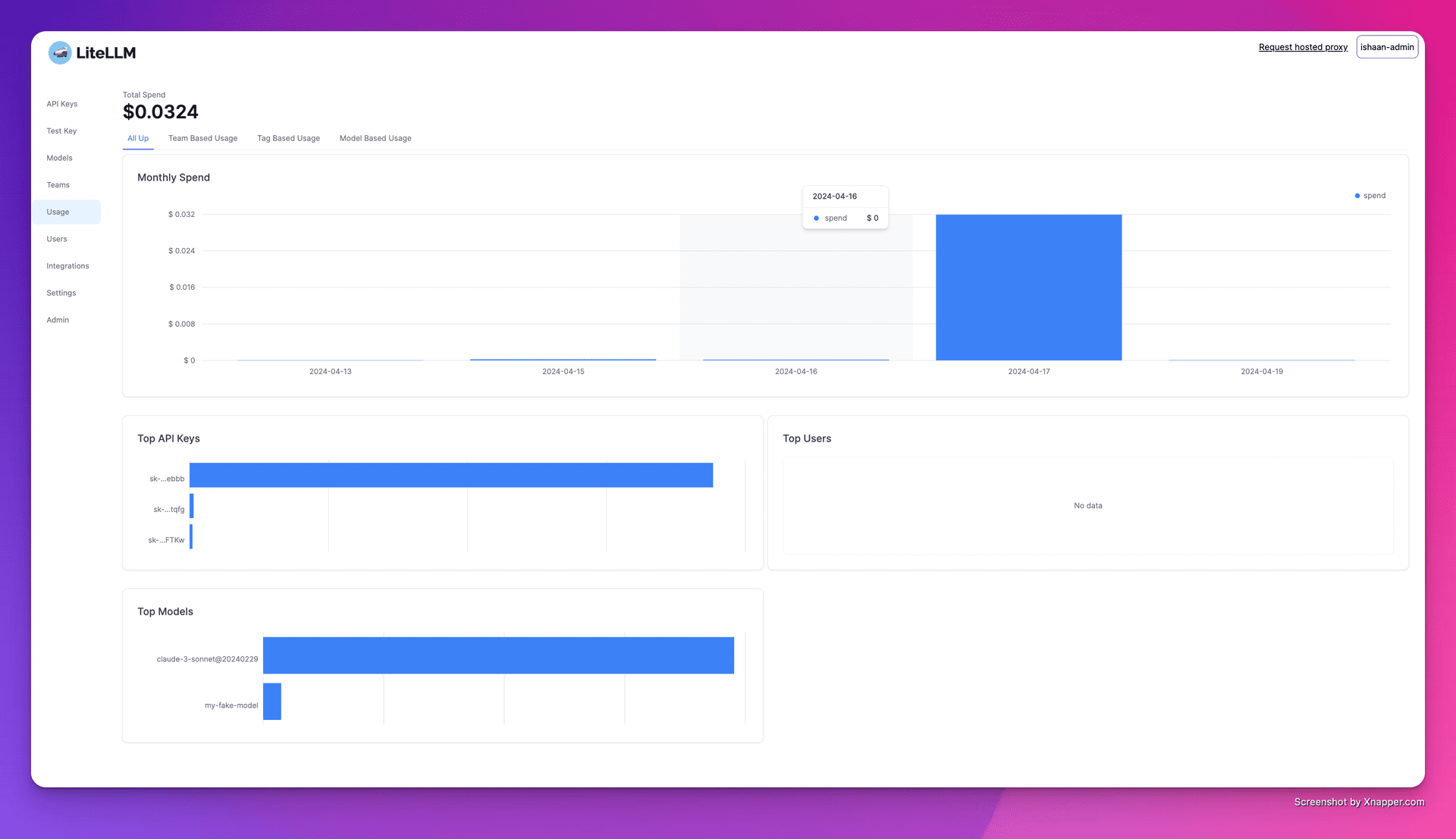

3. le suivi des dépenses

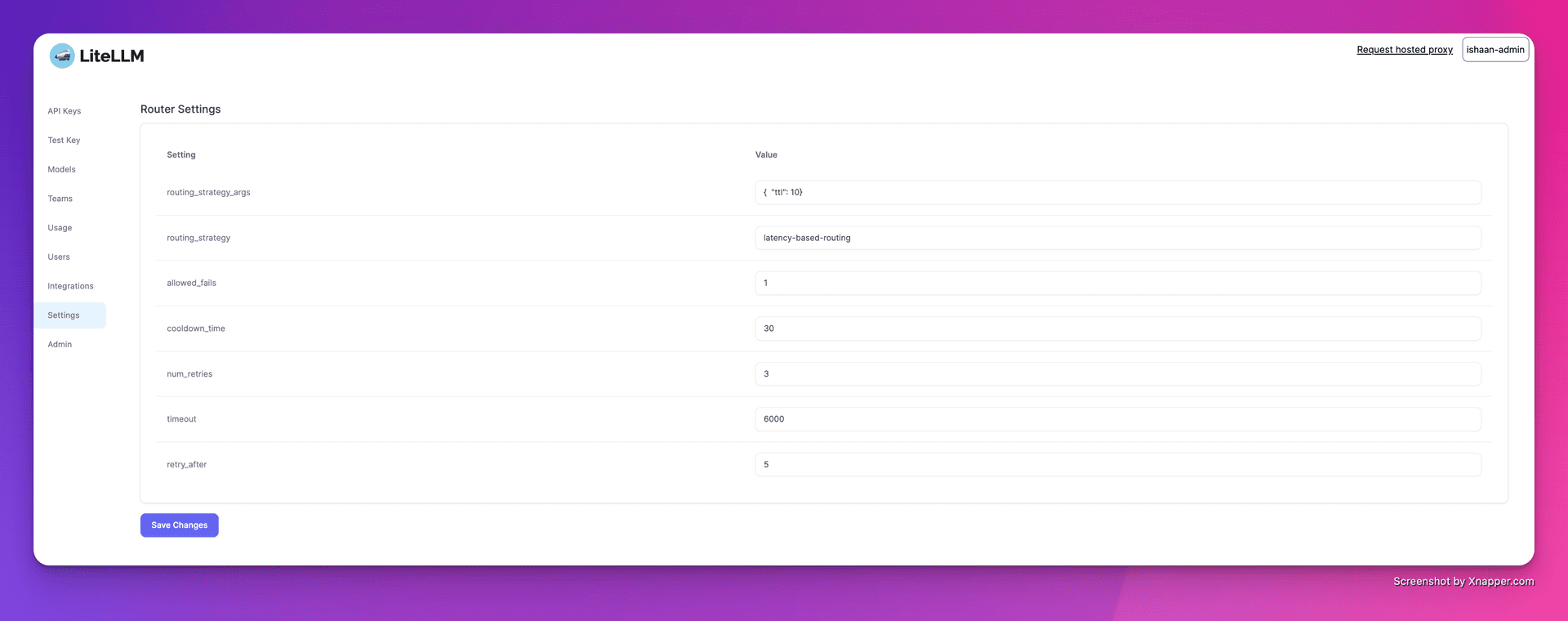

4. configuration de l'équilibrage de la charge

Liste des fonctions

- Support multiplateformeSupport de plusieurs fournisseurs LLM tels que OpenAI, Cohere, Anthropic, et plus encore. Prise en charge de plus de 100 appels d'API de grands modèles.

- version stableLe service d'hébergement : Il fournit des images Docker stables qui ont été testées en charge pendant 12 heures. Prise en charge de la définition de limites de budget et de fréquence des demandes.

- serveur proxyLes nouvelles fonctionnalités sont les suivantes : invocation unifiée de plusieurs API LLM par l'intermédiaire d'un serveur proxy, conversion unifiée du format API au format OpenAI.

- SDK PythonLe logiciel Python : Un SDK Python est fourni pour simplifier le processus de développement.

- réponse en continuSupport pour le streaming des réponses du modèle de retour afin d'améliorer l'expérience de l'utilisateur.

- fonction de rappelLe système de gestion de l'information (SGI) : il prend en charge plusieurs rappels pour faciliter l'enregistrement et la surveillance.

Utiliser l'aide

Installation et configuration

- Installation de DockerPour cela, il faut : s'assurer que Docker est installé sur votre système.

- Tirer les miroirs: Utilisation

docker pulltire une image stable de LiteLLM. - Démarrer le serveur proxy: :

cd litellm echo 'LITELLM_MASTER_KEY="sk-1234"' > .env echo 'LITELLM_SALT_KEY="sk-1234"' > .env source .env poetry run pytest . - Configuration du clientLe code d'accès au serveur proxy et à la clé API : Définissez l'adresse du serveur proxy et la clé API dans le code.

import openai client = openai.OpenAI(api_key="your_api_key", base_url="http://0.0.0.0:4000") response = client.chat.completions.create(model="gpt-3.5-turbo", messages=[{"role": "user", "content": "Hello, how are you?"}]) print(response)

Fonctions d'utilisation

- modèle d'invocation: à travers

model=<provider_name>/<model_name>Appeler des modèles de différents fournisseurs. - réponse en continu: Réglages

stream=TrueObtenir la réponse en continu.response = await acompletion(model="gpt-3.5-turbo", messages=messages, stream=True) for part in response: print(part.choices.delta.content or "") - Définition des rappelsLes fonctions de rappel : Configurer les fonctions de rappel pour enregistrer les entrées et les sorties.

litellm.success_callback = ["lunary", "langfuse", "athina", "helicone"]

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...