Résoudre la confusion o1, les modèles d'inférence comme DeepSeek-R1 sont-ils pensants ou non ?

J'ai trouvé un article amusant sur leLes idées fusent de toutes parts : sur la sous-pensée des LLM de type o1"Le sujet est d'analyser le modèle de raisonnement de type o1. Les changements fréquents de cheminement de la pensée et le manque de concentration dans la pensée, désignés sous le nom de"sous-pensée".Des méthodes d'atténuation sont également proposées. Cet article répond en même temps à la question de savoir si le modèle d'inférence est en train de repenser ou non, et nous espérons que le lecteur trouvera sa propre réponse.

I. Contexte :

Ces dernières années, les grands modèles de langage (LLM), représentés par le modèle o1 de l'OpenAI, ont démontré des capacités supérieures dans les tâches de raisonnement complexes, où ils imitent la profondeur de la pensée humaine en augmentant la quantité de calcul impliquée dans le processus de raisonnement. Cependant, les études existantes ont remis en question la profondeur de la pensée des LLM :Ces modèles réfléchissent-ils vraiment en profondeur ?

Pour répondre à cette question, les auteurs de ce document proposent"Sous-pensée".du concept et l'analyse de manière systématique. Les auteurs soutiennent que lepas assez de matière à réflexionest la première classe de LLM pour la résolution de problèmes complexes.Abandonner trop tôt des voies d'inférence prometteuses conduit à une réflexion insuffisante et affecte en fin de compte la performance du modèle.. Ce phénomène est particulièrement marqué dans les énigmes mathématiques.

II. méthodes de réflexion et de recherche :

Pour approfondir le phénomène de la sous-pensée, les auteurs ont mené les recherches suivantes :

1. les définitions et le phénomène de sous-observation et de sous-réflexion

- Définir la pensée : Les auteurs définissent la "pensée" comme une étape cognitive intermédiaire dans le processus de raisonnement d'un modèle, et utilisent des termes tels que "alternativement" comme signe d'un changement de pensée.

- Exemple : Dans la figure 2, les auteurs montrent un exemple de résultat d'un modèle contenant 25 étapes de réflexion et le comparent au résultat d'une réflexion excessive.

- Conception expérimentale :

- Ensembles de tests : Les auteurs ont choisi trois séries de tests difficiles :

- MATH500. Contient des questions issues de concours de mathématiques de l'enseignement secondaire, d'une difficulté allant de 1 à 5.

- GPQA Diamond. Contient des questions à choix multiples de niveau supérieur en physique, chimie et biologie.

- AIME2024. Les sujets abordés lors du concours invitation américain de mathématiques couvrent un large éventail de domaines, notamment l'algèbre, le comptage, la géométrie, la théorie des nombres et les probabilités.

- Sélection du modèle : Les auteurs ont choisi deux modèles open-source de la classe o1 avec de longues chaînes de pensée visibles : le QwQ-32B-Preview et le DeepSeek-R1-671B, et ont utilisé le DeepSeek-R1-Preview comme complément pour montrer le développement de la famille de modèles R1.

- Ensembles de tests : Les auteurs ont choisi trois séries de tests difficiles :

2. analyser les manifestations d'une réflexion insuffisante

- Réflexion sur la fréquence de commutation et la difficulté du problème :

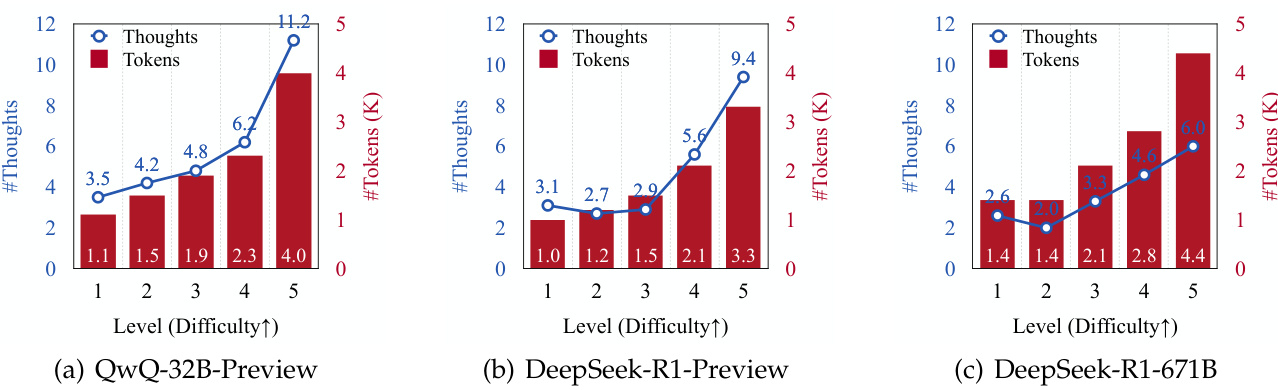

- Les auteurs ont constaté que le nombre de réflexions d'inférence générées et le nombre de jetons générés augmentaient pour tous les modèles à mesure que la difficulté du problème augmentait (voir figure 3).

- Ceci suggère que les LLM de la classe o1 sont capables d'adapter dynamiquement le processus de raisonnement pour faire face à des problèmes plus complexes.

- Réflexion sur la commutation et la réponse aux erreurs :

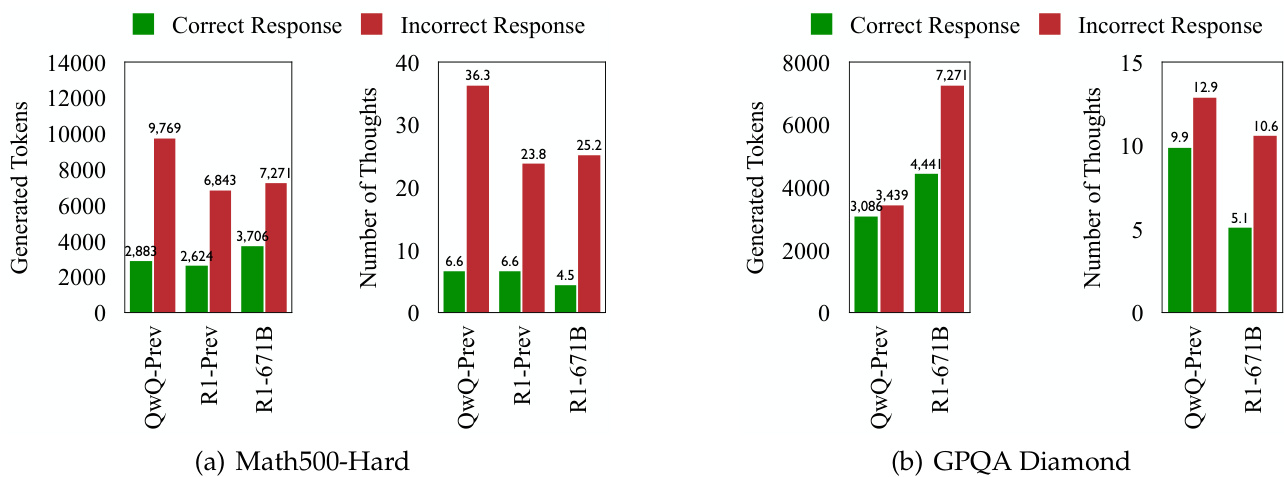

- Dans toutes les séries de tests, les LLM de la classe o1 ont montré des changements de pensée plus fréquents lors de la génération de réponses incorrectes (voir les figures 1 et 4).

- Cela suggère que, bien que le modèle vise à adapter dynamiquement les processus cognitifs pour résoudre les problèmes, des changements de mode de pensée plus fréquents ne conduisent pas nécessairement à une plus grande précision.

3. une enquête approfondie sur la nature du déficit de réflexion

- Évaluer la justesse de la pensée :

- Les auteurs ont utilisé deux modèles basés sur le Llama et le Qwen (DeepSeek-R1-Distill-Llama-70B et DeepSeek-R1-Distill-Qwen-32B) pour évaluer si chaque étape de la réflexion était correcte.

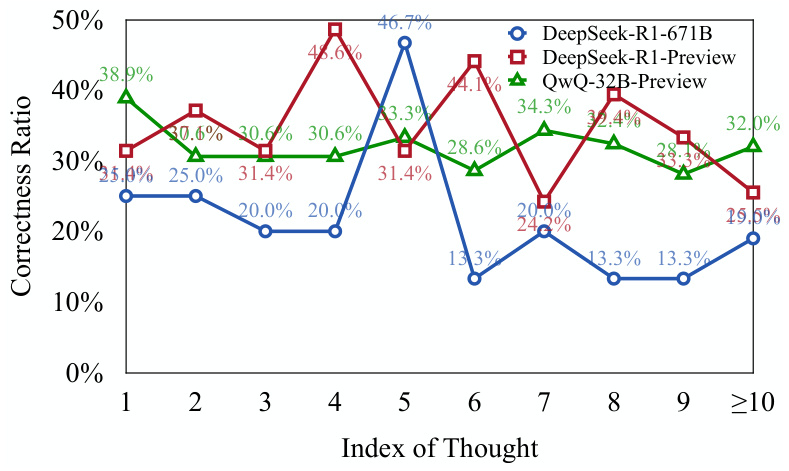

- Les résultats montrent queUne grande partie des premières étapes de la réflexion dans la réponse à l'erreur est correcte mais n'est pas entièrement explorée.(voir figure 5).

- Cela suggère que le modèle, lorsqu'il est confronté à un problème complexeTendance à abandonner prématurément des voies de raisonnement prometteuses, ce qui entraîne un manque de profondeur de la pensée..

- Réfléchissez à la distribution de l'exactitude :

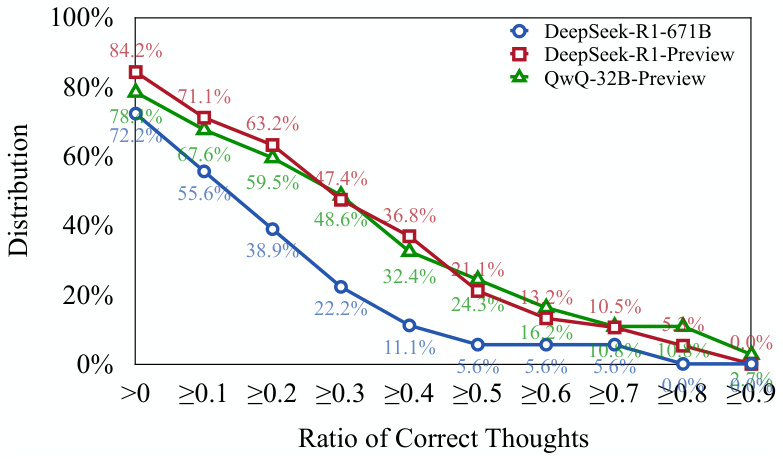

- Les auteurs ont constaté que plus de 701 réponses d'erreur TP3T contenaient au moins une étape de réflexion correcte (voir figure 6).

- Cela confirme le point de vue exprimé ci-dessus :o Les modèles de la classe 1 sont capables d'initier les voies de raisonnement correctes, mais il peut être difficile de poursuivre ces voies jusqu'à la conclusion correcte..

4. quantifier le manque de réflexion : proposer de nouveaux indicateurs d'évaluation

- Réflexion sur les sous-indicateurs (UT) :

- Cette mesure permet de quantifier le degré de sous-réflexion en mesurant l'efficacité du jeton lors de la génération d'une réponse d'erreur.

- Plus précisément, la métrique UT calcule la réponse à l'erreur dans laquelle laNombre d'éléments correctement considérés du début à la fin par rapport au nombre total d'éléments..

- Des valeurs UT plus élevées indiquent des niveaux plus élevés de sous-réflexionc'est-à-dire qu'une plus grande proportion du jeton généré par le modèle en réponse à une erreur ne contribue pas efficacement à générer un raisonnement correct.

5. l'impact de la sous-réflexion sur la performance du modèle :

- Les auteurs ont constaté queLe phénomène de sous-réflexion fonctionne différemment selon les ensembles de données et les tâches: :

- Sur les ensembles de données MATH500-Hard et GPQA Diamond, le modèle DeepSeek-R1-671B, bien que plus précis, avait également une valeur UT plus élevée, ce qui suggère une plus grande sous-réflexion dans sa réponse à l'erreur.

- Sur l'ensemble de test AIME2024, le modèle DeepSeek-R1-671B a non seulement une plus grande précision, mais aussi une valeur UT plus faible, ce qui indique un processus d'inférence plus ciblé et plus efficace.

III. conclusions importantes :

- L'insuffisance de la réflexion est un facteur important de la faible performance des LLM de la catégorie o1 sur les problèmes complexes. Les changements fréquents de mode de pensée se traduisent par des modèles incapables d'explorer en profondeur les voies d'inférence prometteuses, ce qui affecte en fin de compte leur précision.

- Le phénomène de sous-réflexion est lié à la difficulté du problème et à la capacité de modélisation. Les problèmes plus difficiles exacerbent la sous-estimation, et des modèles plus puissants ne réduisent pas toujours la sous-estimation.

- La sous-réflexion est différente de la sur-réflexion. On parle d'overthinking lorsqu'un modèle gaspille des ressources de calcul sur des problèmes simples, et d'underthinking lorsqu'un modèle abandonne prématurément des voies d'inférence prometteuses sur des problèmes complexes.

- L'indicateur de sous-pensée (UT) permet de quantifier efficacement l'ampleur de la sous-pensée. Cette métrique fournit une nouvelle perspective pour évaluer l'efficacité de raisonnement des LLM de la classe o1.

IV. stratégies de réponse :

Pour pallier le problème de l'inadéquation de la réflexion, les auteurs proposent une méthode d'évaluation de la qualité de l'eau.Stratégie de décodage avec think switching penalty (TIP): :

- Idées maîtresses : Pendant le processus de décodage, des pénalités sont appliquées au jeton associé à l'interrupteur de réflexion, auEncourager les modèles à explorer plus profondément la pensée actuelle avant de passer à une nouvelle pensée.

- Résultats : La stratégie TIP améliore la précision du modèle QwQ-32B-Preview sur tous les ensembles de tests, ce qui prouve son efficacité à atténuer le problème de la sous-estimation.

V. Perspectives d'avenir :

Les auteurs suggèrent que les orientations futures de la recherche soient les suivantes :

- Développement de mécanismes adaptatifs pour permettre aux modèles d'autoréguler les commutateurs de pensée.

- Amélioration de l'efficacité de l'inférence des LLM de la classe o1.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Postes connexes

Pas de commentaires...