Xinference : Déploiement et distribution aisés de modèles d'IA distribués

Introduction générale

Xorbits Inference (ou Xinference en abrégé) est une bibliothèque puissante et polyvalente axée sur le déploiement distribué et le service de modèles de langage, de modèles de reconnaissance vocale et de modèles multimodaux. Avec Xorbits Inference, les utilisateurs peuvent facilement déployer et servir leurs propres modèles ou des modèles avancés intégrés avec une seule commande. Que ce soit dans le nuage, sur un serveur local ou sur un ordinateur personnel, Xorbits Inference fonctionne efficacement. La bibliothèque est particulièrement adaptée aux chercheurs, aux développeurs et aux scientifiques des données pour les aider à réaliser le plein potentiel des modèles d'IA de pointe.

Liste des fonctions

- déploiement distribuéLa technologie de l'information est un élément essentiel de la gestion de l'information : elle prend en charge les scénarios de déploiement distribué, ce qui permet de répartir les tâches d'inférence des modèles de manière transparente sur plusieurs appareils ou machines.

- service de modélisationLa rationalisation du processus de distribution de modèles linguistiques, de modèles de reconnaissance vocale et de modèles multimodaux de grande taille.

- Déploiement à commande uniqueLes modèles de service : Déployer et entretenir des modèles avec une seule commande, pour les environnements expérimentaux et de production.

- Utilisation de matériel hétérogène: Intelligence exploite le matériel hétérogène, y compris les GPU et les CPU, pour accélérer les tâches d'inférence des modèles.

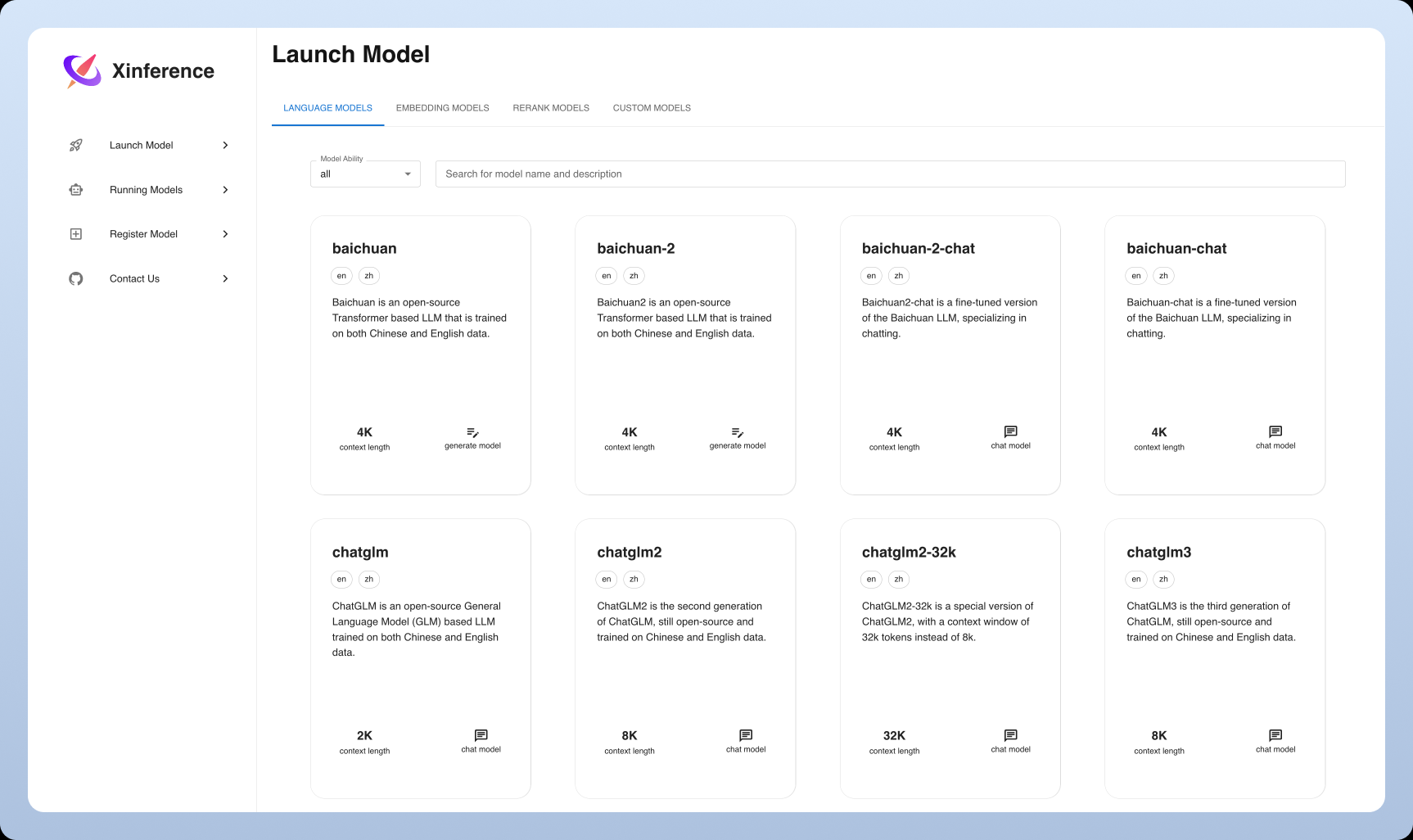

- Des API et des interfaces flexiblesLe modèle est conçu pour être utilisé dans les environnements de travail les plus divers : il fournit une variété d'interfaces pour interagir avec le modèle, supportant RPC, API RESTful (compatible avec l'API OpenAI), CLI et WebUI.

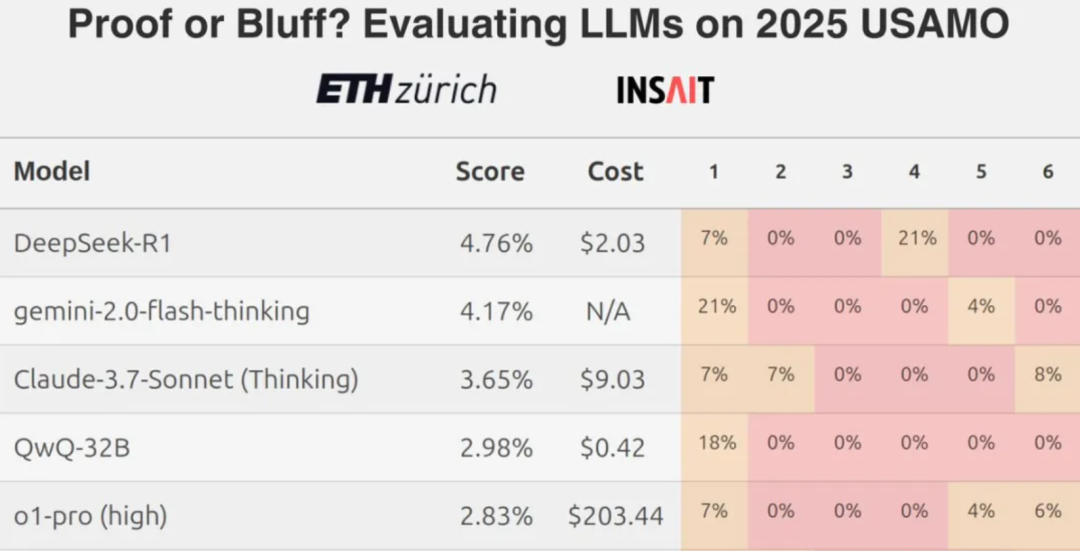

- Modèles avancés intégrésLa prise en charge intégrée d'un large éventail de modèles open-source de pointe, que les utilisateurs peuvent utiliser directement pour leurs expériences.

Utiliser l'aide

Processus d'installation

- Préparation de l'environnementPython : Assurez-vous que Python 3.7 ou une version plus récente est installé.

- Installation de Xorbits Inference: :

pip install xorbits-inference

- Vérifier l'installationUne fois l'installation terminée, vous pouvez vérifier qu'elle s'est bien déroulée en utilisant la commande suivante :

xinference --version

Lignes directrices pour l'utilisation

modèle de déploiement

- Modèles de chargementChargement d'un modèle pré-entraîné : Utilisez la commande suivante pour charger un modèle pré-entraîné :

xinference load-model --model-name <模型名称>

Exemple :

xinference load-model --model-name gpt-3

- Démarrage des servicesAprès avoir chargé le modèle, démarrez le service :

xinference serve --model-name <模型名称>

Exemple :

xinference serve --model-name gpt-3

- Appeler l'APIUne fois le service démarré, il peut être invoqué par le biais d'une API RESTful :

curl -X POST http://localhost:8000/predict -d '{"input": "你好"}'

Utilisation du modèle intégré

Xorbits Inference dispose d'un support intégré pour une large gamme de modèles avancés qui peuvent être utilisés directement par l'utilisateur pour mener des expériences. Exemple :

- modèle linguistique: par exemple GPT-3, BERT, etc.

- modèle de reconnaissance vocale: par exemple DeepSpeech, etc.

- modèle multimodal: par exemple CLIP, etc.

déploiement distribué

Xorbits Inference prend en charge le déploiement distribué, ce qui permet aux utilisateurs de distribuer de manière transparente les tâches d'inférence de modèles sur plusieurs appareils ou machines. Les étapes sont décrites ci-dessous :

- Configuration d'un environnement distribuéInstallation de Xorbits Inference sur chaque nœud et configuration de la connexion réseau.

- Démarrage des services distribuésDémarrer les services distribués sur le nœud maître :

xinference serve --distributed --nodes <节点列表>

Exemple :

xinference serve --distributed --nodes "node1,node2,node3"

- Appeler l'API distribuéeLe déploiement d'un nœud unique : Similaire aux déploiements d'un nœud unique, il est invoqué par l'intermédiaire d'une API RESTful :

curl -X POST http://<主节点IP>:8000/predict -d '{"input": "你好"}'

problèmes courants

- Comment mettre à jour le modèle ? Utilisez la commande suivante pour mettre à jour le modèle :

xinference update-model --model-name <模型名称>

- Comment puis-je consulter les journaux ? Utilisez la commande suivante pour afficher le journal de service :

xinference logs --model-name <模型名称>© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...