gpt prompt engineer : Outil d'ingénierie des invites du modèle de langue | Optimisation des commandes d'invite

Introduction générale

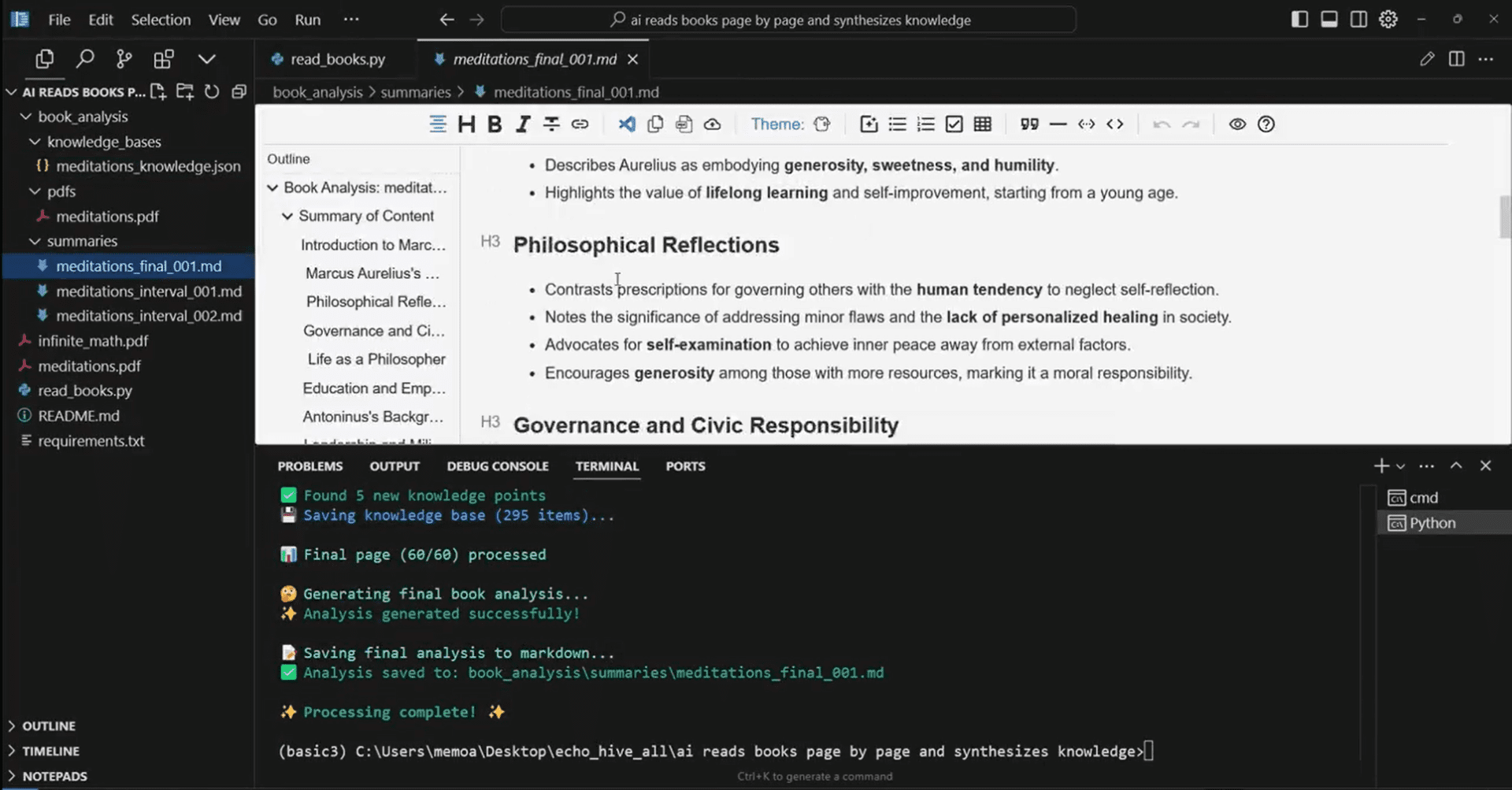

gpt-prompt-engineer est un projet open source sur GitHub qui se concentre sur l'ingénierie des messages-guides pour les modèles GPT. Les utilisateurs peuvent entrer des descriptions de tâches et des cas de test, et cet outil est capable de générer, de tester et de classer différents messages-guides pour trouver le plus performant. Le projet utilise de grands modèles linguistiques tels que GPT-4 et GPT-3.5-Turbo, et utilise un système de notation ELO pour classer l'efficacité des invites générées, avec la possibilité d'enregistrer et de suivre la chaîne d'invites.

L'ingénierie des conseils est un peu comme l'alchimie. Il n'existe pas de méthode claire pour prédire ce qui fonctionnera le mieux. Il s'agit d'expérimenter jusqu'à ce que vous trouviez la bonne pointe. gpt Tip Engineer est un outil qui porte cette expérimentation à un tout autre niveau.

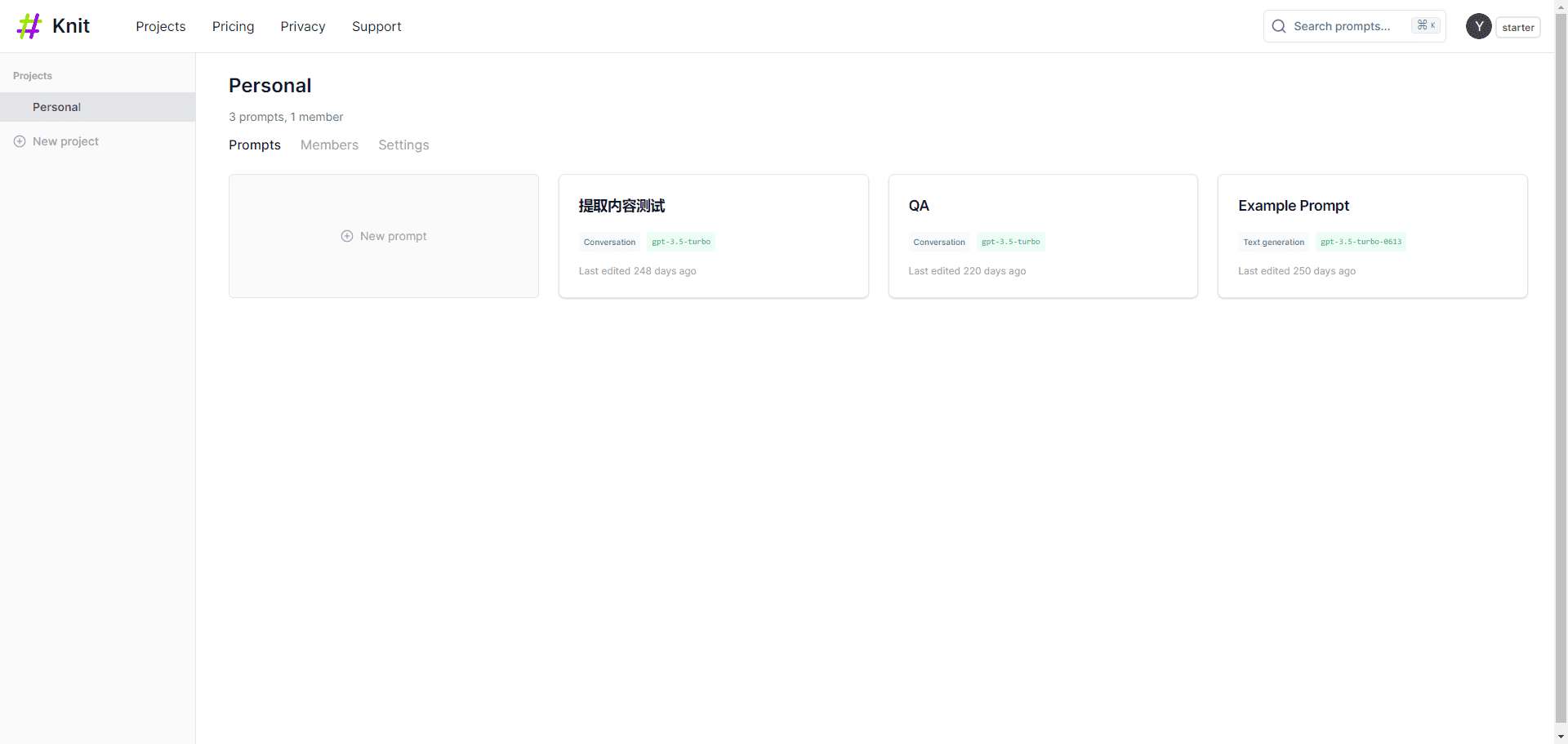

Permet de générer, d'optimiser et de tester les invites, avec prise en charge de GPT et Claude, et d'optimiser le système d'exploitation. Claude Les mots-clés de Claude 3 Haiku permettent d'obtenir d'excellents résultats. Il convient de noter que Claude 3 Haiku est moins cher que GPT-3.5, mais qu'il est performant et prend en charge les modèles visuels.

Liste des fonctions

Génération de conseils : génère une variété de conseils basés sur des cas d'utilisation et des cas de test.

Test de repérage : la performance du repérage est testée et classée à l'aide du système de notation ELO.

Système de notation ELO : ajustement dynamique des notes ELO en comparant les performances de réponse des cas de test.

Version catégorisée : conçue pour les tâches de catégorisation, elle donne des scores de test pour chaque question.

Enregistrement optionnel : permet l'enregistrement des poids et des biais et l'enregistrement de l'outil Portkey.

Utiliser l'aide

Ouvrez le carnet de notes du projet dans Google Colab ou un carnet de notes Jupyter local.

Ajoutez la clé secrète de l'API d'OpenAI au code.

Définir les descriptions de tâches et les cas de test.

Ajustez le modèle et sélectionnez GPT-4 ou GPT-3.5-Turbo selon le cas.

Appelez la fonction generate_optimal_prompt() pour générer, tester et noter les messages-guides.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...