DeepSeek API : application à grande échelle de la technologie de mise en cache des disques durs : une étape clé dans la civilianisation des grands modèles

-- Une discussion sur la logique profonde de la guerre des prix des API des grands modèles, de l'optimisation de l'expérience utilisateur et de l'inclusion technologique.

Image : Documentation officielle de DeepSeek

À l'heure où la concurrence dans le domaine des grands modèles d'IA s'intensifie, DeepSeek a récemment annoncé que son service API utilise de manière innovante la technologie de l'IA.Technologie de cache du disque durL'ajustement de prix de DeepSeek est choquant - le prix de la partie cache hit est directement réduit à un dixième du prix précédent, rafraîchissant une fois de plus la ligne de fond du prix de l'industrie. En tant qu'évaluateur tiers qui s'intéresse depuis longtemps à la technologie des grands modèles et aux tendances de l'industrie, je pense que la décision de DeepSeek n'est pas seulement une révolution des coûts induite par l'innovation technologique, mais aussi une optimisation profonde de l'expérience utilisateur de l'API des grands modèles et une étape importante pour accélérer la généralisation de la technologie des grands modèles.

Innovation technologique : subtilités de la mémoire cache des disques durs et gains de performance

DeepSeek est profondément conscient des coûts élevés et des problèmes de latence qui ont longtemps limité l'adoption généralisée des API de grands modèles, et la duplication contextuelle omniprésente des demandes de l'utilisateur est un facteur clé de ces problèmes. Par exemple, dans les dialogues à plusieurs tours, l'historique du dialogue précédent doit être réintroduit à chaque tour ; dans les tâches de traitement de texte long, Prompt contient souvent des références répétées. Calcul répétitif Jeton Cela gaspille de l'arithmétique et augmente la latence.

Pour résoudre ce problème, DeepSeek introduit de manière créative la technologie de mise en cache contextuelle des disques durs. Le principe de base consiste à mettre intelligemment en cache le contenu contextuel qui devrait être réutilisé à l'avenir, tel que l'historique des dialogues, les préréglages du système, les exemples de plans, etc. Lorsqu'un utilisateur lance une nouvelle requête API, le système détecte automatiquement si la partie préfixe de l'entrée correspond au contenu mis en cache (remarque : le préfixe doit être identique pour atteindre le cache). Si c'est le cas, le système lit le duplicata directement à partir du cache du disque dur à grande vitesse sans recalculer, ce qui optimise à la fois la latence et le coût.

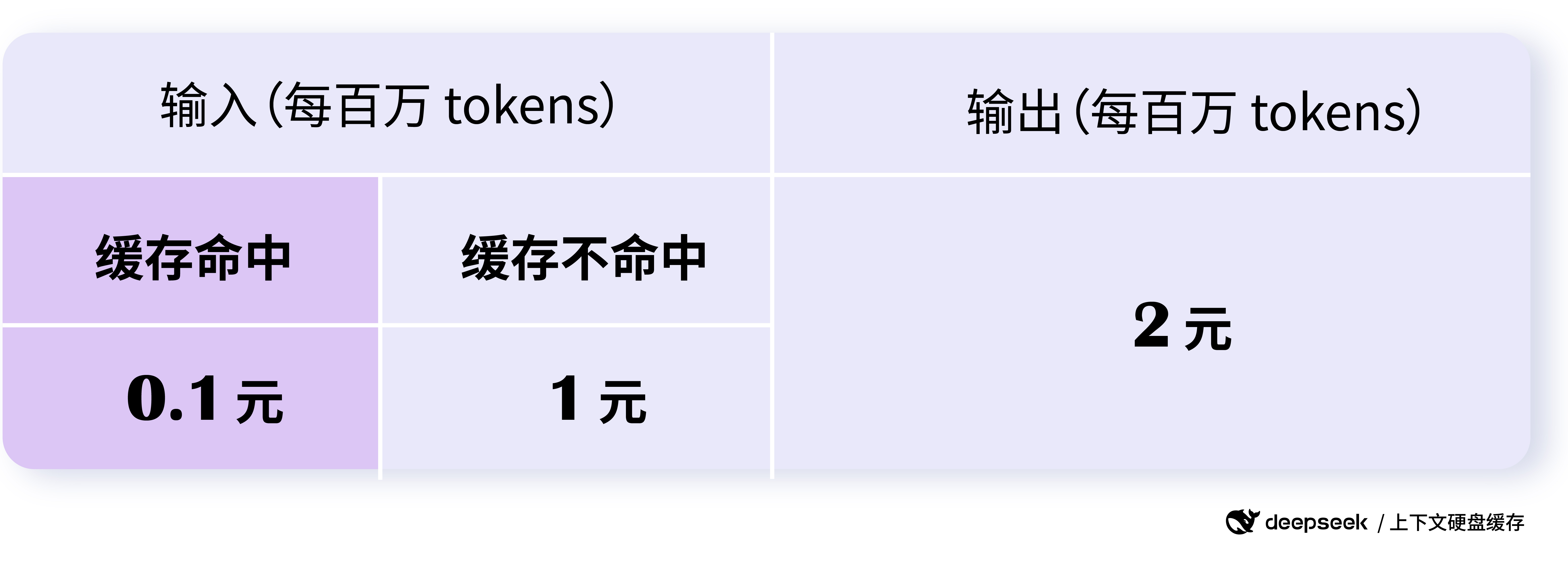

Pour mieux comprendre le fonctionnement de la mise en cache, examinons quelques exemples d'opérations de mise en cache. DeepSeek Exemple officiel fourni :

Exemple 1 : Scénario de dialogue à plusieurs tours

Fonctionnalité principale : les cycles de dialogue suivants utilisent automatiquement le cache contextuel du cycle précédent.

Dans les dialogues à plusieurs tours, où les utilisateurs posent généralement des questions successives sur un même sujet, la mise en cache du disque dur de DeepSeek peut réutiliser efficacement le contexte du dialogue. Par exemple, dans le scénario de dialogue suivant :

Première demande :

messages: [

{"role": "system", "content": "你是一位乐于助人的助手"},

{"role": "user", "content": "中国的首都是哪里?"}

]

Deuxième demande :

messages: [

{"role": "system", "content": "你是一位乐于助人的助手"},

{"role": "user", "content": "中国的首都是哪里?"},

{"role": "assistant", "content": "中国的首都是北京。"},

{"role": "user", "content": "美国的首都是哪里?"}

]

Image : Documentation officielle de DeepSeek

Exemple d'atteinte au cache dans un scénario de dialogue à plusieurs tours : les tours de dialogue suivants atteignent automatiquement le cache contextuel du tour précédent.

Lors de la deuxième demande, étant donné que la partie préfixe (message du système + premier message de l'utilisateur) est exactement la même que lors de la première demande, cette partie sera prise en compte par le cache sans qu'il soit nécessaire de répéter le calcul, ce qui réduit la latence et le coût.

Selon les données officielles de DeepSeek, pour des scénarios extrêmes avec 128 000 entrées et la plupart des répétitions, la latence mesurée du premier jeton a chuté de 13 secondes à 500 millisecondes, ce qui représente une amélioration étonnante des performances. Même dans des scénarios non extrêmes, il est possible de réduire efficacement la latence et d'améliorer l'expérience de l'utilisateur.

De plus, le service de mise en cache des disques durs de DeepSeek est entièrement automatisé et indépendant de l'utilisateur. Vous pouvez profiter des avantages de performance et de prix de la mise en cache sans avoir à modifier le code ou l'interface API. La nouvelle invite_cache_hit_tokens (cache hits) dans le champ d'utilisation renvoyé par l'API permet aux utilisateurs de voir le nombre d'accès au cache qu'ils ont reçu. jetons (nombre de jetons) et prompt_cache_miss_tokens (nombre de jetons manqués) pour surveiller les hits du cache en temps réel afin de mieux évaluer et optimiser les performances du cache.

La structure MLA (Multi-head Latent Attention) proposée par DeepSeek V2 comprime considérablement la taille du contexte KV Cache tout en garantissant les performances du modèle, ce qui permet de stocker le KV Cache sur un disque dur peu coûteux, jetant ainsi les bases de l'implantation de la technologie de mise en cache sur disque dur sur le marché. Il est ainsi possible de stocker le KV Cache sur un disque dur peu coûteux, ce qui jette les bases de la technologie de mise en cache sur disque dur.

compréhensions Profondeur de l'eau-R1 Hit API Cache vs. prix :Utilisation de l'API DeepSeek-R1 Questions fréquemment posées

Scénarios d'application : des questions-réponses sur des textes longs à l'analyse de codes, les limites sont infinies !

Les scénarios d'application de la technologie de mise en cache des disques durs sont très vastes, et presque toutes les applications modèles de grande taille impliquant des données contextuelles peuvent en bénéficier. L'article original énumère les scénarios typiques suivants et fournit des exemples plus spécifiques :

- Un assistant de quiz avec des mots-clés longs et prédéfinis :

- Fonctionnalité principale : les invites fixes du système peuvent être mises en cache, ce qui réduit le coût par requête.

- Exemple :

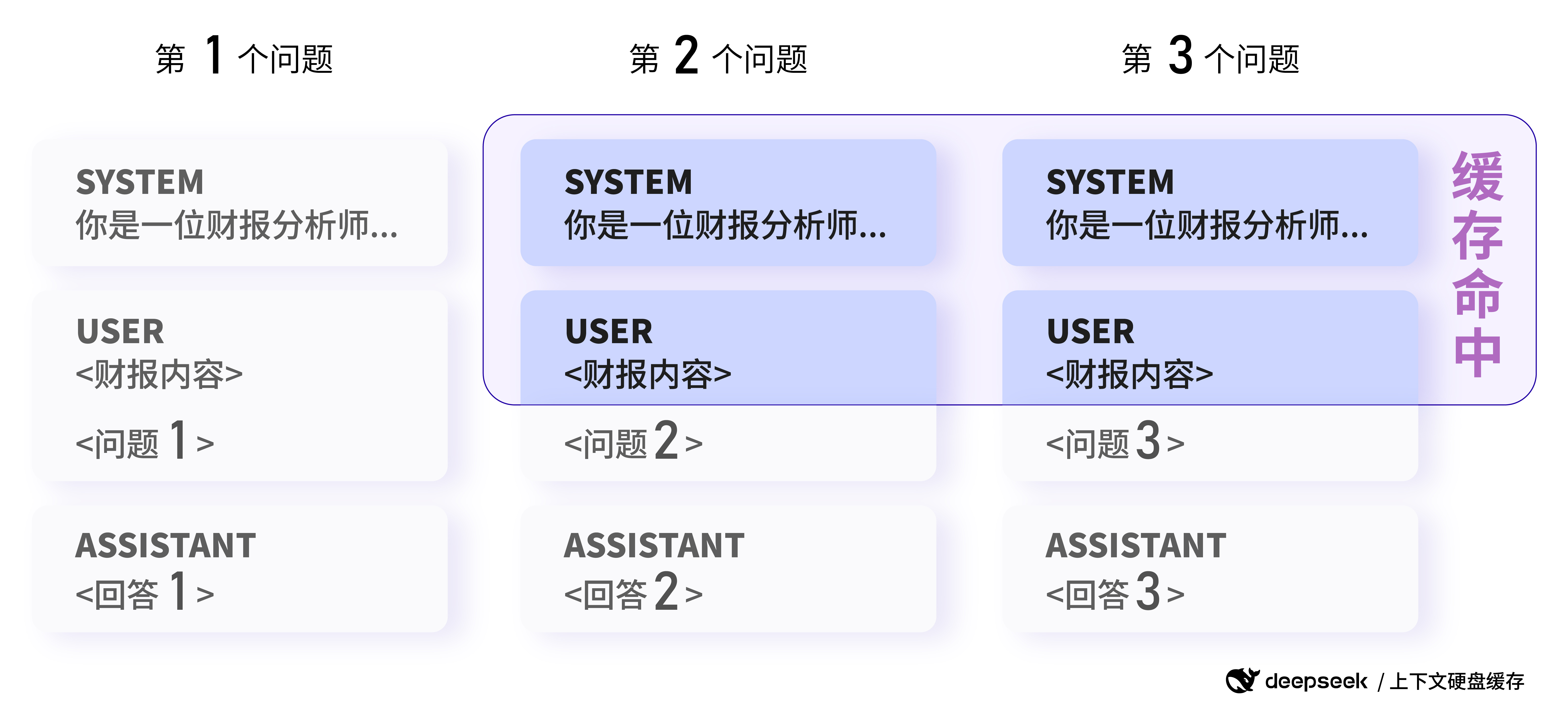

Exemple 2 : Scénario de questions-réponses sur un texte long

Fonctionnalité principale : plusieurs analyses d'un même document peuvent se retrouver dans le cache.

Les utilisateurs doivent analyser le même rapport de résultats et poser des questions différentes :

Première demande :

messages: [

{"role": "system", "content": "你是一位资深的财报分析师..."},

{"role": "user", "content": "<财报内容>\n\n请总结一下这份财报的关键信息。"}

]

Deuxième demande :

messages: [

{"role": "system", "content": "你是一位资深的财报分析师..."},

{"role": "user", "content": "<财报内容>\n\n请分析一下这份财报的盈利情况。"}

]

Dans la deuxième demande, étant donné que la partie du message du système et du message de l'utilisateur a le même préfixe que la première demande, cette partie peut être récupérée par le cache afin d'économiser des ressources informatiques.

- Applications de jeu de rôle avec plusieurs tours de dialogue :

- Caractéristiques principales : forte réutilisation de l'historique des dialogues et mise en cache importante.

- (L'exemple 1 a été présenté en détail)

- Analyse de données pour les collections de textes fixes :

- Caractéristiques principales : plusieurs analyses et quiz sur le même document avec une répétition élevée des préfixes.

- Par exemple, plusieurs analyses et séances de questions-réponses sur le même rapport financier ou document juridique. (L'exemple 2 a été présenté en détail)

- Outils d'analyse du code et de dépannage au niveau du référentiel de code :

- Fonctionnalité principale : Les tâches d'analyse de code impliquent souvent une grande quantité de contexte, et la mise en cache peut être efficace pour réduire les coûts.

- Apprentissage à quelques coups :

- Fonctionnalité principale : les exemples de peu de choses préfixés par Prompt peuvent être mis en cache, ce qui réduit le coût des appels multiples de peu de choses.

- Exemple :

Exemple 3 : Scénario d'apprentissage à quelques coups

Fonctionnalité principale : le même exemple Few-shot peut être mis en cache en tant que préfixe.

Les utilisateurs ont recours à l'apprentissage Few-shot pour améliorer l'efficacité du modèle dans le cadre de l'interrogation sur les connaissances historiques :

Première demande :

messages: [

{"role": "system", "content": "你是一位历史学专家,用户将提供一系列问题,你的回答应当简明扼要,并以`Answer:`开头"},

{"role": "user", "content": "请问秦始皇统一六国是在哪一年?"},

{"role": "assistant", "content": "Answer:公元前221年"},

{"role": "user", "content": "请问汉朝的建立者是谁?"},

{"role": "assistant", "content": "Answer:刘邦"},

{"role": "user", "content": "请问唐朝最后一任皇帝是谁"},

{"role": "assistant", "content": "Answer:李柷"},

{"role": "user", "content": "请问明朝的开国皇帝是谁?"},

{"role": "assistant", "content": "Answer:朱元璋"},

{"role": "user", "content": "请问清朝的开国皇帝是谁?"}

]

Deuxième demande :

messages: [

{"role": "system", "content": "你是一位历史学专家,用户将提供一系列问题,你的回答应当简明扼要,并以`Answer:`开头"},

{"role": "user", "content": "请问秦始皇统一六国是在哪一年?"},

{"role": "assistant", "content": "Answer:公元前221年"},

{"role": "user", "content": "请问汉朝的建立者是谁?"},

{"role": "assistant", "content": "Answer:刘邦"},

{"role": "user", "content": "请问唐朝最后一任皇帝是谁"},

{"role": "assistant", "content": "Answer:李柷"},

{"role": "user", "content": "请问明朝的开国皇帝是谁?"},

{"role": "assistant", "content": "Answer:朱元璋"},

{"role": "user", "content": "请问商朝是什么时候灭亡的"},

]

Pour la deuxième requête, comme le même exemple à quatre clichés est utilisé comme préfixe, cette partie peut être atteinte par le cache et seule la dernière question doit être recalculée, ce qui réduit considérablement le coût de l'apprentissage Few-shot.

Image : Documentation officielle de DeepSeek

Exemple d'une réponse positive du cache dans un scénario d'analyse de données : des demandes avec le même préfixe peuvent atteindre le cache (note : l'image ici suit l'exemple original d'analyse de données et se concentre davantage sur le concept de duplication de préfixe ; le scénario de l'exemple Few-shot peut être compris de la même manière).

Ces scénarios ne sont que la partie émergée de l'iceberg. L'application de la technologie de mise en cache des disques durs ouvre réellement la voie à l'imagination pour l'application d'API de grands modèles à contexte long. Par exemple, nous pouvons créer des outils de rédaction de textes longs plus puissants, traiter des tâches plus complexes à forte intensité de connaissances et développer des applications d'IA conversationnelle plus profondes et mémorables.

Référence : Inspiré par Claude

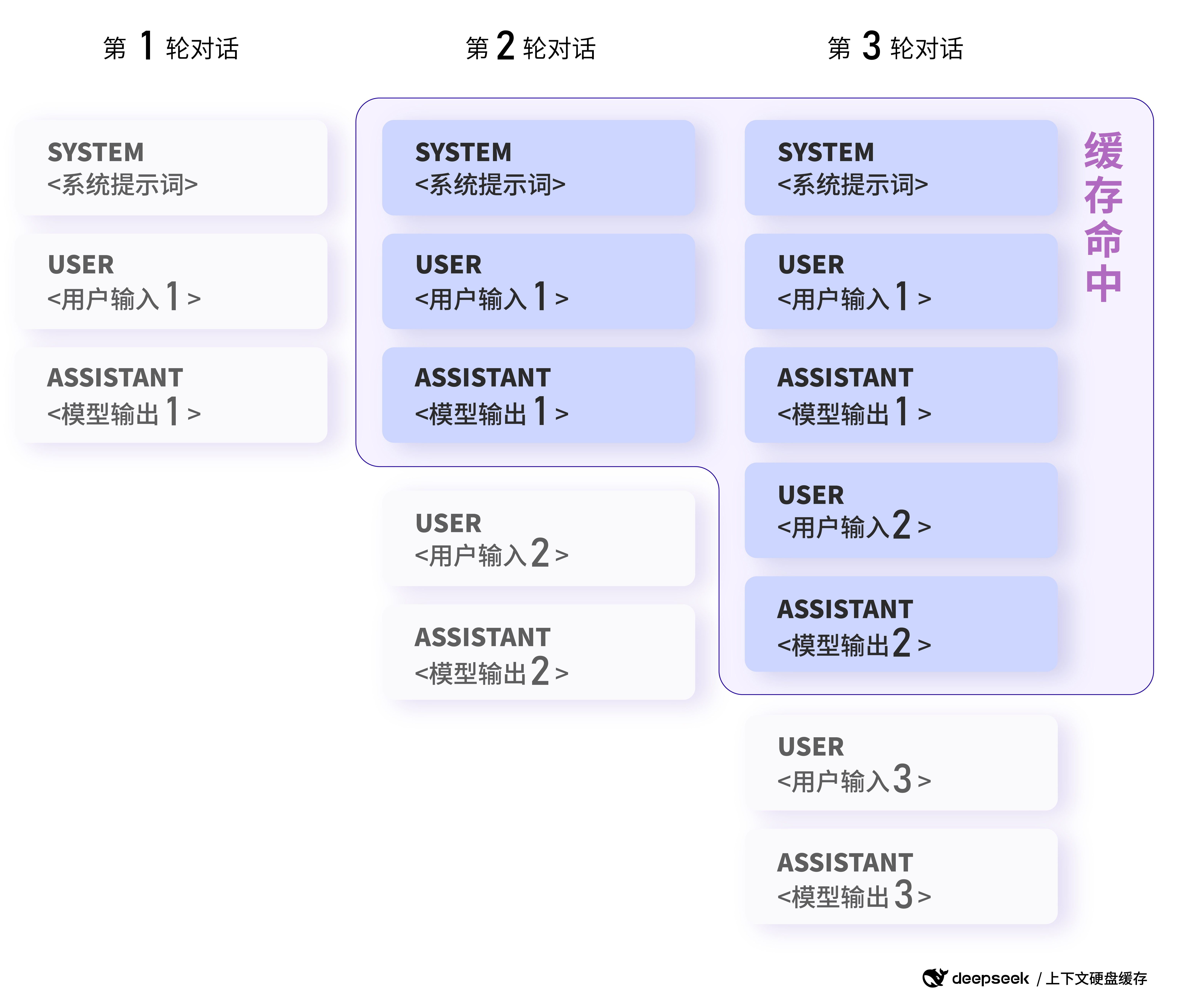

Avantage en termes de coûts : les prix baissent de plusieurs ordres de grandeur au profit de l'écologie du grand modèle.

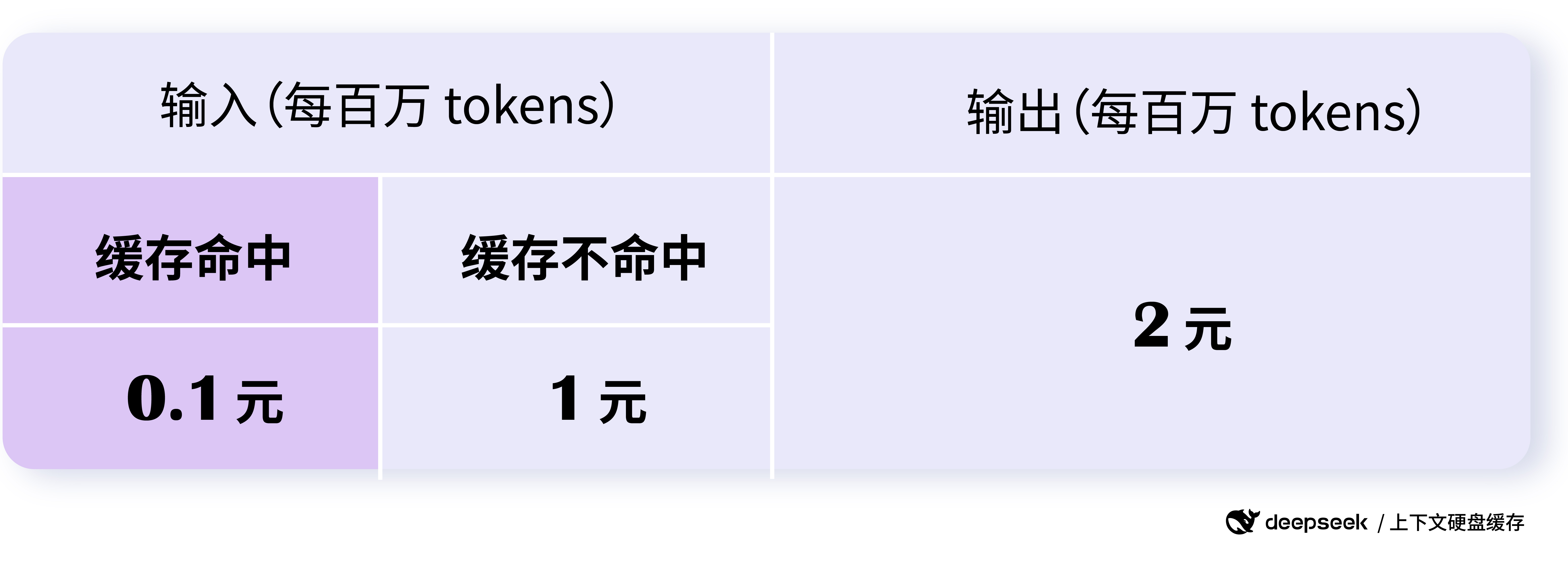

L'ajustement du prix de l'API DeepSeek est "épique", avec la partie cache hit de l'API au prix de 0,10 $/million de tokens et la partie hit au prix de 1 $/million de tokens. Le prix d'un cache hit n'est que de 0,1 $ par million de tokens, et le prix d'un miss n'est que de 1 $ par million de tokens, ce qui est un ordre de grandeur inférieur au prix précédent d'un cache hit.

Selon les données officielles de DeepSeek, il permet d'économiser jusqu'à 90%, et même sans aucune optimisation, les utilisateurs peuvent économiser plus de 50% au total. Cet avantage en termes de coûts est très important pour abaisser le seuil d'application des grands modèles et accélérer la popularité de ces derniers.

Ce qui est plus intéressant, c'est la stratégie de tarification de DeepSeek. La tarification des occurrences et des absences du cache est échelonnée afin d'encourager les utilisateurs à utiliser le cache autant que possible, d'optimiser la conception de l'invite et d'augmenter le taux d'occurrences du cache, ce qui permet de réduire davantage les coûts. Dans le même temps, ni le service de cache lui-même ni l'espace de stockage du cache ne font l'objet de frais supplémentaires, ce qui est vraiment convivial.

Image : Documentation officielle de DeepSeek

Le prix de l'API DeepSeek a été considérablement réduit, les accès au cache ne coûtant que 0,1 dollar par million de jetons.

L'importante réduction de prix de DeepSeek API accélérera sans aucun doute l'évolution de la guerre des prix des grands modèles. Cependant, à la différence de la simple concurrence des prix, la réduction de prix de DeepSeek est une réduction de prix rationnelle basée sur l'innovation technologique et l'optimisation des coûts, qui est plus durable et orientée vers l'industrie. Cette saine concurrence sur les prix profitera en fin de compte à l'ensemble de l'écosystème des grands modèles, de sorte qu'un plus grand nombre de développeurs et d'entreprises pourront bénéficier d'une technologie de pointe pour les grands modèles à un coût moindre.

Flux et concurrence illimités, services de mise en cache sécurisés et fiables

Le service DeepSeek API est conçu en fonction d'une capacité de 1 000 milliards de jetons par jour, avec un flux et une concurrence illimités pour tous les utilisateurs, ce qui garantit la qualité du service dans des conditions de charge élevée.

DeepSeek a également accordé toute son attention à la sécurité des données. Le cache de chaque utilisateur est séparé et logiquement isolé des autres, ce qui garantit la sécurité et la confidentialité des données de l'utilisateur. Les caches qui n'ont pas été utilisés pendant une longue période seront automatiquement vidés (généralement quelques heures à quelques jours) et ne seront pas conservés pendant une longue période ou utilisés à d'autres fins, ce qui réduit encore les risques potentiels pour la sécurité.

Il convient de noter que le système de cache utilise 64 jetons comme unité de stockage et que tout ce qui est inférieur à 64 jetons ne sera pas mis en cache. De plus, le système de cache est "best effort" et ne garantit pas 100%. En outre, la construction du cache prend quelques secondes, mais pour les scénarios à long terme, c'est tout à fait acceptable.

Amélioration du modèle et perspectives d'avenir

Il convient de mentionner que, parallèlement au lancement de la technologie de mise en cache du disque dur, DeepSeek a également annoncé que le modèle deepseek-chat a été mis à niveau pour devenir DeepSeek-V3, et que le modèle deepseek-reasoner est devenu le nouveau modèle DeepSeek-R1. la compétitivité de l'API DeepSeek.

Selon les informations officielles sur les prix, DeepSeek-V3 API (deepseek-chat) bénéficie d'un prix réduit jusqu'au 8 février 2025 à 24 heures, avec un prix de seulement 0,1 $/million de tokens pour les hits mis en cache, 1 $/million de tokens pour les entrées manquées et 2 $/million de tokens pour les sorties. DeepSeek-R1 API (deepseek-reasoner) est positionné comme un modèle d'inférence avec une longueur de chaîne de pensée de 32K et une longueur de sortie maximale de 8K, avec un prix d'entrée (hits mis en cache) de 1 $/million de tokens. L'API DeepSeek-R1 (deepseek-reasoner) se présente comme un modèle d'inférence avec une longueur de chaîne de pensée de 32 000 et une longueur de sortie maximale de 8 000, avec un prix d'entrée de 1 $/million de jetons pour les résultats mis en cache, de 4 $/million de jetons pour les entrées manquées et de 16 $/million de jetons pour les sorties (tous les jetons de la chaîne de pensée et de la réponse finale). et tous les jetons de la réponse finale).

La série d'initiatives innovantes de DeepSeek témoigne de son investissement continu dans la technologie et de sa philosophie de priorité à l'utilisateur. Nous avons toutes les raisons de croire qu'avec DeepSeek et d'autres forces innovantes, la technologie des grands modèles accélérera sa maturité, deviendra plus inclusive et apportera des changements plus profonds à toutes les industries.

remarques finales

L'utilisation innovante de la technologie de mise en cache sur disque dur par l'API DeepSeek et la réduction significative de son prix constituent une avancée décisive. L'étape franchie par DeepSeek pourrait redéfinir le modèle de concurrence des API de grands modèles, accélérer la popularité et l'application de la technologie de l'IA et, en fin de compte, construire un écosystème de grands modèles plus prospère, plus ouvert et plus inclusif.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Postes connexes

Pas de commentaires...