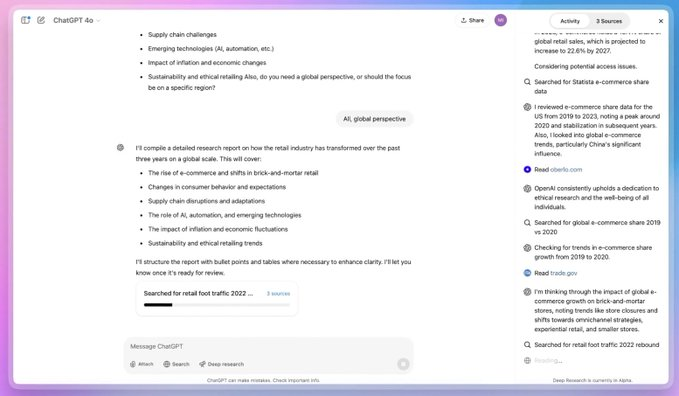

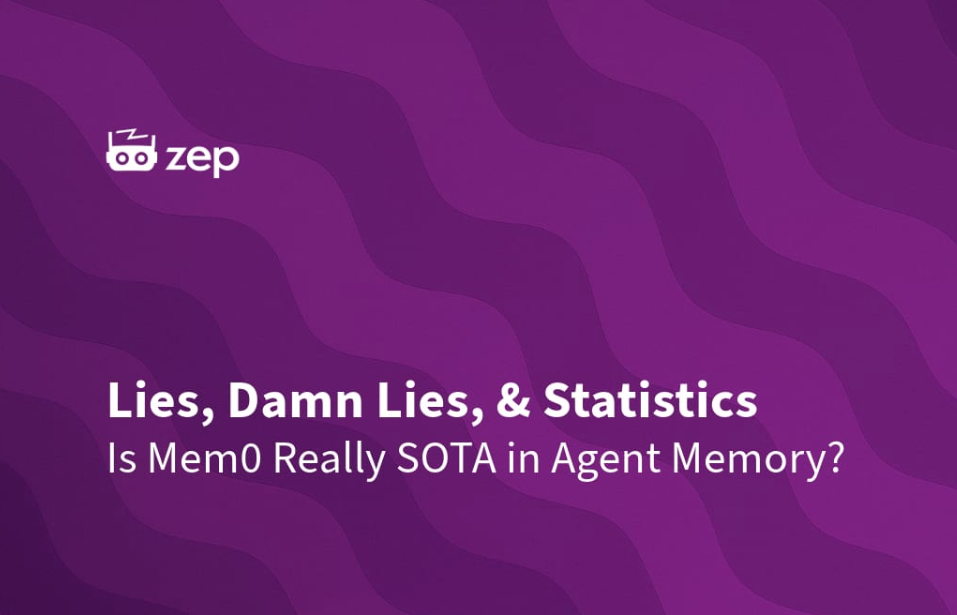

Débat sur les performances de la mémoire de l'intelligence artificielle : les références de Zep Mem0 remises en question

Une annonce récente dans le domaine de la mémoire corporelle intelligente de l'IA a suscité beaucoup d'intérêt dans l'industrie.La société Mem0 publie des rapports de rechercheL'entreprise affirme que ses produits atteignent les niveaux les plus élevés de l'industrie (SOTA) en matière de technologie AI Smart Body Memory et qu'ils sont plus performants que d'autres dans des domaines de référence spécifiques, dont les suivants Zep Cette affirmation a toutefois été rapidement contestée par l'équipe de Zep. Cependant, cette affirmation a été rapidement contestée par l'équipe de Zep, qui a noté que, lorsqu'il était correctement mis en œuvre, son produit surpassait en fait le benchmark LoCoMo sélectionné par Mem0 d'environ 241TP3 T. Cette différence significative a suscité un examen plus approfondi de l'équité du benchmark, de la rigueur de la conception expérimentale et de la fiabilité des conclusions finales.

Dans le domaine hautement compétitif de l'intelligence artificielle, l'obtention de la désignation SOTA (State-of-the-Art) revêt une grande importance pour toute entreprise. Elle est non seulement synonyme de leadership technologique, mais elle attire également les investissements, les talents et l'attention du marché. C'est pourquoi toute déclaration concernant la SOTA, en particulier les conclusions tirées de l'analyse comparative, doit être examinée de près.

Affirmation de Zep : les résultats des tests LoCoMo sont inversés si la mise en œuvre est correcte

Dans sa réponse, l'équipe de Zep a indiqué que lorsque l'expérience LoCoMo était configurée conformément aux meilleures pratiques de son produit, les résultats étaient très différents de ceux du rapport Mem0.

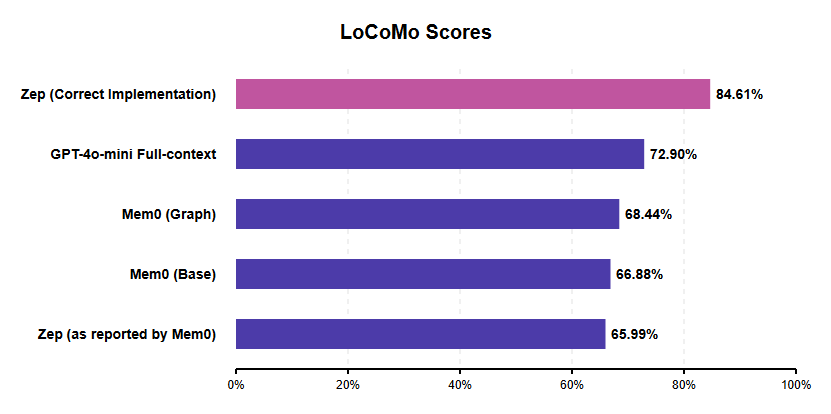

Tous les scores sont tirés des rapports Mem0, à l'exception de "Zep (Correct)" dont il est question ici.

Selon l'évaluation publiée par Zep, la note J de son produit a atteint 84.61%Par rapport à la configuration optimale Mem0 (graphique Mem0) d'environ 68,41 TP3T, elle permet d'atteindre environ 23.6% de gains de performance relatifs. Ce résultat contraste avec le score de 65,99% obtenu par Zep dans l'article de Mem0, qui, selon Zep, est probablement le résultat direct d'une erreur de mise en œuvre, comme nous le verrons plus loin.

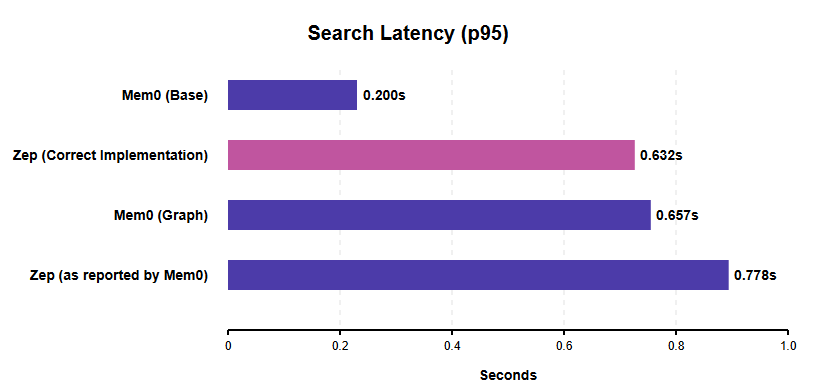

En termes de **latence de recherche (latence de recherche p95)**, Zep note que lorsque son système est correctement configuré pour des recherches simultanées, la latence de recherche p95 est de 0,632 seconde. C'est mieux que les 0,778 secondes indiquées par Zep dans le rapport Mem0 (dont Zep suppose qu'elles sont gonflées par son implémentation de la recherche séquentielle), et légèrement plus rapide que la latence de la recherche de graphes de Mem0 (0,657 secondes).

Tous les scores sont tirés des rapports Mem0, à l'exception de "Zep (Correct)" dont il est question ici.

Il convient de noter que la configuration de base de Mem0 (Mem0 Base) présente une latence de recherche plus faible (0,200 seconde). Cependant, il ne s'agit pas d'une comparaison entièrement équivalente, car Mem0 Base utilise un stockage/cache vectoriel plus simple qui n'a pas les capacités relationnelles d'une base de données de graphes, et il a également le score de précision le plus bas des variantes de Mem0. Les recherches concurrentes efficaces de Zep démontrent de solides performances pour les intelligences IA de niveau de production qui nécessitent des structures de mémoire plus complexes et recherchent la réactivité. Zep explique que ses données de latence ont été mesurées dans un environnement AWS us-west-2 avec une configuration NAT pour la transmission.

Les limites de l'analyse comparative de LoCoMo soulèvent des questions

La décision de Mem0 de choisir LoCoMo comme référence pour sa recherche a elle-même été examinée par Zep, qui a identifié un certain nombre de défauts fondamentaux dans la référence, tant au niveau de la conception que de l'exécution. La conception et l'exécution d'un test de référence complet et impartial est une tâche difficile en soi, qui nécessite une expertise approfondie, des ressources adéquates et une compréhension approfondie des mécanismes internes du système testé.

Les principaux problèmes de LoCoMo identifiés par l'équipe de Zep sont les suivants :

- Longueur et complexité insuffisantes des dialoguesLa durée moyenne d'un dialogue dans LoCoMo est comprise entre 16 000 et 26 000. Jetons Entre. Bien que cette durée puisse sembler longue, elle correspond généralement aux capacités de la fenêtre contextuelle des gestionnaires de l'apprentissage tout au long de la vie modernes. Cette durée ne permet pas d'exercer une réelle pression sur les capacités de récupération de la mémoire à long terme. Pour preuve, les propres résultats de Mem0 montrent que son système n'est même pas aussi performant qu'une simple "ligne de base à contexte complet" (c.-à-d., où le dialogue entier est introduit directement dans le LLM). Le score J pour la ligne de base du contexte complet est d'environ 731 TP3T, alors que le meilleur score de Mem0 est d'environ 681 TP3T. Si le simple fait de fournir tout le texte donne de meilleurs résultats qu'un système de mémoire professionnel, alors le benchmark ne parvient pas à examiner de manière adéquate les rigueurs de la capacité de mémoire dans les interactions IA-intelligence du monde réel.

- Absence de test des fonctions critiques de la mémoireL'évaluation comparative ne tient pas compte du problème de "mise à jour des connaissances" qu'elle a été conçue pour tester. La mise à jour de la mémoire lorsque les informations changent au fil du temps (par exemple, lorsqu'un utilisateur change d'emploi) est une caractéristique essentielle de la mémoire de l'IA.

- Problèmes de qualité des donnéesLa base de données elle-même souffre de plusieurs défauts de qualité :

- Catégorie d'indisponibilitéLa catégorie 5 n'a pas pu être utilisée en raison de l'absence de réponse standardisée, ce qui a contraint Mem0 et Zep à exclure cette catégorie de leurs évaluations.

- erreur multimodaleCertaines questions portaient sur les images, mais les informations nécessaires n'apparaissaient pas dans les descriptions d'images générées par le modèle BLIP au cours du processus de création de l'ensemble de données.

- Mauvaise attribution des orateursCertaines questions attribuent à tort des comportements ou des déclarations au mauvais interlocuteur.

- Manque de clarté dans la définition du problèmeCertaines questions sont ambiguës et peuvent comporter plus d'une réponse potentiellement correcte (par exemple, demander à quelqu'un quand il va camper alors que cette personne peut y être allée en juillet et en août).

Compte tenu de ces erreurs et de ces incohérences, la fiabilité de LoCoMo en tant que mesure faisant autorité des performances de mémoire des intelligences artificielles est discutable. Malheureusement, LoCoMo n'est pas un cas isolé. D'autres critères, tels que HotPotQA, ont été critiqués pour l'utilisation de données d'entraînement LLM (par exemple Wikipedia), la simplification excessive des questions et les erreurs factuelles. Cela met en évidence le défi permanent que représente la réalisation d'analyses comparatives robustes dans le domaine de l'IA.

Mem0 Critique de la méthodologie d'évaluation de Zep

Outre la controverse entourant le test LoCoMo lui-même, la comparaison de Zep dans le document Mem0 est, selon Zep, basée sur une mise en œuvre défectueuse et ne reflète donc pas avec précision les véritables capacités de Zep :

- Mauvais modèle d'utilisateurMem0 utilise une structure de graphe d'utilisateur conçue pour une interaction unique entre l'utilisateur et l'assistant, mais attribue des rôles d'utilisateur aux éléments du dialogue.les deux parties concernéesLes participants. Cela risque de perturber la logique interne de Zep, qui considère le dialogue comme un utilisateur unique changeant constamment d'identité d'un message à l'autre.

- Traitement inapproprié de l'horodatageLes horodatages sont transmis en les ajoutant à la fin du message, plutôt qu'en utilisant le champ created_at spécifique à Zep. Cette approche non standard interfère avec les capacités d'inférence temporelle de Zep.

- Recherche séquentielle et recherche parallèleLa recherche est exécutée de manière séquentielle et non en parallèle, ce qui augmente artificiellement le temps de latence de la recherche de Zep tel qu'il est indiqué par Mem0.

Zep affirme que ces erreurs de mise en œuvre ont fondamentalement mal interprété la manière dont Zep était conçu pour fonctionner et ont inévitablement conduit aux mauvaises performances signalées dans le document Mem0.

L'industrie demande une meilleure évaluation comparative : pourquoi Zep préfère LongMemEval

La controverse suscitée par LoCoMo a renforcé la nécessité pour le secteur de disposer d'analyses comparatives plus solides et plus pertinentes. L'équipe de Zep a exprimé sa préférence pour des analyses comparatives telles que le LongMemEval Un tel critère d'évaluation, car il compense les lacunes de LoCoMo à plusieurs égards :

- Longueur et défi: contient des dialogues beaucoup plus longs (115k tokens en moyenne) qui testent réellement les limites contextuelles.

- Raisonnement temporel et changement d'étatL'évaluation de l'aptitude à l'emploi : teste explicitement la compréhension du temps et la capacité à faire face aux changements d'information (mise à jour des connaissances).

- masse (en physique)Les produits sont conçus et dessinés à la main dans le but de garantir une qualité élevée.

- Pertinence de l'entrepriseLes applications d'entreprise : plus représentatives de la complexité et des exigences des applications d'entreprise du monde réel.

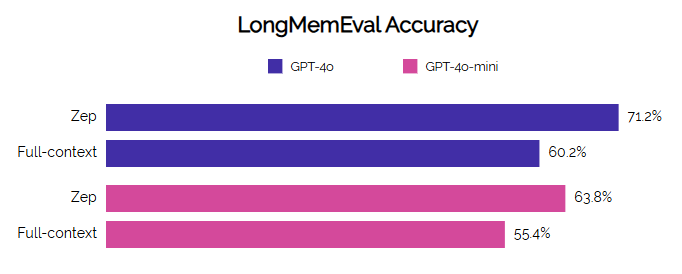

Zep aurait démontré de solides performances sur LongMemEval, avec des améliorations significatives en termes de précision et de temps de latence par rapport à la base, en particulier sur des tâches complexes telles que la synthèse multi-session et l'inférence temporelle.

L'étalonnage est un exercice complexe, et l'évaluation des produits concurrents exige encore plus de diligence et d'expertise pour garantir que les comparaisons sont justes et précises. Il ressort de la réfutation détaillée présentée par Zep que les performances SOTA revendiquées par Mem0 sont basées sur une référence erronée (LoCoMo) et une mise en œuvre défectueuse du système d'un concurrent (Zep).

Lorsqu'il est correctement évalué dans le cadre du même benchmark, Zep surpasse significativement Mem0 en termes de précision et se montre très compétitif en termes de latence de recherche, en particulier lorsqu'il s'agit de comparer des implémentations basées sur des graphes. Cette différence souligne l'importance cruciale d'une conception expérimentale rigoureuse et d'une compréhension approfondie du système évalué afin de tirer des conclusions crédibles.

À l'avenir, le domaine de l'IA a désespérément besoin d'analyses comparatives plus représentatives et de meilleure qualité. Les observateurs du secteur encouragent également les équipes de Mem0 à évaluer leurs produits sur des critères plus difficiles et plus pertinents tels que LongMemEval, où Zep a déjà publié ses résultats, afin d'effectuer des comparaisons plus significatives des capacités de mémoire à long terme des intelligences artificielles. Il ne s'agit pas seulement de la réputation des produits individuels, mais de la bonne direction du progrès technologique pour l'industrie dans son ensemble.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...