Bilan de la semaine : le début de l'année 2024 est une semaine assez choquante pour les débuts de l'IA

Voici une information qui n'avait pas été mentionnée auparavant : cette semaine, Nvidia a dépassé Amazon et Alphabet, la société mère de Google, pour devenir la troisième entreprise la plus valorisée au monde, avec une capitalisation boursière stupéfiante de 1,83 billion de dollars. Petite anecdote : la dernière fois que Nvidia a dépassé Amazon en termes de capitalisation boursière, c'était en 2002. 🤯 Quelle montée en puissance choquante de l'IA !

Examinons maintenant quelques-uns des principaux acteurs de ce secteur.

OpenAI révolutionne le monde de la production vidéo

Il y a un peu moins d'un an, la technologie des vidéos générées par l'IA à partir de texte était exceptionnellement mauvaise (vous vous souvenez de la vidéo de Will Smith ?). . Mais hier, OpenAI a publié Sora, son premier modèle de génération vidéo, et en une seule journée, il a bouleversé la perception qu'avait le public de la vidéo générée par l'IA.

En bref : Sora est un modèle d'IA capable de produire jusqu'à 60 secondes de vidéo à partir d'indices textuels, et c'est un modèle de diffusion qui s'appuie sur les recherches antérieures d'OpenAI sur les modèles DALL-E et GPT.

La particularité de Sora est qu'il crée des scènes extrêmement réalistes et de haute qualité avec une durée de vidéo plus de dix fois supérieure à celle des générateurs vidéo existants. Il est capable de prendre en compte avec précision toutes sortes de détails et de comprendre comment ils existent dans le monde réel.

Mais ce n'est pas tout : il peut également générer des images (attention à Midjourney), générer des vidéos basées sur des images, éditer des vidéos avec des invites textuelles, fusionner deux vidéos et même créer des boucles infinies.

Quelles sont les lacunes ? OpenAI a publié le modèle à des "fins de recherche" (ou pour faire parler d'elle), mais attend toujours qu'une équipe d'évaluation de la sécurité termine l'évaluation des risques.

OpenAI admet également que le modèle présente des lacunes : Sora a parfois des difficultés à saisir les détails spatiaux et les lois physiques. Il produit parfois des résultats complètement illogiques, comme la génération d'une vidéo d'un joggeur courant à reculons sur un tapis roulant.

Essayez-le : bien que nous n'ayons pas de moyen d'expérimenter Sora directement pour le moment, vous pouvez expérimenter le simulateur de génération de vidéo dans le document de recherche d'OpenAI. Vous pouvez également rejoindre la foule de personnes qui envoient constamment à Sam Altman des demandes d'intervention sur la plate-forme X et essayer de jouer avec la technologie (voici un de mes exemples préférés).

Des détails à l'ensemble : les percées d'OpenAI dans le domaine de l'IA vidéo sont tout simplement stupéfiantes. Avec de telles avancées réalisées en un an seulement, qui aurait pu imaginer les sommets que la technologie de génération de vidéos atteindrait d'ici 2025 ?

Google lance la version améliorée de Gemini 1.5

Gémeaux 1.5 Le professionnel démontre son raisonnement en analysant 402 pages de transcriptions.

Une semaine après le lancement du Gemini Ultra, plus puissant, Google a lancé le Gemini 1.5, un modèle multiple qui établit une nouvelle norme.

Comment cela fonctionne-t-il ? Gemini 1.5 est si efficace grâce à son architecture hybride experte : pour chaque requête, il n'active qu'une partie spécifique du modèle au lieu du modèle entier.

Pourquoi est-ce si important ? Gemini 1.5 est capable de traiter une énorme quantité d'informations à la fois - il dispose d'une fenêtre contextuelle pouvant aller jusqu'à 1 million de mots, pour être exact. Cela signifie qu'il peut traiter 750 000 mots, 11 heures de son, 1 heure de vidéo et des dizaines de milliers de lignes de code.

Les performances en pratique : Gemini 1.5 a permis de comprendre et de raisonner sur les 402 pages de transcriptions de la mission Apollo 11 sur la Lune, d'analyser avec précision les nombreuses intrigues et événements d'un film muet de 44 minutes, et de modifier et d'interpréter jusqu'à 100 000 lignes de code.

Clause de non-responsabilité : ce n'est pas encore disponible pour le public, mais Google introduira bientôt la version 1.5 Pro avec une fenêtre contextuelle standard de 128 000 jetons, et passera éventuellement à 1 million de jetons de puissance de traitement.

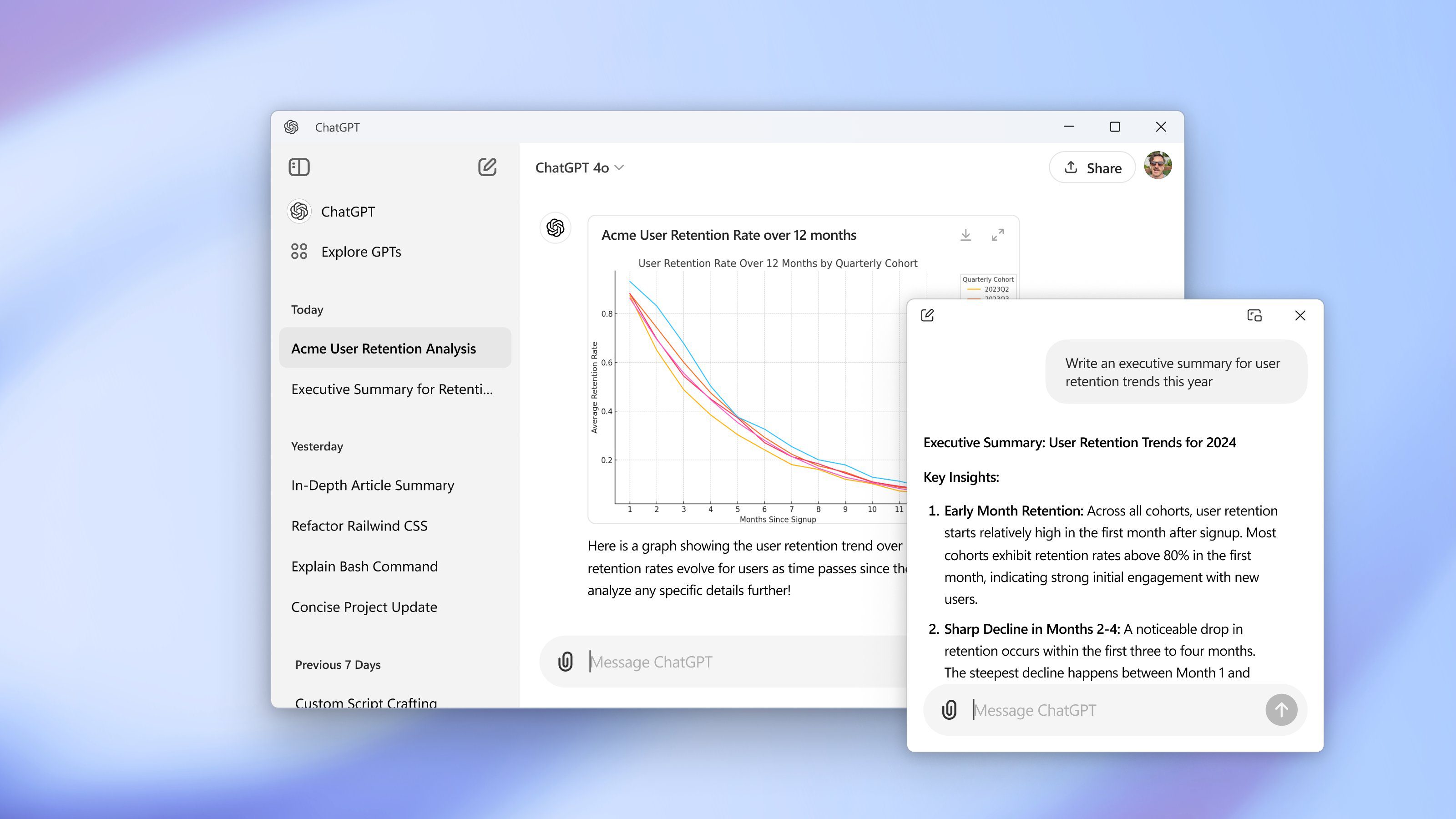

ChatGPT peut enfin se souvenir

Vous avez déjà eu l'occasion de discuter avec ChatGPT et d'être toujours bloqué dans une boucle sans fin de " Attendez, qui êtes-vous ? Qui êtes-vous ?". L'OpenAI a trouvé une solution : ChatGPT dispose d'une fonction de mémorisation.

Innovation OpenAI : l'ajout de la fonction Mémoire (encore en version bêta) permet à ChatGPT de stocker et de rappeler les informations partagées lors des conversations précédentes, de sorte qu'il n'est plus nécessaire de recommencer à chaque conversation.

Fonctionnement : vous pouvez soit demander explicitement à ChatGPT de se souvenir d'un certain détail, soit lui demander de capturer et de mémoriser automatiquement l'information. Exemple : ChatGPT se souvient d'un détail :

Vous indiquez à ChatGPT votre boulangerie sans blé, et lorsque vous demandez des recettes de brownies, il ne vous recommandera que des recettes sans blé.

Vous indiquez à ChatGPT que vous souhaitez que le procès-verbal apparaisse sous forme de colonnes à puces et de titres en gras, et il appliquera ce format à tous les futurs résumés de réunion.

L'OpenAI propose une série d'options permettant aux utilisateurs de contrôler le stockage de leurs souvenirs :

Les utilisateurs peuvent consulter le contenu des mémoires stockées dans le ChatGPT et supprimer sélectivement certaines informations.

Grâce au mode furtif, les utilisateurs peuvent lancer des requêtes sans s'appuyer sur des souvenirs antérieurs.

Des détails à l'ensemble : la nouvelle fonction de mémorisation de ChatGPT réduit la difficulté de taper la même chose à plusieurs reprises, ce qui permet aux utilisateurs de gagner du temps et d'éviter la frustration. Toutefois, cette nouvelle fonction est bien plus qu'une simple commodité : c'est un grand pas en avant pour l'IA vers une interaction humanisée.

Le son au service de l'économie avec ElevenLabs

ElevenLabs vient de lancer le plan de paiement pour les acteurs vocaux, une toute nouvelle opportunité pour quiconque de gagner de l'argent avec l'IA.

Détails : le plan de paiement pour les acteurs sonores permet aux professionnels du son (n'importe qui, en fait) de générer et de partager des versions clonées numériquement de leurs propres voix.

Il suffit aux utilisateurs de télécharger un échantillon de voix de 30 minutes et de fournir des détails descriptifs (tels que l'accent et le sexe).

Une fois téléchargée dans la bibliothèque sonore d'ElevenLab, votre voix peut être utilisée dans le monde entier pour des projets de voix off et de narration.

Pour éviter les abus, les administrateurs d'ElevenLabs suivent les projets qui utilisent votre voix et signalent toute utilisation inappropriée. Vous pouvez également activer des filtres automatiques pour une protection supplémentaire.

Du micro au macro : on craint beaucoup que l'IA ne supprime des emplois créatifs. Mais ElevenLabs est un exemple du potentiel de l'IA à offrir de nouvelles opportunités financièrement lucratives aux créatifs et aux créateurs.

- Meta a présenté V-JEPA, un moyen d'aider à former les modèles d'IA au monde réel par le biais de la vidéo.

- Sam Altman recherche 7 000 milliards de dollars (oui, avec un "t") pour un nouveau projet de puce d'intelligence artificielle.

- Un candidat politique pakistanais a utilisé l'IA pour gérer sa campagne - depuis la prison.

- Nvidia a lancé un chatbot personnalisé qui fonctionne localement sur votre PC.

- Apple vient de lancer un nouvel outil d'animation d'images appelé Keyframer.

- L'IA a eu son heure de gloire au Super Bowl de cette année

- Les chercheurs d'Amazon ont mis au point le plus grand modèle de synthèse vocale à ce jour, avec des résultats prometteurs.

- Microsoft a présenté trois grandes tendances de l'IA à surveiller en 2024.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...