Wisdom Spectrum admite 128K de contexto/4K de longitud de salida gran modelo GLM-4-Flash a todo volumen ¡abierto gratis!

Desde el 27 de agosto, Wisdom Spectrum pone gratuitamente a disposición del público la API GLM-4-Flash. GLM-4-Flash compara el GLM-4-9b proporcionado por Silicon Flow y el GLM-4-9b proporcionado por Silicon Flow. OpenRouter: interfaz unificada para integrar varios LLM, interfaz de grandes modelos gratuita No es menos eficaz ni más rápida que las numerosas API de modelos gratuitas que ofrece el PIR.

GLM-4-9b publicó anteriormente una API gratuita en el SILICONFLOW (Silicon Flow): acelerar la AGI para la humanidad, integrando una gran interfaz de modelos gratuitos GLM-4-Flash y GLM-4-9b tienen algunas diferencias en cuanto al tamaño del modelo, el número de parámetros, los escenarios de aplicación, etc. Además, ambas son API gratuitas y ambas ofrecen servicios gratuitos, ¿cómo debemos elegir?

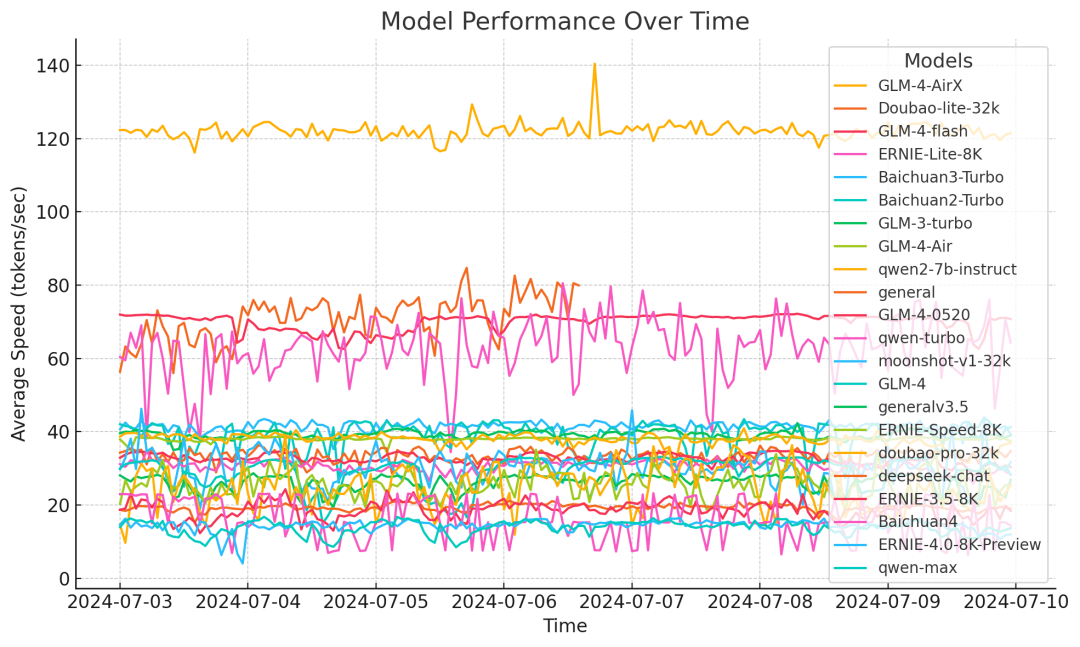

Puede decirse que el modelo GLM-4-Flash tiene una gran ventaja tanto en "velocidad" como en "rendimiento".

Para mejorar la velocidad de inferencia del modelo, GLM-4-Flash adopta una serie de medidas de optimización, como la cuantificación adaptativa de pesos, múltiples técnicas de procesamiento paralelo, estrategia de procesamiento por lotes y muestreo especulativo. Según los resultados de la prueba de velocidad del modelo de terceros, la velocidad de inferencia de GLM-4-Flash se mantiene estable en torno a 72,14 token/s en un ciclo de prueba de una semana, lo que es significativamente mejor que la de otros modelos.

En términos de rendimiento, GLM-4-Flash utiliza hasta 10T de datos multilingües de alta calidad en la fase de preentrenamiento del modelo, lo que le permite razonar sobre diálogos de varias rondas, búsquedas en Internet, invocaciones de herramientas y textos largos (con soporte para longitudes de contexto de hasta 128K.Salida Longitud 4K), etc. Admite 26 idiomas, entre ellos chino, inglés, japonés, coreano y alemán.

Sobre la base de una API GLM-4-Flash completamente gratuita y abierta, con el fin de ayudar a los usuarios a aplicar mejor el modelo a escenarios de aplicación específicos, proporcionamos simultáneamente funciones de ajuste fino del modelo para satisfacer las necesidades de diferentes usuarios. Le invitamos a utilizarlo.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...