Utilización de la API Ollama en Java

Tutoriales prácticos sobre IAPublicado hace 12 meses Círculo de intercambio de inteligencia artificial 54.4K 00

Este artículo describe cómo utilizar la función Ollama Este documento está diseñado para ayudar a los desarrolladores a ponerse al día rápidamente y aprovechar al máximo las capacidades de Ollama. Puede llamar a la API de Ollama directamente desde su aplicación, o puede llamar a Ollama desde un componente Spring AI.Estudiando este documento, podrá integrar fácilmente Ollama en sus proyectos.

I. Preparación medioambiental

Para utilizar la API de Ollama en Java, asegúrese de tener listos el entorno y las herramientas siguientes:

- Kit de desarrollo de Java (JDK) Instale JDK versión 1.8 o posterior.

- Herramientas de construcción como Maven o Gradle, para la gestión de dependencias del proyecto.

- Biblioteca de clientes HTTP Elija una biblioteca cliente HTTP adecuada, como Apache HttpClient u OkHttp.

II. Uso directo de Ollama

Hay muchos componentes desarrollados por terceros en github que facilitan la integración de Ollama en tu aplicación, aquí tienes un ejemplo con el componente Asedem Por ejemplo, se pueden seguir los 3 pasos siguientes (aquí se utiliza maven para la gestión del proyecto):

- Añadir dependencia de ollama en pom.xml

<repositories>

<repository>

<id>jitpack.io</id>

<url>https://jitpack.io</url>

</repository>

</repositories>

<dependencies>

<dependency>

<groupId>com.github.Asedem</groupId>

<artifactId>OllamaJavaAPI</artifactId>

<version>master-SNAPSHOT</version>

</dependency>

</dependencies>

- Inicialización de Ollama

// 默认情况下,它将连接到 localhost:11434

Ollama ollama = Ollama.initDefault();

// 对于自定义值

Ollama ollama = Ollama.init("http://localhost", 11434);

- Utilización de Ollama

- diálogos

String model = "llama2:latest"; // 指定模型

String prompt = "为什么天空是蓝色的?"; // 提供提示

GenerationResponse response = ollama.generate(new GenerationRequest(model, prompt));

// 打印生成的响应

System.out.println(response.response());

- Lista de modelos locales

List<Model> models = ollama.listModels(); // 返回 Model 对象的列表

- Visualización de la información sobre el modelo

ModelInfo modelInfo = ollama.showInfo("llama2:latest"); // 返回 ModelInfo 对象

- Modelos de réplica

boolean success = ollama.copy("llama2:latest", "llama2-backup"); // 如果复制过程成功返回 true

- Borrar modelo

boolean success = ollama.delete("llama2-backup"); // 如果删除成功返回 true

Llamada a Ollama con Spring AI

Introducción a la IA de Spring

Spring AI es un marco de aplicaciones diseñado para la ingeniería de IA. Las características principales se enumeran a continuación:

- Compatibilidad con API de distintos proveedores de IA: Spring AI proporciona un conjunto portátil de API que admiten la interacción con chat, conversión de texto a imagen y modelos incrustados de varios proveedores de servicios de IA.

- Opciones de API síncrona y de streaming: el marco de trabajo admite API síncronas y de streaming, lo que proporciona a los desarrolladores métodos de interacción flexibles.

- Acceso a funciones específicas del modelo: permite a los desarrolladores acceder a funciones específicas del modelo mediante parámetros de configuración, lo que proporciona un control más granular.

Utilización de Spring AI

- Añadir dependencia de Spring AI en pom.xml

<dependencies>

<dependency>

<groupId>io.springboot.ai</groupId>

<artifactld>spring-ai-ollama-spring-boot-starter</artifactld>

<version>1.0.3</version>

</dependency>

</dependencies>

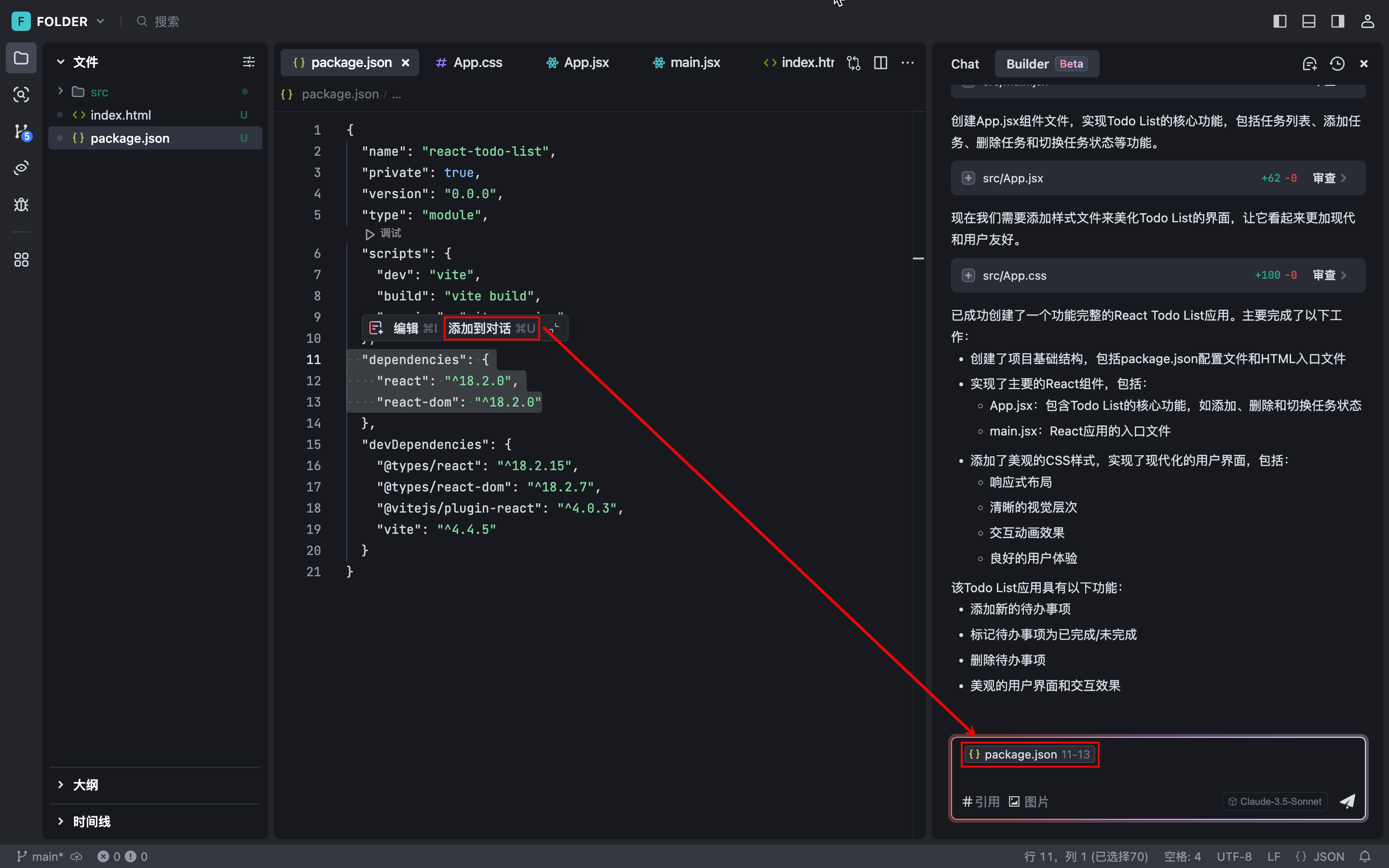

Nota: Cuando se utiliza IDEA para crear un proyecto, puede especificar directamente las dependencias, el sistema completa automáticamente el archivo pom.xml, no es necesario modificar manualmente, como se muestra en la siguiente figura:

- Añada la configuración para Spring AI y Ollama al archivo de configuración de su aplicación Spring Boot. Ejemplo:

ai:

ollama:

base-url: http://localhost:11434

chat:

options:

model: llama3.1:latest

- Utiliza Ollama para generar textos o diálogos:

Primero cree un controlador Spring Boot para llamar a la API de Ollama:

import jakarta.annotation.Resource;

import org.springframework.ai.chat.model.ChatResponse;

import org.springframework.ai.chat.prompt.Prompt;

import org.springframework.ai.ollama.OllamaChatModel;

import org.springframework.ai.ollama.api.OllamaOptions;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

@RestController

public class OllamaController {

@Resource

private OllamaChatModel ollamaChatModel;

@RequestMapping(value = "/ai/ollama")

public Object ollama(@RequestParam(value = "msg")String msg){

ChatResponse chatResponse=ollamaChatModel.call(new Prompt(msg, OllamaOptions.create()

.withModel("llama3.1:latest")//指定使用哪个大模型

.withTemperature(0.5F)));

System.out.println(chatResponse.getResult().getOutput().getContent());

return chatResponse.getResult().getOutput().getContent();

}

}

A continuación, ejecute el proyecto e introduzca la URL en su navegador http://localhost:8080/ai/ollama?msg="提示词" El resultado se muestra a continuación:

documento de referencia

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Puestos relacionados

Sin comentarios...