Xorbits Inference: despliegue en un clic de múltiples modelos de IA, un marco de inferencia distribuida

Introducción general

Xorbits Inference (Xinference) es un marco de inferencia distribuida potente y completo que admite la inferencia para una amplia gama de modelos de IA, como modelos de lenguaje extensos (LLM), modelos de reconocimiento del habla y modelos multimodales. Con Xorbits Inference, los usuarios pueden desplegar fácilmente sus propios modelos con un solo clic o utilizar los modelos de código abierto de vanguardia incorporados, tanto si se ejecutan en la nube, en un servidor local o en un PC.

Lista de funciones

- Admite el razonamiento con múltiples modelos de IA, incluidos grandes modelos lingüísticos, modelos de reconocimiento del habla y modelos multimodales.

- Modelos de implantación y servicios con un solo clic para simplificar la configuración de entornos experimentales y de producción

- Admite la ejecución en la nube, en servidores locales y en PC

- Incorpora una variedad de modelos de código abierto de última generación para comodidad directa del usuario

- Proporcionar abundante documentación y apoyo comunitario

Utilizar la ayuda

Proceso de instalación

- Preparación medioambientalAsegúrese de que Python 3.7 o superior está instalado.

- Instalación de Xorbits Inference::

pip install xorbits-inference - Entorno de configuraciónConfigure las variables de entorno y las dependencias según sea necesario.

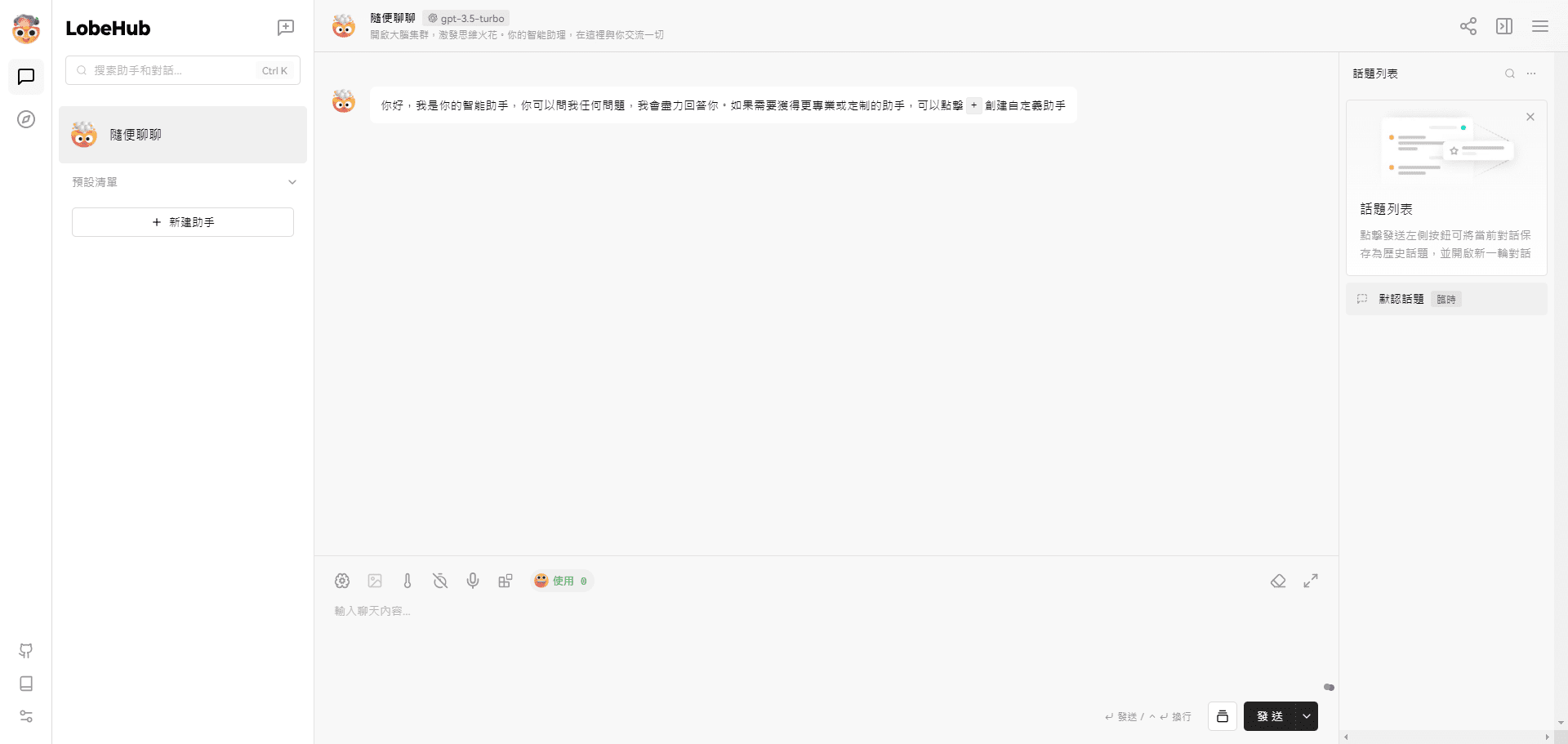

Proceso de utilización

- Modelos de carga::

from xinference import InferenceEngine engine = InferenceEngine(model_name="gpt-3") - razonamiento en funcionamiento::

result = engine.infer("你好,世界!") print(result) - modelo de despliegue::

xinference deploy --model gpt-3 --host 0.0.0.0 --port 8080

Funcionamiento detallado

- Selección de modelosLos usuarios pueden elegir entre una amplia gama de modelos de código abierto de última generación, como GPT-3, BERT, etc., o cargar sus propios modelos de inferencia.

- Configuración de parámetrosAl desplegar un modelo, puede configurar los parámetros del modelo, como el tamaño del lote, el uso de la GPU, etc., en función de sus necesidades.

- Seguimiento y gestión: A través de la interfaz de gestión proporcionada, los usuarios pueden supervisar el estado de funcionamiento del modelo y los indicadores de rendimiento en tiempo real, lo que facilita la optimización y el ajuste.

- Apoyo comunitarioÚnete a la comunidad Slack de Xorbits Inference para compartir experiencias y preguntas con otros usuarios y obtener ayuda y soporte a tiempo.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...