Modelo pequeño, gran potencia: QwQ-32B con parámetros 1/20 para luchar contra DeepSeek-R1 de pura cepa

Recientemente se han producido avances impresionantes en el campo de la IA, especialmente en la mejora de la capacidad de razonamiento de los modelos de lenguaje de gran tamaño (LLM). Entre ellos, el aprendizaje por refuerzo (RL) se está convirtiendo en una tecnología clave para romper el cuello de botella de rendimiento de los modelos tradicionales. Muchos estudios han confirmado que el RL puede mejorar significativamente la capacidad de razonamiento de los modelos. Por ejemplo, el modelo DeepSeek R1 logró un pensamiento profundo y un razonamiento complejo mediante la integración de datos de arranque en frío y un entrenamiento multietapa, alcanzando el nivel líder en ese momento.

En este contexto, AliCloud ha lanzado el modelo QwQ-32B, que ha vuelto a atraer la atención del sector. Este modelo, con 32.000 millones de parámetros, es comparable en rendimiento al DeepSeek-R1 que tiene un elevado número de 671.000 millones de parámetros (37.000 millones de parámetros activados). El extraordinario rendimiento de QwQ-32B es una demostración fehaciente de la eficacia del aprendizaje por refuerzo para mejorar la inteligencia de potentes modelos base preentrenados en el conocimiento masivo del mundo.

Además, Aliyun ha incorporado al modelo de razonamiento del QwQ-32B funciones relacionadas con los agentes, lo que le permite no sólo pensar de forma crítica, sino también utilizar herramientas y ajustar el proceso de razonamiento en función de la información que recibe del entorno. Estos avances tecnológicos demuestran el potencial transformador de la tecnología RL y allanan el camino hacia la Inteligencia Artificial General (AGI).

Actualmente, QwQ-32B se ha publicado en las plataformas Hugging Face y ModelScope bajo el protocolo de código abierto Apache 2.0, y los usuarios pueden acceder a él a través de la página web Chat de Qwen Experiencia.

Introducción

QwQ es el modelo de inferencia de la familia de modelos "Qwen". En comparación con los modelos tradicionales de ajuste fino de instrucciones, los modelos QwQ tienen mayores capacidades de pensamiento y razonamiento, y muestran importantes mejoras de rendimiento en las tareas descendentes, especialmente al resolver rompecabezas complejos. qwQ-32B, como modelo de inferencia de tamaño medio, tiene un rendimiento es comparable al de modelos de inferencia avanzados como DeepSeek-R1 y o1-mini.

Características del modelo.

- tipologíaModelos de lenguaje causal

- fase de formaciónPreentrenamiento y postentrenamiento, incluidos el ajuste supervisado y el aprendizaje por refuerzo.

- construya: Estructura de transformadores con codificación posicional RoPE, función de activación SwiGLU, normalización RMSNorm y sesgo del mecanismo de atención QKV Sesgo del mecanismo de atención

- escala de parámetros: 32.500 millones de dólares (32,5B)

- Tamaños de los parámetros de capa no integrados: 31.000 millones de dólares (31,0B)

- piso: 64

- Jefes de Atención (GQA)40 en el lado de las consultas y 8 en el lado de las claves/valores.

- Longitud del contexto: Completo 131,072 fichas

tenga en cuentaPara obtener la mejor experiencia, asegúrese de consultar la página Normas de uso El modelo QwQ se despliega más adelante.

Los usuarios pueden acceder al Demo Tener una experiencia, o pasar por la QwenChat Para acceder al modelo QwQ, recuerda abrir Thinking (QwQ).

Para más información, consulte Repositorios de GitHub demasiado documento oficial.

Rendimiento

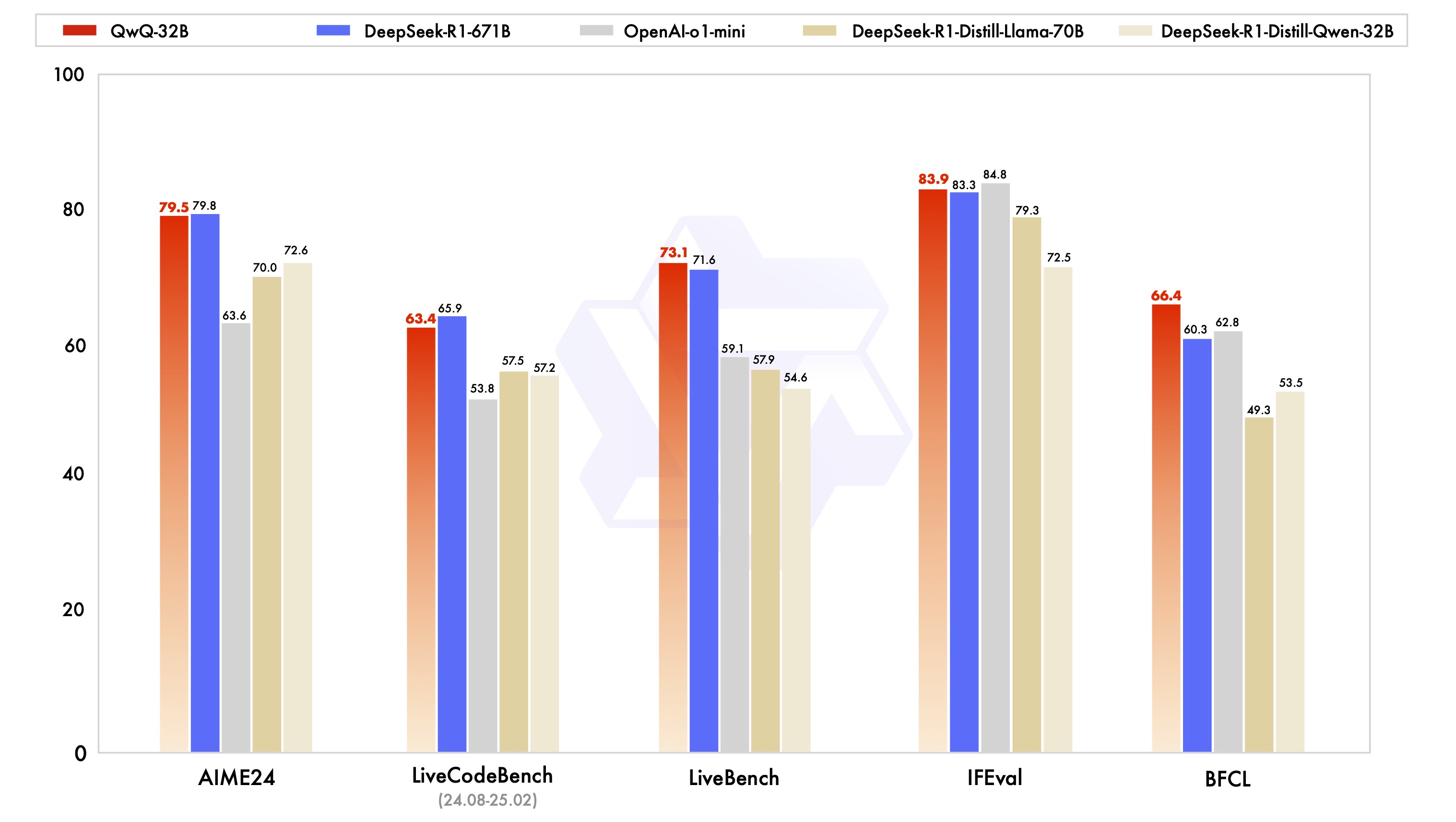

El modelo QwQ-32B fue evaluado en una serie de pruebas de referencia diseñadas para proporcionar una visión completa de sus capacidades en razonamiento matemático, escritura de código y resolución de problemas genéricos. El siguiente gráfico ilustra el rendimiento de QwQ-32B frente a otros modelos líderes, como DeepSeek-R1-Distilled-Qwen-32B, DeepSeek-R1-Distilled-Llama-70B, o1-mini y el DeepSeek-R1 original.

A partir de los resultados, QwQ-32B muestra un rendimiento similar o incluso mejor que los modelos superiores en varios puntos de referencia clave. Cabe destacar especialmente que QwQ-32B sigue manteniendo su competitividad frente a DeepSeek-R1, que tiene un número de parámetros mucho mayor que QwQ-32B, lo que demuestra aún más el gran potencial del aprendizaje por refuerzo para mejorar el rendimiento de los modelos.

Aprendizaje por refuerzo

El extraordinario rendimiento del QwQ-32B se debe en gran parte a la tecnología de Aprendizaje por Refuerzo (RL) que hay detrás. En pocas palabras, el aprendizaje por refuerzo es un método que guía a un modelo para que aprenda a tomar decisiones óptimas en un entorno determinado mediante mecanismos de recompensa o castigo. A diferencia del aprendizaje supervisado tradicional, el aprendizaje por refuerzo no se basa en grandes cantidades de datos etiquetados, sino que interactúa con el entorno y aprende por ensayo y error, dominando en última instancia las estrategias necesarias para completar la tarea.

Durante el entrenamiento de QwQ-32B, el equipo de investigación de Aliyun aplicó un método de ampliación del aprendizaje por refuerzo basado en la recompensa de resultados, partiendo de un punto de control de arranque en frío. En la fase inicial, se centraron en la ampliación del RL para tareas matemáticas y de código. En lugar de basarse en modelos de recompensa tradicionales, el equipo utilizó un verificador de precisión para las preguntas de matemáticas con el fin de garantizar la corrección de las respuestas finales, y un servidor de ejecución de código para evaluar si el código generado superaba con éxito los casos de prueba predefinidos.

A medida que avanzaba el entrenamiento, el rendimiento del modelo tanto en el dominio de las matemáticas como en el del código mostraba una mejora constante. Tras la primera fase, el equipo de investigación añadió una fase de entrenamiento de RL para capacidades genéricas. Esta fase de entrenamiento utilizó señales de recompensa del modelo de recompensa genérico y una serie de validadores basados en reglas. Los resultados experimentales muestran que un pequeño número de pasos de entrenamiento RL puede mejorar eficazmente las capacidades de propósito general del modelo en términos de adherencia a las instrucciones, alineación de preferencias humanas y rendimiento del agente sin causar una degradación significativa del rendimiento en las capacidades matemáticas y de codificación.

Aquí tienes un artículo sobre por qué Qwen-2.5-3B tiene una excelente capacidad de razonamiento:¿Cómo se hacen "más inteligentes" los grandes modelos? La Universidad de Stanford revela la clave de la superación personal: cuatro comportamientos cognitivos

Normas de uso

Para un rendimiento óptimo, se recomiendan los siguientes ajustes:

- Obligar a los modelos a pensar en la producción:: Garantizar que los modelos se modelan con

<think>\nal principio para evitar generar contenido de think vacío, lo que puede reducir la calidad de la salida. Si utiliza la funciónapply_chat_templatey estableceadd_generation_prompt=TrueEsto se implementa automáticamente. Tenga en cuenta, sin embargo, que esto puede hacer que falte la respuesta al principio del<think>Etiquetado, que es normal. - Parámetros de muestreo:

- utilizar

Temperature=0.6responder cantandoTopP=0.95En lugar de Descodificación codiciosa para evitar repeticiones interminables. - utilizar

TopKEntre 20 y 40 para filtrar las raras Ficha manteniendo la diversidad de la producción generada.

- utilizar

- Formatos de salida normalizadosSe recomienda utilizar el indicador Prompt para estandarizar la salida del modelo.

- problema de matemáticasEn el Prompt añadir "Por favor, el razonamiento paso a paso, y poner su respuesta final dentro de \boxed{}. "(Razone paso a paso y escriba su respuesta final dentro del recuadro {}).

- pregunta tipo test: Añade la siguiente estructura JSON al Prompt para estandarizar la respuesta: "Por favor, muestre su elección en el campo

answercon sólo la letra elegida, por ejemplo\"answer\": \"C\". " (Por favor, añada lo siguiente alanswerEl campo muestra su selección y contiene sólo la letra de selección, por ejemplo, el\"answer\": \"C\").

- Tratamiento de entradas largasPara entradas superiores a 32.768 fichas, active YaRN técnicas para mejorar la capacidad del modelo de captar eficazmente la información de secuencias largas.

Para los frameworks compatibles, se puede añadir lo siguiente a la directiva config.json para activar YaRN:

{

...,

"rope_scaling": {

"factor": 4.0,

"original_max_position_embeddings": 32768,

"type": "yarn"

}

}

Para la implantación, se recomienda vLLM. Si no está familiarizado con vLLM, consulte la sección documento oficial para obtener el uso. Actualmente, vLLM solo admite YARN estáticos, lo que significa que el factor de escalado permanece constante a medida que cambia la longitud de entrada.Esto puede afectar al rendimiento del modelo cuando se trata de textos más cortos. Por lo tanto, se recomienda añadir contextos largos sólo cuando sea necesario procesarlos. rope_scaling Configuración.

Cómo utilizar QwQ-32B (Use QwQ-32B)

El siguiente breve ejemplo muestra cómo utilizar el modelo QwQ-32B a través de Hugging Face Transformers y la API AliCloud DashScope.

vía Transformers Cara de Abrazo.

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/QwQ-32B"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompt = "How many r's are in the word \"strawberry\""

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=32768

)

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(response)

A través de la API AliCloud DashScope.

from openai import OpenAI

import os

# Initialize OpenAI client

client = OpenAI(

# If the environment variable is not configured, replace with your API Key: api_key="sk-xxx"

# How to get an API Key:https://help.aliyun.com/zh/model-studio/developer-reference/get-api-key

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1"

)

reasoning_content = ""

content = ""

is_answering = False

completion = client.chat.completions.create(

model="qwq-32b",

messages=[

{"role": "user", "content": "Which is larger, 9.9 or 9.11?"}

],

stream=True,

# Uncomment the following line to return token usage in the last chunk

# stream_options={

# "include_usage": True

# }

)

print("\n" + "=" * 20 + "reasoning content" + "=" * 20 + "\n")

for chunk in completion:

# If chunk.choices is empty, print usage

if not chunk.choices:

print("\nUsage:")

print(chunk.usage)

else:

delta = chunk.choices[0].delta

# Print reasoning content

if hasattr(delta, 'reasoning_content') and delta.reasoning_content is not None:

print(delta.reasoning_content, end='', flush=True)

reasoning_content += delta.reasoning_content

else:

if delta.content != "" and is_answering is False:

print("\n" + "=" * 20 + "content" + "=" * 20 + "\n")

is_answering = True

# Print content

print(delta.content, end='', flush=True)

content += delta.content

Trabajos futuros

El lanzamiento de QwQ-32B marca un paso inicial pero fundamental en la ampliación del aprendizaje por refuerzo (RL) para mejorar el razonamiento con la familia de modelos Qwen. A través de esta exploración, Aliyun no solo ha sido testigo del enorme potencial de las aplicaciones ampliadas del aprendizaje por refuerzo, sino que también ha reconocido el potencial sin explotar de los modelos lingüísticos preentrenados.

De cara al desarrollo de la próxima generación de modelos de "mil preguntas", Aliyun se muestra confiado. Creen que combinando un modelo base más robusto con técnicas de aprendizaje por refuerzo impulsadas por recursos informáticos a escala, se espera acelerar el objetivo final de la Inteligencia Artificial General (AGI). Además, AliCloud está explorando activamente una integración más profunda de los agentes con la RL para permitir capacidades de razonamiento de mayor alcance, y se ha comprometido a desbloquear una mayor inteligencia a través del escalado en el punto de inferencia.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...