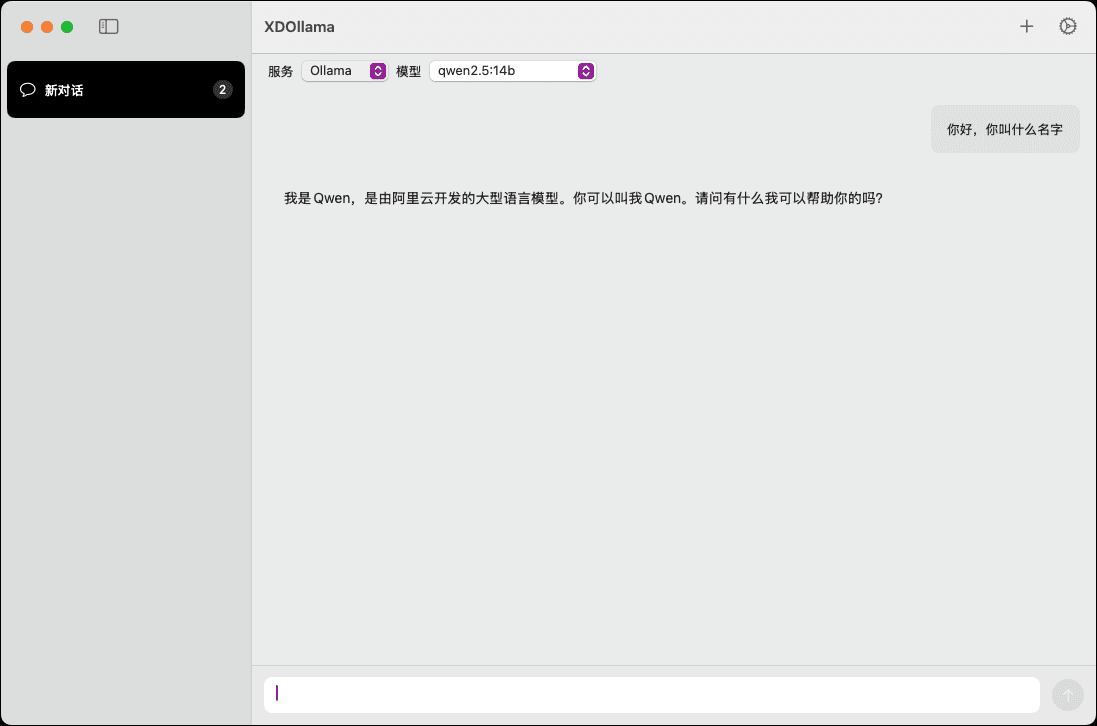

XDOllama: Interfaz del modelo AI para llamadas rápidas a Ollama\Dify\Xinference en MacOS.

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 48.2K 00

Introducción general

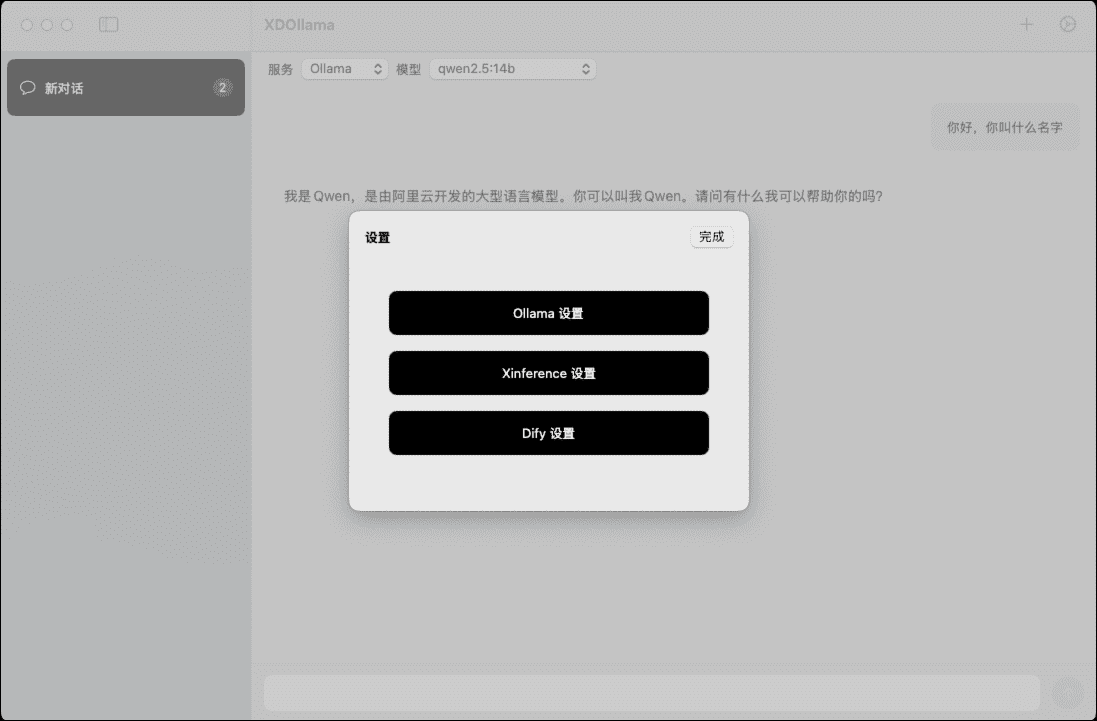

XDOllama es una aplicación de escritorio diseñada para que los usuarios de MacOS puedan invocar rápidamente Ollama, Dify y Xinferencia La aplicación permite a los usuarios llamar fácilmente a modelos de IA locales o en línea a través de una interfaz y un proceso de funcionamiento simplificados. La aplicación permite a los usuarios llamar fácilmente a modelos de IA locales o en línea a través de una interfaz y un proceso de funcionamiento simplificados, lo que mejora la eficiencia y la experiencia de trabajo.

Lista de funciones

- invocar el local Ollama modelización

- Llamar al modelo Ollama en línea

- Llamada al modelo local Xinference

- Llamada al modelo Xinference en línea

- invocar el local Dify aparato

- Llamar a la aplicación en línea de Dify

- Compatibilidad con varios marcos de IA

- Diseño de interfaz fácil de usar

- Eficaz velocidad de llamada de modelos

Utilizar la ayuda

Proceso de instalación

- Descarga el archivo DMG.

- Haga doble clic para abrir el archivo DMG descargado.

- Arrastra XDOllama.app a la carpeta Aplicaciones.

- Una vez finalizada la instalación, abra la aplicación y estará lista para usar.

Normas de uso

- Abra la aplicación XDOllama.

- Seleccione el modelo de IA al que desea llamar (Ollama, Dify o Xinference).

- Seleccione el método de llamada (local o en línea).

- Introduzca los parámetros y ajustes pertinentes que se le soliciten.

- Pulse el botón "Llamar" y espere a que el modelo se cargue y se ejecute.

- Visualizar y utilizar los resultados del modelo.

Flujo detallado de funcionamiento de las funciones

Llamada al modelo local de Ollama

- Seleccione "Ollama" en la pantalla principal.

- Seleccione el método de llamada "Local".

- Introduzca la ruta y los parámetros del modelo.

- Pulse el botón "Llamar" y espere a que se cargue el modelo.

- Ver el resultado del modelo.

Llamar al modelo Ollama en línea

- Seleccione "Ollama" en la pantalla principal.

- Seleccione el método de llamada "En línea".

- Introduzca la URL y los parámetros del modelo en línea.

- Pulse el botón "Llamar" y espere a que se cargue el modelo.

- Ver el resultado del modelo.

Llamada al modelo local Xinference

- Seleccione "Xinferencia" en la pantalla principal.

- Seleccione el método de llamada "Local".

- Introduzca la ruta y los parámetros del modelo.

- Pulse el botón "Llamar" y espere a que se cargue el modelo.

- Ver el resultado del modelo.

Llamada al modelo Xinference en línea

- Seleccione "Xinferencia" en la pantalla principal.

- Seleccione el método de llamada "En línea".

- Introduzca la URL y los parámetros del modelo en línea.

- Pulse el botón "Llamar" y espere a que se cargue el modelo.

- Ver el resultado del modelo.

Llamada a la aplicación local de Dify

- Seleccione "Dify" en la pantalla principal.

- Seleccione el método de llamada "Local".

- Introduzca la ruta de la aplicación y los parámetros.

- Pulse el botón "Llamar" y espere a que se cargue la aplicación.

- Ver la salida de la aplicación.

Llamar a la aplicación en línea de Dify

- Seleccione "Dify" en la pantalla principal.

- Seleccione el método de llamada "En línea".

- Introduzca la URL y los parámetros de la solicitud en línea.

- Pulse el botón "Llamar" y espere a que se cargue la aplicación.

- Ver la salida de la aplicación.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...