Mecanismo de atención (Attention Mechanism) es qué, un artículo para leer y entender

Definición de mecanismos de atención

El mecanismo de atención (Attention Mechanism) es una técnica computacional que imita los procesos cognitivos humanos, aplicada inicialmente en el campo de la traducción automática y convertida posteriormente en una parte importante del aprendizaje profundo. La idea central es permitir que el modelo se centre dinámicamente en las partes relevantes de la entrada al procesar la información, al igual que los humanos se centran automáticamente en las palabras clave al leer. La importancia de los elementos de entrada se representa asignando diferentes pesos, y los pesos más altos representan una mayor atención. En términos de implementación técnica, la función de atención asigna una consulta a un conjunto de pares clave-valor como salida de una suma ponderada, en la que los pesos se calculan a partir de una función de compatibilidad entre la consulta y las claves.

La implementación más común es la atención por producto punto, en la que la distribución de la atención se obtiene calculando el producto punto de las consultas y las claves. El éxito del mecanismo de atención radica en su capacidad para manejar eficientemente largas secuencias de datos, resolviendo el problema de la dependencia de largo alcance que existe en las redes neuronales recurrentes tradicionales. Con el desarrollo, el mecanismo de atención se ha ampliado desde la arquitectura codificador-decodificador inicial a formas como la autoatención, que se ha convertido en un componente central de la arquitectura Transformer. Esta técnica no sólo ha mejorado la calidad de la traducción automática, sino que también se ha utilizado ampliamente en muchos campos, como el procesamiento de imágenes, el reconocimiento del habla, etc., mejorando significativamente la capacidad del modelo para captar información importante.

Orígenes históricos de los mecanismos atencionales

- Fundamentos de la psicología cognitivaEl concepto de mecanismos de atención hunde sus raíces en el estudio de la psicología cognitiva humana. Ya en el siglo XIX, el psicólogo William James propuso que la atención es "el proceso por el cual la mente se ocupa de uno de los varios objetos o pensamientos simultáneos que puede poseer". Este mecanismo de atención humana selectiva proporciona una base teórica para los modelos computacionales.

- Primeros intentos de modelización computacionalEn la década de 1990, los investigadores empezaron a introducir la idea de la atención en las redes neuronales. El Modelo de Alineación, propuesto por el equipo de Joshua Bengio en 1997, puede considerarse un prototipo de mecanismo de atención para mejorar el rendimiento del aprendizaje secuencia a secuencia...

- Avances en traducción automática: En 2014, Bahdanau et al. implementaron con éxito por primera vez el mecanismo de atención en la traducción automática neuronal, lo que mejoró significativamente la calidad de la traducción de frases largas mediante alineación suave. Este trabajo abre el camino a una amplia aplicación del mecanismo de atención en el ámbito del procesamiento del lenguaje natural

- Innovación en la arquitectura de los transformadores: En 2017, Vaswani et al. publicaron el artículo Attention Is All You Need, que construye la arquitectura Transformer enteramente basada en el mecanismo de atención, evitando la estructura tradicional de red neuronal recurrente y creando un nuevo punto de referencia de rendimiento

- Expansión entre dominiosEl mecanismo de atención: Con la profundidad de la investigación, el mecanismo de atención se ha extendido del procesamiento del lenguaje natural a la visión por ordenador, el reconocimiento del habla, los sistemas de recomendación y muchos otros campos, convirtiéndose en una parte importante de los modelos de aprendizaje profundo.

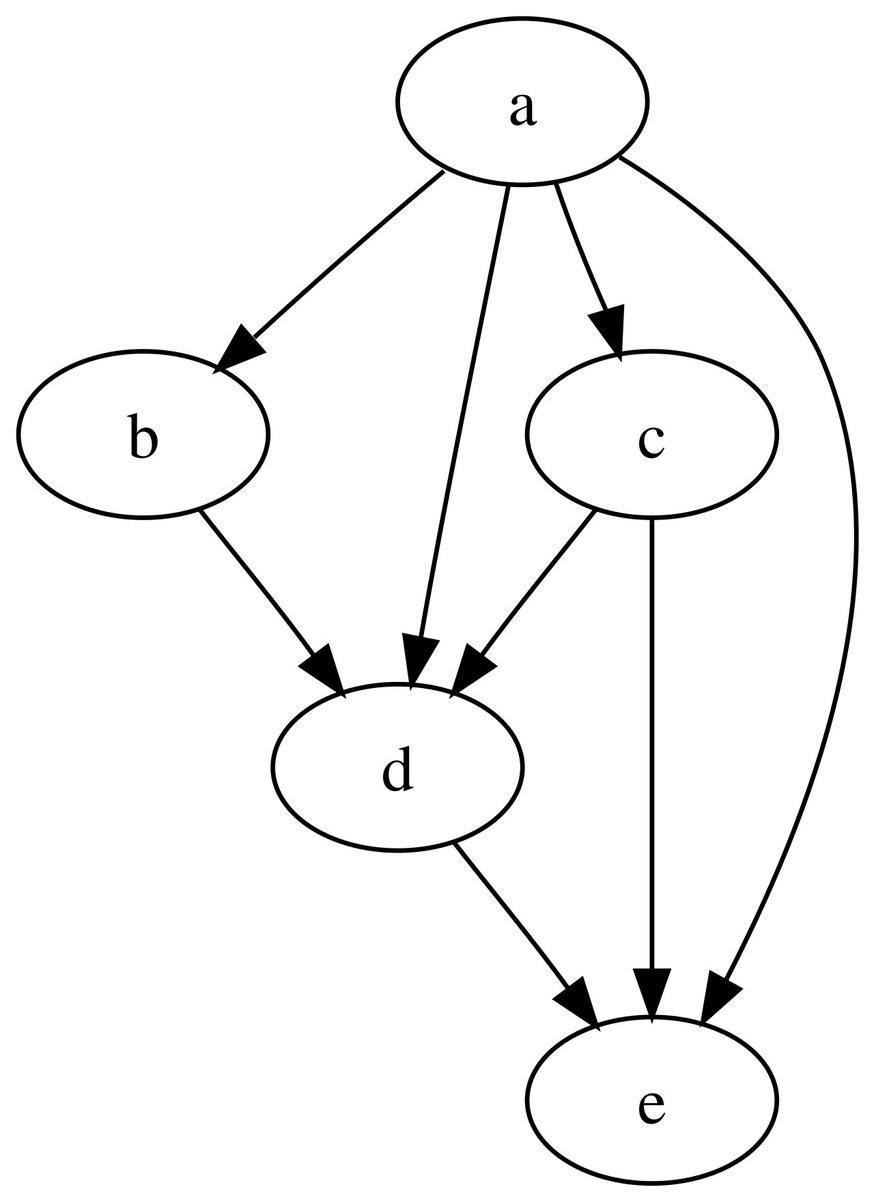

Cómo funciona el mecanismo de atención

- etapa de señal de entradaLa secuencia de entrada se convierte primero en una representación vectorial, en la que cada palabra o elemento corresponde a un vector de alta dimensión. Estos vectores contienen información tanto sobre el propio elemento como sobre su posición en la secuencia

- Marco consulta-clave-valorEl mecanismo de atención utiliza tres componentes: consulta, clave y valor. La Consulta representa lo que debe ser objeto de atención en ese momento, la Clave representa el objeto que se compara y el Valor es la información real que debe extraerse.

- Cálculo de la similitudLa puntuación de atención se obtiene calculando la similitud entre la consulta y cada clave. Entre los métodos de cálculo de similitud más utilizados se encuentran el producto de puntos, la atención aditiva, etc. El método del producto de puntos es muy utilizado debido a su alta eficiencia computacional.

- normalización del pesoUtiliza la función softmax para convertir las puntuaciones de atención en una distribución de probabilidad, asegurando que todos los pesos suman 1, formando la matriz de pesos de atención.

- Salida de la suma ponderadaPor último, los pesos de atención se multiplican y se suman con los vectores de valores correspondientes para obtener una representación de salida ponderada. Esta salida concentra la información más relevante de la secuencia de entrada

Principales tipos de mecanismos atencionales

- Atención suave frente a atención duraLa atención suave asigna pesos continuos a toda la secuencia de entrada, lo que es diferenciable y fácil de entrenar; la atención dura se centra sólo en lugares específicos, lo que es computacionalmente eficiente pero no diferenciable, y requiere entrenamiento mediante métodos como el aprendizaje por refuerzo.

- Atención global frente a atención localAtención global: la atención global tiene en cuenta todas las posiciones de entrada, lo que conlleva una gran carga computacional pero una gran precisión; la atención local se centra sólo en algunas posiciones dentro de la ventana, lo que equilibra precisión y eficiencia.

- Mecanismo de autoatenciónLa autoatención, también conocida como atención interna, permite que cada posición de una secuencia calcule los pesos atencionales con respecto a todas las posiciones de la secuencia, y es buena para captar las dependencias dentro de las secuencias.

- Atención prolongadaMejorar el poder expresivo del modelo y su capacidad para captar múltiples relaciones paralelizando múltiples cabezas de atención y permitiendo que el modelo atienda simultáneamente a información en diferentes subespacios de representación.

- atención divididaSecuencia de consulta: se utiliza entre dos secuencias diferentes, permitiendo que una secuencia actúe como consulta y la otra proporcione claves y valores; se suele emplear para interacciones intermodales en arquitecturas de codificador-decodificador.

Escenarios de aplicación del mecanismo de atención

- sistema de traducción automáticaEn la traducción automática neuronal, el mecanismo de atención ayuda al modelo a centrarse automáticamente en las partes relevantes de la frase en la lengua de partida al generar palabras en la lengua de llegada, lo que mejora notablemente la calidad de la traducción de frases largas.

- Reconocimiento y procesamiento de imágenesEl objetivo de este artículo es analizar los mecanismos de atención en visión por computador que permiten a los modelos centrarse en regiones clave de una imagen, con buenos resultados en tareas de clasificación de imágenes, detección de objetivos y generación de imágenes.

- tecnología de reconocimiento del habla: Mecanismo de atención para alinear los fotogramas de audio con el texto de salida en el reconocimiento de voz, manejar secuencias de entrada y salida de diferentes longitudes y mejorar la precisión del reconocimiento.

- Optimización del sistema recomendadaEl mecanismo de atención: mediante el análisis de la secuencia de comportamientos del usuario, el mecanismo de atención puede captar los cambios en los intereses del usuario y centrarse en los comportamientos históricos más importantes para la predicción de recomendaciones, lo que mejora la precisión de las recomendaciones.

- Medios de diagnóstico médicoEn el análisis de imágenes médicas, el mecanismo de atención ayuda al modelo a centrarse en la zona de la lesión y a proporcionar ayuda a los médicos en la toma de decisiones, al tiempo que mejora la interpretabilidad del modelo.

Características ventajosas del mecanismo de atención

- capacidad de cálculo paraleloA diferencia de las redes neuronales recurrentes, que procesan secuencias de forma secuencial, el mecanismo de atención puede calcular los pesos de atención de todas las posiciones en paralelo, lo que mejora drásticamente la eficacia del entrenamiento y la inferencia.

- Modelización de la dependencia a largo plazoPuede establecer directamente la conexión entre dos posiciones cualesquiera de una secuencia, resolviendo eficazmente el problema de captura de dependencias en secuencias largas y superando el problema de desaparición de gradiente de las RNN tradicionales.

- Mejora de la interpretabilidadLas distribuciones del peso de la atención proporcionan información visual sobre el proceso de toma de decisiones del modelo, lo que ayuda a los investigadores a comprender el foco de atención del modelo y aumenta su transparencia.

- Flexibilidad Arquitectura Diseño: puede integrarse fácilmente en diversas arquitecturas de redes neuronales sin cambiar la estructura principal, lo que ofrece más posibilidades para el diseño de modelos.

- Capacidad de fusión multimodal: Experiencia en el manejo de interacciones entre diferentes datos modales, capaz de integrar eficazmente múltiples tipos de información como texto, imágenes, audio, etc.

Retos para la realización del mecanismo de atención

- Cuestiones de complejidad computacionalLa complejidad computacional del mecanismo de atención crece con la longitud de la secuencia en pasos cuadrados, y se enfrenta a limitaciones computacionales y de memoria cuando se trata de secuencias largas.

- gran consumo de memoriala necesidad de almacenar la matriz de pesos de atención, los requisitos de memoria aumentan drásticamente cuando la secuencia es larga, lo que impone grandes exigencias al dispositivo de hardware

- El fenómeno del alisamiento excesivoA veces, las ponderaciones de la atención están distribuidas de forma demasiado uniforme, lo que hace que el modelo no pueda centrarse en la información clave de forma eficaz y afecta al rendimiento del modelo.

- Inestabilidad de la formaciónEn particular, en la atención multicabezal, las velocidades de aprendizaje pueden variar de un cabezal a otro, lo que requiere un ajuste preciso de los hiperparámetros.

- Codificación de la información de localizaciónel mecanismo de autoatención no es consciente de la ubicación por sí mismo y requiere una codificación adicional de la ubicación para inyectar información sobre el orden de las secuencias.

Orientaciones para mejorar el mecanismo de atención

- Diseño para una atención eficienteLos investigadores han propuesto múltiples variantes de atención dispersa, atención local, etc. para reducir la complejidad computacional y permitir que los modelos manejen secuencias más largas.

- Solución de optimización de memoriaReducción de la huella de memoria mediante técnicas como chunking y gradient checkpointing para que los mecanismos de atención funcionen en entornos con recursos limitados.

- Exploración de innovaciones estructuralesIntroducción de nuevos métodos, como la codificación de la posición relativa y la codificación de la posición rotacional, para tratar mejor las relaciones de posición y la información en las secuencias.

- atención multiescalaCombinar diferentes mecanismos de granularidad de la atención para centrarse tanto en los detalles locales como en el contexto global con el fin de mejorar el rendimiento del modelo.

- Investigación de fundamentos teóricosMejorar los análisis teóricos de los mecanismos de atención para comprender su funcionamiento y sus limitaciones y mejorar el diseño de los modelos.

Desarrollo futuro de los mecanismos de atención

- Arquitectura multimodal unificada: Se espera que los mecanismos de atención sean un marco fundamental para el procesamiento unificado de datos multimodales, impulsando el desarrollo de la IA multimodal.

- Inspirado en la neurociencia:: Profundizar en los mecanismos neuronales del sistema atencional humano para desarrollar un modelo de atención más sólido desde el punto de vista biológico.

- atención adaptativa: Desarrollo de sistemas inteligentes capaces de ajustar automáticamente el alcance y la precisión de la atención en función de la dificultad de la tarea para mejorar la eficiencia computacional.

- Mejora de la interpretabilidad: Combinar técnicas de visualización y métodos explicativos para que las explicaciones proporcionadas por los mecanismos de atención sean más precisas y fiables.

- Despliegue de dispositivos periféricos: Permitir que los modelos basados en la atención se ejecuten eficientemente en dispositivos móviles e IoT mediante la compresión y optimización de modelos.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...