Documento filtrado de Microsoft: ¿sólo 8.000 millones para GPT-4o-mini y 100.000 millones para o1-mini?

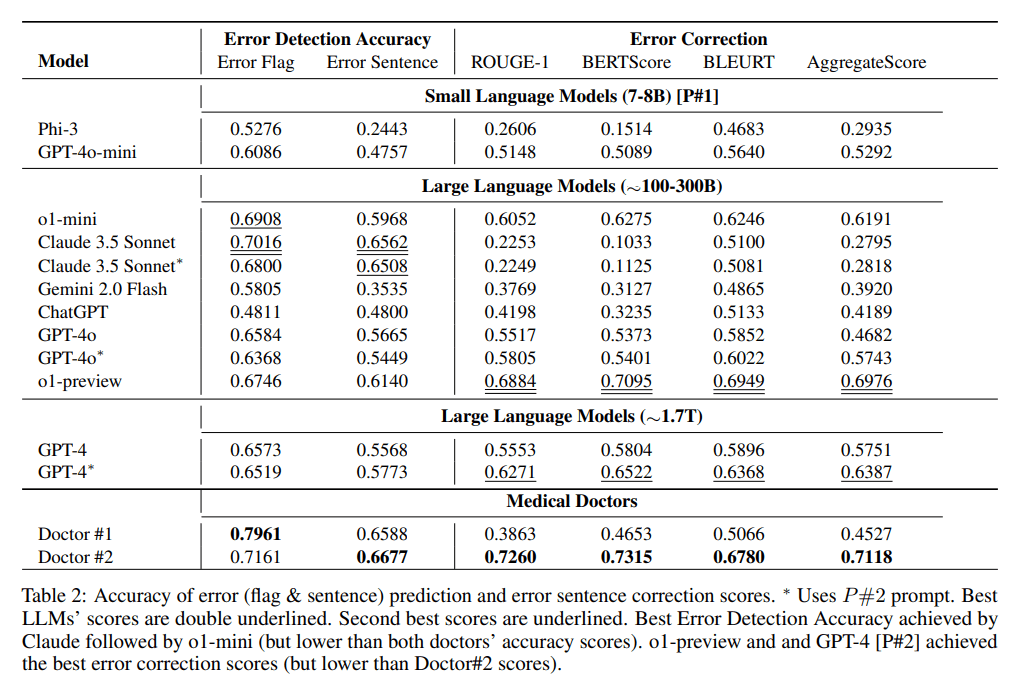

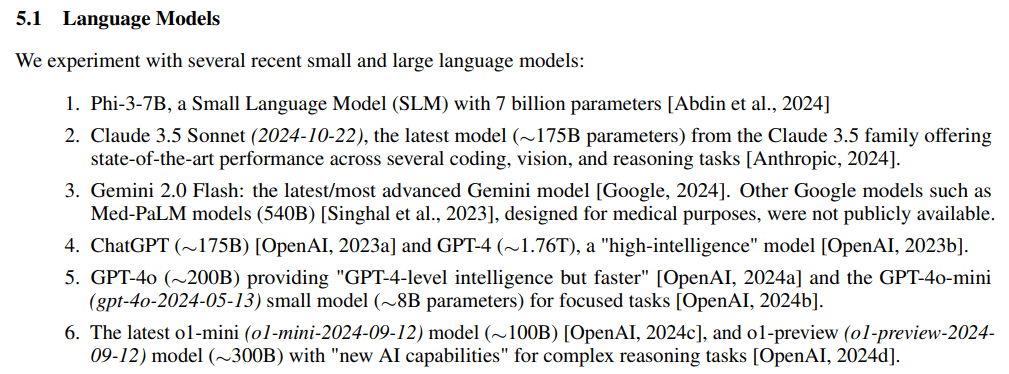

Ha habido una discusión en curso sobre los tamaños de los parámetros de los principales LLM de código cerrado, y en los últimos 2 días de 2024 un artículo de Microsoft sobre elDetección y corrección de errores médicos en las notas clínicasconjeturaexperimentopatrón de referenciaEl estudio del MEDEC se saltó accidental y directamente la escala de sus parámetros:o1-preview, GPT-4.GPT-4o ySoneto Claude 3.5.

Dirección de la ponencia: https://arxiv.org/pdf/2412.19260v1

La parte experimental del experimento también divide las grandes escalas de parámetros del modelo en 3 bloques:7-8B, ~100-300B, ~1,7Tpero (no)GPT-4o-miniEstar en el primer puesto con sólo 8B es un poco increíble.

resúmenes

- Claude 3,5 Soneto (2024-10-22), ~175B

- ChatGPT, ~175B

- GPT-4, aproximadamente 1,76T

- GPT-4o, ~200B

- GPT-4o-mini (gpt-4o-2024-05-13) Sólo 8B

- Último o1-mini (o1-mini-2024-09-12) sólo 100B

- o1-preview (o1-preview-2024-09-12) ~ 300B

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...