Los productos para PC Microsoft Azure+Copilot+AI son totalmente compatibles con los modelos DeepSeek R1

El 30 de enero de 2025, Microsoft comunicó que el modelo R1 de DeepSeek ya está disponible en su plataforma de computación en nube Azure y en las herramientas de GitHub para desarrolladores en general. Microsoft también dijo que los clientes pronto podrán utilizar el modelo R1 de DeepSeek en sus... Copiloto + Ejecutar el modelo R1 localmente en el PC.

Como hemos mencionado antes, Copilot utilizará gradualmente otros grandes modelos además de OpenAI:

Microsoft ha estado en las noticias más recientemente, y una de las cosas más notables es que elEl copiloto de GitHub es gratuito y abierto.aunque en menor número (2.000 al mes para completar códigos y 50 al mes para conversaciones de chat), pero al menos es un acontecimiento histórico, y el modelo se ha ampliado de la única GPT 4o original a o1 Claude responder cantando Géminis y muchos otros modelos.

Lo que esto significa realmente es que Microsoft se está alejando de su dependencia de la tecnología OpenAI, que en cierto modo ya no es el mejor modelo ni, me temo, el más rentable de operar.

A raíz de la reciente búsqueda profunda La influencia más poderosa en el mundo, una serie de llamativas nuevas características siguen viniendo en línea, pero también causó la competencia de vida o muerte entre China y los Estados Unidos en el campo de la IA, Microsoft con el fin de hacer copiloto mejor soporte para el idioma chino, listo para usar el modelo R1 de deepseek en copiloto.

Nadella, CEO de Microsoft, también destacó en la llamada que los modelos DeepSeek R1 ya están disponibles a través de la plataforma de IA de Microsoft Azure AI Foundry y GitHub, y pronto podrán ejecutarse en ordenadores Copilot+. Nadella afirmó que DeepSeek "tiene algunas innovaciones reales" y que el coste de la IA tiende a la baja: "La Ley de Escalado se está acumulando en los cálculos de preentrenamiento y tiempo de inferencia. A lo largo de los años, hemos visto mejoras significativas en la eficiencia del entrenamiento y la inferencia de la IA. En el lado de la inferencia, solemos ver una mejora de más de 2 veces en precio/rendimiento por generación de hardware y de más de 10 veces en precio/rendimiento por generación de modelos".

Nos alegramos de ello.

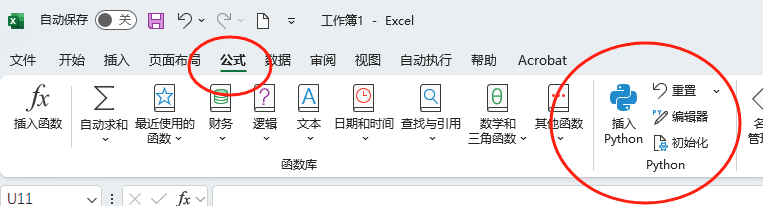

copilot para Microsoft 365 es un plugin nativo de copilot para office 365 (word, excel, ppt, OneNote, teams, etc.), con el que podrás generar contenido a partir de otros archivos en word, generar fórmulas y cálculos en excel, crear presentaciones a partir de otros archivos en PPT También puede crear presentaciones a partir de otros documentos en PPT, organizar notas y generar más notas en OneNote, resumir reuniones en teams, y mucho más.

Lectura relacionada 1: "Ejecución local de modelos DeepSeek R1 optimizados por destilación en ordenadores Copilot

La IA se desplaza hacia los bordes y los ordenadores Copilot+ están a la cabeza. Mientras Azure AI Foundry pone en marcha DeepSeek R1 alojado en la nube (lectura relacionada2), estamos llevando una versión de DeepSeek-R1 optimizada para NPU directamente a los PC Copilot+, con las primeras adaptaciones para la plataforma Qualcomm Snapdragon X, seguidas de compatibilidad con plataformas como Intel Core Ultra 200V. La primera versión de DeepSeek-R1-Distill-Qwen-1.5B estará disponible en AI Toolkit, a la que seguirán las versiones 7B y 14B. Estos modelos optimizados permiten a los desarrolladores crear e implantar aplicaciones de IA que se ejecutan de forma eficiente en el dispositivo, aprovechando al máximo la potencia de la NPU de los PC Copilot+.

La Unidad de Procesamiento Neuronal (NPU) de Copilot+ PC proporciona un motor altamente eficiente para la inferencia de modelos, abriendo un nuevo paradigma para que la IA generativa no sólo se ejecute bajo demanda, sino que también permita servicios de ejecución semicontinua. Esto permite a los desarrolladores crear experiencias continuas proactivas con potentes motores de inferencia. Gracias a la acumulación de tecnologías del proyecto Phi Silica, hemos logrado una inferencia eficiente, minimizando la duración de la batería y el consumo de recursos del sistema, al tiempo que garantizamos tiempos de respuesta y tasas de rendimiento competitivos en el primer token. El modelo DeepSeek optimizado para la NPU utiliza una serie de tecnologías clave del proyecto, como el diseño modular del modelo para lograr un equilibrio óptimo entre rendimiento y eficiencia, técnicas de cuantificación de bajo ancho de bits y la estrategia de mapeo de Transformer en la NPU. Además, aprovechamos Windows Copilot Runtime (WCR) para permitir el escalado en todo el ecosistema Windows a través del formato ONNX QDQ.

¡Experiméntelo ahora!

En primer lugar... Empecemos rápidamente.

Para experimentar DeepSeek en ordenadores Copilot+, basta con descargar la extensión VS Code para AI Toolkit. Los modelos optimizados de DeepSeek con formato QDQ de ONNX estarán pronto disponibles en el repositorio de modelos de AI Toolkit y se extraerán directamente de Azure AI Foundry. Haga clic en el botón "Descargar" para descargar localmente. Una vez descargado, basta con abrir Playground, cargar el modelo "deepseek_r1_1_5" y empezar a experimentar con las instrucciones.

Además del modelo ONNX optimizado para Copilot+ PC, también puede utilizar el modelo ONNX para Copilot+ PC haciendo clic en el botón "DeepSeek R1"Inténtalo". Parque infantil" para experimentar el modelo original alojado en la nube en Azure Foundry.

El AI Toolkit es una parte importante del flujo de trabajo de los desarrolladores, ya que permite la experimentación de modelos y la preparación para el despliegue. Con este Playground, puede probar fácilmente modelos DeepSeek en Azure AI Foundry para su despliegue local.

Optimización a nivel de chip

El modelo Qwen 1.5B optimizado para la destilación contiene un tokenizador, una capa de incrustación, un modelo de procesamiento de contexto, un modelo de iteración de tokens, una cabecera de modelo de lenguaje y un módulo detokenizador.

Utilizamos la cuantificación por trozos de 4 bits para la capa de incrustación y la cabecera del modelo de lenguaje, y ejecutamos estas operaciones de memoria intensiva en la CPU. Al centrar los principales recursos de optimización de la NPU en el módulo Transformer, de alta carga computacional, que contiene el procesamiento del contexto y la iteración de tokens, se utiliza la cuantificación canal a canal int4 y se implementa el procesamiento selectivo de precisión mixta para los pesos, mientras que los valores de activación utilizan la precisión int16.

Aunque la versión de DeepSeek de Qwen 1.5B tiene una versión para int4, no puede adaptarse directamente a las NPU debido a la presencia de formas y comportamientos de entrada dinámicos, que deben optimizarse para lograr una compatibilidad y eficiencia óptimas. Además, utilizamosONNX QDQpara soportar el escalado de varios tipos de NPU en el ecosistema Windows. Optimizamos la disposición de los operadores entre CPU y NPU para lograr el mejor equilibrio entre consumo energético y velocidad.

Para lograr el doble objetivo de ocupar poca memoria y realizar una inferencia rápida (similar al esquema Phi Silica), introducimos dos mejoras clave: en primer lugar, adoptamos un diseño de ventana deslizante, que permite un tiempo de respuesta ultrarrápido del primer Token y un soporte de contexto largo incluso cuando la pila de hardware no admite el tensor dinámico; y en segundo lugar, utilizamos un esquema de cuantificación QuaRot de 4 bits, que aprovecha al máximo el procesamiento de bajo ancho de bits. QuaRot elimina los valores atípicos de los pesos y los valores de activación mediante la rotación Hadamard, lo que facilita la cuantificación del modelo. En comparación con métodos existentes como GPTQ, QuaRot mejora significativamente la precisión de la cuantificación, especialmente en escenarios de baja granularidad como la cuantificación canal a canal. La combinación de la cuantificación de bajo ancho de bits y las optimizaciones de hardware, como el diseño de la ventana deslizante, permite al modelo alcanzar las propiedades de comportamiento de un modelo grande con una huella de memoria compacta. Como resultado de estas optimizaciones, el modelo consigue un tiempo de respuesta de la primera ficha de 130 ms y una tasa de rendimiento de 16 fichas/segundo en escenarios con fichas cortas (<64 fichas).

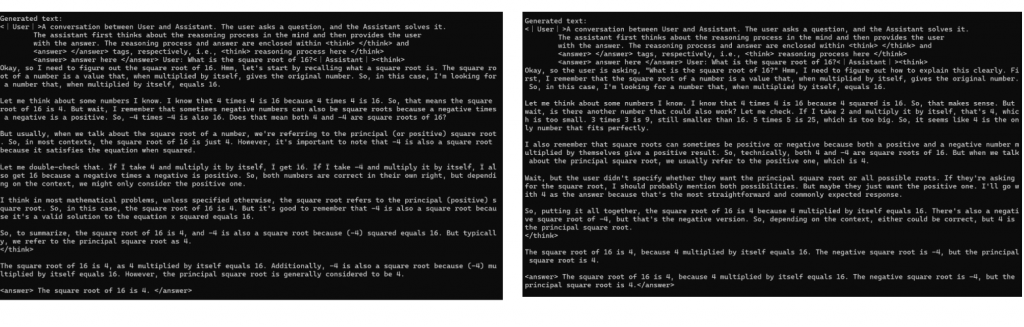

Demostramos las sutiles diferencias entre la respuesta del modelo original y la respuesta del modelo cuantitativo con el siguiente ejemplo, que consigue optimizar la eficiencia energética manteniendo un alto rendimiento:

Fig. 1: Comparación cualitativa. Ejemplos del modelo original (izquierda) y del modelo optimizado NPU (derecha) respondiendo a las mismas señales, incluida una demostración de la capacidad de razonamiento del modelo. El modelo optimizado mantiene el patrón de razonamiento del modelo original y llega a la misma conclusión, lo que demuestra que conserva intacta la capacidad de razonamiento del modelo original.

Con la velocidad superior y la eficiencia energética de los modelos DeepSeek R1 optimizados para NPU, los usuarios podrán interactuar con estos revolucionarios modelos de forma local y totalmente autónoma.

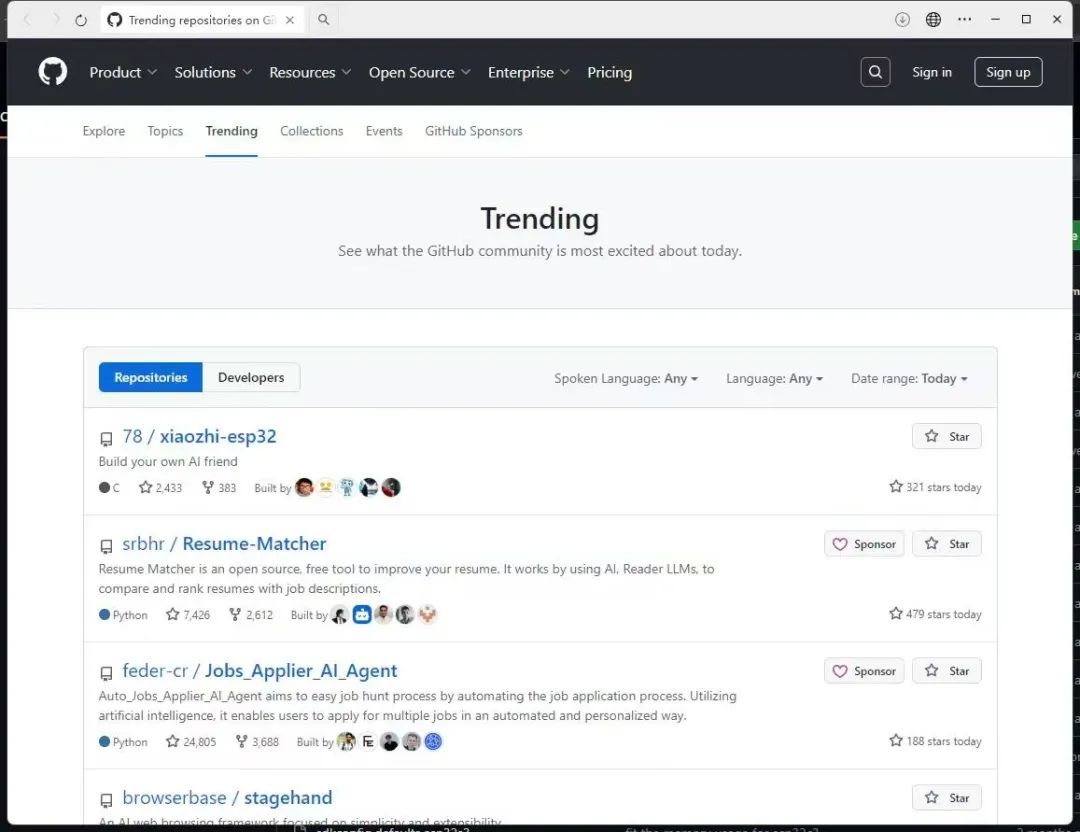

Lectura relacionada 2: "DeepSeek R1 ya está disponible en Azure AI Foundry y GitHub

DeepSeek R1 ya está disponible Azure AI Foundry y el catálogo de modelos de GitHub, uniéndose a una cartera diversa de más de 1.800 modelos que abarcan modelos de IA de vanguardia, de código abierto, específicos de la industria y orientados a tareas. Como parte de Azure AI Foundry, DeepSeek R1 es accesible a través de una plataforma de confianza, escalable y preparada para la empresa que permite a las organizaciones integrar sin problemas tecnologías avanzadas de IA al tiempo que cumplen los SLA, la seguridad y la promesa de una IA responsable, todo ello respaldado por la fiabilidad y la innovación de Microsoft. todo ello respaldado por la fiabilidad e innovación de Microsoft.

Aceleración del razonamiento de IA para desarrolladores de Azure AI Foundry

El razonamiento de IA está ganando popularidad a un ritmo alarmante, cambiando la forma en que los desarrolladores y las empresas aplican la inteligencia de vanguardia. Como explica DeepSeek, R1 proporciona modelos potentes y rentables que permiten a más usuarios acceder a las capacidades de IA más avanzadas con una inversión mínima en infraestructura.

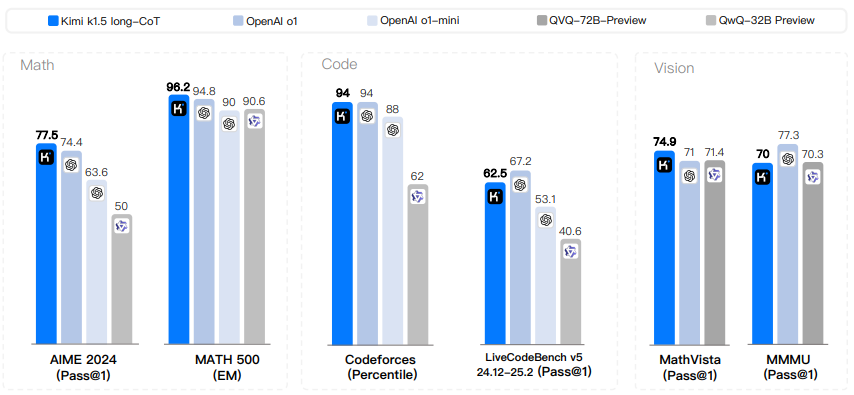

La principal ventaja de utilizar DeepSeek R1 u otros modelos en Azure AI Foundry es la velocidad a la que los desarrolladores pueden experimentar, iterar e integrar la IA en sus flujos de trabajo. Con las herramientas de evaluación de modelos integradas, los desarrolladores pueden comparar rápidamente los resultados, evaluar los puntos de referencia de rendimiento y escalar las aplicaciones basadas en IA. Este rápido acceso, inimaginable hace tan solo unos meses, está en el corazón de nuestra visión para Azure AI Foundry: reunir los mejores modelos de IA en un solo lugar, acelerando la innovación y desbloqueando nuevas posibilidades para organizaciones de todo el mundo.

Desarrollar con IA de confianza

Estamos comprometidos a ayudar a nuestros clientes a crear rápidamente aplicaciones de IA listas para la producción, manteniendo al mismo tiempo los más altos estándares de seguridad. deepSeek R1 ha superado rigurosas "pruebas de equipo rojo" y evaluaciones de seguridad, incluidas evaluaciones automatizadas del comportamiento del modelo y una revisión exhaustiva de la seguridad para mitigar los riesgos potenciales. El filtrado de contenidos integrado está habilitado por defecto con opciones de exclusión flexibles a través de Azure AI Content Security. Además, un sistema de evaluación de la seguridad ayuda a los clientes a probar eficazmente las aplicaciones antes de su despliegue. Estas salvaguardas permiten a Azure AI Foundry proporcionar a las organizaciones un entorno seguro, conforme a la normativa y responsable para desplegar soluciones de IA.

Cómo utilizar DeepSeek en un catálogo de modelos

- Si no dispone de una suscripción a Azure, ahora puedeRegístrese para obtener una cuenta Azure

- Buscar DeepSeek R1 en el catálogo de modelos

- Abra la tarjeta de modelo en el catálogo de modelos de Azure AI Foundry

- Haga clic en "Desplegar" para obtener la API de inferencia y la clave y acceder al banco de pruebas.

- En menos de un minuto accederá a la página de despliegue que muestra la API y la clave, y podrá intentar introducir los datos en el banco de pruebas.

- La API y la clave pueden utilizarse desde varios clientes

Empezar ahora

Ahora se puede acceder a DeepSeek R1 a través de un punto final sin servidor en el catálogo de modelos de Azure AI Foundry.Acceda hoy mismo a Azure AI Foundry y seleccione el modelo DeepSeek.

Explore más recursos y obtenga una guía paso a paso para integrar sin problemas DeepSeek R1 en su aplicación en GitHub. Leer Modelos GitHub Blog Post.

Próximamente: los clientes podrán ejecutar localmente en PC Copilot+ utilizando un modelo lite de DeepSeek R1. Más información Desarrollador Windows Blog Post.

A medida que continuamos ampliando el catálogo de modelos de Azure AI Foundry, esperamos ser testigos de cómo los desarrolladores y las empresas utilizan DeepSeek R1 para abordar desafíos del mundo real y crear experiencias transformadoras. Estamos comprometidos a proporcionar la cartera más completa de modelos de IA para garantizar que las organizaciones de todos los tamaños tengan acceso a herramientas de vanguardia para impulsar la innovación y el éxito".

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...