voyage-3 y voyage-3-lite: una nueva generación de pequeños pero potentes modelos de incrustación de propósito general

resúmenes - Nos complace anunciar el lanzamiento de voyage-3 responder cantando voyage-3-lite modelos integrados que han alcanzado nuevas cotas en términos de calidad de recuperación, latencia y coste.voyage-3 Mejora media del rendimiento de 7,55% con respecto a OpenAI v3 large en todos los dominios de evaluación, incluidos los contextos de código, legal, financiero, multilingüe y largo, junto con una reducción de costes de 2,2x y una reducción de 3x en las dimensiones de incrustación, lo que se traduce en una reducción de 3x en el coste de vectorDB.voyage-3-lite Mejora la precisión de la recuperación en 3,82% con respecto a OpenAI v3 large, reduce el coste en un factor de 6 y reduce la dimensionalidad de la incrustación en un factor de 6. Ambos modelos admiten contextos de 32.000 tokens, 4 veces más que OpenAI.

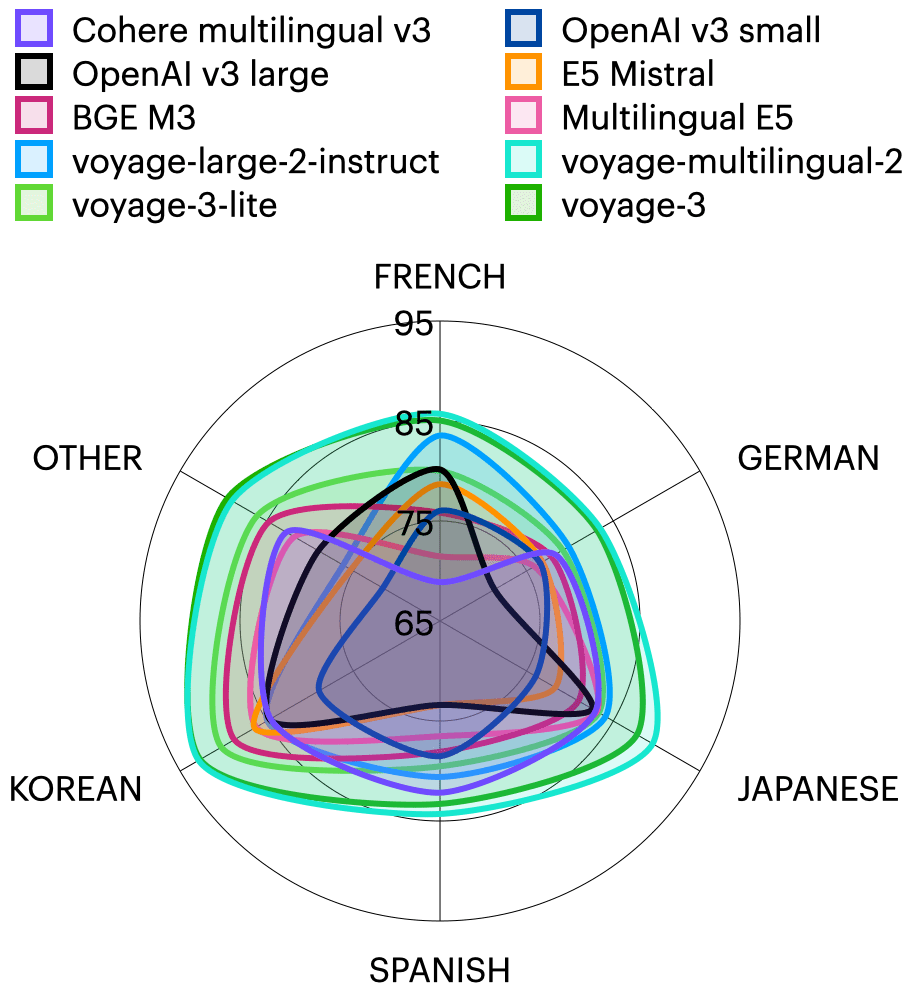

En los últimos nueve meses, hemos lanzado la serie Voyage 2 de kits de modelos empotrados, que incluyen funciones como el voyage-large-2 Estos modelos de propósito general de última generación, así como una serie de modelos específicos de dominio como voyage-code-2yvoyage-law-2yvoyage-finance-2 responder cantando voyage-multilingual-2todos estos modelos están adecuadamente entrenados con datos de sus respectivos ámbitos. Por ejemplo.voyage-multilingual-2 Excelente rendimiento en francés, alemán, japonés, español y coreano, así como el mejor rendimiento de su clase en inglés. También hemos perfeccionado el modelo para casos de uso y datos específicos de organizaciones concretas, como por ejemplo Harvey.ai del modelo de incrustación legal.

Nos complace presentar la gama Voyage 3 de modelos integrados, que incluye voyage-3 responder cantando voyage-3-litey estará disponible en unas semanas voyage-3-large. Estos modelos superan a la competencia en términos de calidad de recuperación, al tiempo que reducen significativamente el precio y el coste posterior de vectorDB. En concreto.voyage-3 Con las siguientes características:

- El rendimiento medio fue 7,55% superior al de OpenAI v3 large en los ocho dominios de evaluación (técnico, código, web, jurídico, financiero, multilingüe, protección y contexto largo).

- Cuesta 2,2x menos que OpenAI v3 grande, 2,2x menos que Cohere Inglés v3 es 1,6 veces inferior por 1 millón. fichas El coste es de $0,06.

- que OpenAI (3072) y E5 Mistral (4096) es 3-4 veces menor (1024), lo que reduce el coste de vectorDB en un factor de 3-4.

- Admite contextos de 32.000 tokens, frente a los 8.000 de OpenAI y los 512 de Cohere.

voyage-3-lite es un modelo ligero optimizado para la latencia y el bajo coste, con características como:

- El rendimiento medio en todos los dominios es 3,82% superior al de OpenAI v3 large.

- El coste es 6,5 veces inferior al de OpenAI v3 large, a $0,02 por 1 millón de tokens.

- Supera a OpenAI v3 small en 7,58% al mismo precio.

- La dimensión de incrustación es entre 6 y 8 veces menor (512) que en OpenAI (3072) y E5 Mistral (4096), lo que reduce el coste de vectorDB entre 6 y 8 veces.

- Admite contextos de 32.000 tokens, frente a los 8.000 de OpenAI y los 512 de Cohere.

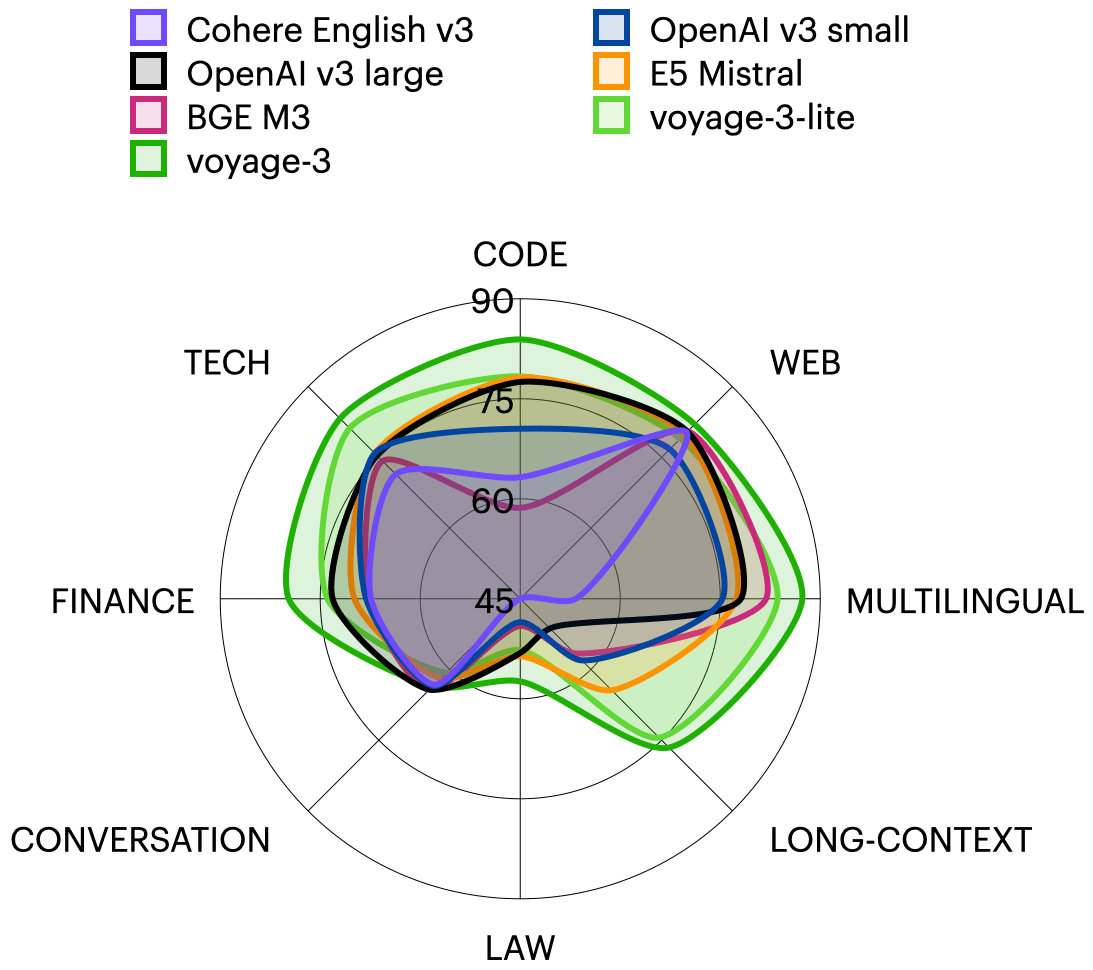

La siguiente tabla resume aspectos importantes de estos modelos y de algunos de sus competidores, y va acompañada de una representación gráfica de la relación entre calidad de recuperación y coste2 .

| modelización | dimensión (matem.) | Contexto Longitud | Coste (por millón de fichas) | Calidad de la recuperación (NDCG@10) |

|---|---|---|---|---|

| viaje-3 | 1024 | 32K | $0.06 | 76.72 |

| voyage-3-lite | 512 | 32K | $0.02 | 72.98 |

| OpenAI v3 grande | 3072 | 8K | $0.13 | 69.17 |

| OpenAI v3 pequeño | 1536 | 8K | $0.02 | 67.08 |

| Cohere Inglés v3 | 1024 | 512 | $0.10 | 59.33 |

| E5 Mistral | 4096 | 4K | $0.10 | 70.13 |

| BGE M3 | 1024 | 8K | $0.016 | 66.61 |

voyage-3 responder cantando voyage-3-lite es el resultado de una serie de innovaciones de investigación, como arquitecturas mejoradas, destilación de modelos más grandes, más de 2 billones de alta calidad Ficha de preentrenamiento, y alineación de los resultados de recuperación mediante retroalimentación humana.

testimonios. Cualquier usuario integrado genérico puede actualizarse a voyage-3 mayor calidad de búsqueda a menor coste, u optar por voyage-3-lite Más ahorro de costes. Si le preocupan especialmente las búsquedas de código, jurídicas, financieras y multilingües, la familia Voyage 2 de modelos específicos de dominio (voyage-code-2yvoyage-law-2yvoyage-finance-2 responder cantando voyage-multilingual-2) siguen siendo la mejor opción en sus respectivos campos, aunque el voyage-3 El rendimiento es también muy competitivo (véase la sección siguiente). Si ya utiliza Voyage Embedding, sólo tiene que añadir una nueva sección a la sección API de viaje La convocatoria model El parámetro se especifica como "voyage-3" tal vez "voyage-3-lite"que puede utilizarse para corpus y consultas.

Detalles de la evaluación

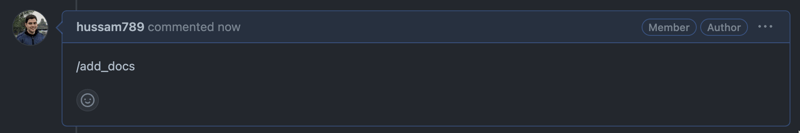

conjunto de datos. Hemos evaluado 40 conjuntos de datos de recuperación de dominios específicos que abarcan ocho ámbitos: documentos técnicos, códigos, derecho, finanzas, reseñas web, multilingües, documentos largos y diálogos. Cada conjunto de datos contiene un corpus que debe recuperarse y un conjunto de consultas. El corpus suele consistir en documentos de un dominio concreto, como respuestas de StackExchange, opiniones de tribunales, documentos técnicos, etc.; las consultas pueden ser preguntas, resúmenes de documentos largos o documentos individuales. En la tabla siguiente se enumeran los conjuntos de datos en ocho categorías, además de la multilingüe. El ámbito multilingüe abarca 62 conjuntos de datos en 26 idiomas, entre ellos francés, alemán, japonés, español, coreano, bengalí, portugués y ruso. Los cinco primeros de estos idiomas tienen múltiples conjuntos de datos, mientras que los restantes contienen un conjunto de datos por idioma y se agrupan en la categoría OTRO en el gráfico de radar multilingüe que aparece a continuación.

| formulario | descripciones | conjunto de datos |

|---|---|---|

| habilidad | documento técnico | Cohere, 5G, OneSignal, LangChain, PyTorch |

| codificación | Fragmentos de código, cadenas de documentos | LeetCodeCpp, LeetCodeJava, LeetCodePython, HumanEval, MBPP, DS1000-referenceonly, DS1000, apps_5doc |

| legislación | Casos, dictámenes judiciales, códigos, patentes | LeCaRDv2, LegalQuAD, LegalSummarisation, AILA casedocs, Estatutos del AILA |

| financiero | Registros de la SEC, control de calidad financiera | RAG benchmark (Apple-10K-2022), FinanceBench, TAT-QA, Finance Alpaca, FiQA Personal Finance, Stock News Sentiment, ConvFinQA, FinQA, HC3 Finance |

| reticulación | Comentarios, mensajes en foros, páginas de política | Huffpostsports, Huffpostscience, Doordash, Health4CA |

| contexto largo | Archivos extensos de informes gubernamentales, documentos académicos, diálogos, etc. | NarrativaQA, Aguja, Clave de acceso, QMSum, SummScreenFD, WikimQA |

| diálogos | Actas, diálogo | Diálogo Suma, QA Conv, HQA |

Encontrará una lista de todos los conjuntos de datos de evaluación en la página Esta hoja de cálculo Ver en.

modelización. Evaluamos la voyage-3 responder cantando voyage-3-liteasí como una serie de modelos alternativos, entre ellos: OpenAI v3 small (text-embedding-3-small) y grande (text-embedding-3-large), E5 Mistral (intfloat/e5-mistral-7b-instruct), BGE M3 (BAAI/bge-m3Cohere English v3.embed-english-v3.0) y voyage-large-2-instruct. Para los conjuntos de datos multilingües y específicos de un dominio, también evaluamos voyage-law-2yvoyage-finance-2yvoyage-multilingual-2Multilingüe E5.infloat/multilingual-e5-large) y Cohere multilingüe v3 (embed-multilingual-v3.0).

norma. Para la consulta, recuperamos los 10 documentos más importantes en función de la similitud coseno e indicamosGanancia acumulada actualizada normalizada(NDCG@10), que es un indicador estándar de la calidad de la recuperación y una variante del recuerdo.

al final

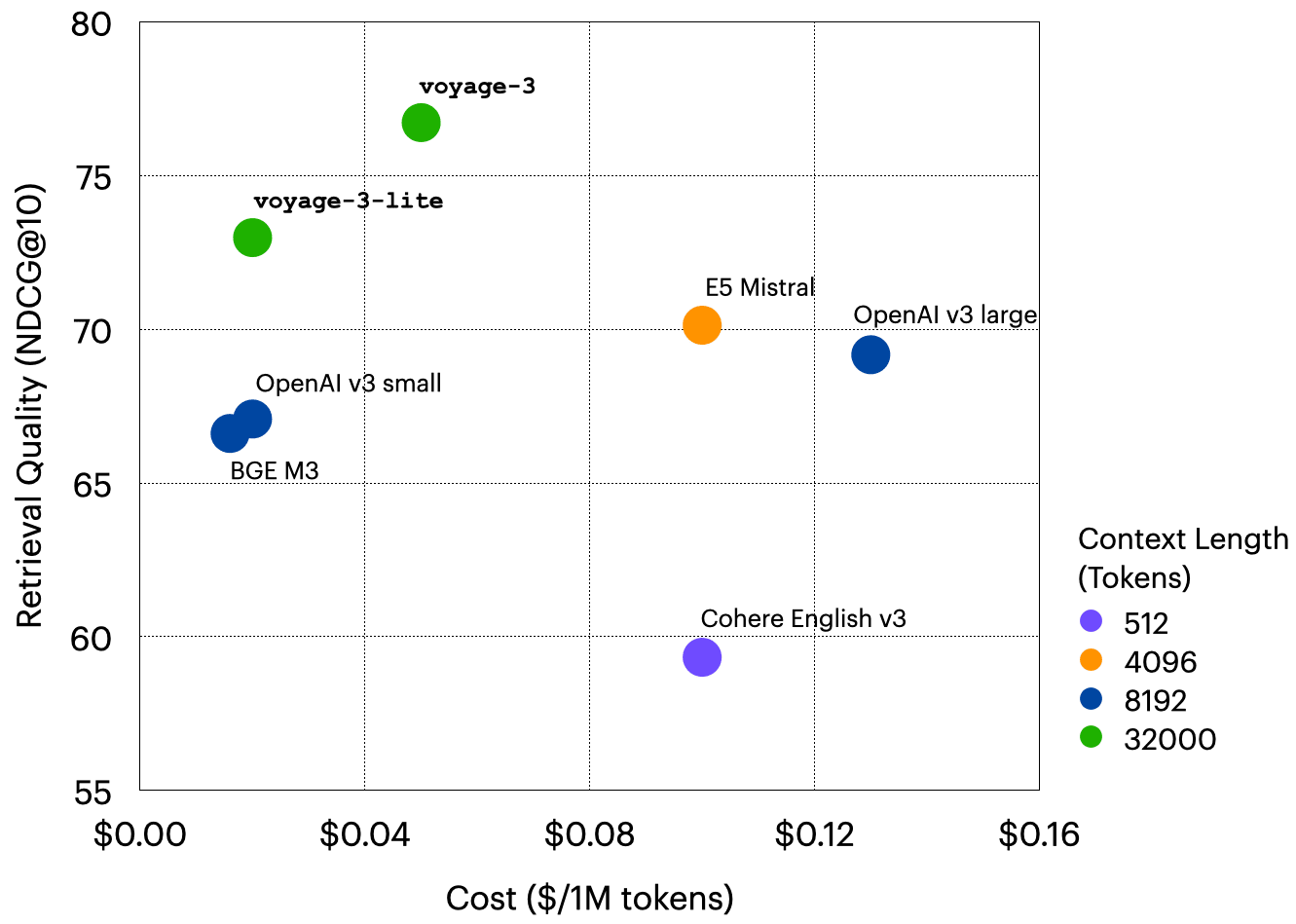

Búsqueda entre dominios. Como ya se ha mencionado, y se muestra en el primer gráfico de radar de este documento, elvoyage-3 rinde de media 7,55% mejor que OpenAI v3 large en múltiples dominios. además, como se muestra en el gráfico de barras siguiente.voyage-3 es sólo ligeramente inferior al modelo de dominio específico de Voyage.

búsqueda multilingüe. Como se muestra en el siguiente gráfico de radar.voyage-3 La calidad de la búsqueda multilingüe es sólo ligeramente inferior a la de la búsqueda voyage-multilingual-2pero con menor latencia y la mitad de coste.voyage-3-lite Supera a todos los modelos que no son Voyage en 4,55%, 3,13% y 3,89% a OpenAI v3 large, Cohere multilingüe v3 y Multilingüe E5 respectivamente.

Todos los resultados de las evaluaciones están disponibles en Esta hoja de cálculo Ver en.

Pruebe la serie Voyage 3

Pruébelo ahora voyage-3 responder cantando voyage-3-lite¡! Los primeros 200M Tokens son gratis. Vaya a nuestro Archivo (informático) Más información. Si está interesado en perfeccionar la integración, también nos encantaría conocer su opinión: póngase en contacto con nosotros en contact@voyageai.com Póngase en contacto con nosotros. Síguenos en X (Twitter) responder cantando LinkedIny únete a nuestro Discordia para más actualizaciones.

- La media de NDCG@10 para Cohere English v3 en los conjuntos de datos LAW y LONG-CONTEXT es de 33,32% y 42,48%, respectivamente. en la visualización del radargrama, redondeamos estos valores a 45%.

- E5 Mistral y BGE M3 son modelos de código abierto. Utilizamos $0,10 como coste de E5 Mistral, que se ajusta a la norma del sector para modelos paramétricos de 7B, y $0,016 para BGE M3, que se basa en el coste de Fireworks.ai para modelos paramétricos de 350M. precios Estimado.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Puestos relacionados

Sin comentarios...