El equipo de LlamaIndex presenta el modelo de recuperación visual de documentos de nueva generación vdr-2b-multi-v1

Lanzamos

vdr-2b-multi-v1Se trata del mejor modelo de incrustación multilingüe para la recuperación visual de documentos. También lo hemos publicado en inglés sencillovdr-2b-v1y el nuevovdr-multilingual-trainEste conjunto de datos contiene 500.000 muestras de alta calidad. Este conjunto de datos contiene 500.000 muestras de alta calidad y es el mayor conjunto de datos sintéticos multilingües de código abierto para la recuperación visual de documentos.

presentan con orgullo vdr-2b-multi-v1 (🤗) que es un modelo de incrustación multilingüe diseñado para la recuperación visual de documentos en múltiples idiomas y dominios. Este modelo está diseñado para codificar capturas de pantalla de páginas de documentos en representaciones unidireccionales densas, lo que permitirá de manera efectiva la búsqueda y consulta de documentos multilingües visualmente ricos sin necesidad de ningún OCR, tuberías de extracción de datos, fragmentación...

vdr-2b-multi-v1 El modelo se basa en MrLight/dse-qwen2-2b-mrl-v1 y se ha entrenado con un gran conjunto de datos multilingües de pares de consulta-imagen. Este modelo se construyó en colaboración con LlamaIndex y es mcdse-2b-v1 La próxima iteración de La siguiente iteración de nuestro vdr-2b-multi-v1 El aprendizaje y los métodos utilizados para entrenarlo se ampliaron y mejoraron, lo que dio lugar a un modelo más potente y mejor.

- En 🇮🇹 italiano, 🇪🇸 español, 🇬🇧 inglés, 🇫🇷 francés y 🇩🇪 alemán para formación: Juntos, forman un nuevo gran conjunto de datos de entrenamiento multilingüe de código abierto que contiene 500.000 muestras de alta calidad.

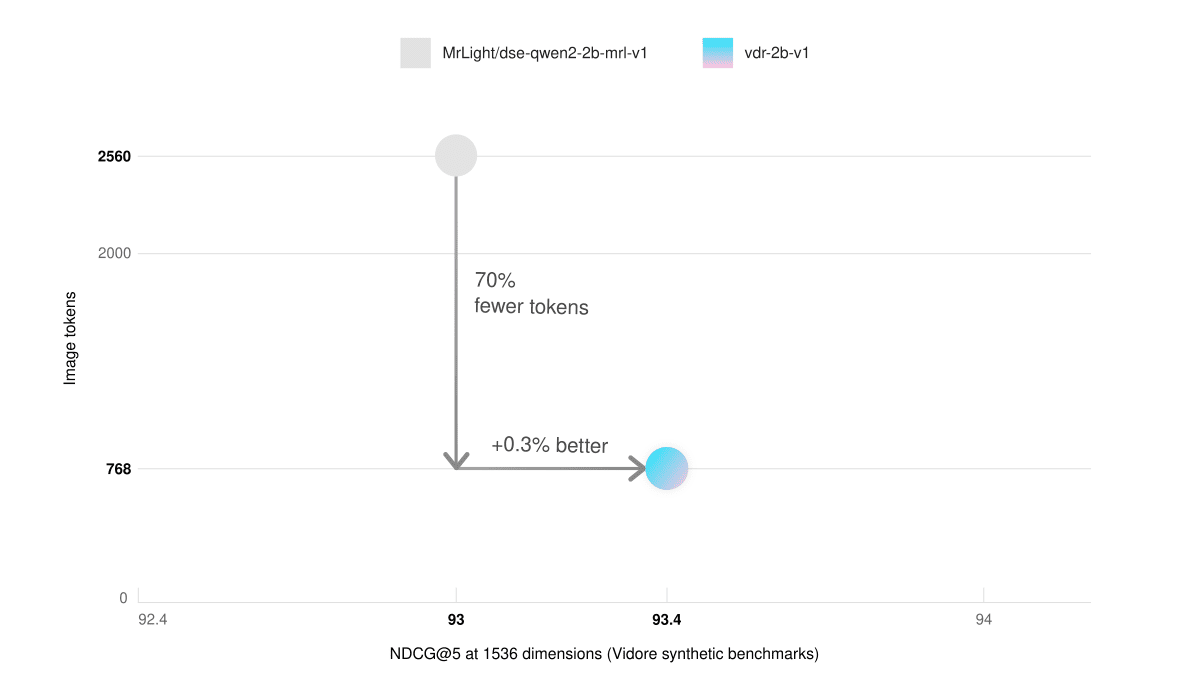

- Poca memoria de vídeo y razonamiento más rápidoEn la prueba comparativa ViDoRe (Synthetic Visual Document Retrieval), nuestro modelo de sólo inglés con 768 bloques de imágenes obtuvo mejores resultados que el modelo base con 2560 bloques de imágenes. El resultado es una inferencia 3 veces más rápida y un uso de memoria gráfica significativamente menor.

- búsqueda multilingüeEs mucho mejor en situaciones reales. Por ejemplo, puedes buscar documentos en alemán utilizando una consulta en italiano.

- La matrioska expresó su aprendizajeEl vector 98%: Puede reducir el tamaño de los vectores en un factor de 3 y mantener la calidad de incrustación del 98%. Esto puede aumentar drásticamente la velocidad de recuperación y reducir los costes de almacenamiento.

uso

🎲 ¡Pruébalo ahora!

vdr-2b-multi-v1A continuación se muestra un ejemplo del tipo de datos que se pueden encontrar en la base de datos Espacio Cara Abrazada ¡Encuéntralo!

A través de la integración directa de SentenceTransformers y LlamaIndex, utilizando la función vdr-2b-multi-v1 Generar incrustaciones es más fácil que nunca. Empieza con unas pocas líneas de código:

Vía LlamaIndex

pip install -U llama-index-embeddings-huggingface

from llama_index.embeddings.huggingface import HuggingFaceEmbedding

model = HuggingFaceEmbedding(

model_name="llamaindex/vdr-2b-multi-v1",

device="cpu", # "mps" for mac, "cuda" for nvidia GPUs

trust_remote_code=True,

)

image_embedding = model.get_image_embedding("image.png")

query_embedding = model.get_query_embedding("Chi ha inventato Bitcoin?")

vía SentenceTransformers

from sentence_transformers import SentenceTransformer

model = SentenceTransformer(

model_name_or_path="llamaindex/vdr-2b-multi-v1",

device="cuda",

trust_remote_code=True,

# These are the recommended kwargs for the model, but change them as needed if you don't have CUDA

model_kwargs={

"torch_dtype": torch.bfloat16,

"device_map": "cuda:0",

"attn_implementation": "flash_attention_2"

},

)

embeddings = model.encode("image.png")

Conjunto de datos de formación

El entrenamiento de buenos modelos unidireccionales para la recuperación de documentos visuales requiere datos de alta calidad, pero los actuales conjuntos de datos multimodales disponibles son escasos y no multilingües.

Por ello, hemos invertido mucho tiempo en construirlo desde cero. El conjunto de datos original contiene 500.000 muestras multilingües de imágenes de consulta recopiladas y generadas a partir de PDF públicos de Internet. La consulta asociada a cada imagen se generó sintéticamente mediante Visual Language Modelling (VLM). A modo de comparación, nuestro conjunto de datos es mucho mayor que el mayor conjunto de datos sintéticos de código abierto para la recuperación de documentos visuales multimodales (es decir, el archivo Conjunto de datos de formación ColPali (documentos descartados generados) 10 veces más muestras.

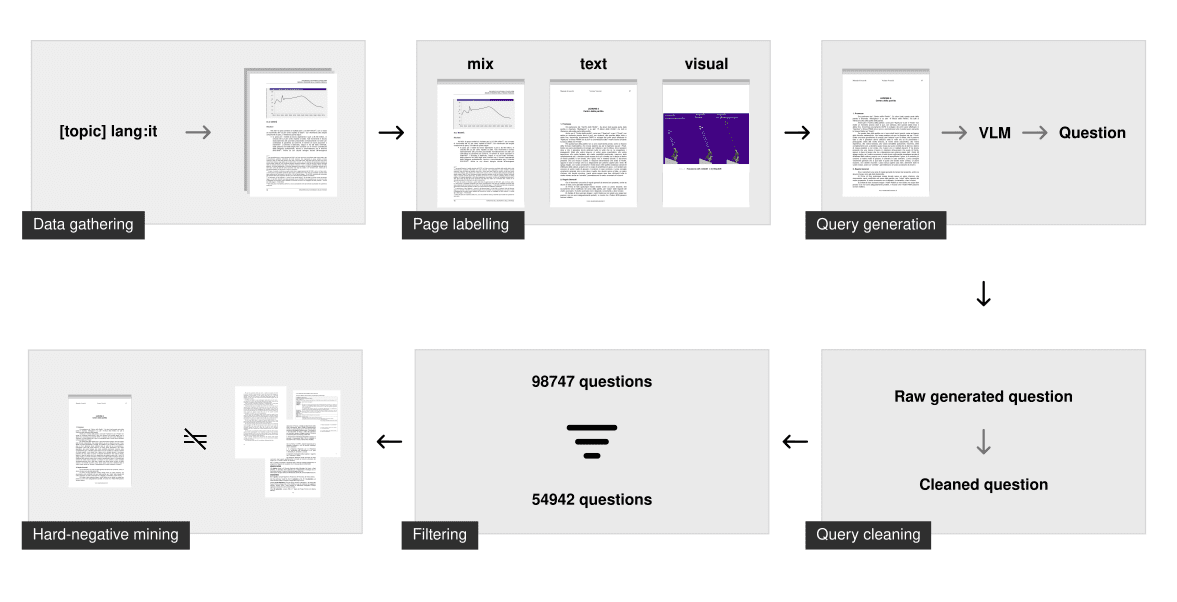

Recogida de datos

Para cada idioma, generamos una larga lista de consultas que abarcan muchos temas diferentes y que luego utilizamos para buscar PDF. Utilizamos las funciones de filtrado por idioma del motor de búsqueda para rastrear sólo los documentos en el idioma especificado. Esta técnica de "búsqueda por temas" garantiza que el modelo haya visto muchos temas y dominios diferentes y funcione bien en situaciones reales.

El proceso de rastreo dio como resultado unos 50.000 documentos multilingües. En comparación con el mcdse-2b-v1 A diferencia del enfoque utilizado en el modelo, las páginas no se extraen aleatoriamente. En su lugar, cada página de cada PDF se somete al modelo de análisis de diseño de documentos para determinar si contiene más elementos textuales o visuales. El resultado es un número que clasifica la página como sólo texto, sólo visual o una mezcla. A continuación, se tomaron muestras de aproximadamente 100.000 páginas utilizando este paso de marcado para garantizar que estaban distribuidas uniformemente por tipo de página.

generación sintética

A continuación, se generaron consultas con gemini-1.5-pro y Qwen2-VL-72B. La tarea consiste en plantear una pregunta específica y otra general. Para entrenar el modelo sólo se utiliza la pregunta específica, pero obligar a los modelos de lenguaje amplio (LLM) a distinguir entre ambas suele dar lugar a preguntas específicas más potentes para el entrenamiento en recuperación de información.

Una vez generado, otros pasos de limpieza garantizan que el problema sea suficiente para la formación. Esto incluye:

- Asegúrese de que el idioma es correcto

- Corrección de problemas de formato

- Borrar reducción

- Asegúrese de que sólo se formula una pregunta

- Eliminar frases base (por ejemplo, "según la Figura 1", "este documento", ...)

Filtrado y extracción de casos negativos duros

Este paso de limpieza garantiza que la consulta sea sintácticamente correcta y siga unas pautas estrictas. Sin embargo, no garantiza que la consulta sea suficiente para recuperar información.

Para filtrar las preguntas erróneas, incrustamos e indexamos cada consulta amplia utilizando el modelo de incrustación voyage-3. Para cada pregunta específica, buscamos en el índice. Si la pregunta general aparece entre los 100 primeros resultados, la consulta se considera "buena". Este método elimina las preguntas con baja entropía, duplicadas o demasiado similares. Por término medio, se eliminaron 40% consultas de cada conjunto de datos lingüísticos.

A continuación, se extrajeron los ejemplos negativos duros utilizando voyage-3 sólo en problemas específicos con un umbral fijo de 0,75. También se utilizó como nvidia/NV-Retriever-v1 Se realizaron experimentos con la minería de casos negativos consciente de los casos positivos como se describe en , pero en este conjunto de datos parece producir casos negativos demasiado fáciles/distantes.

descargando

(vdr-multilingual-train 🤗) El conjunto de datos de entrenamiento es ahora de código abierto y está disponible directamente en Hugging Face. El conjunto de datos de entrenamiento contiene 496.167 páginas PDF, de las cuales sólo 280.679 están asociadas a una consulta filtrada (utilizando el método descrito anteriormente). El resto de imágenes sin consulta se siguen utilizando como ejemplos negativos duros.

| multilingüismo | # Consultas filtradas | # Consultas sin filtrar |

|---|---|---|

| Inglés (lengua) | 53,512 | 94,225 |

| Lengua española | 58,738 | 102,685 |

| Italiano (lengua) | 54,942 | 98,747 |

| Alemán (lengua) | 58,217 | 100,713 |

| Francés (lengua) | 55,270 | 99,797 |

| total (general) | 280,679 | 496,167 |

El conjunto de datos consta de 5 subconjuntos diferentes, cada uno correspondiente a una lengua. Puede consultarlo directamente aquí:

El conjunto de datos consta de 5 subconjuntos diferentes, cada uno correspondiente a una lengua. Puede explorarlo directamente aquí:

Como alternativa, puede añadir el load_dataset Especifique el subconjunto de idiomas en el que desea descargar los idiomas individualmente:

from datasets import load_dataset

italian_dataset = load_dataset("llamaindex/vdr-multilingual-train", "it", split="train")

english_dataset = load_dataset("llamaindex/vdr-multilingual-train", "en", split="train")

french_dataset = load_dataset("llamaindex/vdr-multilingual-train", "fr", split="train")

german_dataset = load_dataset("llamaindex/vdr-multilingual-train", "de", split="train")

spanish_dataset = load_dataset("llamaindex/vdr-multilingual-train", "es", split="train")

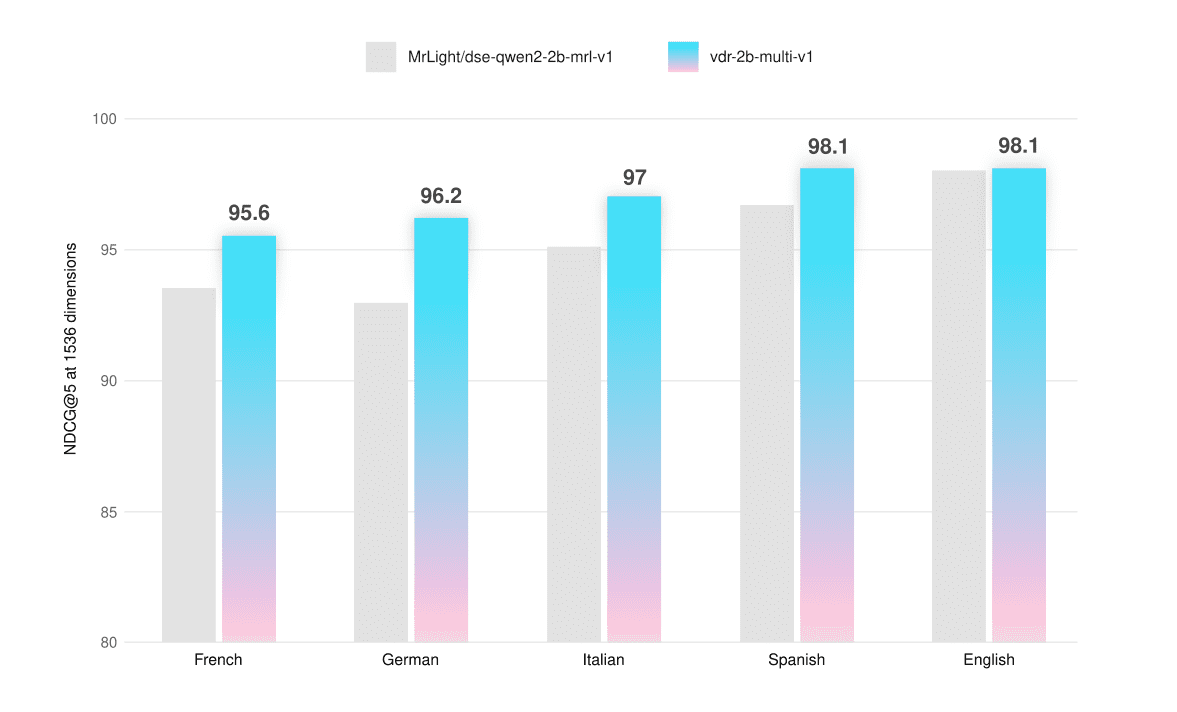

valoración

El modelo se ha evaluado con parámetros de referencia ViDoRe y conjuntos de evaluación personalizados que permiten probar su funcionalidad multilingüe en capturas de pantalla de páginas sólo de texto, sólo visuales e híbridas. El conjunto de datos de evaluación también está disponible públicamente en Hugging Face (vdr-multilingual-test 🤗).

Nos aseguramos de que ninguna página de estos conjuntos de datos apareciera en el conjunto de entrenamiento para evitar cualquier contaminación en la evaluación. Estos conjuntos de datos se recopilaron y generaron de la misma forma que los de entrenamiento, pero con muestras más pequeñas. Todos los pasos de filtrado se realizaron manualmente: cada consulta se evaluó, cotejó y refinó (si era necesario) para garantizar datos de alta calidad.

Todas las evaluaciones se realizaron mediante el uso de 1536 ViVectores y puede utilizarse con Hasta 768 fichas La resolución de la imagen representada para calcular el NDCG@5 Partitura a interpretar.

| de media | Francés (texto) | Francés (visual) | Francés (mixto) | |

|---|---|---|---|---|

| dse-qwen2-2b-mrl-v1 | 93.5 | 94.7 | 90.8 | 95.1 |

| vdr-2b-multi-v1 | 95.6 | 95.6 | 93.3 | 97.9 |

| +2.2% |

| de media | Alemán (texto) | Alemán (visual) | Alemán (mixto) | |

|---|---|---|---|---|

| dse-qwen2-2b-mrl-v1 | 93.0 | 93.4 | 90.0 | 95.5 |

| vdr-2b-multi-v1 | 96.2 | 94.8 | 95.7 | 98.1 |

| +3.4% |

| de media | Italiano (texto) | Italiano (visual) | Italiano (mixto) | |

|---|---|---|---|---|

| dse-qwen2-2b-mrl-v1 | 95.1 | 95.1 | 94.0 | 96.2 |

| vdr-2b-multi-v1 | 97.0 | 96.4 | 96.3 | 98.4 |

| +2% |

| de media | Español (texto) | Español (visual) | Español (mixto) | |

|---|---|---|---|---|

| dse-qwen2-2b-mrl-v1 | 96.7 | 97.2 | 94.7 | 98.2 |

| vdr-2b-multi-v1 | 98.1 | 98.3 | 96.9 | 99.1 |

| +1.4% |

| de media | Inglés (texto) | Inglés (Visual) | Inglés (mixto) | |

|---|---|---|---|---|

| dse-qwen2-2b-mrl-v1 | 98.0 | 98.3 | 98.5 | 97.1 |

| vdr-2b-multi-v1 | 98.1 | 97.9 | 99.1 | 97.3 |

| +0.1% |

El modelo multilingüe supera al modelo básico en todos los idiomas y tipos de página, con una mejora media de +2,31 TP3T. También obtiene resultados ligeramente mejores en la prueba ViDoRe (+0,51 TP3T). Hemos ajustado el vdr-2b-multi-v1 Se han logrado enormes aumentos de rendimiento, especialmente en las páginas no inglesas puramente visuales o híbridas. Véase, por ejemplo, que la recuperación puramente visual en alemán mejora NDCG@5 en +6,33% en comparación con el modelo base.

También entrenamos una versión con un subconjunto del inglés (vdr-2b-v1 🤗). En la prueba comparativa ViDoRe completa (con 768 imágenes) Ficha (para la evaluación), tanto la versión multilingüe como la versión en inglés superan al modelo base.

| de media | cambiarproyecto | gobierno | sanidad | energía | ai | docvqa | arxivqa | tatdqa | infovqa | tabfquad | |

|---|---|---|---|---|---|---|---|---|---|---|---|

| dse-qwen2-2b-mrl-v1 | 83.6 | 79.8 | 95.7 | 96.9 | 92.0 | 98.2 | 56.3 | 85.2 | 53.9 | 87.5 | 90.3 |

| vdr-2b-multi-v1 | 84.0 | 82.4 | 95.5 | 96.5 | 91.2 | 98.5 | 58.5 | 84.7 | 53.6 | 87.1 | 92.2 |

| vdr-2b-v1 | 84.3 | 83.4 | 96.9 | 97.2 | 92.6 | 96.8 | 57.4 | 85.1 | 54.1 | 87.9 | 91.3 |

Razonamiento más rápido

inglés sencillo vdr-2b-v1 El modelo también iguala el rendimiento del modelo base en el conjunto de datos sintéticos de referencia ViDoRe utilizando sólo 30% de imagen Token (768 frente a 2560). Esto multiplica por 3 la velocidad de inferencia y reduce significativamente el uso de memoria gráfica.

| de media | cambiarproyecto | gobierno | sanidad | energía | ai | |

|---|---|---|---|---|---|---|

| dse-qwen2-2b-mrl-v1 (Token de imagen 2560) | 93.0 | 82 | 96 | 96.4 | 92.9 | 97.5 |

| vdr-2b-v1 (ficha de imagen 768) | 93.4 | 83.4 | 96.9 | 97.2 | 92.6 | 96.8 |

búsqueda multilingüe

Aunque el modelo se entrenó en cada idioma por separado, también ha mejorado en la recuperación interlingüística. Para probar esta capacidad, las consultas del conjunto de evaluación en alemán se tradujeron al italiano utilizando DeepL. Las capturas de pantalla de las páginas de documentación se conservan en el alemán original.

| de media | Italiano -> Alemán (texto) | Italiano -> Alemán (visual) | Italiano -> Alemán (mixto) | |

|---|---|---|---|---|

| dse-qwen2-2b-mrl-v1 | 93.1 | 92.6 | 93.5 | 93.3 |

| vdr-2b-multi-v1 | 95.3 | 95.0 | 95.8 | 95.1 |

| +2.3% |

El modelo obtiene resultados significativamente mejores en todos los tipos de documentos, con una mejora media de +2,31 TP3T.Estas capacidades de búsqueda son fundamentales para casos de uso en el mundo real, especialmente en regiones lingüísticamente dispersas como Europa. Por ejemplo, permite realizar búsquedas independientes del idioma en fuentes multilingües complejas, como decisiones vinculantes europeas, manuales de instrucciones, KID de activos financieros, prospectos farmacéuticos, etc.

MRL e incrustación binaria

Este modelo se entrena mediante el aprendizaje de representaciones Matryoshka (MRL). La función de pérdida utilizada durante el entrenamiento se calibra para realizar un seguimiento del rendimiento en todas estas dimensiones, lo que permite precargar el modelo con la información de reconocimiento más importante. Esto permite reducir eficazmente las dimensiones de incrustación en función del tamaño y el presupuesto. Para obtener más información sobre MRL, visite la página web de Hugging FaceEsta entrada del blogSe dio una buena explicación al respecto.

Para comprobar la capacidad de recuperación del modelo en distintas dimensiones vectoriales, se evaluó en la prueba comparativa interlingüística italiano -> alemán.

NDCG@5 (coma flotante)

| de media | Italiano -> Alemán (texto) | Italiano -> Alemán (visual) | Italiano -> Alemán (mixto) | |

|---|---|---|---|---|

| 1536 Vi | ||||

| dse-qwen2-2b-mrl-v1 | 93.1 | 92.6 | 93.5 | 93.3 |

| vdr-2b-multi-v1 | 95.3 | 95.0 | 95.9 | 95.1 |

| +2.3% | ||||

| 1024 V | ||||

| dse-qwen2-2b-mrl-v1 | 92.2 | 90.9 | 92.3 | 93.5 |

| vdr-2b-multi-v1 | 94.6 | 93.1 | 95.7 | 95.1 |

| +2.5% | ||||

| 512 Vi | ||||

| dse-qwen2-2b-mrl-v1 | 89.8 | 87.9 | 89.4 | 92.2 |

| vdr-2b-multi-v1 | 93.0 | 91.1 | 93.4 | 94.5 |

| +3.4% |

NDCG@5 (binario)

| de media | Italiano -> Alemán (texto) | Italiano -> Alemán (visual) | Italiano -> Alemán (mixto) | |

|---|---|---|---|---|

| 1536 Vi | ||||

| dse-qwen2-2b-mrl-v1 | 89.8 | 88.2 | 90.3 | 90.8 |

| vdr-2b-multi-v1 | 92.3 | 89.6 | 94.1 | 93.3 |

| +2.8% | ||||

| 1024 V | ||||

| dse-qwen2-2b-mrl-v1 | 86.7 | 84.9 | 88.2 | 86.9 |

| vdr-2b-multi-v1 | 90.8 | 87.0 | 92.6 | 92.8 |

| +4.6% | ||||

| 512 Vi | ||||

| dse-qwen2-2b-mrl-v1 | 79.2 | 80.6 | 81.7 | 75.4 |

| vdr-2b-multi-v1 | 82.6 | 77.7 | 86.7 | 83.3 |

| +4.0% |

Los vectores de coma flotante de 1024 dimensiones ofrecen un muy buen equilibrio entre calidad y tamaño. Son unos 301 TP3T más pequeños, pero conservan el rendimiento de recuperación de 991 TP3T. Lo mismo ocurre con los vectores binarios de 1536 dimensiones, que tienen 10 veces menos bytes por vector, pero conservan la calidad de recuperación de 971 TP3T. Curiosamente, los 1536 vectores binarios casi igualan el rendimiento de los 1536 vectores en coma flotante del modelo base.

Conclusiones y próximos pasos

Creemos que vdr-2b-multi-v1 responder cantando vdr-2b-v1 resultará útil a muchos usuarios.

Nuestro modelo multilingüe es el primero de su clase, ya que mejora significativamente el rendimiento en situaciones multilingües e interlingüísticas y, gracias al MRL y a la cuantificación binaria, la recuperación es más eficiente y rápida que nunca. Creemos que esto abrirá nuevos casos de uso y oportunidades, especialmente en regiones lingüísticamente dispersas como Europa.

Su versión en inglés representa una importante mejora del modelo subyacente, que ahora permite incrustar documentos 3 veces más rápido, al tiempo que reduce la memoria y mantiene la misma (o mejor) calidad de búsqueda.

Todo gracias al nuevo vdr-multilingual-train Este conjunto de datos contiene 500.000 muestras de alta calidad. Este conjunto de datos contiene 500.000 muestras de alta calidad y es el mayor conjunto de datos sintéticos multilingües de código abierto para la recuperación visual de documentos.

En el futuro se estudiará cómo funciona nuestro modelo cuando se adapta a ámbitos nuevos y específicos. Todavía estamos en las primeras fases de desarrollo y es necesario seguir trabajando antes de publicar los resultados, pero las primeras pruebas parecen haber demostrado que tomar lamuchoCon menos datos y recursos informáticos se obtienen ganancias impresionantes.

Esté atento a futuras actualizaciones.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...