UltraLight Digital Human: humano digital ultraligero de código abierto que funciona en tiempo real y se instala con un solo clic.

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 59.1K 00

Introducción general

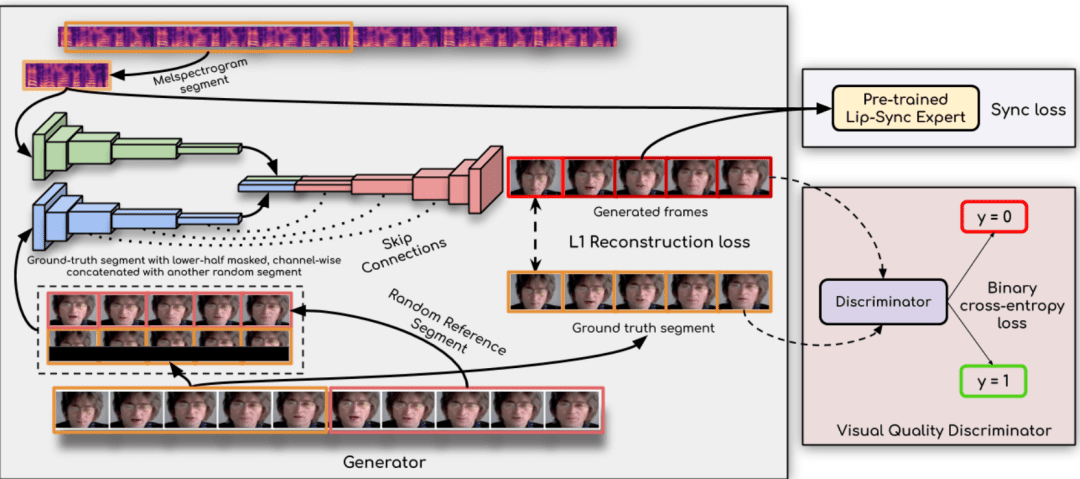

Ultralight Digital Human es un proyecto de código abierto cuyo objetivo es desarrollar un modelo humano digital ultraligero que pueda ejecutarse en tiempo real en dispositivos móviles. El proyecto consigue un funcionamiento fluido en dispositivos móviles mediante la optimización de algoritmos y estructuras de modelos para diversos escenarios, como aplicaciones sociales, juegos y realidad virtual. Los usuarios pueden entrenar y desplegar fácilmente sus propios modelos humanos digitales para disfrutar de experiencias personalizadas e inmersivas.

En cuanto a que funciona bien en el móvil, sólo tienes que cambiar el número de canales de este modelo actual un poco más pequeño y utilizar wenet para las funciones de audio y estarás bien.

Lista de funciones

- funcionamiento en tiempo realLos modelos pueden funcionar en tiempo real en dispositivos móviles y tienen capacidad de respuesta.

- Diseño ligeroEstructura de modelo optimizada para dispositivos móviles con recursos limitados.

- proyecto de código abiertoEl código y el modelo son de código abierto y los usuarios pueden modificarlos y utilizarlos libremente.

- aplicación multiescenario: Adecuado para una gran variedad de escenarios, como aplicaciones sociales, juegos, realidad virtual y mucho más.

- Extracción de características de audio: Admite los esquemas de extracción de características de audio wenet y hubert.

- red síncrona: Sincronización labial mejorada con tecnología syncnet.

- Tutorial detallado: Se proporcionan tutoriales detallados de formación y uso para ayudar a los usuarios a iniciarse rápidamente.

Utilizar la ayuda

Proceso de instalación

- Preparación medioambiental::

- Instale Python 3.10 y superior.

- Instale PyTorch 1.13.1 y otras dependencias:

conda create -n dh python=3.10 conda activate dh conda install pytorch==1.13.1 torchvision==0.14.1 torchaudio==0.13.1 pytorch-cuda=11.7 -c pytorch -c nvidia conda install mkl=2024.0 pip install opencv-python transformers numpy==1.23.5 soundfile librosa onnxruntime

- Descargar modelos::

- Descargue el archivo wenet encoder.onnx del siguiente enlace y colóquelo en la carpeta

data_utils/Catálogo: enlace de descarga

- Descargue el archivo wenet encoder.onnx del siguiente enlace y colóquelo en la carpeta

Proceso de utilización

- Preparar el vídeo::

- Prepara un vídeo de entre 3 y 5 minutos, asegurándote de que cada fotograma tiene una exposición facial completa y de que el sonido es claro y sin ruidos.

- Coloca el vídeo en una carpeta nueva.

- Extracción de características de audio::

- Utilice los siguientes comandos para extraer características de audio:

cd data_utils python process.py YOUR_VIDEO_PATH --asr hubert

- Utilice los siguientes comandos para extraer características de audio:

- Modelos de formación::

- Entrene el modelo syncnet para obtener mejores resultados:

cd .. python syncnet.py --save_dir ./syncnet_ckpt/ --dataset_dir ./data_dir/ --asr hubert - Entrene el modelo humano digital utilizando el punto de control de menor pérdida:

python train.py --dataset_dir ./data_dir/ --save_dir ./checkpoint/ --asr hubert --use_syncnet --syncnet_checkpoint syncnet_ckpt

- Entrene el modelo syncnet para obtener mejores resultados:

- inferencia::

- Extracción de características de audio de prueba:

python extract_test_audio.py YOUR_TEST_AUDIO_PATH --asr hubert - Razonamiento de carrera:

python inference.py --dataset ./data_dir/ --audio_feat ./your_test_audio_hu.npy --save_path ./output.mp4 --checkpoint ./checkpoint/best_model.pth

- Extracción de características de audio de prueba:

advertencia

- Asegúrate de que la frecuencia de imagen del vídeo coincide con el esquema de extracción de características de audio elegido: 20 fps para wenet y 25 fps para hubert.

- Durante el proceso de formación e inferencia, se controla periódicamente el valor de pérdida del modelo y se selecciona el punto de control óptimo para la formación.

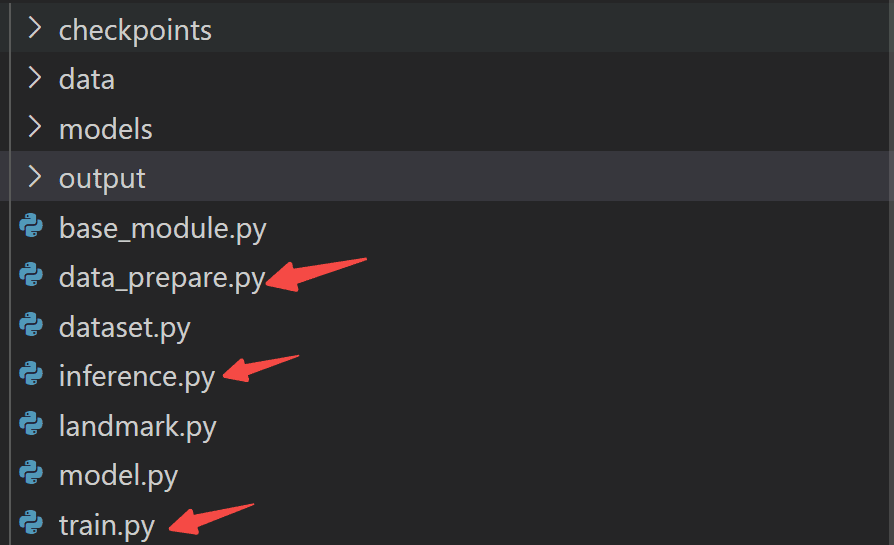

Paquete de integración Monkey One Click

https://pan.baidu.com/s/19DcRlR0kJVg4bLb7snUrBQ?pwd=tct1

Para su comodidad práctica, he consolidado y encapsulado el proceso anterior (Incluye pesos del modelo y casos de prueba):

Sólo tienes que hacer el tonto:

paso 0: Instalar las dependencias:

conda create -n udh python=3.10 conda activate udh pip install -r requirements.txt

paso 1: preparación de los datos:

python data_prepare.py

PASO 2: Formación de modelos:

python train.py

PASO 3: Modelización del razonamiento:

python inference.py

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...