Curso gratuito sobre el funcionamiento de los Transformer LLM, por Enda Wu

Últimos recursos sobre IAPublicado hace 6 meses Círculo de intercambio de inteligencia artificial 45.4K 01

¿Cómo funcionan los LLM transformadores?

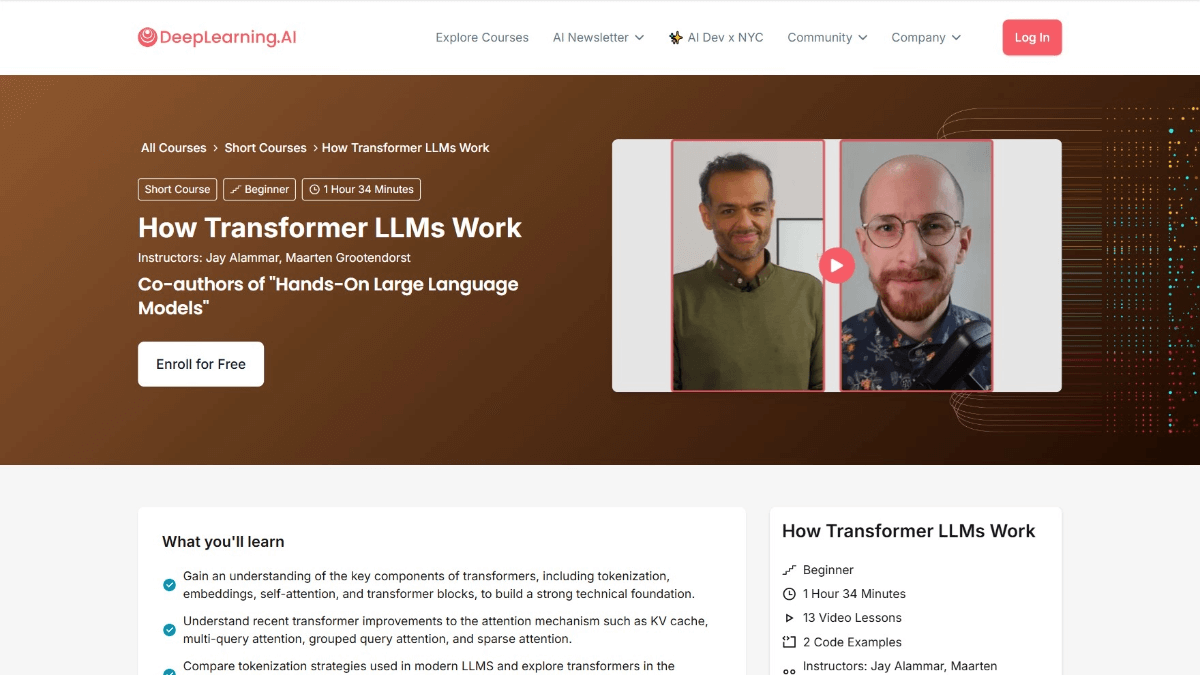

Transformador Cómo funcionan los LLM es un curso de DeepLearning.AI en colaboración con Jay Alammar y Maarten Grootendorst, autores de Hands-On Large Language Models. El curso proporciona una visión en profundidad de la arquitectura Transformer que soporta los Modelos de Lenguaje de Gran Tamaño (LLMs). El curso comienza con la evolución de la representación numérica de los lenguajes y cubre temas como la desambiguación, el mecanismo de atención y la capa feedforward de los bloques Transformer, y cómo mejorar el rendimiento mediante el almacenamiento en caché de los cálculos. Tras completar el curso, los usuarios comprenderán en profundidad cómo procesan los LLM los lenguajes, serán capaces de leer y comprender artículos relevantes y mejorarán su capacidad para construir aplicaciones LLM.

Objetivos del curso Cómo funcionan los transformadores LLM

- Comprender la evolución de la representación numérica del lenguajeComprender cómo se representa digitalmente el lenguaje, desde sencillos modelos de bolsa de palabras hasta complejas arquitecturas de transformadores.

- Dominar el tratamiento de los participiosAprender a descomponer el texto de entrada en "tokens" y comprender cómo se introducen los tokens en el modelo lingüístico.

- Sumergirse en la arquitectura de los transformadoresSe estudian en detalle las tres fases principales de la arquitectura Transformer: desambiguación e incrustación, apilamiento de bloques Transformer y cabeceras de modelos lingüísticos.

- Comprender los detalles del bloque Transformador: Incluye los mecanismos de atención y las capas feedforward, y cómo funcionan conjuntamente para procesar y generar texto.

- Optimización del rendimiento del aprendizajeAprende a mejorar el rendimiento de Transformer mediante técnicas como la computación en caché.

- Aplicación práctica Exploración: Exploración de recientes implementaciones de modelos para mejorar las aplicaciones prácticas mediante la biblioteca Hugging Face Transformer.

Esquema del curso sobre el funcionamiento de los transformadores LLM

- Visión general de los LLM de transformadorIntroducción a los objetivos del curso, la estructura y la importancia de la arquitectura Transformer en el contexto de los grandes modelos lingüísticos (LLM) modernos.

- Evolución de la representación lingüísticaUna mirada a la evolución del modelado del lenguaje desde Bag-of-Words a Word2Vec y a la arquitectura Transformer.

- participio e incrustaciónAprender cómo se descompone un texto de entrada en tokens y cómo convertir tokens en vectores de incrustación, incluida la aplicación de la codificación posicional.

- Bloque transformador: Comprender la estructura del bloque Transformador, incluido el mecanismo de autoatención y el papel de las redes feed-forward.

- Atención prolongadaExplora cómo los mecanismos atencionales multicabezales pueden mejorar el rendimiento del modelo captando diferentes aspectos de la entrada a través de múltiples "cabezas".

- Apilamiento de bloques de transformadoresAprenda a construir modelos profundos apilando varios bloques Transformer, así como el papel de la vinculación residual y la normalización de capas.

- Cabecera del modelo lingüísticoComprender cómo Transformer implementa la generación de texto generando la distribución de probabilidad del siguiente token a partir del encabezado del modelo de lenguaje.

- mecanismo de almacenamiento en cachéAprende a mejorar la velocidad de inferencia de los modelos Transformer a través de mecanismos de almacenamiento en caché, y aplicaciones prácticas del almacenamiento en caché.

- Últimas innovaciones arquitectónicas: Presenta las últimas innovaciones en Mezcla de Expertos (MoE) y otras arquitecturas de Transformadores.

- Implementación del Transformador con Cara de AbrazoAprende a cargar y ajustar modelos Transformer preentrenados con la biblioteca Hugging Face Transformers.

- Codificación práctica de TransformerAprende a implementar los componentes clave del Transformer y a construir modelos simples de Transformer a través de ejercicios prácticos de codificación.

- Trabajo de investigación sobre lectura y comprensión: Aprenda a leer y comprender los trabajos de investigación relacionados con los transformadores, analizando los trabajos recientes y sus aportaciones al campo.

- Creación de solicitudes LLM: Explora cómo desarrollar aplicaciones basadas en LLM y discute futuras direcciones y aplicaciones potenciales de la arquitectura Transformer.

Dirección del curso para saber cómo funciona el LLM Transformador

- Dirección del curso::DeepLearning.AI

Para quién trabajan los LLM de Transformer

- investigador en procesamiento del lenguaje natural (PLN)Estudio en profundidad de la arquitectura Transformer, explorando aplicaciones punteras en los campos de la comprensión, generación y traducción del lenguaje, y promoviendo el desarrollo de la tecnología de procesamiento del lenguaje natural.

- Ingeniero de aprendizaje automáticoDominar el funcionamiento de Transformer para poder optimizar el rendimiento de los modelos, mejorar su precisión y eficacia y desarrollar aplicaciones de modelos lingüísticos más potentes.

- científico de datos: Procesamiento y análisis de datos de texto a gran escala con la arquitectura Transformer, extrayendo de los datos patrones e información para apoyar la toma de decisiones.

- desarrollador de software: Integre los LLM de Transformer en diversas aplicaciones de software, como chatbots, sistemas de recomendación de contenidos, etc., para mejorar la inteligencia de producto.

- Entusiastas de la inteligencia artificialInteresado en la arquitectura Transformer y con ganas de aprender cómo funciona, profundizar en el conocimiento de la tecnología de IA y ampliar sus horizontes técnicos.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...