Together: una plataforma en la nube para construir y ejecutar plataformas de entrenamiento de modelos generativos de IA

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 72.2K 00

Introducción general

Together AI es una plataforma centrada en modelos generativos de IA, que ofrece una gama completa de servicios que van desde la formación de modelos y el ajuste fino hasta la inferencia. Los usuarios pueden aprovechar el motor de inferencia de alta eficiencia de Together AI y los clústeres de GPU para desplegar y ejecutar rápidamente una variedad de modelos de código abierto. La plataforma admite múltiples arquitecturas de modelos para satisfacer los distintos requisitos de las aplicaciones de IA.

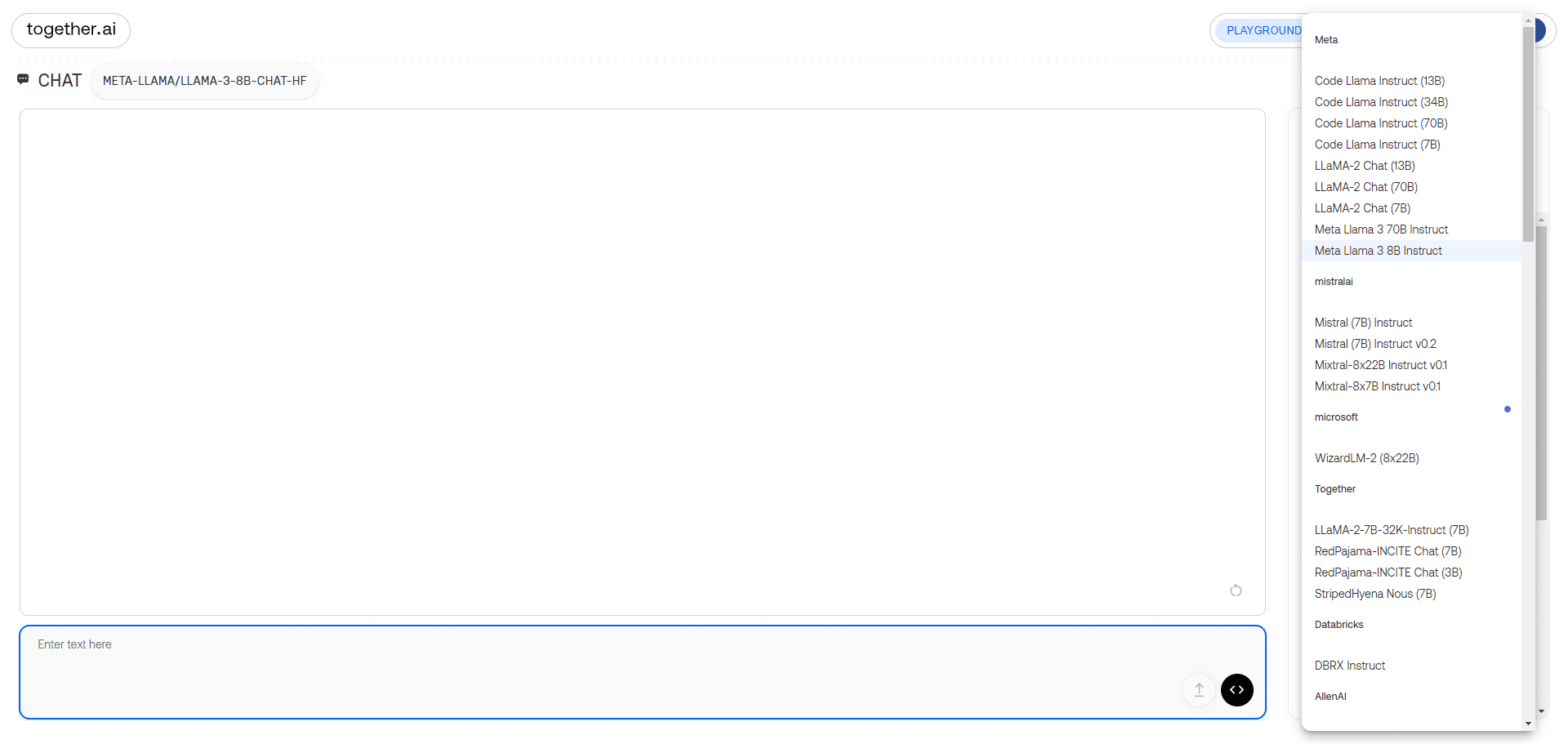

Interfaz de demostración del chat de modelos grandes

Lista de funciones

- API de inferencia: Admite el razonamiento en más de 100 modelos de código abierto y proporciona modelos de instancia dedicados y sin servidor.

- función de ajuste finoPermitir a los usuarios afinar los modelos generativos de IA utilizando sus propios datos, manteniendo la propiedad de los datos.

- Clúster de GPUProporciona clusters de última generación de 16 a 1000+ GPUs para el entrenamiento de modelos a gran escala.

- Formación de modelos personalizados: Entrena modelos punteros desde cero y admite múltiples arquitecturas de modelos.

- modelo multimodalReconocimiento de imágenes, inferencia de imágenes, generación de imágenes, etc.

- Motor de inferencia eficaz: Integre las últimas tecnologías de inferencia, como FlashAttention-3 y Flash-Decoding, para ofrecer servicios de inferencia rápidos y precisos.

Utilizar la ayuda

Instalación y uso

- Registro e inicio de sesión::

- Visite el sitio web de Together AI (https://www.together.ai/) y haga clic en el botón "Start Building" para inscribirse.

- Una vez completado el registro, acceda a su cuenta y vaya al Panel de Control de Usuario.

- Seleccionar servicio::

- En el panel de control, seleccione el módulo de servicio que necesita utilizar, como la API de inferencia, la función de ajuste fino o el clúster de GPU.

- Seleccione el modo de instancia dedicada o sin servidor según sea necesario.

- Uso de la API de inferencia::

- Seleccione el modelo de código abierto que necesita ejecutar, como Llama-3, RedPajama, etc.

- Integre el modelo en su aplicación a través de la interfaz API proporcionada por Together AI.

- Cree su propia aplicación RAG utilizando los puntos finales integrados de Together AI.

- función de ajuste fino::

- Cargue su conjunto de datos y seleccione los modelos que deben ajustarse.

- Configure los parámetros de ajuste fino para iniciar el proceso de ajuste fino.

- Una vez finalizado el ajuste, descargue el modelo ajustado y despliéguelo.

- Uso del clúster de GPU::

- Seleccione el tamaño de clúster de GPU deseado y configure los parámetros de hardware.

- Cargue los datos de entrenamiento y el código del modelo para iniciar el entrenamiento.

- Una vez finalizado el entrenamiento, el modelo entrenado se descarga para su inferencia o posterior ajuste.

- Formación de modelos personalizados::

- Seleccione el módulo Entrenamiento personalizado del modelo para configurar la arquitectura del modelo y los parámetros de entrenamiento.

- Cargue el conjunto de datos e inicie el proceso de entrenamiento.

- Una vez finalizado el entrenamiento, el modelo se descarga para su despliegue e inferencia.

flujo de trabajo

- Acceso al panel de control: Después de conectarse, vaya al panel de control y seleccione el módulo de servicio deseado.

- Parámetros de configuraciónConfigure los parámetros de inferencia, ajuste fino o entrenamiento según sea necesario.

- Cargar datosCarga el conjunto de datos o el código del modelo.

- Inicio de la misión: Inicie tareas de razonamiento, ajuste o formación y supervise el progreso de las tareas en tiempo real.

- Descargar resultados: Una vez finalizada la tarea, el modelo o los resultados de la inferencia se descargan para su integración en la aplicación.

problemas comunes

- ¿Cómo elegir el modelo adecuado?

- Seleccione el modelo de código abierto adecuado en función del escenario de aplicación, como la generación de texto, el reconocimiento de imágenes, etc.

- ¿Qué debo hacer si encuentro un error durante el proceso de ajuste?

- Compruebe el formato del conjunto de datos y las configuraciones de los parámetros y consulte la documentación oficial para realizar los ajustes.

- ¿Poco rendimiento durante el uso del clúster de GPU?

- Confirme que la configuración del hardware cumple los requisitos y ajuste los parámetros de formación para mejorar la eficacia.

modelo utilizable

| Puntos finales sin servidor | Autor | Tipo | Precios (por 1 millón) fichas) | |

|---|---|---|---|---|

| Meta Llama 3.2 11B Vision Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Meta Llama 3.2 90B Vision Instruct Turbo | ||||

| Meta | chat | $1.20 | ||

| Qwen2.5 7B Instruct Turbo | ||||

| Qwen | chat | $0.30 | ||

| Qwen2.5 72B Instruct Turbo | ||||

| Qwen | chat | $1.20 | ||

| FLUX.1 [schnell] | ||||

| Laboratorios Black Forest | imagen | Ver precios | ||

| FLUX 1.1 [pro] | ||||

| Laboratorios Black Forest | imagen | Ver precios | ||

| FLUX.1 [pro] | ||||

| Laboratorios Black Forest | imagen | Ver precios | ||

| FLUX.1 [schnell] Gratis | ||||

| Laboratorios Black Forest | imagen | Ver precios | ||

| Meta Llama 3.2 3B Instruct Turbo | ||||

| Meta | chat | $0.06 | ||

| Meta Llama Vision Gratis | ||||

| Meta | chat | Gratis | ||

| Meta Llama Guard 3 11B Vision Turbo | ||||

| Meta | moderación | $0.18 | ||

| Meta Llama 3.1 8B Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Mixtral-8x22B Instructor v0.1 | ||||

| mistralai | chat | $1.20 | ||

| Difusión estable XL 1.0 | ||||

| Estabilidad AI | imagen | Ver precios | ||

| Meta Llama 3.1 70B Instruct Turbo | ||||

| Meta | chat | $0.88 | ||

| Meta Llama 3.1 405B Instruct Turbo | ||||

| Meta | chat | $3.50 | ||

| Gryphe MythoMax L2 Lite (13B) | ||||

| Gryphe | chat | $0.10 | ||

| Salesforce Llama Rank V1 (8B) | ||||

| salesforce | rerank | $0.10 | ||

| Meta Llama Guard 3 8B | ||||

| Meta | moderación | $0.20 | ||

| Meta Llama 3 70B Instruct Turbo | ||||

| Meta | chat | $0.88 | ||

| Meta Llama 3 70B Instruct Lite | ||||

| Meta | chat | $0.54 | ||

| Meta Llama 3 8B Instruct Lite | ||||

| Meta | chat | $0.10 | ||

| Meta Llama 3 8B Instruct Turbo | ||||

| Meta | chat | $0.18 | ||

| Meta Llama 3 70B Instruir Referencia | ||||

| Meta | chat | $0.90 | ||

| Meta Llama 3 8B Instruir Referencia | ||||

| Meta | chat | $0.20 | ||

| Qwen 2 Instruir (72B) | ||||

| Qwen | chat | $0.90 | ||

| Gemma-2 Instruct (27B) | ||||

| Google Empresa de Internet | chat | $0.80 | ||

| Gemma-2 Instruct (9B) | ||||

| chat | $0.30 | |||

| Mistral (7B) Instruct v0.3 | ||||

| mistralai | chat | $0.20 | ||

| Qwen 1.5 Chat (110B) | ||||

| Qwen | chat | $1.80 | ||

| Meta Llama Guard 2 8B | ||||

| Meta | moderación | $0.20 | ||

| WizardLM-2 (8x22B) | ||||

| microsoft | chat | $1.20 | ||

| DBRX Instruir | ||||

| Databricks | chat | $1.20 | ||

| DeepSeek Chat LLM (67B) | ||||

| DeepSeek | chat | $0.90 | ||

| Gemma Instruct (2B) | ||||

| Google Empresa de Internet | chat | $0.10 | ||

| Mistral (7B) Instruir v0.2 | ||||

| mistralai | chat | $0.20 | ||

| Mixtral-8x7B Instructor v0.1 | ||||

| mistralai | chat | $0.60 | ||

| Mixtral-8x7B v0.1 | ||||

| mistralai | idioma | $0.60 | ||

| Chat Qwen 1.5 (72B) | ||||

| Qwen | chat | $0.90 | ||

| Guardia Llama (7B) | ||||

| Meta | moderación | $0.20 | ||

| Nous Hermes 2 - Mixtral 8x7B-DPO | ||||

| NousResearch | chat | $0.60 | ||

| Mistral (7B) Instruir | ||||

| mistralai | chat | $0.20 | ||

| Mistral (7B) | ||||

| mistralai | idioma | $0.20 | ||

| Chat LLaMA-2 (13B) | ||||

| Meta | chat | $0.22 | ||

| Chat LLaMA-2 (7B) | ||||

| Meta | chat | $0.20 | ||

| LLaMA-2 (70B) | ||||

| Meta | idioma | $0.90 | ||

| Código Llama Instrucción (34B) | ||||

| Meta | chat | $0.78 | ||

| Upstage SOLAR Instruct v1 (11B) | ||||

| subir al escenario | chat | $0.30 | ||

| M2-BERT-Recuperación-32k | ||||

| Juntos | incrustación | $0.01 | ||

| M2-BERT-Recuperación-8k | ||||

| Juntos | incrustación | $0.01 | ||

| M2-BERT-Recuperación-2K | ||||

| Juntos | incrustación | $0.01 | ||

| EAU-Grande-V1 | ||||

| DóndeEstá | incrustación | $0.02 | ||

| BAAI-Bge-Grande-1p5 | ||||

| BAAI | incrustación | $0.02 | ||

| BAAI-Bge-Base-1p5 | ||||

| BAAI | incrustación | $0.01 | ||

| MythoMax-L2 (13B) | ||||

| Gryphe | chat | $0.30 |

ejemplo de uso

Ejemplos de razonamiento modelo

import os

import requests

url = "https://api.together.xyz/v1/chat/completions"

payload = {

"model": "mistralai/Mixtral-8x7B-Instruct-v0.1",

"max_tokens": 512,

"temperature": 0.7,

"top_p": 0.7,

"top_k": 50,

"repetition_penalty": 1

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)

Ejemplo de ajuste del modelo

import os

import requests

url = "https://api.together.xyz/v1/fine-tune"

payload = {

"model": "togethercomputer/llama-2-70b-chat",

"data": "path/to/your/data",

"epochs": 3,

"batch_size": 8

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...