Text2Edit: A Native Multimodal Model for Text-Driven Video Ad Creation (inédito)

Introducción general

Text2Edit es un proyecto de código abierto , alojado en GitHub , tiene como objetivo proporcionar funciones eficientes de edición de texto y generación de anuncios . El objetivo principal del proyecto es ayudar a los usuarios a procesar rápidamente el contenido de texto y generar material publicitario de alta calidad a través de una interfaz fácil de usar y características de gran alcance.proyecto Text2Edit es mantenido por un grupo de desarrolladores , la base de código es abierto , los usuarios pueden acceder libremente y contribuir. Los principales lenguajes de programación del proyecto son JavaScript, HTML y CSS, lo que garantiza la compatibilidad entre plataformas y una gran experiencia de usuario.

Características técnicas

1. Modelos Multimodales de Grandes Lenguajes (MLLM)

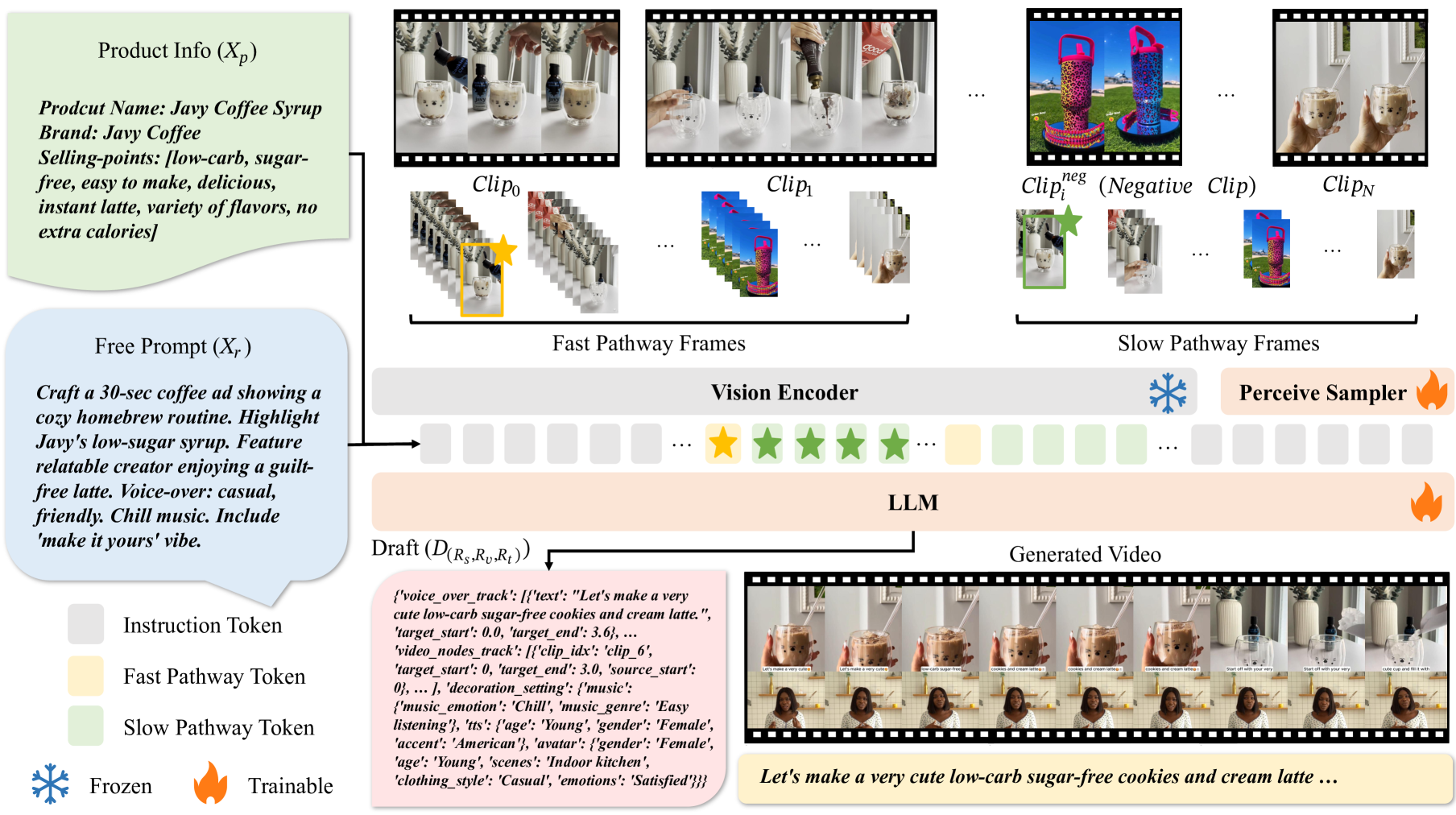

La base del proyecto es el Big Language Model Multimodal, capaz de procesar simultáneamente información en múltiples modalidades, como texto, imágenes y vídeo.

2. Muestreo de alta frecuencia de cuadro y técnicas de procesamiento lento-rápido

Para comprender mejor la información espacio-temporal del vídeo, el proyecto utiliza un muestreo de alta frecuencia de cuadro y técnicas de procesamiento lento-rápido:

- Muestreo de alta frecuencia de fotogramas: Al muestrear los fotogramas de vídeo a una frecuencia de 2 fotogramas por segundo (fps), el modelo es capaz de captar con mayor sensibilidad los cambios temporales del vídeo. Este enfoque mejora significativamente la capacidad del modelo para comprender los cambios en la dinámica del vídeo.

- Técnica de procesamiento lento-rápido: el modelo procesa los fotogramas de vídeo utilizando dos vías simultáneamente.

- Trayectoria lenta: los fotogramas se procesan a una velocidad inferior (por ejemplo, 0,5 fps), pero se asignan más fichas por fotograma para capturar información espaciotemporal detallada.

- Ruta rápida: procesa los fotogramas a una velocidad alta (por ejemplo, 2 fps) pero asigna menos fichas por fotograma, centrándose en la captura de escenas que cambian rápidamente. Esta estrategia de doble vía equilibra la información espaciotemporal y semántica del vídeo y mejora significativamente la comprensión del contenido del vídeo por parte del modelo.

3. Edición basada en texto

El mecanismo de edición por texto permite a los usuarios controlar con precisión el resultado de la edición de vídeo mediante la introducción de texto. Los usuarios pueden especificar la duración del vídeo, la línea argumental, el público al que va dirigido, el estilo del guión, los puntos de venta del producto que deben resaltarse y otra información. El modelo genera un borrador de edición de vídeo que satisface las necesidades del usuario basándose en estas indicaciones textuales, lo que garantiza un alto grado de control y variedad en el resultado.

4. Aplicación específica de la edición de vídeo

- Incrustación y procesamiento de fotogramas de vídeo: los fotogramas de vídeo se convierten primero en vectores de incrustación mediante un codificador visual como CLIP u OpenCLIP. Estos vectores se introducen en el LLM junto con vectores de incrustación de texto, y el modelo los procesa mediante un mecanismo de autoatención para generar borradores para la edición de vídeo.

- Generación de borradores y postprocesado: El borrador resultante del modelo incluye la disposición de los clips de vídeo, los guiones de voz en off y los elementos decorativos (por ejemplo, bandas sonoras, imágenes humanas digitales, etc.). Estos borradores se procesan mediante posprocesamiento (por ejemplo, síntesis de voz, recuperación de música, etc.) para producir el vídeo final renderizable.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...