Tarsier: un modelo de comprensión de vídeo de código abierto para generar descripciones de vídeo de alta calidad

Últimos recursos sobre IAPublicado hace 11 meses Círculo de intercambio de inteligencia artificial 60.1K 00

Introducción general

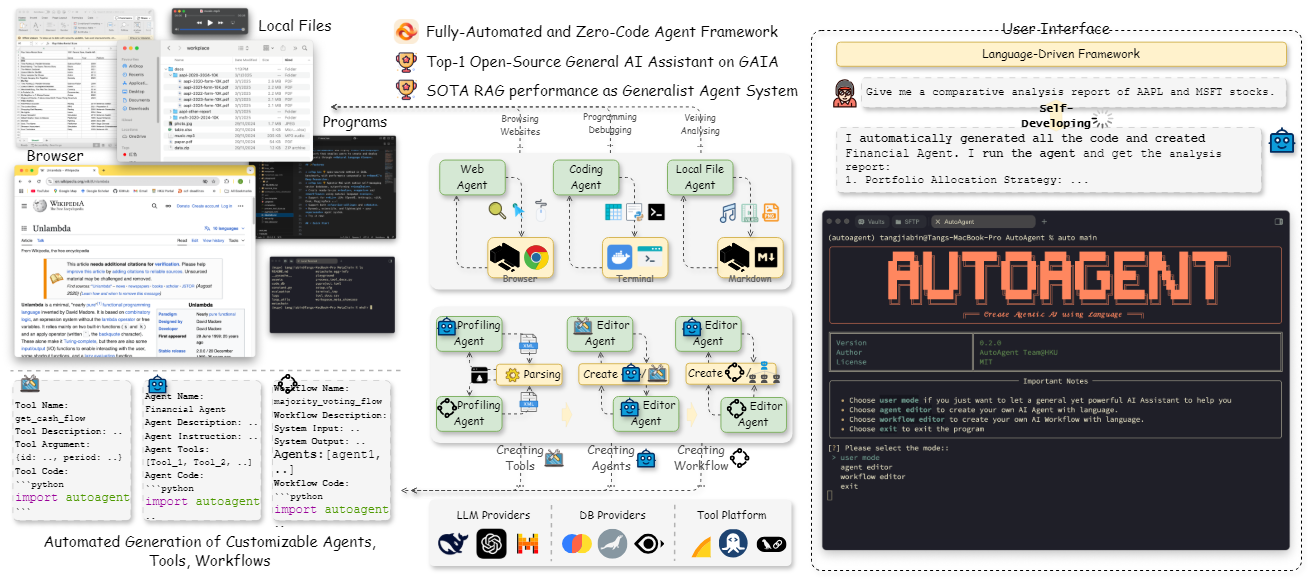

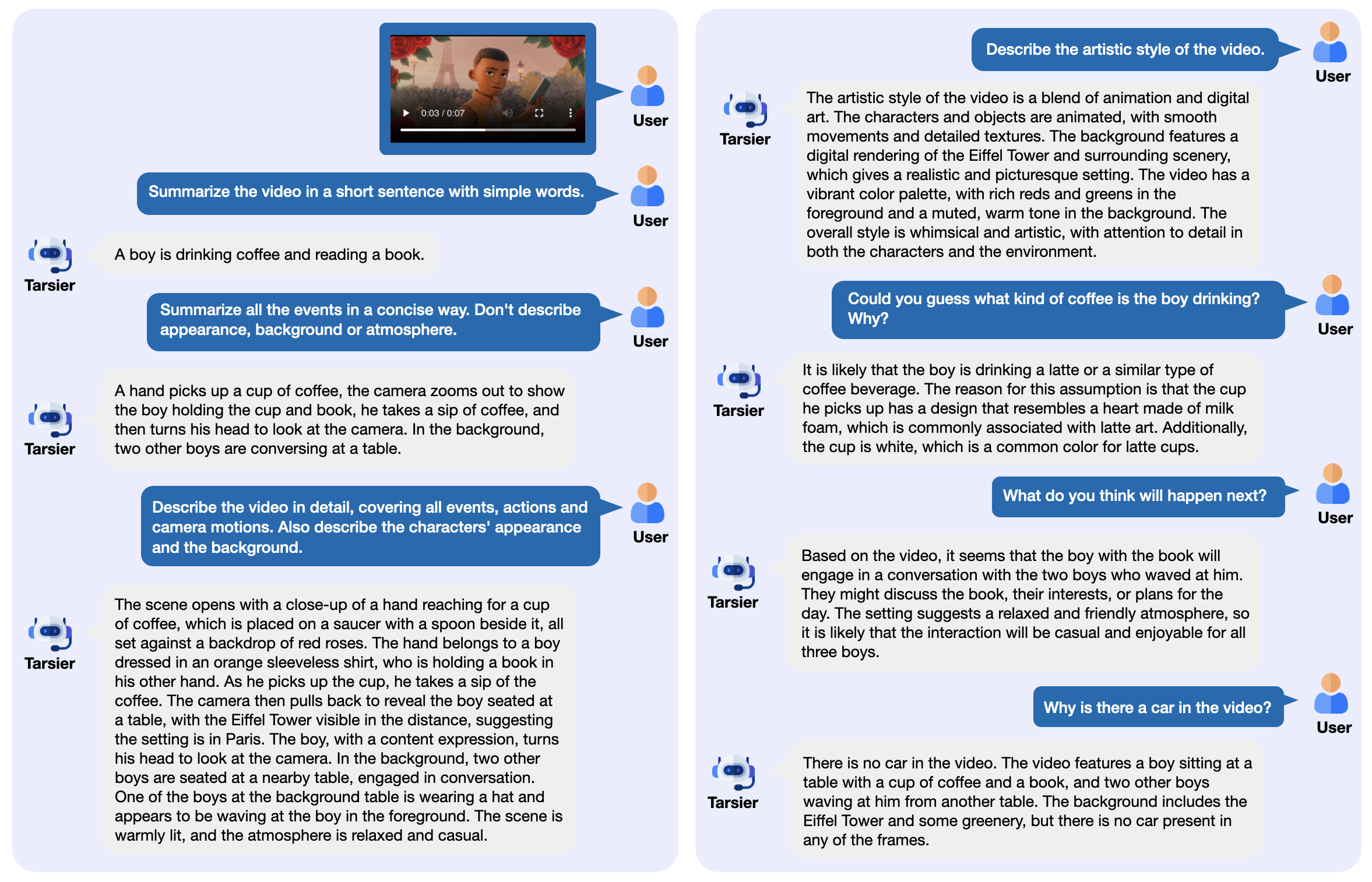

Tarsier es una familia de modelos de videolenguaje de código abierto desarrollada por ByteDance, que se utiliza principalmente para generar descripciones de vídeo de alta calidad. Consta de una estructura sencilla: CLIP-ViT procesa los fotogramas de vídeo y analiza las relaciones temporales en combinación con un Large Language Model (LLM). La última versión, Tarsier2-7B (publicada en enero de 2025), alcanzó el máximo nivel en 16 pruebas comparativas públicas y puede competir con modelos como GPT-4o. Tarsier admite descripción de vídeo, preguntas y respuestas, y generación de subtítulos sin muestras, y el código, los modelos y los datos están disponibles públicamente en GitHub. El proyecto también ha lanzado la prueba de referencia DREAM-1K para evaluar las capacidades de descripción de vídeo, que contiene 1000 clips de vídeo diversos.

Lista de funciones

- Genere descripciones detalladas de los vídeos: analice el contenido del vídeo y genere un texto detallado.

- Soporte para preguntas y respuestas en vídeo: responde a preguntas relacionadas con el vídeo, como eventos o detalles.

- Generación de subtítulos con muestra cero: genera subtítulos para vídeos sin entrenamiento.

- Comprensión de vídeo multitarea: destaca en tareas múltiples, como el cuestionario y los subtítulos.

- Despliegue de código abierto: proporcione pesos de modelo y código para ejecutar localmente o en la nube.

- Proporciona herramientas de evaluación: incluye el conjunto de datos DREAM-1K y la metodología de evaluación AutoDQ.

Utilizar la ayuda

Tarsier es adecuado para usuarios con formación técnica, como desarrolladores o investigadores. A continuación se ofrecen instrucciones detalladas de instalación y uso.

Proceso de instalación

- Preparar el entorno

Requiere Python 3.9 o posterior. Se recomienda un entorno virtual:

conda create -n tarsier python=3.9

conda activate tarsier

- almacén de clones

Descarga el código del proyecto Tarsier:

git clone https://github.com/bytedance/tarsier.git

cd tarsier

git checkout tarsier2

- Instalación de dependencias

Ejecute el script de instalación:

bash setup.sh

Esto instalará todas las librerías necesarias, como PyTorch y las herramientas de Hugging Face.

- Compatibilidad con GPU (opcional)

Si tienes una GPU NVIDIA, instala PyTorch con CUDA:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu118

- Descargar modelos

Descargar modelos de Hugging Face, por ejemplo Tarsier2-7B:

huggingface-cli download omni-research/Tarsier2-7b

Otros modelos como Tarsier-34b o Tarsier2-Recap-7b también están disponibles en los enlaces oficiales.

- Verificar la instalación

Ejecute el script de prueba rápida:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --input_path assets/videos/coffee.gif

La salida debe ser una descripción del vídeo, como "Un hombre coge una taza de café con espuma en forma de corazón y bebe un sorbo".

Funciones principales

Generar descripción de vídeo

- mover

- Prepara un archivo de vídeo (admite formatos como MP4, GIF, etc.).

- Ejecutar comando:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "Describe the video in detail." --input_path your/video.mp4

- El resultado se muestra en el terminal, por ejemplo, describiendo las acciones y escenas del vídeo.

- tenga en cuenta

- Los vídeos demasiado largos pueden requerir más memoria, por lo que se recomienda probar primero con un vídeo corto.

- Parámetros ajustables como la velocidad de fotogramas (véase

configs/tarser2_default_config.yaml).

Vídeo de preguntas y respuestas

- mover

- Especifique las preguntas y los vídeos:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "视频里的人在做什么?" --input_path your/video.mp4

- Da una respuesta directa, por ejemplo: "Está tomando café".

- llamar la atención sobre algo

- Las preguntas deben ser específicas y evitar la ambigüedad.

- Soporta chino y otros idiomas, el chino funciona mejor.

Generación de subtítulos de muestra cero

- mover

- Modifique el archivo de configuración para activar el modo de subtítulos (

configs/tarser2_default_config.yamlestablecertask: caption). - Corriendo:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --config configs/tarser2_default_config.yaml --input_path your/video.mp4

- Emite subtítulos cortos, como "Café solo".

Despliegue local de servicios

- mover

- Instale vLLM (versión recomendada 0.6.6):

pip install vllm==0.6.6

- Inicie el servicio:

python -m vllm.entrypoints.openai.api_server --model path/to/Tarsier2-7b

- Llamada con una API:

curl http://localhost:8000/v1/completions -H "Content-Type: application/json" -d '{"prompt": "描述这个视频", "video_path": "your/video.mp4"}'

- vantage

- El vídeo puede procesarse por lotes.

- Fácil integración en otros sistemas.

Función destacada Operación

Evaluación DREAM-1K

- mover

- Descargar el conjunto de datos DREAM-1K:

wget https://tarsier-vlm.github.io/DREAM-1K.zip

unzip DREAM-1K.zip

- Evaluación operativa:

bash scripts/run_inference_benchmark.sh path/to/Tarsier2-7b output_dir dream

- El resultado incluye métricas como las puntuaciones F1 que muestran la calidad de la descripción.

Evaluación AutoDQ

- mover

- Garantizar la instalación ChatGPT dependencias (se requiere la configuración de Azure OpenAI).

- Ejecute el script de evaluación:

python evaluation/metrics/evaluate_dream_gpt.py --pred_dir output_dir/dream_predictions

- Genera una puntuación de evaluación automatizada que mide la precisión de la descripción.

Preguntas frecuentes

- fallo de instalación: Comprueba la versión de Python y la red, actualiza pip (

pip install -U pip). - Carga lenta del modeloAsegúrate de que tienes suficiente espacio en el disco, se recomiendan al menos 50 GB.

- Sin salida GPU: Ejecutar

nvidia-smiCompruebe que CUDA funciona correctamente.

Experiencia en línea

- entrevistas Demostración en línea de Tarsier2-7BSi quieres probar la descripción y la función de preguntas y respuestas, sube un vídeo.

Con estos pasos, podrá manejar fácilmente las tareas de vídeo con Tarsier. Tanto si está generando descripciones como desplegando servicios, es sencillo y eficiente.

escenario de aplicación

- Recopilación de contenidos de vídeo

Los trabajadores de los medios de comunicación pueden utilizar Tarsier para generar resúmenes de vídeo y organizar rápidamente las secuencias. - Asistencia de vídeo educativo

Los profesores pueden generar subtítulos o cuestionarios para los vídeos del curso con el fin de mejorar la enseñanza y el aprendizaje. - Breve análisis en vídeo

Los profesionales del marketing pueden analizar el contenido de vídeos cortos como TikTok y extraer mensajes clave para su promoción.

CONTROL DE CALIDAD

- ¿Qué formatos de vídeo son compatibles?

Soporta MP4, GIF, AVI, etc, siempre que FFmpeg pueda decodificarlo. - ¿Cuáles son los requisitos de hardware?

Mínimo 16 GB de RAM y 4 GB de memoria de vídeo, GPU NVIDIA recomendada (por ejemplo, 3090). - ¿Está disponible en el mercado?

Sí, Tarsier utiliza la licencia Apache 2.0 y se permite el uso comercial sujeto a condiciones.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...