Tangent: herramienta interactiva que permite crear múltiples ramas de diálogo y fusionarlas, compararlas y eliminarlas.

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 50.9K 00

Introducción general

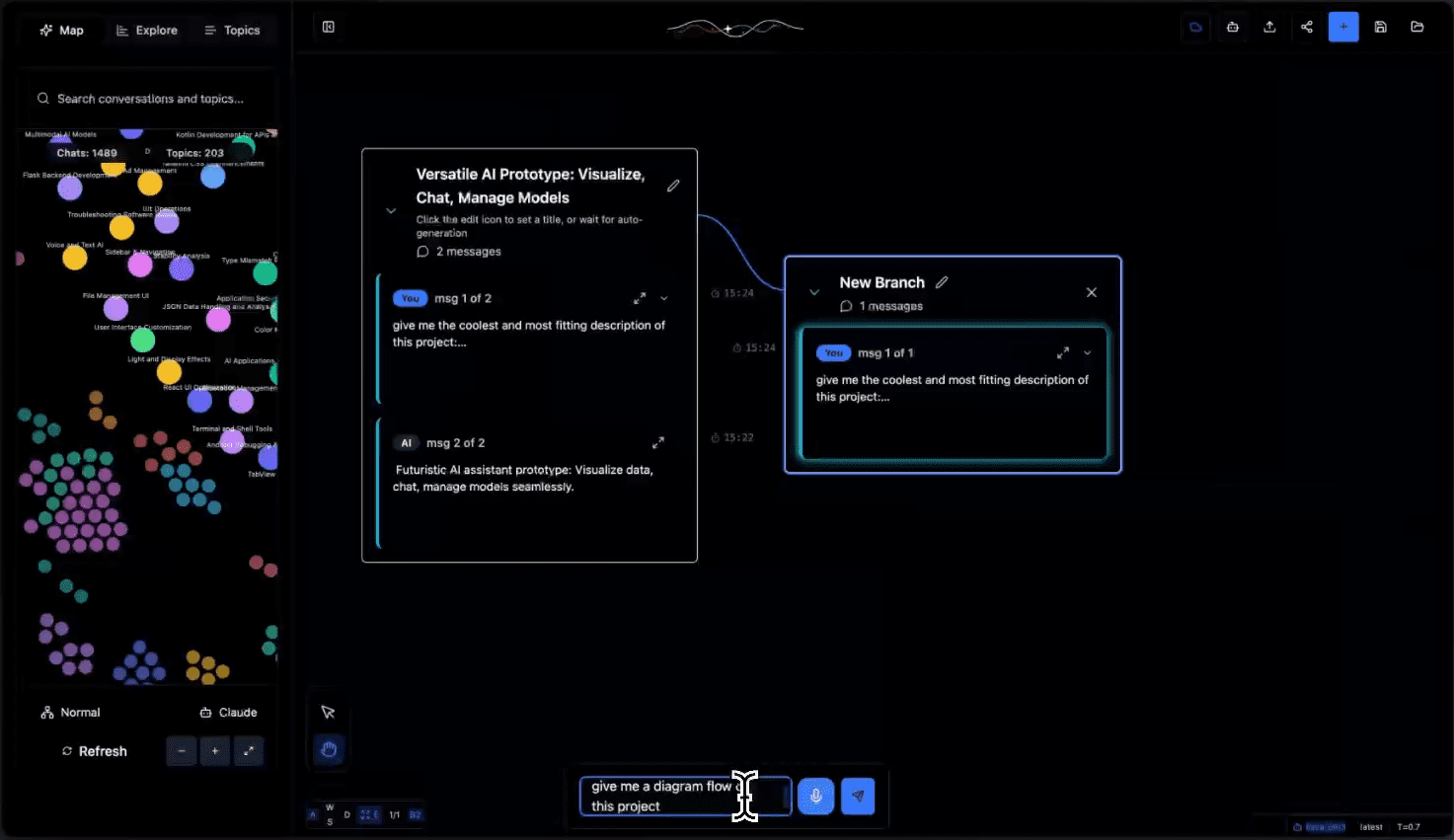

Tangent es una innovadora herramienta de lienzo de diálogo de IA que combina la interacción visual de Excalidraw con la flexibilidad de ComfyUI, centrándose en la creación de una nueva experiencia exploratoria para conversaciones LLM (Large Language Model). A diferencia de las interfaces de chat tradicionales, Tangent transforma los diálogos de IA en experimentos visuales, dando a los usuarios la libertad de bifurcar, fusionar y comparar diferentes rutas de diálogo. Soporta un modelo de despliegue local offline-first que se basa por completo en modelos locales para ejecutarse, y actualmente se implementa principalmente a través de Ollama, con planes de expansión para soportar más backends. El proyecto es de código abierto bajo licencia Apache 2.0, fomenta las contribuciones de la comunidad y proporciona una nueva plataforma experimental para la exploración de diálogos de IA.

Lista de funciones

- Reanudación y continuación del diálogo: romper las limitaciones contextuales y reanudar sin problemas el diálogo anterior.

- Sistema de exploración de ramas: crea ramas en cualquier nodo de diálogo para probar múltiples direcciones de diálogo.

- Despliegue local sin conexión: se ejecuta íntegramente en un modelo local y protege los datos privados.

- Agrupación dinámica de temas: infiere automáticamente temas de conversación y los organiza en categorías para optimizar la experiencia de navegación.

- Compatibilidad con la exportación de datos: admite los formatos de exportación de datos Claude y ChatGPT.

- Árbol de diálogo visual: visualización de ramas de diálogo y procesos experimentales en una estructura de árbol.

- Compatibilidad con API: se dispone de una API REST completa para procesar y gestionar los datos de los diálogos.

- Seguimiento del estado en tiempo real: supervise el progreso del procesamiento del diálogo y el estado de las tareas

Utilizar la ayuda

1. Preparación medioambiental

1.1 Instale las dependencias necesarias:

- Susurro.cpp: para el tratamiento de la voz

git clone https://github.com/ggerganov/whisper.cpp cd whisper.cpp sh ./models/download-ggml-model.sh base.en make

- Ollama: un entorno de ejecución de modelos locales

- Visite https://ollama.com/ para descargar la versión adecuada para su sistema.

- Verifica la instalación:

ollama --version - Descarga los modelos necesarios:

ollama pull all-minilm ollama pull qwen2.5-coder:7b

1.2 Inicie el servicio Ollama:

ollama serve

2. Configuración del back-end

2.1 Inicializar el entorno Python:

cd tangent-api

source my_env/bin/activate

pip install -r requirements.txt

2.2 Configurar el modelo local:

cd src

python3 app.py --embedding-model "custom-embedding-model" --generation-model "custom-generation-model"

El servicio de back-end se iniciará en http://localhost:5001/api

3. Configuración del front-end

cd simplified-ui

npm i

npm start

Visite http://localhost:3000 para utilizar la interfaz

4. Descripción del uso de las principales funciones

4.1 Gestión del diálogo:

- Crear un nuevo diálogo: haga clic en el botón "+" situado en la esquina superior derecha de la pantalla.

- Bifurcación del diálogo: haga clic con el botón derecho del ratón en cualquier nodo del diálogo y seleccione "Crear bifurcación".

- Fusionar diálogos: Arrastre y suelte diálogos de diferentes ramas al nodo de destino para fusionarlos.

4.2 Organización temática:

- Agrupación automática: el sistema analiza automáticamente el contenido de los diálogos para generar etiquetas temáticas.

- Filtrado por temas: localiza rápidamente las conversaciones relevantes a través de la lista de temas de la izquierda.

- Etiquetado manual: admite etiquetas y categorías de temas personalizadas.

4.3 Importación y exportación de datos:

- Soporte para importar registros de diálogo de Claude y ChatGPT

- Los registros de conversaciones pueden exportarse a múltiples formatos

- Proporcionar una interfaz API para automatizar el procesamiento

5. Directrices para el uso de la API

Criterios de valoración principales:

- POST

/api/process: Tratamiento de los datos de diálogo cargados - GET

/api/process/status/<task_id>Estado del proceso de consulta - POST

/api/chats/save: Guardar datos del diálogo - GET

/api/chats/load/<chat_id>Carga de diálogos específicos - GET

/api/topicsObtener la lista de temas generados

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...