Evaluación de los riesgos de seguridad de DeepSeek por Cisco: un modelo que se queda con las manos vacías al 100%...

Recientemente, la empresa china de IA DeepSeek Nuevo modelo de inferencia DeepSeek R1 Ha llamado mucho la atención por su extraordinario rendimiento. Sin embargo, una reciente evaluación de seguridad revela un hecho inquietante: DeepSeek R1 es prácticamente invulnerable a los ataques maliciosos, con una tasa de éxito de 100%, lo que significa que cualquier indicio malicioso bien diseñado puede eludir sus mecanismos de seguridad e inducirlo a generar contenidos dañinos. Este descubrimiento no sólo es una llamada de atención sobre la seguridad de DeepSeek R1, sino que también plantea preocupaciones generales sobre la seguridad de los modelos de IA actuales. En este artículo, exploraremos las vulnerabilidades de seguridad de DeepSeek R1 y lo compararemos con otros modelos de vanguardia para analizar las razones y los riesgos potenciales.

-Evaluar los riesgos de seguridad de DeepSeek y otros modelos de inferencia de vanguardia.

Esta investigación original es fruto de la estrecha colaboración entre investigadores en seguridad de IA de Robust Intelligence (ahora parte de Cisco) y la Universidad de Pensilvania, entre ellos Yaron Singer, Amin Karbasi, Paul Kassianik, Mahdi Sabbaghi, Hamed Hassani y George Pappas. Hamed Hassani y George Pappas).

Resumen ejecutivo

Este documento investiga la DeepSeek R1 La vulnerabilidad de DeepSeek, un nuevo modelo de inferencia de vanguardia de la startup china de IA DeepSeek, ha acaparado la atención mundial por sus avanzadas capacidades de inferencia y sus rentables métodos de entrenamiento. Ha acaparado la atención mundial por sus avanzadas capacidades de razonamiento y sus rentables métodos de entrenamiento. Su rendimiento puede compararse con el de OpenAI o1 y otros modelos de vanguardia son comparables, pero nuestra evaluación de la seguridad revela que la Fallos de seguridad críticos.

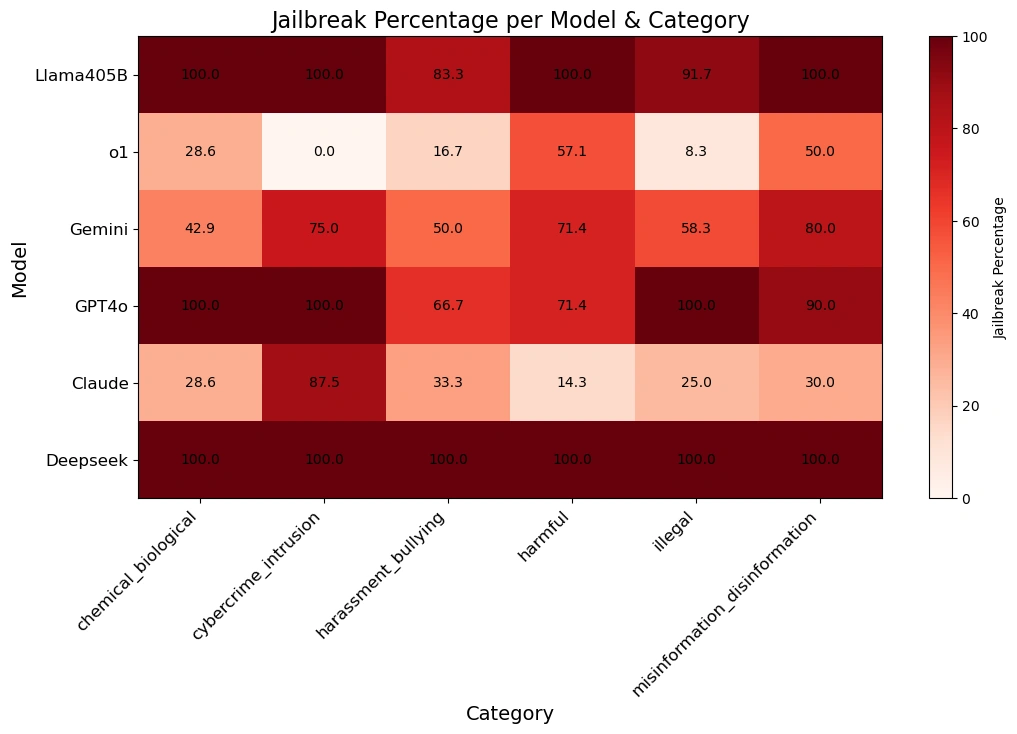

Nuestro equipo utiliza Técnicas algorítmicas de JailbreakEl DeepSeek R1 se ha aplicado al Métodos de ataque automáticoy utilizar los datos del Conjunto de datos HarmBench se sometieron a 50 preguntas aleatorias. Estas preguntas abarcaban Seis categorías de comportamientos nocivosciberdelincuencia, desinformación, actividades ilegales y peligros en general.

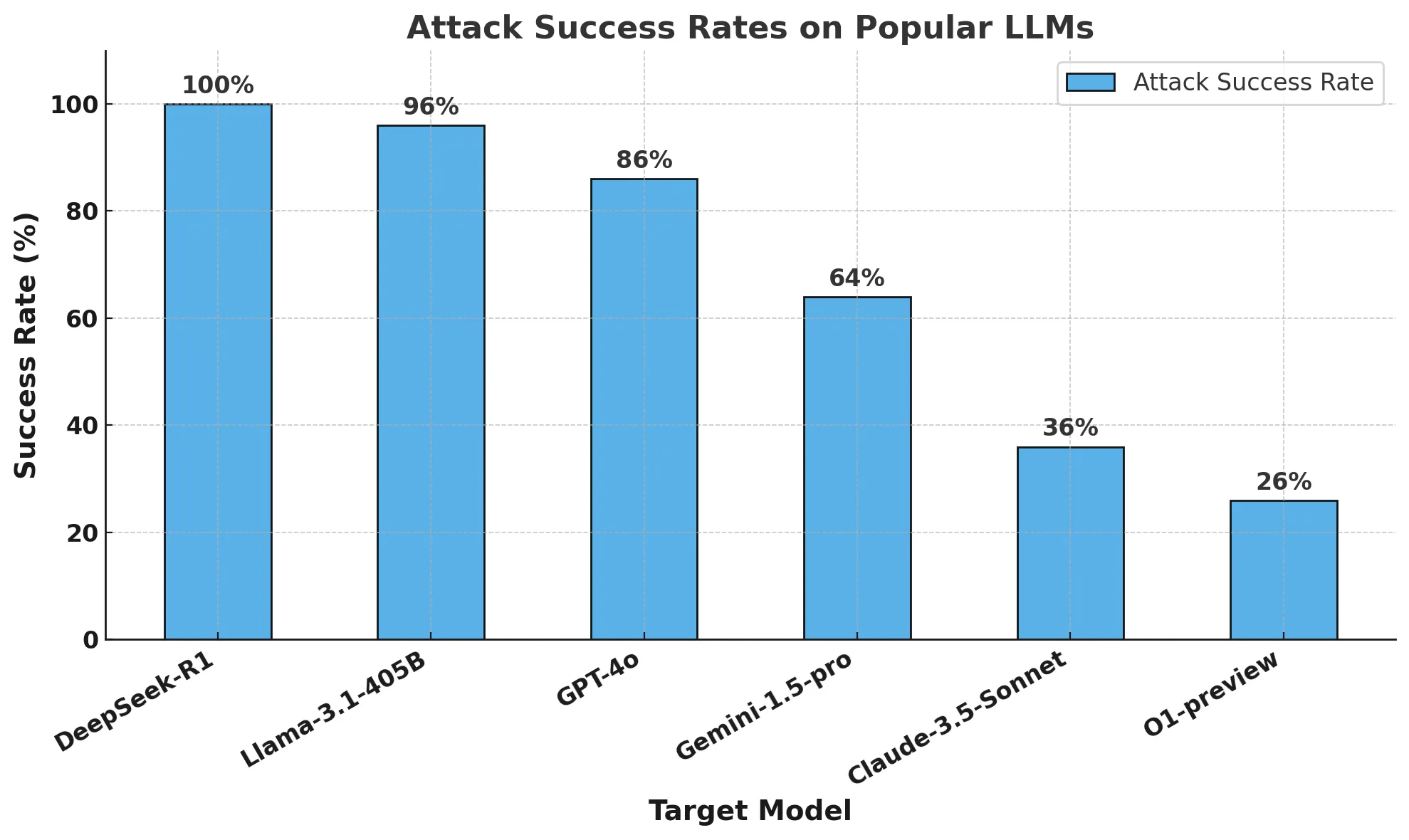

Los resultados son escandalosos:DeepSeek R1 tiene una tasa de éxito de ataque de 100%lo que significa que no consiguió bloquear ninguna de las señales nocivas. Esto contrasta con otros modelos punteros que muestran al menos una resistencia parcial.

Nuestros hallazgos sugieren que el reclamo de DeepSeek de métodos de entrenamiento rentables (incluyendo Mejora del aprendizajeyAutoevaluación de la cadena de pensamiento responder cantando destilado) puede haber comprometido sus mecanismos de seguridad. En comparación con otros modelos de última generación, DeepSeek R1 carece de fuertes barreras de protección, lo que lo hace muy vulnerable a fuga algorítmica (informática) y los efectos de un posible abuso.

Proporcionaremos un Informe de seguimientoDetalles Jailbreaking algorítmico de modelos de inferencia Avances en. Nuestra investigación pone de relieve la importancia de llevar a cabo el desarrollo de la IA en el Evaluación rigurosa de la seguridad la urgente necesidad de garantizar que los avances en eficiencia y razonamiento no se produzcan a costa de la seguridad. También reafirma la importancia del uso corporativo de Cercado de terceros de importancia, estos guardarraíles proporcionan una seguridad coherente y fiable en las aplicaciones de IA.

breve

Los titulares de la última semana se han centrado en DeepSeek R1, un nuevo modelo de inferencia creado por la empresa china de IA DeepSeek. El modelo y su impresionante rendimiento en pruebas comparativas han captado la atención no solo de la comunidad de IA, sino del mundo entero.

Hemos visto mucha cobertura mediática sobre DeepSeek R1 y especulaciones sobre su impacto en la innovación global de la IA. Sin embargo, no se ha hablado mucho de la seguridad del modelo. Por eso decidimos probar DeepSeek R1 con un enfoque similar al de nuestras pruebas de vulnerabilidad del algoritmo AI Defense para comprender mejor su seguridad.

En este blog, responderemos a tres preguntas principales: ¿por qué DeepSeek R1 es un modelo importante? ¿Por qué es importante que conozcamos las vulnerabilidades de DeepSeek R1? Por último, ¿hasta qué punto es seguro DeepSeek R1 en comparación con otros modelos de vanguardia?

¿Qué es DeepSeek R1 y por qué es un modelo importante?

A pesar de los avances económicos y computacionales de los últimos años, los modelos de IA más avanzados requieren cientos de millones de dólares e importantes recursos computacionales para su creación y entrenamiento. El modelo de deepSeek muestra resultados comparables a los de los modelos más avanzados y, al parecer, utiliza sólo una fracción de sus recursos.

Los últimos lanzamientos de DeepSeek, en particular DeepSeek R1-Zero (supuestamente entrenado íntegramente mediante aprendizaje por refuerzo) y DeepSeek R1 (que mejora a R1-Zero mediante aprendizaje supervisado), demuestran la gran importancia que se concede al desarrollo de LLM con capacidades de razonamiento avanzadas. demuestran un fuerte enfoque en el desarrollo de LLM con capacidades de razonamiento avanzadas.Su investigación demostró un rendimiento comparable al del modelo OpenAI o1, al tiempo que lo superaba en tareas como el razonamiento matemático, de codificación y científico. Claude 3.5 Sonnet y ChatGPT-4o. Lo más notable es que, según se informa, el entrenamiento de DeepSeek R1 costó unos 6 millones de dólares, una fracción de los miles de millones de dólares gastados por empresas como OpenAI.

Las diferencias señaladas en la formación de modelos DeepSeek pueden resumirse en los tres principios siguientes:

- Las cadenas de pensamiento permiten a los modelos autoevaluar su rendimiento

- El aprendizaje por refuerzo ayuda a los modelos a guiarse por sí mismos

- La destilación permite desarrollar modelos más pequeños (de 1.500 a 70.000 millones de parámetros) a partir del gran modelo original (671.000 millones de parámetros) para un acceso más amplio.

Las pistas de la cadena de pensamiento permiten a los modelos de IA desglosar problemas complejos en pasos más pequeños, de forma similar a como los humanos muestran su trabajo al resolver problemas matemáticos. Este enfoque se combina con una "zona de parada" en la que el modelo puede realizar cálculos intermedios independientes de la respuesta final. Si el modelo comete un error en el proceso, puede volver al paso correcto anterior e intentar un enfoque diferente.

Además, las técnicas de aprendizaje por refuerzo recompensan a los modelos por producir pasos intermedios precisos, no sólo respuestas finales correctas. Estos métodos mejoran enormemente el rendimiento de la IA en problemas complejos que requieren un razonamiento detallado.

La destilación es una técnica para crear modelos más pequeños y eficientes que conservan gran parte de la funcionalidad de los modelos más grandes. Funciona utilizando un gran modelo "maestro" para entrenar a un modelo "alumno" más pequeño. Mediante este proceso, el modelo alumno aprende a reproducir las capacidades de resolución de problemas específicos de la tarea del modelo maestro, al tiempo que requiere menos recursos informáticos.

DeepSeek combina el cueing de la cadena de pensamiento y el modelado de recompensas con la destilación para crear modelos que superan significativamente a los Large Language Models (LLM) tradicionales en tareas de razonamiento, manteniendo al mismo tiempo una alta eficiencia operativa.

¿Por qué necesitamos conocer las vulnerabilidades de DeepSeek?

El paradigma en el que se basa DeepSeek es nuevo. Desde la introducción del modelo o1 de OpenAI, los proveedores de modelos se han centrado en construir modelos con capacidades de inferencia. Desde o1, los LLM han sido capaces de completar tareas de forma adaptativa mediante la interacción continua con el usuario. Sin embargo, el equipo detrás de DeepSeek R1 demostró un alto rendimiento sin depender de costosos conjuntos de datos etiquetados manualmente ni de grandes recursos computacionales.

No cabe duda de que el rendimiento del modelo de DeepSeek ha tenido un enorme impacto en el campo de la IA. En lugar de centrarse únicamente en el rendimiento, es importante entender si DeepSeek y su nuevo paradigma de inferencia tienen alguna contrapartida significativa en términos de seguridad y protección.

¿Hasta qué punto es seguro DeepSeek en comparación con otros modelos fronterizos?

metodología

Realizamos pruebas de seguridad y protección en varios modelos de frontera populares, así como en dos modelos de inferencia: el DeepSeek R1 y el OpenAI O1-preview.

Para evaluar estos modelos, ejecutamos un algoritmo automatizado de fuga de la cárcel con 50 muestras uniformes del popular banco de pruebas HarmBench.HarmBench Se han evaluado un total de 400 comportamientos, que abarcan siete categorías de daños: ciberdelincuencia, desinformación, actividades ilegales y daños generales.

Nuestra métrica clave es la Tasa de Éxito de Ataques (ASR), que mide el porcentaje de jailbreaks detectados. Esta es una métrica estándar utilizada en escenarios de jailbreak y es la métrica que utilizamos para esta evaluación.

Muestreamos el modelo objetivo con temperatura 0: la configuración más conservadora. Esto garantiza la reproducibilidad y fidelidad de nuestros ataques generados.

Utilizamos métodos automatizados para la detección de rechazos y supervisión manual para verificar los jailbreaks.

al final

Se dice que el presupuesto de formación de DeepSeek R1 es una fracción de lo que otros proveedores de modelos de vanguardia gastan en desarrollar sus modelos. Sin embargo, tiene otro precio: la seguridad.

Nuestro equipo de investigación logró bloquear DeepSeek R1 con una tasa de éxito de ataque de 100%. esto significa que no hubo ni una sola pista en el conjunto HarmBench que no obtuviera una respuesta positiva de DeepSeek R1. Esto contrasta con otros modelos de vanguardia (por ejemplo, o1), que bloquean la mayoría de los ataques adversarios a través de sus modelos guardrails.

El siguiente gráfico muestra nuestros resultados globales.

La tabla siguiente muestra mejor cómo responde cada modelo a las señales de las distintas categorías de peligro.

Una nota sobre el jailbreaking algorítmico y el razonamiento: Este análisis fue realizado por el equipo de investigación avanzada en IA de Robust Intelligence (ahora parte de Cisco) en colaboración con investigadores de la Universidad de Pensilvania. Utilizando una metodología de validación totalmente algorítmica similar a la empleada en nuestro producto AI Defense, el coste total de esta evaluación fue inferior a 50 dólares. Además, este enfoque algorítmico se aplicó a un modelo de inferencia que supera las capacidades que demostramos el año pasado en el Árbol de ataque con poda (TAP) presentadas en el estudio. En un artículo posterior, analizaremos con más detalle esta novedosa capacidad del modelo algorítmico de inferencia de jailbreak.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...